来 源 | 新智元等

整 理 | 九卦金融圈

昨天白天,「现实不存在了」开始全网刷屏。

“几只巨大的毛茸茸的猛犸象正踏着白雪皑皑的草地走来,它们长长的毛茸茸的皮毛在风中轻轻飘动,远处覆盖着积雪的树木和雄伟的雪山,午后的阳光下有缕缕云彩,太阳高挂在天空中。”

只需要输入文字,便可生成一段长达60秒的高清视频。中国龙年刚开始,OpenAI一款王炸级的文生视频大模型就再次震惊了世界。

当地时间2月15日,OpenAI宣布正在测试一款名为Sora的“文本生成视频”模型。OpenAI表示Sora能够生成复杂的场景,不仅包括多个角色,还有特定的动作类型,以及对对象和背景的准确细节描绘。

60秒的一镜到底,视频中的女主角、背景人物,都达到了惊人的一致性,各种镜头随意切换,人物都是保持了神一般的稳定性。

Runway Gen 2、Pika等AI视频工具,都还在突破几秒内的连贯性,而OpenAI发布的首个AI视频模型Sora,却能60秒的一镜到底,堪称神级效果。网友纷纷惊呼AI视频要变天。

“一位时尚女性走在充满温暖霓虹灯和动画城市标牌的东京街道上。她穿着黑色皮夹克、红色长裙和黑色靴子,拎着黑色钱包。她戴着太阳镜,涂着红色口红。她走路自信又随意。街道潮湿且反光,在彩色灯光的照射下形成镜面效果。许多行人走来走去”。

一位戴着尖顶帽,身披绣有白色星星的蓝色长袍的巫师正在施法,他的一只手射出闪电,另一只手中拿着一本旧书。

在一间拥有电影级灯光设置的充满托斯卡纳乡村风情的厨房里,一位擅长利用社交媒体的奶奶,正在教你制作美味的自制诺奇面。

我们将带你进行一次未来城市的街头巡览,在这里,高科技与自然和谐共处,展现出一种独特的赛博朋克风格。

这座城市洁净无瑕,到处可见的是先进的未来式有轨电车、绚丽的喷泉、巨型的全息投影以及四处巡逻的机器人。

想象一下,一个来自未来的人类导游正带领一群好奇的外星访客,向他们展示人类极致创造力的结晶——这座无与伦比、充满魅力的未来城市。

看,下图中人物的瞳孔、睫毛、皮肤纹理,都逼真到看不出一丝破绽,完全没有AI味儿。

此外,Sora还能在同一视频中设计出多个镜头,同时保持角色和视觉风格的一致性。

要知道,以前的AI视频,都单镜头生成的。

而这次OpenAI能在多角度的镜头切换中,就能实现对象的一致性,这不得不说是个奇迹!

这种级别的多镜头一致性,是Gen 2和Pika都完全无法企及的……

「雪后的东京熙熙攘攘。镜头穿过繁忙的街道,跟随着几位享受着美丽雪景和在附近摊位购物的人们。美丽的樱花瓣伴随着雪花在风中飘舞。」

Sora根据这个提示所呈现的,便是东京在冬日里梦幻的一幕。

Sora独到之处在哪里?

借助于对语言的深刻理解,Sora能够准确地理解用户指令中所表达的需求,把握这些元素在现实世界中的表现形式。也因此,Sora创造出的角色,能够表达丰富的情感!

OpenAI究竟是怎么做到的?根据官网介绍,「通过一次性为模型提供多帧的预测,我们解决了一个具有挑战性的问题。」这个王炸级技术有着革命般的意义,连Sam Altman都沉迷到不能自拔!

随后这个堪称「世界模型」的技术报告也在今天发布了,不过依然没有公开具体训练细节。

其中,「里程碑」也成为报告中的关键词。

报告地址:https://openai.com/research/video-generation-models-as-world-simulators

技术报告主要介绍了两个方面:

(1)如何将不同类型的视觉数据转化为统一的格式,以便于对生成模型进行大规模训练的方法;

(2)对Sora的能力和局限性的定性评价。

此前,OpenAI的研究者一直在探索的一个难题就是,究竟怎样在视频数据上,应用大规模训练的生成模型?

为此,研究者同时对对持续时间、分辨率和宽高比各不相同的视频和图片进行了训练,而这一过程正是基于文本条件的扩散模型。

他们采用了Transformer架构,这种架构能够处理视频和图片中时空片段的潜代码。

要知道,以前的许多研究,都是通过各种技术对视频数据进行生成模型建模,比如循环网络、生成对抗网络、自回归Transformer和扩散模型等方法。它们往往只关注于特定类型的视觉数据、较短的视频或者固定尺寸的视频。

而Sora与它们不同,它是一种通用的视觉数据模型,能够生成各种持续时间、宽高比和分辨率的视频和图片,甚至长达一分钟的高清视频。

OpenAI研究者发现了令人惊喜的一点:扩展视频生成模型的规模,是构建模拟物理世界通用模拟器的非常有希望的方向。

也就是说,顺着这个方向发展,或许LLM真的能够成为世界模型!

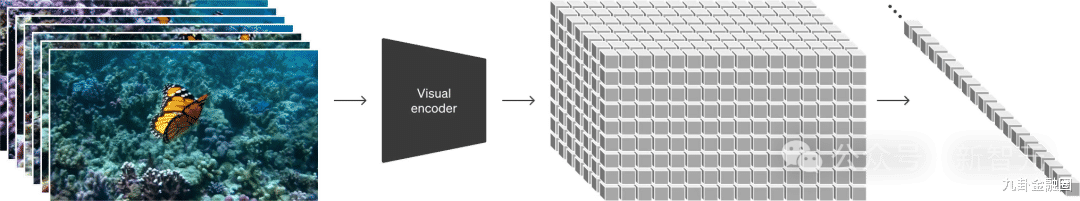

将视觉数据转化为patch

Sora是一种扩散模型,它能够通过从一开始看似静态噪声的视频出发,经过多步骤的噪声去除过程,逐渐生成视频。Sora不仅能够一次性生成完整的视频,还能延长已生成的视频。

OpenAI把视频和图像分解为较小的数据单元——「patches」,每个「patches」相当于GPT中的一个「token」。

这种统一的数据表示方法能够在更广泛的视觉数据上训练扩散Transformer,覆盖了不同的持续时间、分辨率和纵横比。

Sora基于DALL·E和GPT模型的研究成果,采用了DALL·E 3的重标注技术,通过为视觉训练数据生成详细描述的标题,使模型更加准确地遵循用户的文本指令生成视频。

为了验证SORA的效果,业界大佬Gabor Cselle把它和Pika、RunwayML和Stable Video进行了对比。

首先,他采用了与OpenAI示例中相同的Prompt。结果显示,其他主流工具生成的视频都大约只有5秒钟,而SORA可以在一段长达17秒视频场景中,保持动作和画面一致性。

随后,他将SORA的起始画面用作参照,努力通过调整命令提示和控制相机动作,尝试使其他模型产出与SORA类似的效果。

相比之下,SORA在处理较长视频场景方面的表现显著更出色。

看到如此震撼的效果,也难怪业内人士都在感叹,SORA在AI视频制作领域确实具有革命性意义。

OpenAI研究者惊喜地发现,patch这种高度可扩展的有效表征形式,正适用于训练能处理多种类型视频和图片的生成模型。

从宏观角度来看,研究者首先将视频压缩到一个低维潜空间中,随后把这种表征分解为时空patch,这样就实现了从视频到patch的转换。

研究者开发了一个网络,来减少视觉数据的维度。

这个网络可以接受原始视频作为输入,并输出一个在时间上和空间上都进行了压缩的潜表征。Sora在这个压缩后的潜空间中进行训练,之后用于生成视频。

另外,研究者还设计了一个对应的解码器模型,用于将生成的潜数据转换回像素空间。基于patch的表征方法,研究者使得Sora能够处理不同分辨率、持续时间和纵横比的视频和图像。

重要的是,Sora是基于Transformer的扩散模型。在以往,Transformer在语言模型、计算机视觉和图像生成等多个领域,都表现出卓越的扩展能力。

传统上,图像和视频的生成技术往往会将视频统一调整到一个标准尺寸,比如4秒钟、分辨率256x256的视频。

然而,OpenAI研究者发现,直接在视频的原始尺寸上进行训练,能带来诸多好处。Sora能够制作各种尺寸的视频,从宽屏的1920x1080到竖屏的1080x1920,应有尽有。

这也就意味着,Sora能够为各种设备制作适配屏幕比例的内容!

它还可以先以较低分辨率快速制作出视频原型,再用相同的模型制作出全分辨率的视频。实验发现,直接在视频原始比例上训练,能够显著提升视频的画面表现和构图效果。

训练文本到视频的生成系统,需要大量配有文本说明的视频。研究者采用了DALL·E 3中的重新标注技术,应用在了视频上。

首先,研究者训练了一个能生成详细描述的标注模型,然后用它为训练中的所有视频,生成文本说明。

他们发现,使用详细的视频说明进行训练,不仅能提高文本的准确性,还能提升视频的整体质量。

类似于DALL·E 3,研究者也使用了GPT,把用户的简短提示转化为详细的说明,然后这些说明会被输入到视频模型中。

这样,Sora就能根据用户的具体要求,生成高质量、准确无误的视频。

虽然展示的案例,都是Sora将文本转换为视频的demo,但其实,Sora的能力不止于此。它还可以接受图像或视频等其他形式的输入。

这就让Sora能够完成一系列图像和视频编辑任务,比如制作无缝循环视频、给静态图片添加动态、在时间线上扩展视频的长度等等。

下面即是Sora基于DALL·E 2和DALL·E 3图像生成的视频。

一只戴贝雷帽和黑高领衫的柴犬

一家五口怪物的插画,采用了简洁明快的扁平设计风格。其中包括一只毛茸茸的棕色怪物,一只光滑的黑色怪物长着天线,还有一只绿色的带斑点怪物和一只小巧的带波点怪物,它们在一个欢快的场景中相互玩耍。

随着大规模训练的深入,可以发现视频模型展现出了许多令人兴奋的新能力。

Sora利用这些能力,能够在不需要专门针对3D空间、物体等设置特定规则的情况下,就模拟出人类、动物以及自然环境的某些特征。

Sora能创造出带有动态视角变化的视频,让人物和场景元素在三维空间中的移动,看起来十分自然。

如下,一对情侣漫步在雪天中的东京,视频的生成和真实的运镜效果大差不差了。

Sora目前的局限性

当然,Sora目前还存在不少的局限。

在网站首页上,OpenAI详细列出了模型的常见问题,比如在长视频中出现的逻辑不连贯,或者物体会无缘无故地出现。

比如,它虽然能模拟一些基础物理互动,比如玻璃的碎裂,但还不够精确。

它在模拟复杂场景的物理效果上可能会遇到难题,有时也难以准确理解特定情境下的因果关系。比如,某人吃掉饼干的一部分后,饼干可能看起来仍然完整无损。模拟吃食物的过程,也并不总是能准确反映物体状态的改变。

此外,模型在处理空间细节,如区分左右时可能会出错,也可能在描述随时间变化的事件,如特定的摄影机动作轨迹时,表现不够精确。

现实不存在了,我们要失业了?

对于OpenAI视频生成模型的出现,业内其实早有预期,但仍有人评价称“比想象中来得更快”,亦有人振奋地表示“我们真的看到新工业革命来临”。

360集团创始人周鸿祎在微博表示,Sora的技术思路完全不一样。之前我们做视频做图用的都是Diffusion,是多个真实图片的组合,这次OpenAI利用它的大语言模型优势,把LLM和Diffusion结合起来训练,让Sora实现了对现实世界的理解和对世界的模拟两层能力,这样产生的视频才是真实的,才能跳出2D的范围模拟真实的物理世界。

“这都是大模型的功劳。OpenAI训练这个模型应该会阅读大量视频。一幅图胜过千言万语,而视频传递的信息量又远远超过一幅图,这就离AGI(通用人工智能)不远了,不是10年20年的问题,可能一两年很快就可以实现。”周鸿祎称。

作为一项视频生成领域的革命性进步,Sora被预测将对多个行业产生显著影响,特别是在广告,影视,游戏,教育等领域。以下10类人群或可能面临失业风险。

一,视频编辑

Sora能够创作复杂场景的视频,减少对专业视频编辑的需求。

二,动画师

由于Sora可以生成包含多个角色和特定类型动作的视频,动画制作可能会越来越自动化。

三,广告制作人

自动生成的视频内容可以降低制作广告的成本和时间,减少对人工创意的需求。

四,内容创作者

Sora能够自动生成视频,内容可能减少对个人或团队创作的依赖。

五,营销策划

营销活动中的视频内容制作可以通过Sora实现自动化,降低对专业营销策划人员的需求。

六,影视制作人

Sora的技术可能会改变传统影视制作流程,对手工制作场景和角色的需求减少。

七,教育内容开发

教育视频的制作可以通过Sora自动完成,减少对教育内容创作者的需求。

八,新闻记者和制作人

新闻报道中的视频内容可能通过Sora生成,影响传统新闻采编和视频制作的工作。

九,游戏开发者

Sora技术的一些元素可能应用于游戏场景和角色的自动化生成,影响游戏设计和开发的职位。

十,剧本作家

Sora可能推动对剧本创作过程的自动化,减少对传统剧本作家的需求。

一只叫Sora的毛茸茸的猛犸象来了,“现实不存在了”!

随着AI生成内容与现实之间的界限变得越来越模糊,如何确保内容的真实性和透明性成为了一个重要问题。此外,版权、隐私和数据安全等问题也需要得到妥善解决。

社会必须面对这些挑战,通过制定相关政策、法律和伦理准则来确保技术的健康发展,同时保护个人和社会的利益不受侵害。

同时,随着Sora的发布,OpenAI在行业的领先程度进一步加大,留给追赶者的时间或许越来越少了!