一个炎热的下午,我和几个好友正在咖啡馆闲聊。

忽然,张三提起上周发布的AI推理测试,“你们知道吗?

传说中的DeepSeek R1居然在测试中翻车了!

他的话顿时引起了大家的兴趣。

你可能会觉得奇怪,大家为什么对人工智能的推理能力这么感兴趣?

实际上,这次测试有点不一般。

一个普遍认同聪明的AI,在推理题居然出错了,这难道不可怕吗?

测试背景和参与人工智能先说说这次测试的背景吧。

其实,最初的测试并不是那么复杂。

我只是用一道常见的脑筋急转弯题去了考验几个知名的AI:Grok 3、DeepSeek和GPT。

出乎意料的是,这几个AI顺利通过了测试,但大名鼎鼎的GPT却翻车了。

所以,我觉得有点意思,于是写了篇文章讨论这件事,这篇文章一发布在头条上,马上就引起了广泛关注。

不少头条群友留言提出了很多有趣的看法和建议,有位热心朋友还特别提供了一道新的、更复杂的数字推理题。

于是我决定,再次测试一下目前市面上非常热门的几大人工智能,看看它们的推理能力到底如何。

这次参与测试的AI包括:DeepSeek、ChatGPT、谷歌的Gemini、Kimi、Perplexity、Claude和基于推特的Grok 3等多个版本。

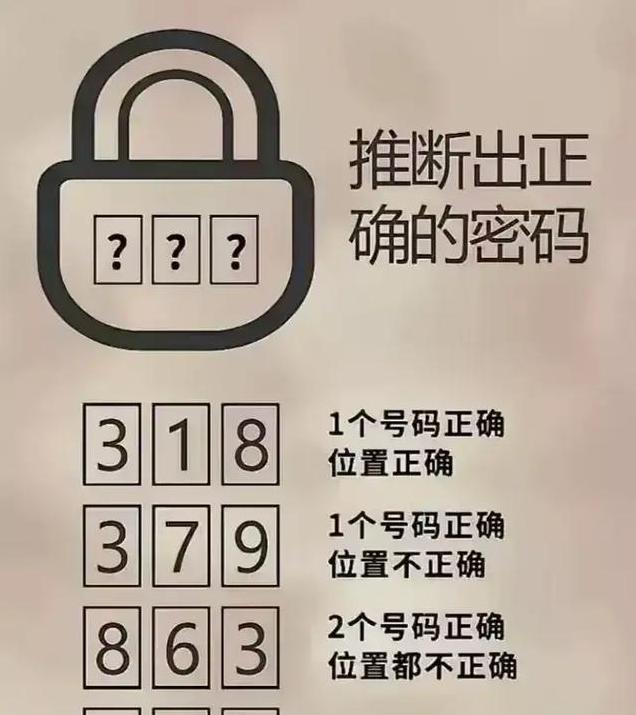

新题测试和推理过程新的测试题是一道密码锁的推理问题,题目看似简单,但实际上难度比之前的脑筋急转弯大了不少。

题目给出四行提示,要求根据这些提示推断出正确的密码以及每个密码数字的顺序。

开始测试后,我发现这些AI在推理过程中的表现确实精彩。

它们相对复杂的推理过程,简直让我大开眼界。

DeepSeek坐在那里静静地“思考”了好几分钟,写下了一大堆逻辑分析,仿佛在做一篇严谨的数学论文。

Gemini虽然速度快,但结果却不怎么理想。

Claude 3.7 sonnet刚刚发布,对它寄予厚望的我也被它的错误答案震惊了。

至于Grok 3在推理过程中耗时最长,而答案却错得有点离谱。

真正让我感到惊喜的是ChatGPT o3 mini。

它不仅推理速度快,答案准确,而且推理逻辑清晰,和人的思维方式非常相似。

它会在推理过程中不断验证自己的结论,每一步都有条不紊,真有点像一个优秀的学生在认真检查作业。

推理结果和分析结果出来之后,我花了些时间去分析这些AI的答案。

GPT测试了四个不同的版本,只有o3 mini给出了正确答案。

反观DeepSeek,推理过程复杂冗长,但最终还是没能得出正确答案。

谷歌的Gemini三个版本全都被淘汰,尽管它们能输出看似合理的推理过程,但答案依然错误。

Kimi系列在这次测试中也令人失望,普通版和1.5 长思考版都没有能够避开障碍,出现了明显的推理错误。

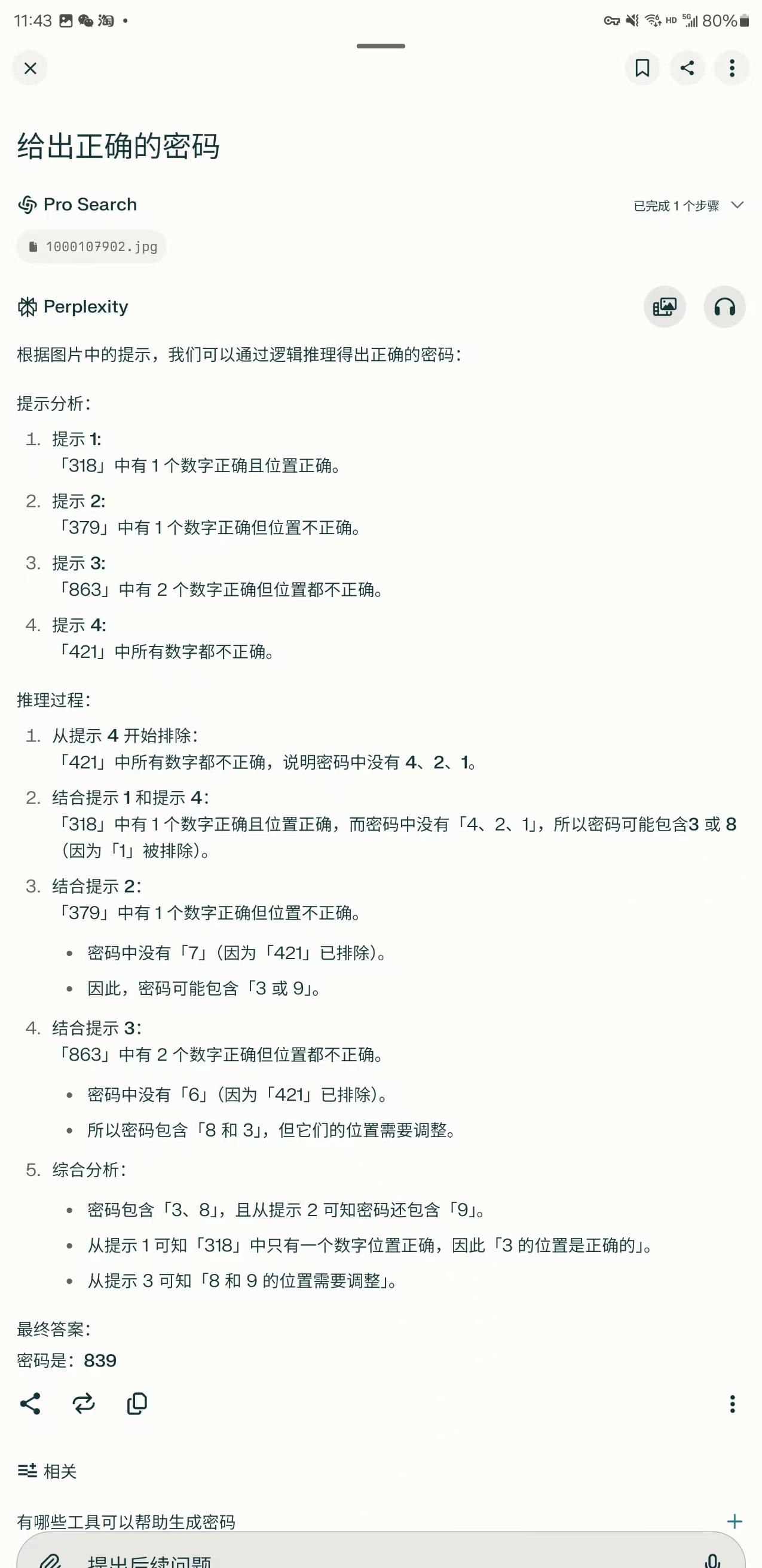

Perplexity o3-Mini看似名声在外,实际上也没能通过测试。

至于Claude 3.7 sonnet,这个刚推出的AI首次亮相就让我们失望了。

最后的Grok 3,用了最长的时间,却给出了错误的结果。

这次测试再次证明了,不是花费的时间越长,答案就越正确。

未来展望与思考这次测试让我们对人工智能的推理能力有了更深层次的认识。

尽管目前很多AI在推理过程中表现出色,但距离完全替代人类的思维还有不小的差距。

DeepSeek这次推理失误,看似偶然,实际也是当前AI发展中的一个普遍问题。

人工智能还在不断进步中,随着算法和计算能力的提升,相信未来会有更多表现出色的AI问世。

这样的测试也提醒我们,不能盲目相信大牌AI的性能,它们也有出错的时候。

测试的结果启示我们要不断完善AI的设计,提高它们在复杂推理中的可靠性。

此外,AI与人类思维方式的融合也是值得深入研究的方向。

毕竟,像ChatGPT o3 mini这样能展现接近人类思维逻辑的AI,是未来发展的一个重要目标。

人类与人工智能的关系,就像是合伙人,我们要让这些“聪明”的机器更懂我们,以帮助我们做出更明智的决策。

但这也提醒我们:在依赖AI之前,请让它多次“考试”,确保它在关键时刻不会掉链子。

毕竟,没有什么比自己养成的习惯和独立思考的能力更可靠。

总之,人工智能终究是人类创造的产物,我们有责任去监督它们,修正它们,让它们伴随我们一起前行。

同样,我们也需要保持谨慎,别让科技的光环蒙蔽了自己的判断力。

至于DeepSeek R1的失败,或许也是再提醒我们,需要加倍努力,让这些“聪明”的机器变得真正“聪明”。