2025大年初一的时候我曾发了一篇如何在本地部署DeepSeek大模型的流程教程,意外的获得了超多的点击和收藏,也了解到了许多用户遇到的问题,经过一段时间的使用,我发现蒸馏过的32b DeepSeek用起来不太如意,遂折腾了一下,成功部署并能较为流畅的运行70b的DeepSeek本地版,实际体验与在线版的671b完整版区别越来越小了,已经是可用状态了。

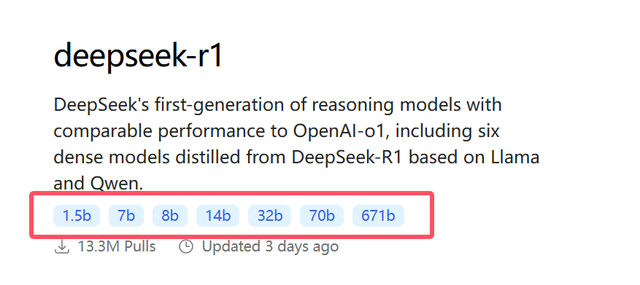

这里需要和不明白的朋友们讲下,32b、70b、671b的b代表什么:

b=billion,十亿,70b意思是700亿个参数,参数越多,大模型的推理和生成能力越强,能处理更复杂的任务、提供更精准的结果。但参数越大、对电脑要求越高,所以要结合现实综合考量后选择适合自己电脑的版本。

接下来的内容,我会以70b的蒸馏版模型,继续教大家如何部署70b DeepSeek本地版,其中包含解决很多用户关心的问题答疑,如何离线安装部署DeepSeek的操作。

这个流程我会假设你对编程和命令行操作有一点点点点了解,操作虽然很简单,但我也会尽量详细解释每一步,争取让小白也能成功部署。

需要准备的工作电脑内存越大越好、显卡越强越好、固态硬盘越快越稳越好……总之,电脑配置要高,我的电脑核心配置供参考:

Windows 11 23H2系统

CPU:Intel i9-14900K

主板:技嘉Aorus Z790冰雕

显卡:公版英伟达RTX 4080

固态硬盘:致态TiPro9000 1TB

内存:64GB双通道DDR5 6000 C30(16GB x4)

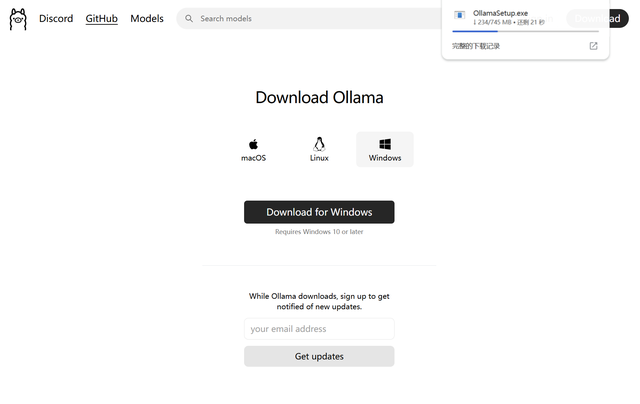

安装大语言运行框架我们继续选用Ollama作为我们的DeepSeek大模型运行框架。

Ollama是一个开源的AI工具,支持本地运行各种模型,包括GPT-4、DeepSeek等。我们要用DeepSeek就必须要安装运行框架。

打开Ollama的官网:ollama点com(输入的时候将“点”换成“.”,没有双引号,下同),或者去github下载(开源的项目),如果你是Windows的话,就下载Windows的版本并安装。

安装完成后,电脑的任务栏会显示Ollama已经在后台运行了,看到后别关闭,关了就用不了DeepSeek了。

克隆代码仓库 部署大模型

接着,我们可以在Ollama的官网直接打开DeepSeek大模型的拉取链接,在models里选择deepseek-r1即可。

这时候,我们要根据电脑性能、尤其是显卡性能来选择大小不同的模型,如果你的显卡显存很大,可以选择更大一些。我的显卡是4080,显存是16GB,官方推荐用32b大小的DeepSeek模型。但,我测试过了,70b大小的同样可以运行,虽然速度稍慢,但深度思考、推理结果更接近671b的在线完整版。

选好后,复制右侧的框内的代码。

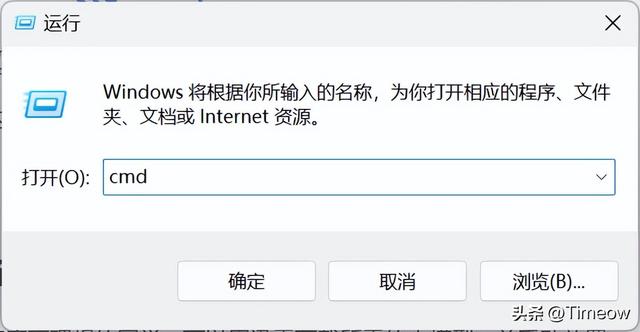

按windows徽标键+R,打开“运行”,输入cmd并确定。

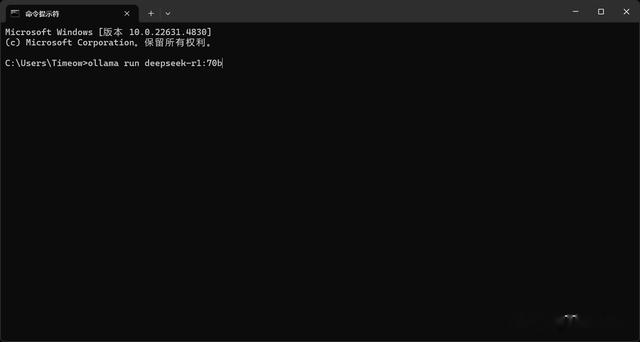

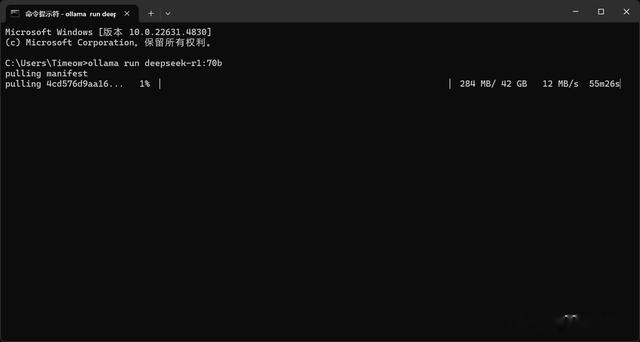

在命令提示符或终端里,Ctrl+V,将刚刚复制的代码ollama run deepseek-r1:70b粘贴到里面,随后按键盘的Enter/回车健。

70b大模型的文件大小是42GB左右,克隆/下载速度因人而异,默认会安装在C盘。如何想要更改大模型的存储目录,请拖到文章后面的部分,我会教各位如何操作。

CMD/终端运行DeepSeek经过漫长的等待,70b大模型安装完成后,运行环境和DeepSeek大模型就算搭建好了。我们在cmd/终端里可以直接输入ollama run deepseek-r1:70b命令来使用DeepSeek。

输入命令后,此时电脑内存大小和硬盘性能决定了载入时长,我这边用的PCIe5.0的致态TiPro9000,载入时间约10多秒,载入完成后就可以开始使用DeepSeek了。

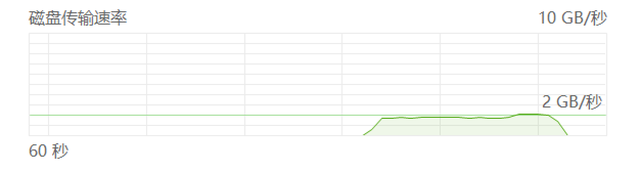

在使用过程中,CPU、内存和显存的占用率都挺高的,而且我也发现固态硬盘也时不时的需要进行大量读取,此时固态硬盘的性能还是挺关键的。

提升体验!用chatbox搭建操作界面对于大多数没有编程基础的玩家来说,以上的命令行用起来非常繁琐不够直观,而且功能不够人性化,接下来我们可以通过搭建一个口碑较好的用户界面来运行。

我选的是开源的chatbox ai工具,去官网chatboxai.app斜杠zh(输入的时候将“斜杠”换成“/”,没有双引号)或github上下载安装所需的版本。

安装完成后,选择“使用自己的API Key或本地模型”

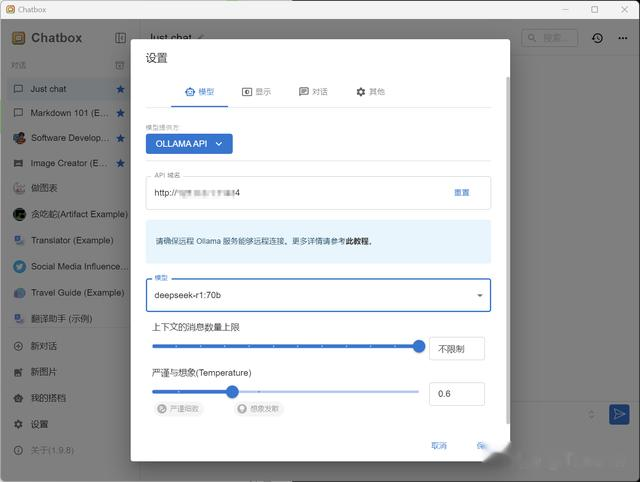

在弹出的设置页面中,模型提供方选择OLLAMA API,模型选择deepseek-r1:70b。

上下文的消息数量上限可以拖到不限制,在严谨和想象(Temperature)拖到0.6比较好一些,兼顾严谨和发散,点击保存后完成!

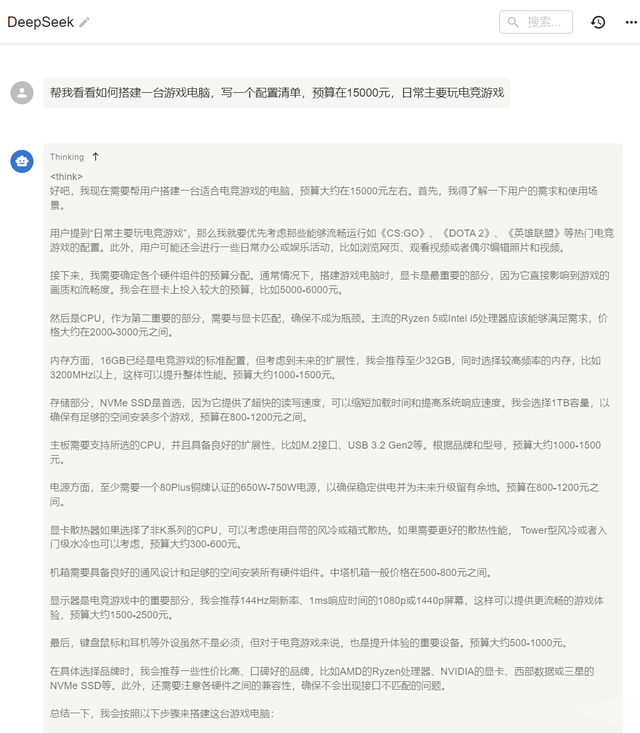

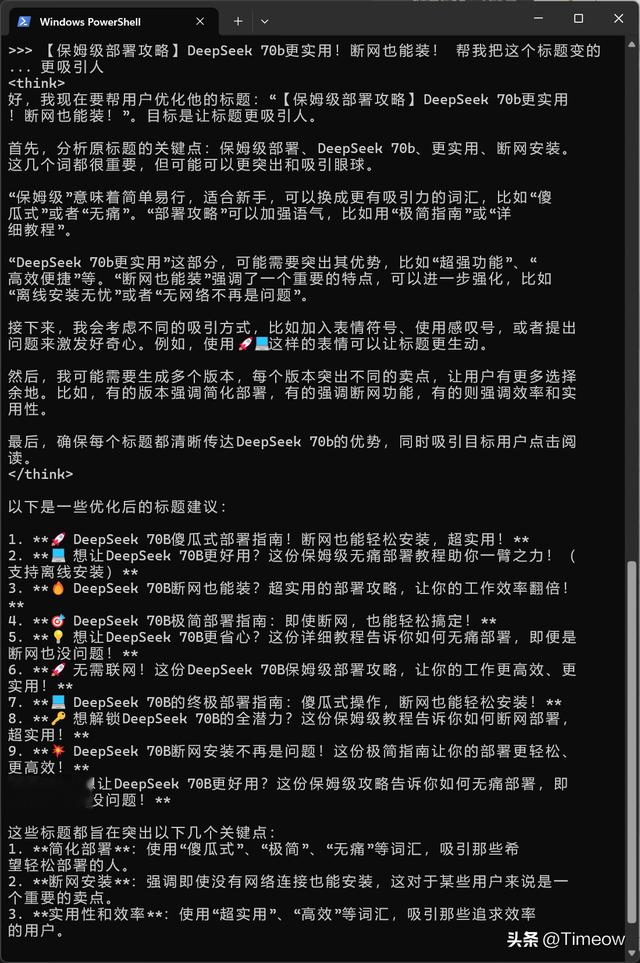

接下来就是愉快的使用过程了,对话过程中,我们也能和在线版一样,可以看到DeepSeek的思考推理过程,我的电脑运行时的速度大约是每秒2个token(2个汉字或2个单词),完全可以接受!

以上的部署操作过程其实非常简单,小白跟着做,绝对可以完成。而70b的DeepSeek大模型已经可以很好进行思考推理生成了,如果不考虑时效性的内容(如上图中,DeepSeek对电脑硬件的了解可能还停留在2年前,但思路是对的),本地部署70b完全可用!

断网安装 如何导入下载好的大模型?网络不好导致拖不动DeepSeek模型、或者单纯想在一台隔离网络的单机上部署DeepSeek的同学,可以用迅雷下载所需的大模型,并用手动导入到ollama指定的文件夹内,具体的详细步骤请看。

Ollama安装完成后,先设置一个DeepSeek的模型存放目录

windows搜索框内输入查看高级系统设置,进入环境变量>新建,设定DeepSeek的模型存放位置,并在电脑硬盘目录里新建一个模型目录文件夹(比如我命名为deepseekmodel)。

变量名:OLLAMA_MODELS别写错,变量值就是deepseekmodel的文件夹地址

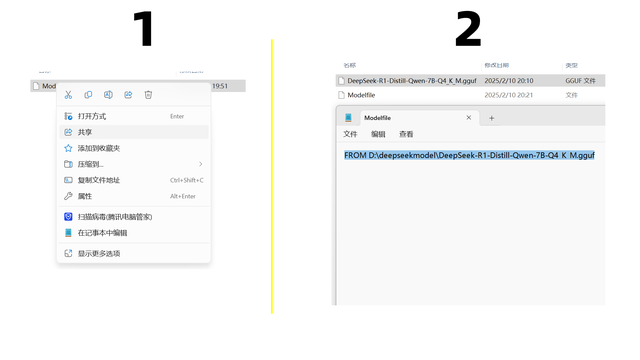

随后在deepseekmodel文件夹内,右键新建一个文本文档(.txt),然后点击查看>开启显示文件扩展名,将这个txt文件的.txt后缀删掉,并命名为Modelfile。

先去modelscope点cn搜索所需的DeepSeek模型,搜索的时候,加上关键词GGUF(ollama支持的模型文件格式)。

选好合适的模型后,进入其模型介绍和下载页面,选择一个下载即可。完成后,将此模型文件丢到D:\deepseekmodel目录中。

(为了节省下载时间,在这个章节里,图片中我选用了7b的DeepSeek模型来做示范,其他大小的模型操作方法完全一致)

右键点击Modelfile,用记事本打开,输入以上图片内容FROM D:\deepseekmodel\DeepSeek-R1-Distill-Qwen-7B-Q4_K_M.gguf,并保存

(FROM后面,是DeepSeek模型的文件存放路径,一定要一字不差,可以右键点击模型文件,复制文件地址获取,记得删掉双引号,FROM后面加空格)

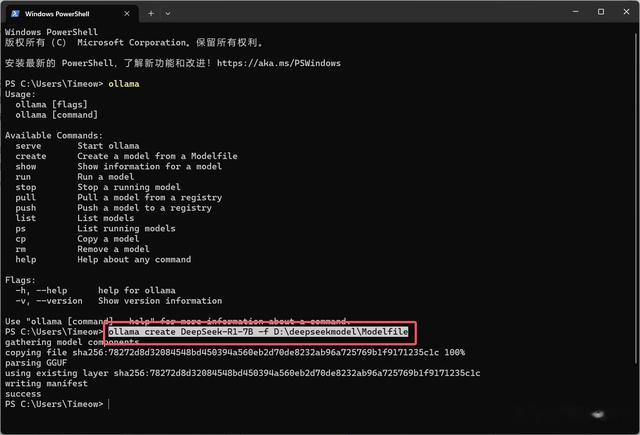

随后打开cmd/终端,输入ollama create DeepSeek-R1-7B -f D:\deepseekmodel\Modelfile

(意思是用D:\deepseekmodel\Modelfile的路径找到模型文件,生成一个DeepSeek-R1-7B模型)

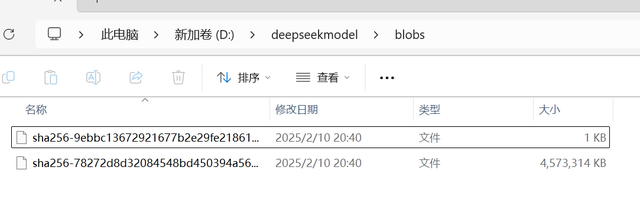

完成后,D:\deepseekmodel\blobs文件夹内就会有这两个文件,大的那个就是模型文件。

去cmd/终端里, 输入ollama list命令确认一下,有了!

后续操作,和“用chatbox搭建友好的操作界面”章节完全一致,各位可往上滑参考。完成后就能用chatbox接入DeepSeek了。

硬盘如何选

上面有提到,在使用DeepSeek、尤其是参数较多的模型时,电脑的压力还是蛮大的,除了显卡要强、内存要大之外,其实硬盘也得快。

因为DeepSeek的模型都是十几GB甚至几十、上百GB的单文件,需要解包载入到内存,整个过程对硬盘的性能要求不低,更好的SSD能提供更好的读取性能,不拖整机后腿。

我这次用了致态TiPro9000这款旗舰级PCIe 5.0固态硬盘,它最高14000MB/s的满血读速、最高2000K IOPS(2TB)的随机读取速度,可以让我的电脑实现极限性能释放,载入模型的速度非常极速。

而它搭载了全新一代的长江存储晶栈®Xtacking® 4.0架构原厂高品质存储颗粒,除了更快、而且还更稳,在我使用的过程中,没有出现卡顿的问题,整体体验相当不错!

具体它的性能有多厉害,各位可以看以上的性能对比图,相比主流高端PCIe4.0的固态硬盘,它的性能几乎是翻倍的提升。

而在PCMark10这种生产力系统盘基准测试中,它整体得分处于断档级的绝对领先地位。表现相当猛!

除了性能,在质保方面,致态TiPro9000的5年/每TB容量600TBW写入保固让我可以放心的狠狠用,什么ollama deepseek、stable diffusion都往里塞,用起来没有后顾之忧。

而且在价格方面,横向对比同性能级别的大牌PCIe5.0固态硬盘:同价位的性能不如它、同性能的比它贵,这让致态TiPro9000很有性价比啊!

如果你的电脑支持PCIe5.0的固态硬盘,那就别犹豫,直接上!另外,我推荐各位可以直接购入2TB版本,算下来的综合性价比还是挺高的,而且一步到位免折腾。靠谱!

如果不支持5.0的话,高端PCIe4.0固态也同样可以畅快用,像上面的测试图显示,致态TiPlus7100性能也相当不错,可以作为首选。

显卡如何选

我推荐各位选购16G显存的中端卡,比如4070Ti Super 16G,价格在6000元以内,实际的AI推理、文生图速度和4080 Super没有区别。而且16G显存运行32b速度很快、70b的话主要是CPU和GPU协同处理(存疑),速度慢但也可以接受,综合下来还是可以的。

如果你能抢到5090,那自然是最好的,不仅推理速度更快,而且可以运行更大的模型。

最后

在DeepSeek席卷的AI浪潮下,人工智能现在真的落地了,它让每个人都能轻松用上,降低了专业壁垒,惠及了每个互联网用户。接下来,我们要做的是让AI为我所用,这样才能在这个时代里立足啊!

希望此文对你有帮助,也希望各位部署DeepSeek一次成功。