在这个飞速发展的时代,人工智能(AI)技术已经广泛渗透到我们生活的方方面面。从智能家居生态系统的搭建,到无人驾驶汽车的出现,再到医疗健康和娱乐休闲的应用,AI已经成为现代社会的重要组成部分。这其中展示出了AI的巨大潜力和影响力,然而,随之而来的是对其潜在风险的深入理解和关注的迫切需求。

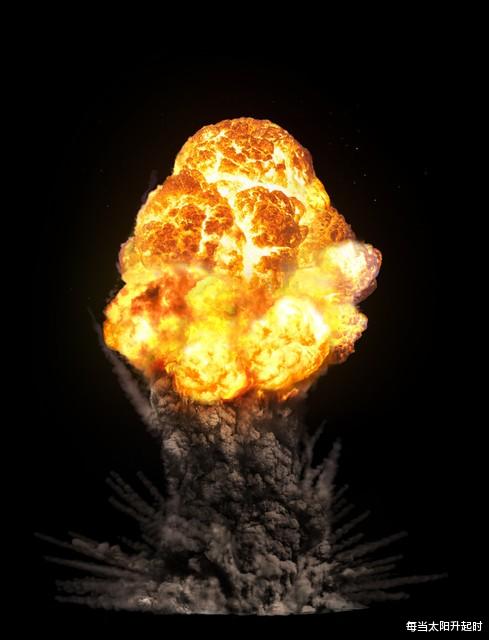

近日,有报道指出特斯拉首席执行官埃隆·马斯克(Elon Musk)再次强调了对人工智能的监管重要性,并称AI的危险性甚至超过了核弹。多次发出警告的马斯克表达了对AI潜在风险的担忧,早在2017年,他就曾指出AI技术由于其能够自我复制和难以控制的特性,其潜在风险已经超过了核弹头。这一观点引发了广泛的讨论,并提醒人们对AI的应用和发展保持警觉。

为了应对AI可能带来的潜在风险,马斯克与其他人共同创办了人工智能研究实验室“OpenAI”。通过开源软件,他们希望让更多人能够使用和监督AI技术,以实现一种防火墙的效应。然而,在2018年,马斯克试图将OpenAI并入特斯拉的计划遭到了拒绝,最终导致他与OpenAI的分道扬镳。

时至今日,马斯克创建了X.AI,这是一个专门致力于确保人工智能安全的组织。马斯克思考和行动背后的出发点在于,他意识到无监管的AI技术所带来的风险可能无法预料,并通过创建这些组织来推动更多人参与AI技术的监督和控制。

马斯克的行动无疑是积极而明智的。尽管AI技术的发展给我们带来了巨大的好处,但与此同时,我们也不能忽视其潜在风险。AI技术的迅猛发展和广泛应用使我们能够享受到许多以前无法想象的便利,但这并不意味着我们可以对其潜在风险视而不见。因此,我们需要更多像马斯克这样具有远见的科技领袖,他们不仅在AI技术上有深入的理解,而且懂得如何在推动科技前进的同时确保其安全可控。

在未来,我们希望看到全球范围内更多的企业和研究机构加入AI技术的监管行列中。通过知识的共享和合作,我们能够为社会提供更多的安全保障。同时,政府的参与和合理的立法也是非常必要的,以构建一个公平、透明且有益的AI发展环境。只有这样,我们才能确保AI的发展不仅是对人类社会的进步,而不是潜藏着巨大风险的灾难。

综上所述,我们需要在深入探讨人工智能的潜在风险时,有几个关键问题值得我们深入思考。

首先是隐私和数据安全的问题。AI技术依赖于大量的数据来进行训练和学习,这些数据可能包含个人隐私和敏感信息。如果这些数据落入了错误的手中或被滥用,将引发严重的隐私问题。此外,恶意攻击者可能利用AI技术中的漏洞或弱点来进行网络攻击,对个人、组织甚至整个国家造成巨大损失。因此,确保数据安全和隐私保护成为至关重要的任务。

其次是深度伪造技术的滥用。随着技术的进步,生成逼真的假造视频和声音已成为可能,这被称为深度伪造技术。虽然这项技术在娱乐和创作领域具有潜力,但其滥用可能导致虚假信息的传播和信任危机。例如,伪造的视频和声音可以被用于政治操纵、网络欺诈和舆论煽动等不良行为。这对社会稳定和个人的信任造成了巨大的威胁,我们需要采取措施来识别和打击深度伪造技术的滥用。

此外,AI在决策过程中存在公平和偏见的问题。AI系统基于历史数据进行训练和决策,如果历史数据中存在偏见或歧视,那么AI算法也可能产生偏向和不公平的结果。这对于一些关键决策领域如招聘、贷款和司法系统尤为重要。因此,我们需要确保AI算法的公平性和可解释性,使其决策过程能够透明、可信,并遵循伦理原则。

面对这些挑战,马斯克的行动为保障AI技术的安全发展作出了积极贡献。通过OpenAI和X.AI这样的组织,他鼓励开源和合作,促进人们更深入地了解和监督AI技术。他的警告呼吁我们认识到AI的潜在风险,并采取相应的措施来确保其安全和可控性。

要解决AI技术的潜在风险,我们需要全球范围内的合作和共同努力。科技公司、研究机构、政府和学术界应加强合作,制定相关政策和法规,建立监管机制,确保AI技术的安全和透明。同时,普通公众也需要加强对AI技术的理解和意识,积极参与讨论,推动AI技术的安全和道德发展。

在未来,我希望看到更多的技术领袖和研究机构积极关注AI技术的潜在风险,并采取行动来确保其安全和可控。只有这样,我们才能真正发挥人工智能在推动社会进步和改善人类生活方面的潜力,而不必担心AI可能带来的灾难性后果。