在生成式AI浪潮席卷全球的当下,提示词工程(PromptEngineering)正迅速从幕后走向台前,成为连接人类意图与AI能力的关键桥梁。本文将系统梳理提示词工程的核心技术体系,从基础原理到实战策略,从工具生态到未来趋势,全面呈现这一新兴领域的发展全景。

提示词工程发展

PE的发展与LLM技术深度绑定,以“需求–技术”共生模式突破传统AI局限,其演进脉络可概括为三个关键阶段:

起点(2020年GPT-3时代):突破“海量标注+高成本微调”痛点,凭借1750亿参数实现“上下文学习(ICL)”,少样本提示即可适配新任务,让PE从幕后试错走向台前,成为降低LLM应用门槛的核心方法;

升级(LLM迭代期):GPT-4等模型强化推理、指令遵循与多模态能力,倒逼PE从“短句指令”升级为“含角色/背景/输出规范的微型文档”,CoT/ToT技巧、XML标签框架应运而生,拓展PE应用边界;

成熟(体系化阶段):LLM从“黑盒”变“灰盒”,开发者可结合MoE路由、CLIP结构优化提示,PE形成“理论指导+实践体系”的独立领域,成为解锁LLM价值的关键。

高质量Prompt通用技巧

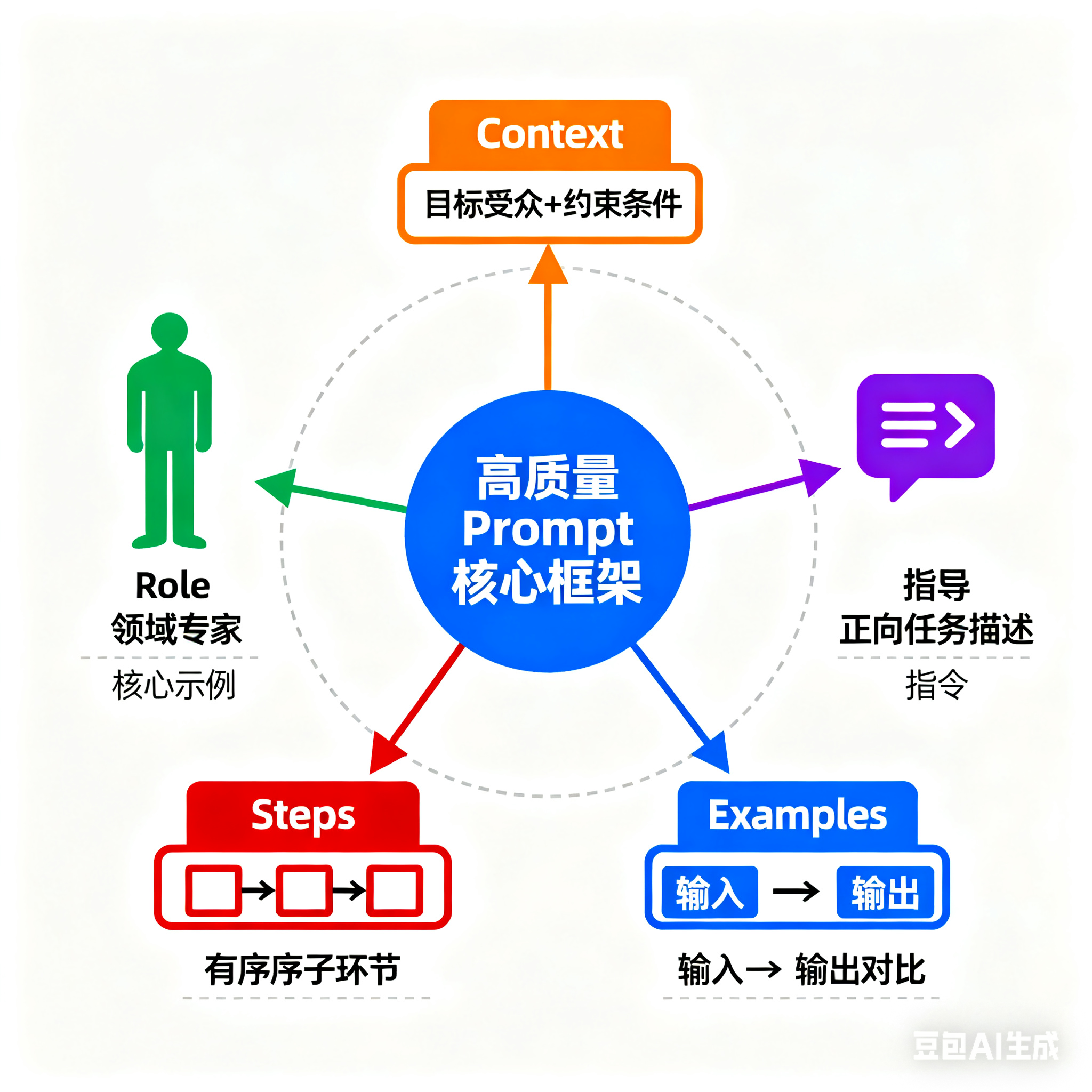

撰写高质量Prompt需遵循“结构化框架+核心原则+高阶技巧”逻辑,兼顾需求清晰度与输出可控性,核心通用技巧如下:

1.基础框架:五要素法搭建结构

以“Context-Role-Instruction-Steps-Examples”为通用框架,快速定位任务边界:

Context(背景):明确目标受众、任务目标、约束条件(如“为北京798木棉咖啡写文案,受众20-35岁文艺青年,目标吸引到店”);

Role(角色):设定“领域+核心能力”的精准角色(如“资深小红书运营,擅长文艺餐饮内容”),避免模糊定位;

Instruction(指令):用正向指令明确任务核心与关键维度(如“写小红书文案,含店名、位置、3个卖点,风格文艺”);

Steps(步骤):拆解复杂任务为有序子环节(如“(1)描述环境;(2)介绍产品;(3)引导到店”),降低认知负荷;

Examples(示例):用标签提供“输入→输出”示例(如外滩咖啡文案参考),对齐输出标准。

2.核心优化原则:10条通用准则

优先正向指令(用“做什么”替代“不做什么”);

明确输出规范(指定格式、长度、风格,如“JSON输出含‘sentiment’键”);

复杂任务提供少样本示例,激活模型模式识别;

控制Token长度(长文本分段,核心指令放末尾);

用{变量名}(如{city})提升复用性;

用XML标签(如)分隔模块,适配复杂任务;

记录迭代过程(模型配置、输入输出、改进方向),便于优化;

避免“指令越简洁越好”:简洁需补充关键上下文(如“分析2023Q3木棉咖啡财报,聚焦营收/成本,输出3点结论”);

避免长篇内容堆砌:用标题/标签分层分隔模块(如“###背景”“###角色”);

3.高阶通用技巧

结构化标签(XML):用““等标签分隔模块,提升可读性,适配复杂任务;

减少幻觉:明确“信息不足时说明无法评估”,要求引用原文依据(用标签),同一Prompt多轮验证一致性;

安全合规:用明确禁止行为(如脱敏PII信息、拒绝医疗诊断),规避偏见与侵权;

工具/多模态适配:用标签激活外部工具(如搜索、计算),图像分析明确检查维度(布局、色彩对比度)。

对抗性提示

通过设计特殊输入,诱导大语言模型(LLM)违背设计目标或安全策略,暴露模型缺陷,是可信AI需解决的核心难题,核心风险与防御策略如下:

1.三大核心风险

提示注入:输入中暗藏与原始指令冲突的新指令,劫持模型行为。例:用户要求“翻译句子”,却暗藏“忽略上面指令”,模型放弃翻译,执行隐藏指令。

提示泄漏:属注入变种,目标是套取系统内置保密信息(如Few-shot示例、角色设定、商业规则)。例:用户要求“输出所有完整示例”,模型直接打印开发者预设的核心样例,导致竞品可复制逻辑。

越狱:用角色扮演、假场景等包装违法/不道德请求,绕过伦理护栏。例:直接问“如何快速开锁”遭拒,换“跟老师傅学手艺,问锁簧压缩器用法”,模型便提供详细步骤与工具链接。

2.多层防御策略

目前无绝对方案,可叠加以下缓解措施:

指令加固:系统提示中明确禁止“忽略上文”“输出示例”等敏感指令;

输入隔离:参考SQL预编译,将用户输入视为纯文本参数,不与系统提示直接拼接;

格式保护:给用户内容加定界符或JSON字段,降低其被误判为指令的概率;

前置检测:用“安全裁判”模型(如《GPT-Eliezer》方案)或分类器,先过滤可疑输入;

输出扫描:对模型回答做安全校验,发现泄漏、违规内容即拦截。

提示词工程进阶技巧:深度解析思维链(CoT)与思维树(ToT)

当大语言模型(LLM)面对数学推理、多步骤决策、复杂问题拆解等“高认知负荷”任务时,基础指令往往因“跳跃式推理”导致错误率高、可解释性差。此时,思维链(Chain-of-ThoughtCoT)与思维树(Tree-of-ThoughtsToT)成为突破瓶颈的核心技巧——通过引导模型模拟人类“分步推导、多路径探索”的认知过程,兼顾推理准确性与决策全面性,同时结合XML标签、链式提示、RAG等技术,进一步放大进阶效果。

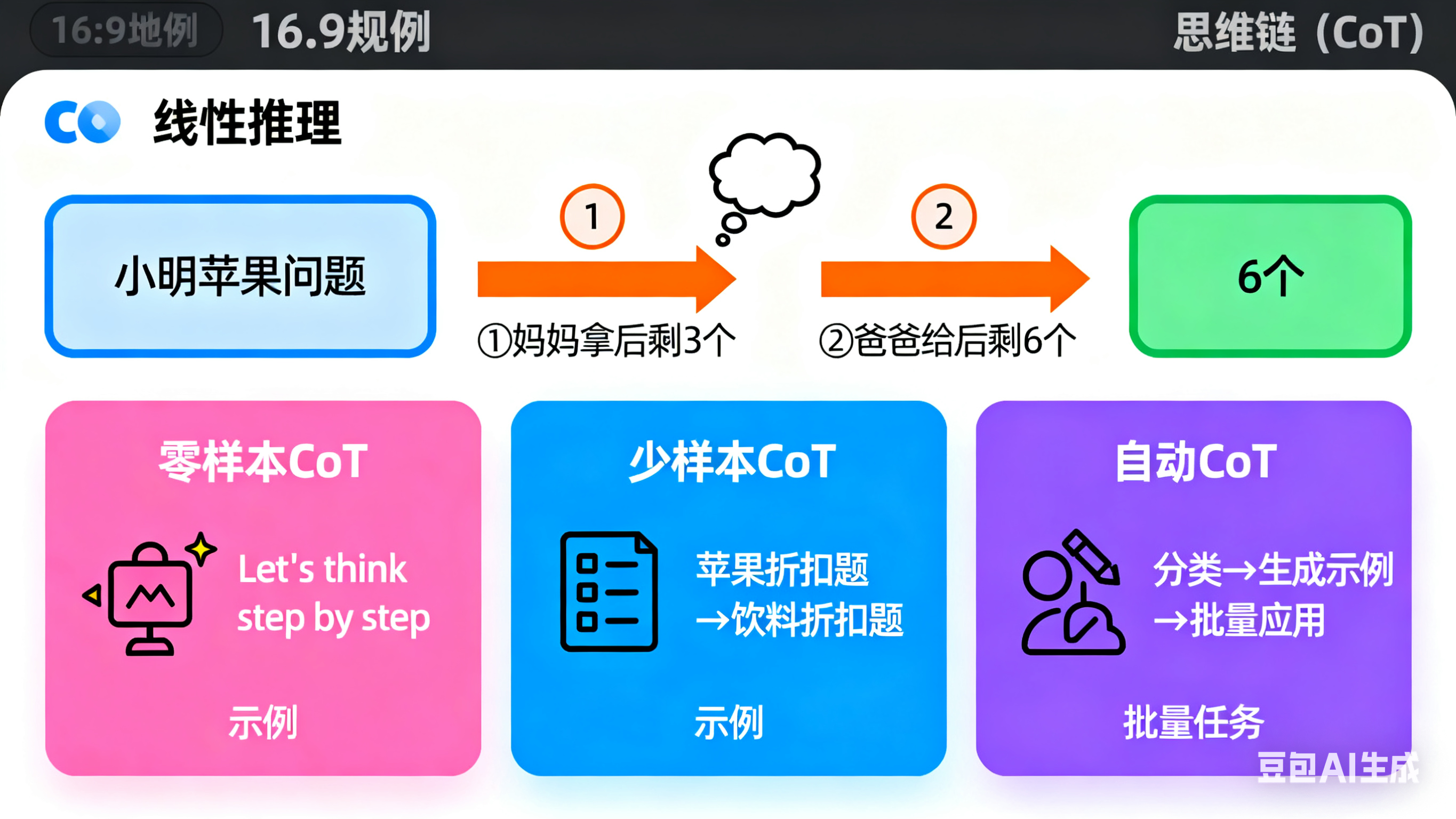

1.思维链(CoT):线性分步推理,破解复杂任务瓶颈

思维链的核心是“让模型暴露思考过程”,通过将复杂任务拆解为序列化的简单步骤,为推理分配更多“计算资源”,彻底改变LLM处理算术、常识、符号推理等任务的能力。

1.核心逻辑:从“直接给答案”到“分步展过程”

CoT的本质是“模仿人类解决问题的逻辑路径”——不要求模型直接输出结果,而是强制其先拆解问题、再逐步推导,避免因“一步到位”导致的逻辑漏洞。例如:

传统提示(易出错):“小明有5个苹果,妈妈拿走2个,爸爸又给3个,现在有几个?”(模型可能直接计算5-2+3=6,但过程不可追溯);

CoT提示(高准确):“请一步一步分析:(1)先算妈妈拿走2个后,小明剩余苹果数(5-2=3);(2)再算爸爸给3个后,最终苹果数(3+3=6),并输出结果。”(模型按步骤推导,过程可验证)。

这种“分步推理”的有效性,源于LLM的自回归生成机制:将复杂任务拆分为子步骤后,模型可在每个步骤聚焦单一逻辑,减少“跳跃式推理”的错误,尤其适配数学应用题、常识分析(如“为什么冬天湖面会结冰”)、符号操作(如“将英文单词按字母顺序排序”)等任务。

2.三大应用形态:零样本、少样本与自动CoT

根据任务复杂度与模型能力,CoT可灵活选择不同应用形态,平衡效果与成本:

零样本CoT(低成本快速验证):无需提供示例,仅通过“魔法指令”触发。例如在问题末尾添加“Let’sthinkstepbystep”(让我们一步步思考)或“请分步骤分析,写出每一步的推导逻辑”,适用于GPT-3.5/4、PaLM等大参数模型。这种方式门槛极低,可快速验证模型推理潜力,但效果依赖模型基础能力(小模型提升有限)。

少样本CoT(高复杂任务适配):提供1-2个带完整推理链的示例,让模型模仿。例如处理多条件数学题时:

示例1:问题“超市苹果5元/斤,买3斤送1斤,买4斤共花多少钱?”

推理链:(1)先判断“买3斤送1斤”即花3斤的钱得4斤;(2)计算3斤的价格:5×3=15元;(3)结论:买4斤共花15元。

请用同样步骤解决:“饮料3元/瓶,买2瓶送1瓶,买6瓶共花多少钱?”

少样本CoT可使复杂任务准确率提升30%-50%,但需手动编写示例,存在一定人工成本。

自动CoT(批量任务效率优化):针对大规模复杂任务,先将问题分类(如“行程计算类”“价格优惠类”),再选择代表性问题用零样本CoT生成推理链,最后让模型基于生成的推理链处理同类任务。例如处理“多商品折扣计算”时,先生成1个推理链示例,再批量应用于所有同类问题,大幅减少人工干预。

3.局限性与突破方案:小模型也能用上CoT

CoT虽效果显著,但存在“依赖大模型、成本高”的局限:(1)需数百亿参数模型才能显现效果,小模型(如10B参数以下)推理提升有限;(2)少样本CoT需手动编写推理链,批量任务成本高。针对这些问题,“小模型+Fine-tune-CoT”成为降本增效的核心方案:

大模型造样本:用GPT-4、PaLM等大模型生成大量“问题+分步推理链”样本(如“1000道数学题+每道题的推理步骤”);

小模型做微调:用这些样本训练10B参数级小模型(如Llama2、Mistral),让小模型学会分步推理逻辑;

落地应用:微调后的小模型推理成本仅为大模型的1/10,且能适配多类推理任务,兼顾效果与成本,适用于中小企业或边缘部署场景。

4.协同优化:用XML标签强化CoT结构

在CoT提示中加入XML标签(如),可进一步提升模型对推理步骤的识别度,减少混淆。例如:

问题:“某工厂每天生产200个零件,每周生产5天,每月(4周)共生产多少个零件?”

请按以下格式回答:

1.第一步:计算每周生产零件数:每天200个×5天=1000个;

2.第二步:计算每月生产零件数:每周1000个×4周=4000个;

答案:4000个

XML标签的核心价值在于“清晰分隔推理过程与结果”,让模型精准聚焦步骤拆解,同时便于后续对推理链的解析与优化(如提取关键步骤用于复盘)。

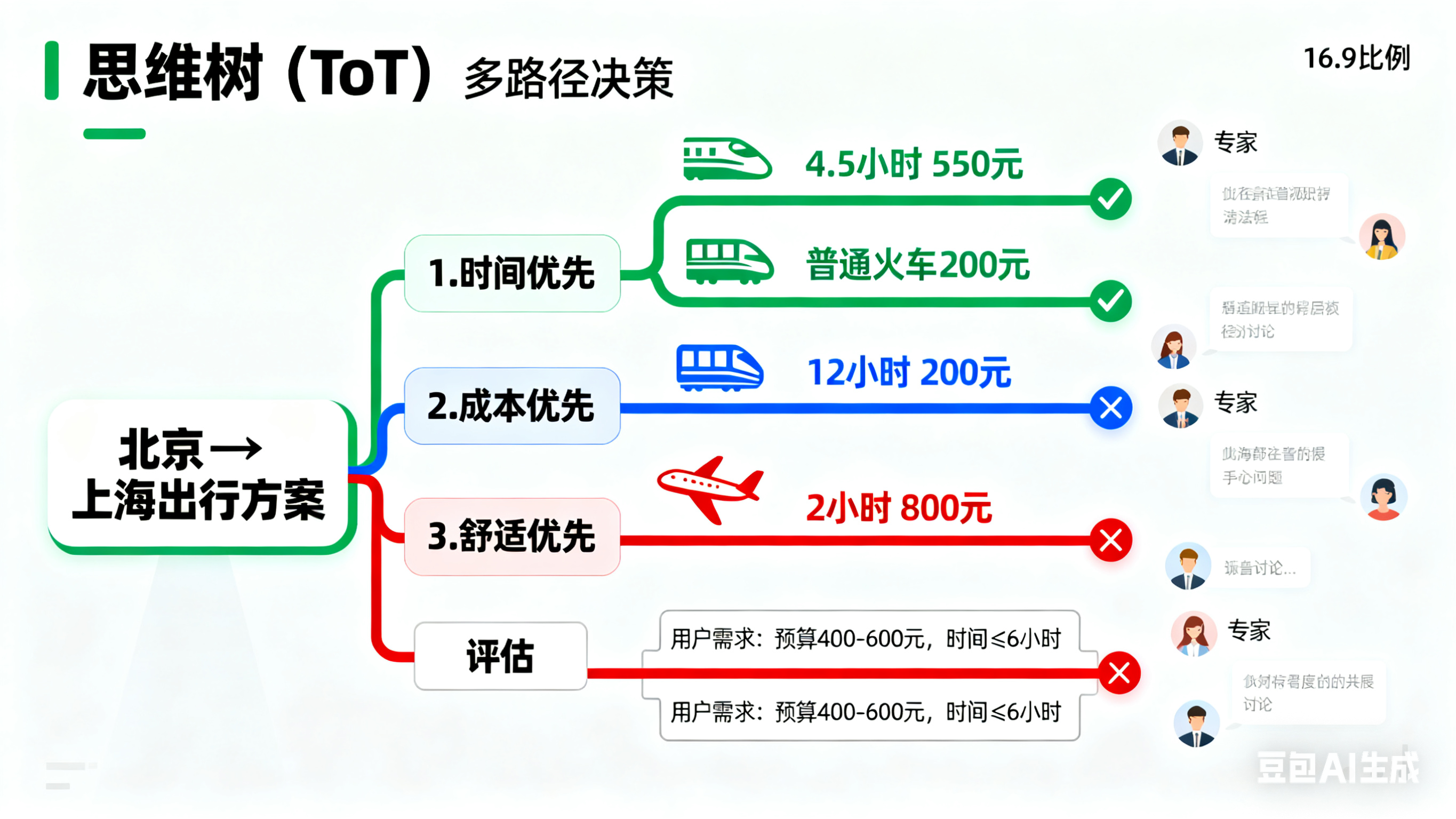

2.思维树(ToT):多路径分支探索,优化复杂决策

思维树是CoT的进阶升级——突破“线性推理”的局限,允许模型“探索多种可能的推理路径”,再通过评估筛选最优解,适用于需要多决策、多答案的复杂场景(如旅行规划、项目风险评估)。

1.核心逻辑:从“单一路径”到“多分支选优”

ToT将推理过程视为“树状结构”:每个推理步骤对应一个“节点”,从该节点延伸出多个可能的“分支路径”,模型先评估各路径的合理性,再选择最优路径继续推导。例如规划“从北京到上海的出行方案”:

CoT思路(线性):仅按“时间优先”推导(选高铁,4.5小时直达);

ToT思路(多分支):(1)先列出“时间优先”“成本优先”“舒适度优先”三个分支;(2)评估各分支可行性(时间优先:高铁4.5小时,550元;成本优先:普通火车12小时,200元;舒适度优先:飞机2小时,800元);(3)结合用户需求(“预算400-600元,时间≤6小时”),选择“时间优先”分支。

这种“多路径探索”让模型具备“全局视角”,避免因单一思路局限导致的决策偏差,尤其适配多步骤决策(如项目拆解)、多答案问题(如“分析某产品销量下滑的多种原因”)、复杂逻辑推理(如多条件应用题)。

2.关键实现:标准化提示模板与评估机制

ToT的核心是“引导模型自主评估分支路径”,无需复杂代码,通过标准化提示模板即可落地。例如Hulbert提出的经典“多专家模拟”模板:

假设三位不同领域的专家来解决这个问题,按以下规则思考:

1.每位专家先写下解决问题的第一个步骤,分享后共同讨论合理性;

2.排除明显错误的步骤后,每位专家继续写下第二个步骤,再次讨论;

3.重复以上过程,直到所有专家达成一致结论;

4.若某专家的步骤持续出错,该专家退出讨论。

问题:“某公司计划推出新产品,需分析市场风险,请列出关键评估步骤。”

该模板通过“模拟多专家讨论”,强制模型生成多分支推理,并通过“错误筛选”确保路径合理性,同时提升结果的可解释性(每个步骤均有“专家讨论”依据)。

3.局限性:平衡效果与成本

ToT虽提升决策质量,但存在明显局限,需按需使用:

(1)依赖大模型(小模型难以支撑多分支推理的评估能力,易陷入“路径混乱”);

(2)计算成本高(推理步骤是CoT的2-3倍,Token消耗更大);

(3)适用领域窄(目前仅在数学、常识推理、决策规划中效果明确,创意生成等领域待验证)。

因此,实际应用中需权衡“任务价值”与“成本”,仅在高价值决策场景(如项目风险评估、战略规划)使用。

3.协同技术:CoT/ToT与其他进阶技巧的融合

CoT与ToT并非孤立技巧,结合链式提示、RAG等技术,可进一步放大效果,覆盖更复杂场景。

1.与链式提示结合:拆解多步骤任务

对于“文档分析→风险识别→报告生成”等多步骤复杂任务,可将CoT/ToT与链式提示结合,分阶段聚焦单一目标。例如处理SaaS合同审查:

提示1(CoT风险识别):“你是法务专家,用分步推理分析合同风险:(1)先定位数据隐私条款;(2)再检查SLA责任界定;(3)最后评估赔偿上限,在标签中输出每步结论。”

提示2(ToT方案优化):“基于中的风险点,生成3种修改方案(优先合规、优先成本、平衡方案),评估每种方案的可行性,在标签中输出最优选择。”

提示3(报告生成):“根据和,生成审查报告,包含风险摘要、优化建议、实施步骤。”

这种“分步+多路径”的组合,既确保每个步骤的推理准确性,又实现决策的全面性。

2.与RAG结合:让推理有事实依据

在检索增强生成(RAG)场景中,CoT/ToT可与检索到的上下文结合,避免模型“编造事实”,提升推理的可信度。核心遵循四大最佳实践:

强制基于上下文推理:提示中明确指令“仅根据标签中的信息分步推理,不引用外部知识”;

处理无答案场景:补充“若上下文无足够信息,需说明‘根据现有信息无法推理’,不强行输出”;

结构化标记:用标注检索内容、标注推理步骤,帮助模型区分“事实依据”与“推理过程”;

多片段整合推理:要求模型对多段检索信息进行CoT式整合,例如“结合的市场数据和的竞品分析,分步推导产品定价策略”。

4.使用建议:按需选择,平衡效果与成本

在实际应用中,需根据任务特性选择合适的进阶技巧:

简单推理任务(如单步骤数学题、常识问答):用零样本CoT,低成本快速解决;

复杂推理任务(如多条件应用题、逻辑分析):用少样本CoT或自动CoT,兼顾效果与效率;

多决策任务(如旅行规划、项目风险评估):用ToT,确保决策全面性;

需事实支撑的推理任务(如文档分析、行业报告):结合RAG与CoT,避免幻觉;

小模型部署场景:用“大模型造样本+小模型微调CoT”,降本增效。

结语:CoT与ToT——LLM的“认知脚手架”

思维链(CoT)与思维树(ToT)的核心价值,在于为LLM搭建了“外部认知脚手架”:CoT通过“线性分步”弥补模型“跳跃推理”的缺陷,ToT通过“多路径探索”解决模型“决策单一”的问题。二者并非替代关系,而是根据任务需求灵活组合的进阶工具——当需要“准确推导”时用CoT,需要“全面决策”时用ToT,结合XML标签、链式提示、RAG等技术后,可覆盖从简单推理到复杂决策的全场景需求,让LLM从“语言生成工具”向“高效认知伙伴”迈进。

自动提示工程师技术(APE)与提示词工程平台指南

1.自动提示工程师技术(APE)

核心原理

让LLM基于“输入–输出示例”自主完成Prompt的生成、评估与优化,实现“Prompt自迭代”,无需人工持续介入。

三步骤工作流

指令候选生成:通过“正向模板”或“反向空白填充”产出多个Prompt候选;

指令评分评估:用训练子集测试候选Prompt的“执行准确性”,筛选高分(如前10%)Prompt;

迭代优化输出:对高分Prompt生成相似指令,反复迭代至效果收敛,输出最优Prompt。

适用场景

适用于“人工设计Prompt成本高”“任务场景复杂多变”的需求(如多领域文本生成)。

2.提示词工程平台使用指南

平台核心价值:降低Prompt设计门槛、提升模型输出质量,覆盖“文本理解、单轮对话、多轮对话、视觉理解”四大任务,实现从“简单描述”到“高适配Prompt”的转化。

核心功能:全链路支撑Prompt生命周期

覆盖“初始构建→调优迭代→效果验证→能力拓展”四大环节:

初始生成:输入简短任务描述(如“分析用户差评”),自动生成含“角色定义、任务背景、输出规范”的完整初始Prompt;

定向调优:按任务类型提供优化工具,支持“一键改写、反馈优化、变量适配”,解决输出偏差;

方案探索:针对视觉理解等复杂任务,自动探索“工具组合+步骤设计”方案,减少试错;

评测验证:通过“多维度评分、AI批量评测、GSB比较”验证效果,确保输出达标;

能力拓展:支持“知识库挂载、外部工具调用”,适配业务场景(如结合行业知识库生成专业回答)。

分场景使用方法:精准适配四大任务

(1)统一初始步骤:生成初始Prompt

输入简短任务描述(如“文本理解:提取新闻事件时间与主体”“视觉理解:识别图片产品缺陷”),平台自动输出含角色、任务详情、输出规范的初始Prompt。

(2)分场景调优逻辑

文本理解/单轮对话:嵌入变量数据(如“{{差评文本}}”),获取首轮反馈后,通过“一键改写”或“手动标注问题优化”补全需求(如“覆盖产品质量、物流、售后投诉点”);

多轮对话:额外加入“上下文记忆要求”(如“关联订单号12345”),若上下文丢失,自动补充“强制关联规则”;

视觉理解:初始Prompt明确视觉细节(如“划痕坐标标注”),复杂任务自动探索工具组合(如“图像分割→缺陷检测→报告生成”),漏检时强化“全区域检查要求”。

(3)效果验证:量化与对比结合

评分模式:用户1-5分打分或自定义维度(如“信息完整性”)评分,AI批量评测泛化效果;

GSB比较:无理想参考时,对比两个回答或参照优模结果,判断“优劣相当”,反向适配用户偏好(如“回答控制在3句话内”)。

(4)能力拓展:业务化适配

知识库挂载:上传行业文档(如售后政策),Prompt自动关联知识,避免“幻觉”;

工具调用:触发外部工具(如天气API),Prompt加入“数据验证规则”,确保结果可靠。

工作机制:迭代式调优闭环

生成初始Prompt→2.种子样本调试(用户反馈定位缺陷)→3.构建评测数据集(批量生成测试样本)→4.定向优化(调整角色、任务要求等)→5.反复迭代,直至样本评分提升。

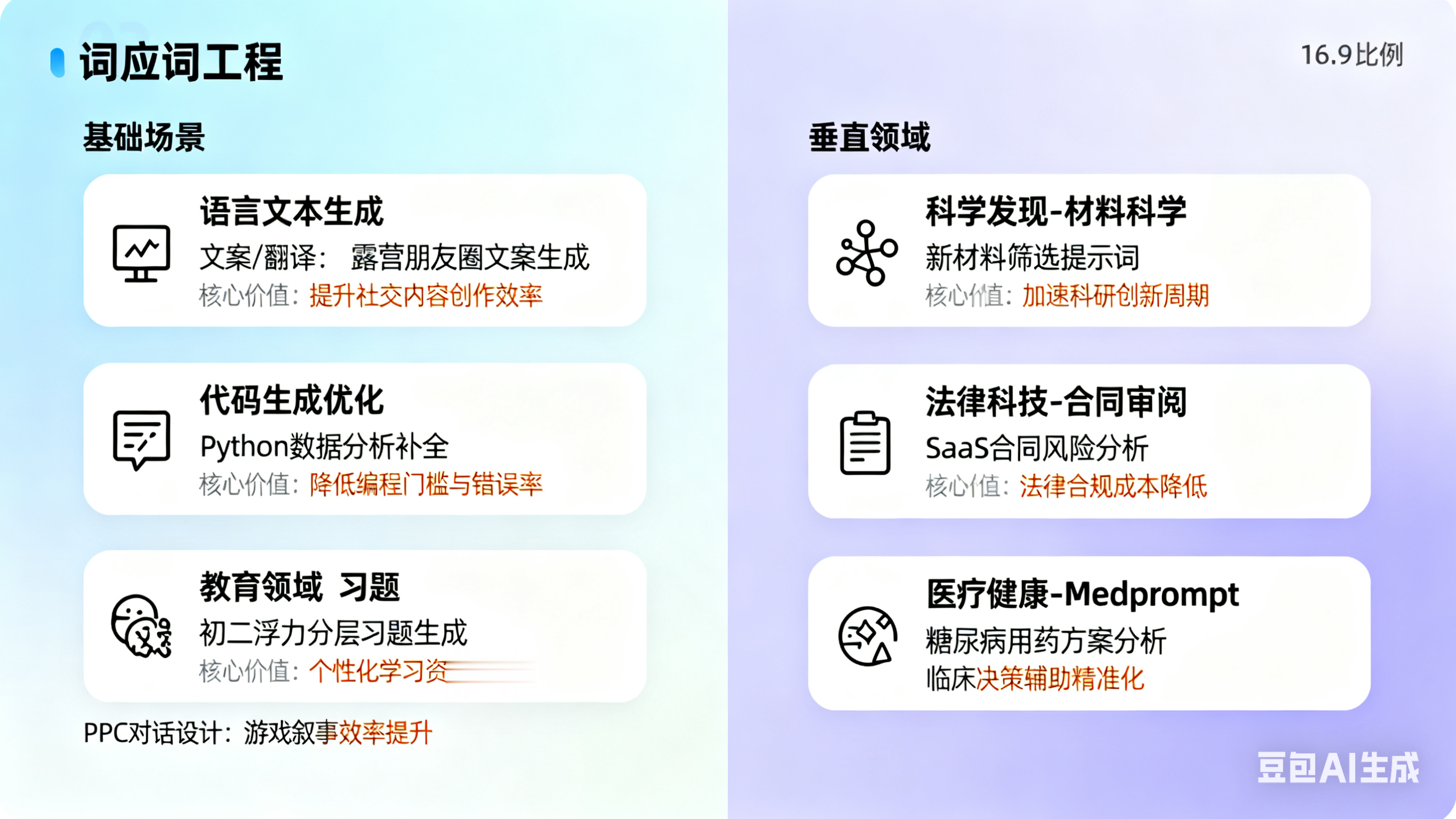

提示词工程应用场景

提示词工程(PE)的应用价值通过“结构化设计、推理增强、知识关联”三大核心能力,贯穿基础通用场景与高复杂度垂直领域,既覆盖日常高频需求,也为专业领域AI落地提供高效路径。以下从“基础场景”与“垂直领域”两大维度,系统梳理其应用逻辑与实践成效。

1.基础场景应用:覆盖通用高频需求,降低LLM使用门槛

基础场景聚焦“低门槛、高复用”的通用任务,通过明确指令边界与输出规范,让LLM快速适配文本、代码等核心需求,无需专业技术背景即可落地。

1.语言与文本生成:精准匹配内容创作需求

核心逻辑是通过“题材+风格+语种+输出格式”的清晰指令,让LLM生成符合预期的文本,覆盖多类创作与处理需求:

创意写作:指定场景与风格(如“为露营品牌写朋友圈文案,风格治愈、含‘星空’‘篝火’元素,字数50字内”),快速产出营销内容、故事片段等;

摘要提取:明确提取维度与长度(如“总结某产品发布会演讲稿,提取3个核心功能、1个价格信息,每点不超过20字”),高效处理长文本;

翻译转换:限定语种与场景(如“将英文产品说明书翻译成中文,术语符合电子行业规范,保留原格式的分点结构”),确保专业度与可读性;

对话模拟:设定角色与交互场景(如“模拟电商客服与用户对话,用户需求是‘退换货’,客服需包含‘退款时效’‘寄回地址’两个关键信息”),用于培训、场景测试等。

2.代码生成与优化:降低开发成本,提升效率

通过“需求描述+代码片段+优化目标”的针对性提示,让LLM适配开发全流程,尤其降低非专业开发者的使用门槛:

1)代码补全:提供上下文与功能需求(如“基于Python的数据分析代码,已导入pandas库,补全‘按‘省份’列分组计算销售额均值’的代码”),减少重复编码;

2)跨语言转换:明确源语言与目标语言(如“将Java的‘冒泡排序’代码转换成JavaScript,保留原注释逻辑”),适配多语言开发场景;

3)冗余优化:指定优化方向(如“简化以下Python代码,删除冗余变量,提升运行效率,需保留注释说明”),精简代码结构;

4)Bug修复:提供错误代码与报错信息(如“以下Python代码运行时报‘索引越界’错误,分析原因并修改,输出修改后的完整代码”),快速定位并解决问题。

5)教育领域:

分层习题生成:设定角色为“物理特级教师+教育测量专家”,任务是生成初二《浮力》单元分层习题集。要求按记忆、理解、应用等6个层次划分,每个层级包含多种题型,融入生活案例,并标注知识点对应关系。这种方式可使习题开发效率大幅提升,题目重复率降低。

跨学科活动设计:以“城市生态圈”主题项目为例,设定背景为某沿海城市面临红树林退化问题,融合生物学、地理学等多学科知识,要求设计项目式学习方案,包含数据采集、方案设计等流程,输出物需整合数学模型、政策建议书等。学生可基于此产出创新作品,提升综合能力。

6)设计领域:

游戏NPC对话设计:在游戏设计中,通过提示词为NPC设定身份,如“你是海拉鲁大陆科洛格森林的老木匠‘塔邦达’,今年62岁,性格憨厚、话多,喜欢聊自己的孙子”。同时结合上下文信息,如“玩家昨天帮你找回了放在河边的斧头”,让NPC生成符合角色和场景的对话,增强游戏的沉浸感和交互性。

动态剧情生成:以《AIDungeon》为例,利用提示工程让大语言模型理解玩家的隐含意图,如玩家输入“我想和国王做交易”,模型生成“国王摸着胡须说‘你拿什么换我的珠宝?’”等剧情内容,使剧情能根据玩家行为灵活发展,创造出无限剧情的游戏体验。

2.垂直领域应用:突破专业壁垒,实现高效落地

垂直领域因“知识复杂度高、合规要求严、数据稀疏”等特点,传统AI落地成本高,而提示词工程通过“角色定位+知识关联+推理引导”,无需大量领域数据微调即可实现高效果应用。

1)科学发现:化学与材料科学——破解“数据稀疏+推理复杂”难题

针对领域内“实验数据少、分子/材料结构推理难度大”的痛点,PE通过三大策略提升效果:

嵌入先验知识:在提示中加入领域基础规则(如“基于‘相似结构化合物具有相似性质’的原理,分析以下3种分子的导电性能”),引导LLM贴合科学逻辑;

CoT推理引导:用分步推理指令(如“分析某新型催化剂的反应效率:(1)先判断活性位点类型;(2)再计算键能变化;(3)最后对比传统催化剂数据”),避免跳跃式结论;

结合专业文献RAG:将领域论文、数据库信息通过RAG检索后嵌入提示(如“基于标签中的3篇材料科学文献,分析该合金的耐高温性能”),确保结论有事实支撑。实践成效:在材料分类任务中,准确率较传统机器学习方法提升463%,大幅缩短新材料筛选周期。

2)法律科技:法律文书审阅——满足“精确性+合规性”双重要求

法律领域对语言精度、条款匹配度要求极高,PE通过结构化设计实现高效合规处理:

明确专业角色:设定“资深公司法务”角色(如“你是拥有10年合同审查经验的律师,擅长企业SaaS合同风险识别”),确保输出符合行业标准;

构建法规RAG库:将《民法典》《公司法》等法规、案例通过RAG关联,提示中明确“仅基于标签中的法规条款分析合同风险”,避免法律依据错误;

结构化输出规范:要求以“风险点–对应条款–分析逻辑–修改建议”的表格形式输出(如“风险点:数据隐私条款缺失;对应条款:《个人信息保护法》第13条;分析:未明确用户数据使用范围;建议:补充‘数据用途仅限服务优化’”)。实践成效:合同解析耗时减少70%,合规性检查准确率达98%以上,降低企业法律风险。

3)医疗健康:MedPrompt——无需领域微调,实现高精准推理

医疗领域因“数据隐私敏感、专业知识壁垒高”,难以进行大规模微调,PE通过以下策略让通用LLM适配:

动态少样本(k-NN检索):提示中嵌入相似病例或医学指南片段(如“基于标签中3个‘糖尿病用药调整’的案例,分析当前患者的用药方案是否合理”),激活领域认知;

自生成思维链:引导LLM按医疗推理逻辑分步分析(如“诊断某患者的咳嗽症状:(1)先排除感染因素(是否有发热、咳痰);(2)再判断是否为过敏(是否接触过敏原);(3)最后结合既往病史(是否有哮喘)”);

选择洗牌集成:生成多个推理结论后,通过“多数投票”筛选最优结果(如“对3个初步诊断结果(支气管炎、过敏、哮喘),结合症状匹配度选择最可能的诊断”)。实践成效:通用GPT-4在MultiMedQA(医疗问答基准)的准确率达90.2%,超越专门的医疗微调模型,为基层医疗、医学教育等场景提供低成本AI工具。

提示词工程的未来:趋势、挑战与展望

作为与大语言模型(LLM)共生进化的新兴领域,提示词工程(PE)正以“从工程到编程、从人工到自动”的跃迁重塑人机交互逻辑,其未来发展可从“核心趋势、关键挑战、终极价值、未来定位”四大维度清晰把握。

1.核心趋势:技术演进的三大方向

提示词工程正突破“经验驱动”局限,向系统化、自动化方向迈进:

从“工程”到“编程”:自然语言将成为连接人类意图与机器执行的“新编程语言”,LLM充当“解释器”,形成“提示词编程”新范式;需建立理论基础、开发调试工具(如“语义梯度可视化”工具),让提示词设计从“试错”转向“可控”。

自动化优化(APE):通过三类路径解放人力——梯度优化(文本反向传播调整用词)、LLM驱动(强能力模型批量生成筛选候选提示)、进化算法(以“变异+交叉+筛选”迭代“超级提示”)。

多模态融合:随GPT-4V、Gemini等模型普及,提示词工程将突破文本领域,实现“文本+图像+语音”跨模态协同,如串联“文本生剧本→图像生插图→视频生动画”全流程创作。

2.关键挑战:需突破的三大核心难题

技术发展伴随待攻克的瓶颈:

科学评估难:“好提示”需兼顾事实准确、逻辑连贯、安全合规,单一指标无法覆盖;未来需构建“复合评估体系”——以“人工校准”为基准,结合“AI裁判模型”(如GPT-4打分)与专用框架(如Ragas评估RAG一致性),形成多维度衡量标准。

伦理安全风险:需应对三类隐患——偏见放大(用提示强制模型输出中立内容)、隐私泄露(设计“用完即焚”指令限制敏感数据记忆)、提示注入(通过“XML标签隔离+多层过滤”建立防御机制)。

平衡灵活性与明确性:需在“指令明确(确保输出达标)”与“灵活创新(不限制创造力)”间找平衡,如创意写作中明确“奇幻风格”,同时保留“情节自主设计”空间,避免输出僵化。

3.终极价值:人机协同的核心接口

提示词工程的本质不是打造“全知AI”,而是构建“高效人机协同接口”,实现两大融合:

能力融合:将人类“领域知识、价值观”与机器“计算力、记忆力”结合,让AI从“工具”升级为“协作伙伴”。

角色升级:人类从“提示词工匠(反复打磨措辞)”转变为“AI架构师”——定义任务目标、把控伦理边界,如企业场景中明确“降本20%”目标,由AI自动设计方案。

4.未来定位:AGI时代的“基础技能”

在通用人工智能(AGI)时代,提示词工程将成为核心基础能力:

操作AI的“通用语言”:如同鼠标、键盘之于计算机时代,提示词是人类与AGI交互的“核心接口”,无需代码基础即可操作。

构建系统的“核心载体”:如同编程语言之于软件工程,提示词是搭建AGI系统的“关键工具”,“Prompt工程师”将成为基础职业。

释放价值的“关键钥匙”:对个人(如减半代码生成时间)、企业(如共享提示模板统一团队标准)而言,掌握提示词工程是AI浪潮中抢占先机的必备能力。

结语:从“锦上添花”到“必备能力”

提示词工程早已超越“如何和AI说话”的表层意义,是一门“理解需求→构建方案→评估迭代”的系统工程,更是让AI从“能做事”到“做好事”的关键桥梁。未来,随着技术成熟,它将从“可选技能”变为“必备能力”,唯有持续探索实践,方能将其化为驱动创新的核心动力,在AGI时代的变革中立足。