与其他全开源模型相比,性能提升2-5倍。

小参数模型也进入了R1时代,这次开源出新技术的是Meta。

本周五,MetaAI团队正式发布了MobileLLM-R1。

HuggingFace链接:https://huggingface.co/collections/facebook/mobilellm-r1-68c4597b104fac45f28f448e

试用链接:https://huggingface.co/spaces/akhaliq/MobileLLM-R1-950M

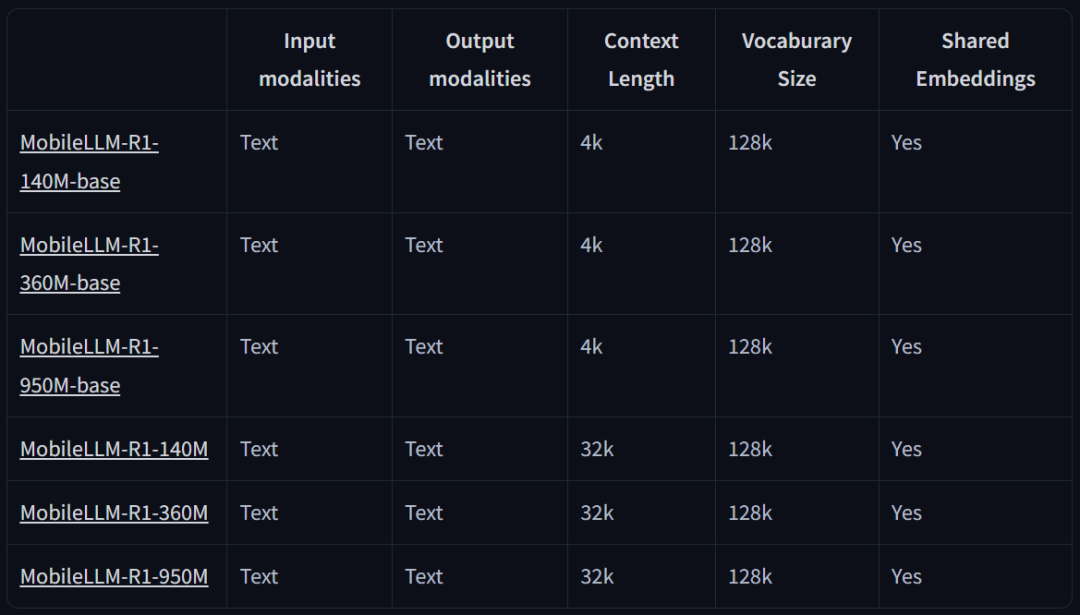

这是MobileLLM的全新高效推理模型系列,包含两类模型:基础模型MobileLLM-R1-140M-base、MobileLLM-R1-360M-base、MobileLLM-R1-950M-base和它们相应的最终模型版。

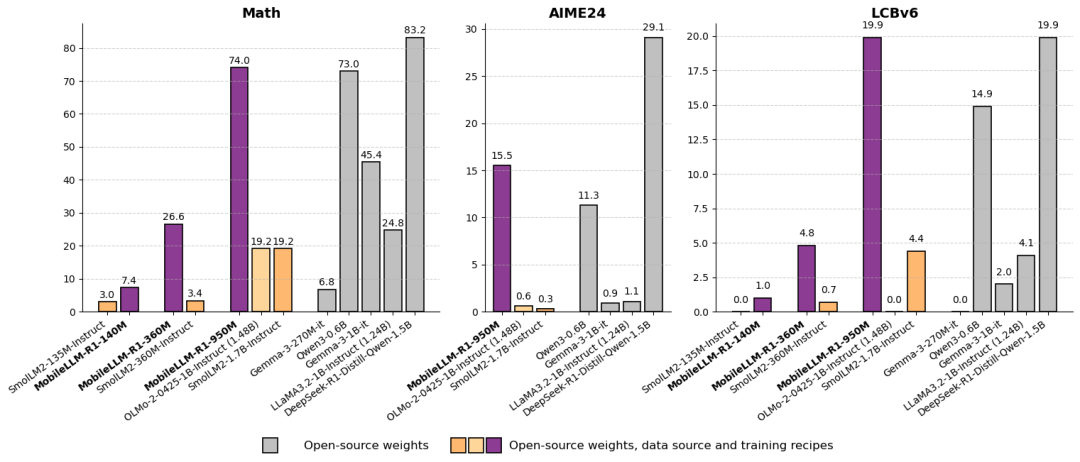

它们不是通用的聊天模型,而是监督微调(SFT)模型,专门针对数学、编程(Python、C++)和科学问题进行训练。

除了模型本身之外,Meta还发布了完整的训练方案和数据源,以确保可重复性并支持进一步的研究。

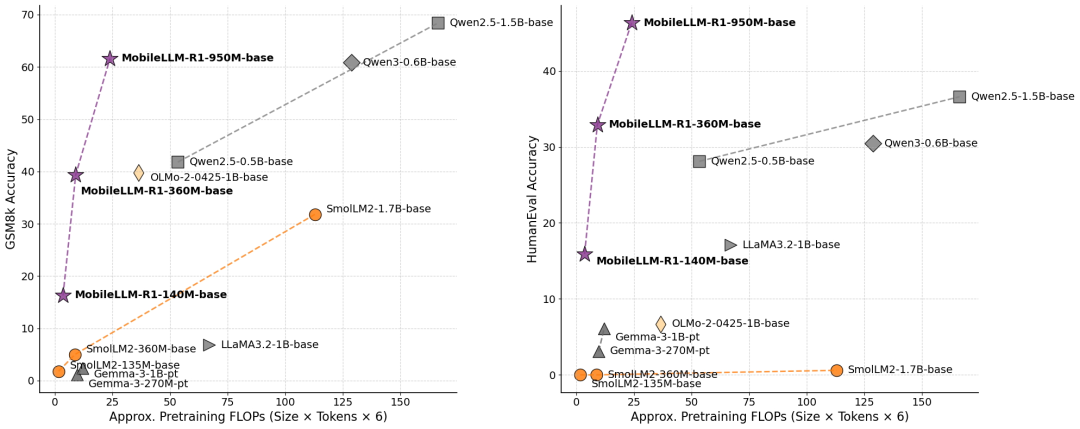

值得注意的是,该系列参数最大的MobileLLM-R1950M模型仅使用约2T高质量token进行预训练,总训练token量少于5T,但在MATH、GSM8K、MMLU和LiveCodeBench基准测试中,其性能与使用36Ttoken进行训练的Qwen30.6B相当或更佳。

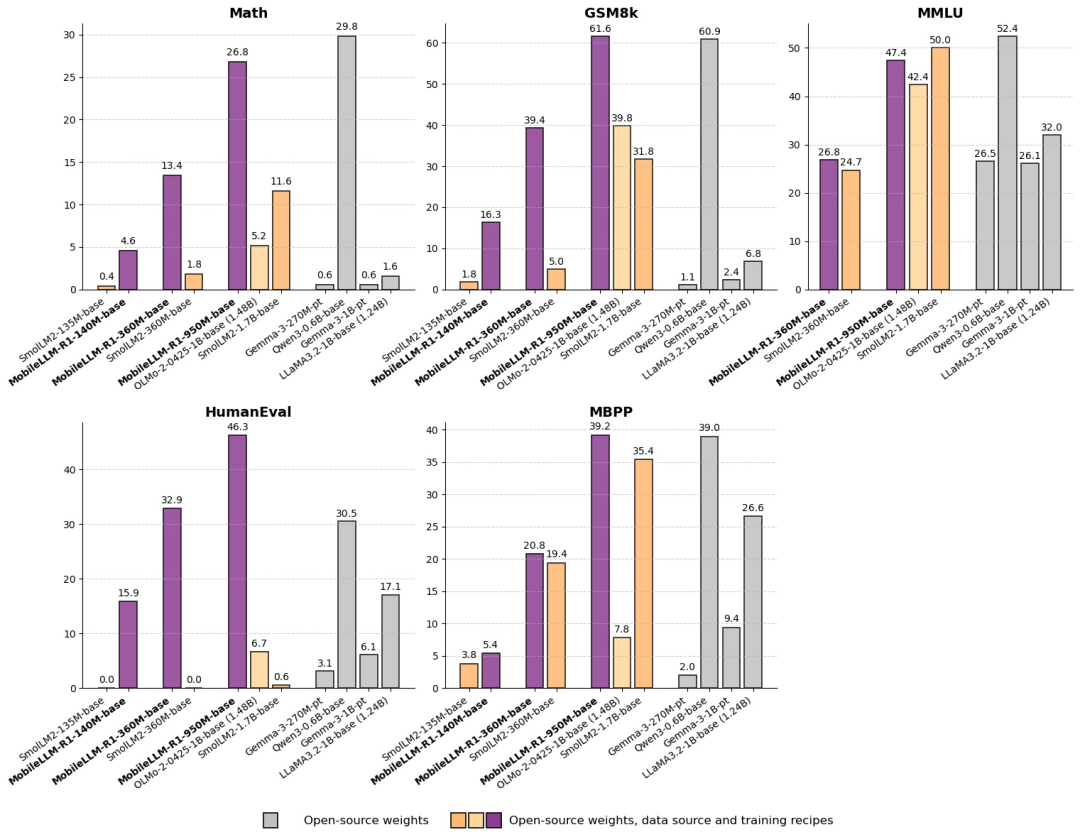

与现有的完全开源模型相比,尽管参数规模明显更小,MobileLLM-R1950M模型在MATH基准上的准确率也比Olmo1.24B模型高出约五倍,比SmolLM21.7B模型高出约两倍。此外,MobileLLM-R1950M在编码基准测试中的表现远超Olmo1.24B和SmolLM21.7B,在完全开源模型中创下了新的最高水平。

Token效率的比较如下:

后训练比较:

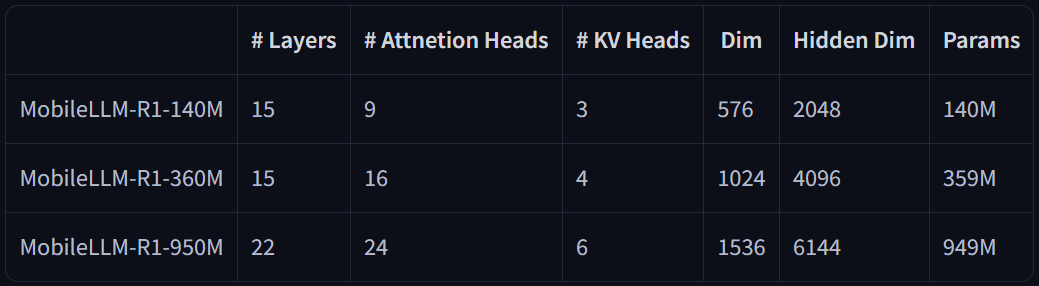

模型架构:

MobileLLM-R1的发布引起了机器学习社区的讨论。人们欢迎通义、Meta等顶尖大模型团队基于小体量模型的探索。这一方向的训练成本较为低廉,可以更加方便尝试各类最新论文提出的技术,更重要的是,模型体量的下降也意味着它可以覆盖更多端侧设备,实现更大面积的落地。

随着训练成本普遍下降,我们将会得到更好的模型。

背后三位华人作者

在MobileLLM-R1系列发布的同时,背后的作者们也正式亮相,他们表示,该工作的研发时间有一年之久。该项目由华人领衔。

ZechunLiu

ZechunLiu是MetaAI的研究科学家,专注于大模型和基础模型的高效部署与优化。

她的研究涉及大语言模型的预训练与后训练,神经网络架构设计与搜索,量化、剪枝与稀疏性,知识蒸馏以及高效的视觉-语言模型等,目标是在计算资源有限的环境中实现高性能模型的推理和部署。

2016年,她在复旦大学获得本科学位,2019年至2021年在卡内基梅隆大学担任访问学者,导师为MariosSavvides教授和EricXing(邢波)教授。2021年6月获得香港科技大学的博士学位,师从Kwang-TingTimCHENG教授。

ZechunLiu在顶级会议和期刊上发表了20多篇论文,其论文引用量达到了数千次。

ErnieChang

ErnieChang是MetaAI的研究科学家,专注于自然语言处理、多模态学习和高效模型部署等领域。

他于2023年2月加入Meta,参与了多个前沿项目的研究和开发。

在他的研究中,ErnieChang参与了多个重要的项目和论文。例如,他是《Agent-as-a-Judge:EvaluateAgentswithAgents》一文的共同作者,该论文提出了一种新的评估方法,通过代理模型对其他代理模型进行评估,从而提高评估效率和准确性。

此外,他还参与了《MobileLLM:OptimizingSub-billionParameterLanguageModelsforOn-DeviceUseCases》的研究,该研究致力于优化小语言模型,以适应移动设备上的应用需求。

ErnieChang的研究兴趣包括多语言处理、多模态系统等。

ChangshengZhao(赵常盛)

ChangshengZhao是MetaAI的研究科学家,专注于自然语言处理、深度学习和大语言模型的高效部署与优化。

他本科毕业于北京大学,后在哥伦比亚大学攻读硕士学位,毕业后去了三星美国研究员担任研究员,2021年加入Meta。

在Meta,ChangshengZhao参与了多个前沿研究项目,主要集中在模型量化、神经网络架构和多模态系统等领域。部分代表性工作包括:

ParetoQ:ScalingLawsinExtremelyLow-bitLLMQuantization:探讨极低比特量化在大语言模型中的缩放定律,帮助平衡模型大小与准确率。

LlamaGuard3-1B-INT4:参与开发Meta的开源LlamaGuard模型变体,这是一个紧凑高效的1B参数INT4量化版本,于2024年MetaConnect活动中开源,用于AI安全和内容过滤。