ChexGen:首个基于960,000+胸部X光图文对的生成式基础模型,开创胸部放射影像合成新纪元。

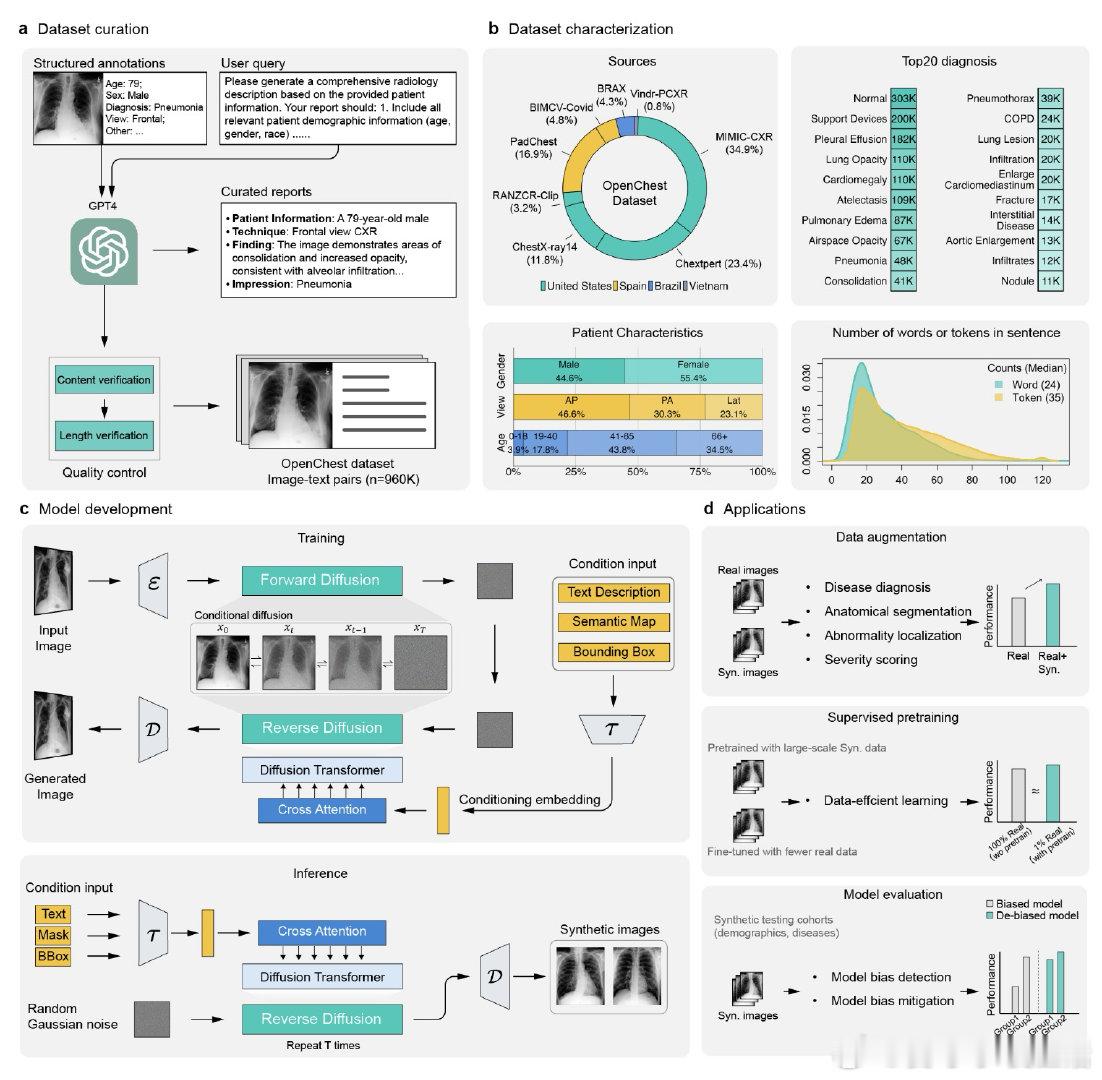

• 数据规模空前——汇聚来自8个国际队列的多样化胸片与标准化报告,涵盖多病理、多视角、广泛人口统计学特征,构建了迄今最大高质量胸片影像-文本配对数据库OpenChest。

• 先进架构——采用潜在扩散transformer结合T5文本编码器与Stable Diffusion VAE,支持文本、掩膜及标注框多模态条件引导,实现病灶精准空间控制,超越传统文本生成限制。

• 双阶段训练——先在960K低分辨率数据上进行视-语义预训练,再用45K高质量临床报告精调,实现高保真512×512胸片生成,细节丰富、临床关联紧密。

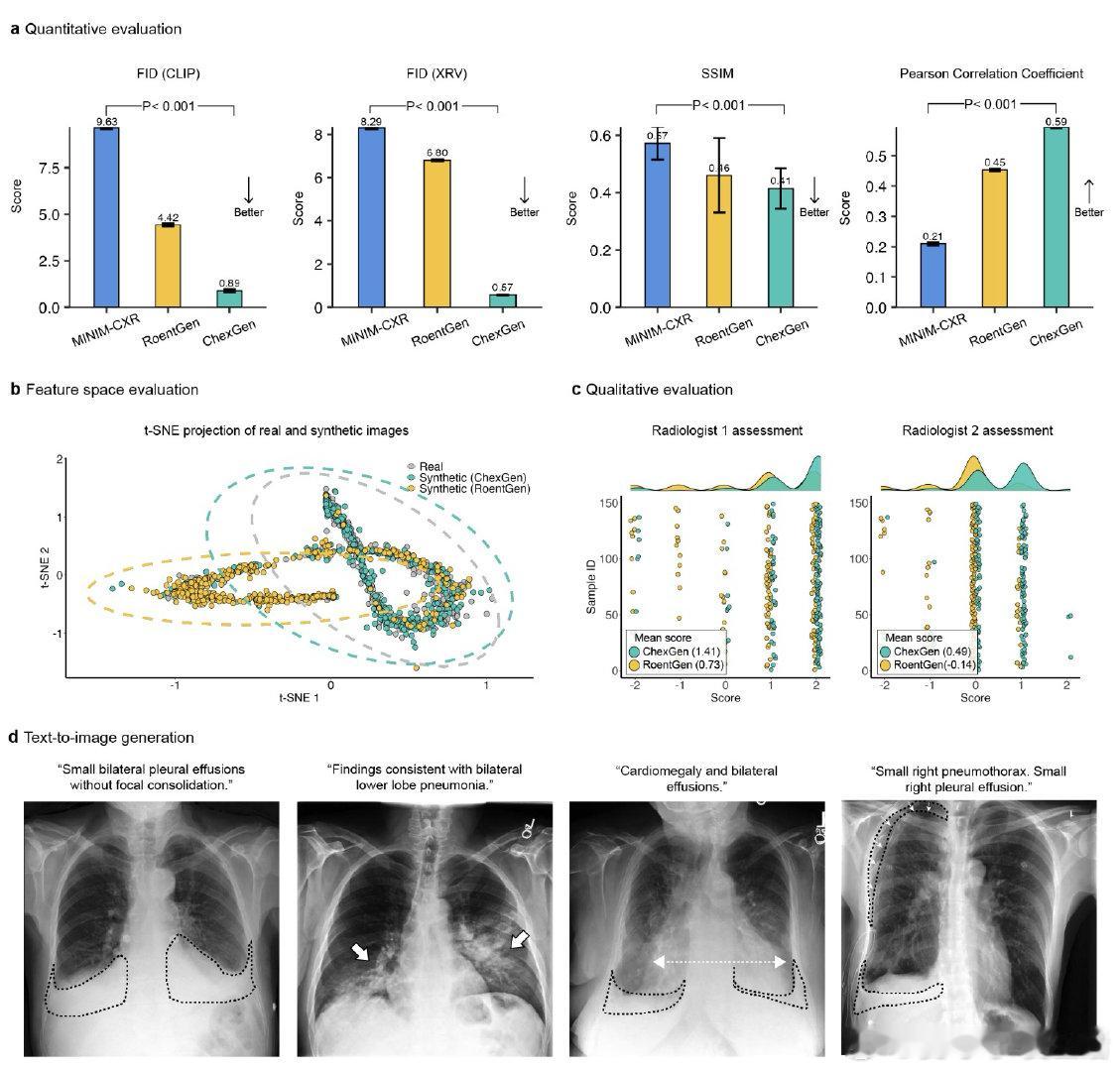

• 多维度评估——FID、SSIM、Pearson相关性指标均优于现有RoentGen和MINIM-CXR模型;双认证放射科医师盲评打分显著更高,图像与报告匹配度佳。

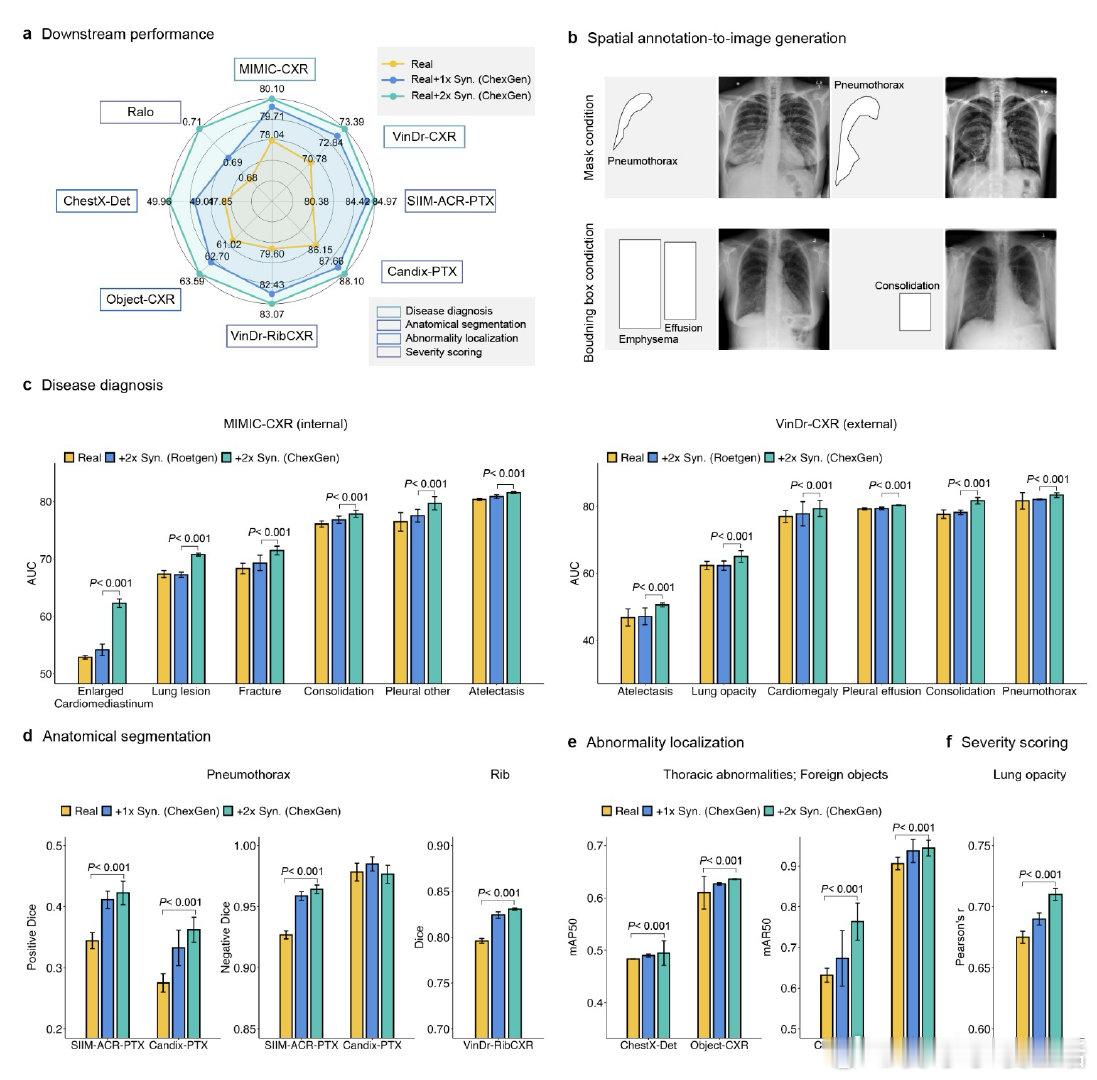

• 临床应用突破——合成数据用于训练增强,分类、分割、检测、严重度评分任务均显著提升(AUC提升约10%);少量真实数据微调下,预训练模型表现超越ImageNet预训练,极大节省标注成本。

• 公平性保障——通过定制合成患者群体,精准检测与缓解模型对性别、年龄、种族等群体偏差,提升算法公平性,应对法规合规需求。

• 灵活扩展——模块化设计,轻量ControlNet适配器易于微调,适配多种空间注释,实现更广泛医学影像合成任务。

心得:

1. 利用大规模、多源、多模态数据构建的生成模型能显著突破传统医学影像AI的数据瓶颈,推动数据多样性和真实性并重。

2. 融合文本与空间注释的生成框架为医学图像合成带来精细可控性,助力精准模拟复杂病理特征,增强模型训练针对性。

3. 合成数据不仅提升模型性能,还能成为公平性审查与偏差调节的强大工具,促进医疗AI的伦理性和临床可信度。

详情🔗arxiv.org/abs/2509.03903

人工智能 医疗影像 生成模型 胸部X光 深度学习 数据增强 算法公平性