[LG]《Beyond Scaling Law: A Data-Efficient Distillation Framework for Reasoning》X Wu, X Jiang, H Li, J Zhai... [Zhongxing Telecom Equipment(ZTE)] (2025)

突破缩放律:一种高效数据蒸馏框架提升推理能力

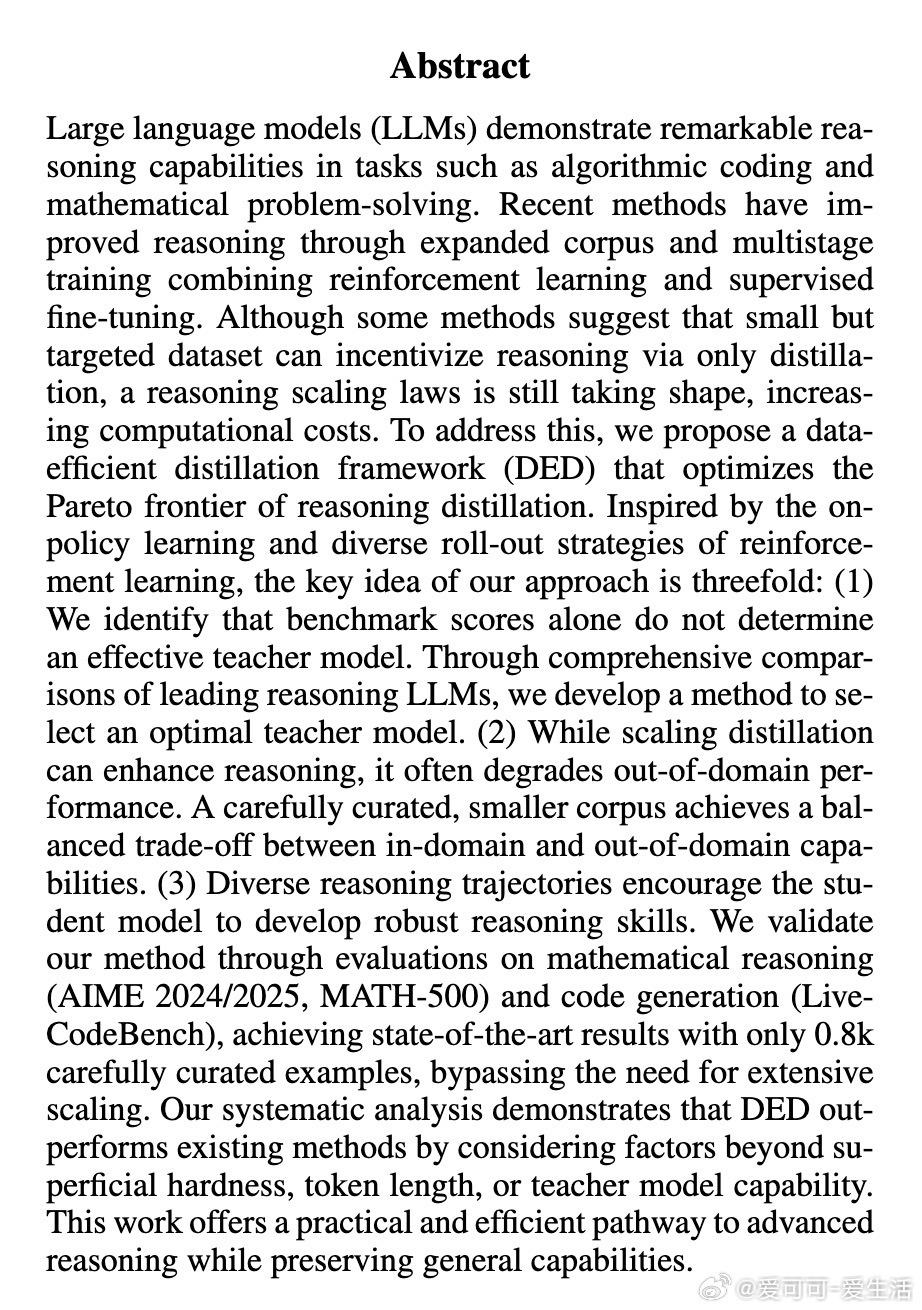

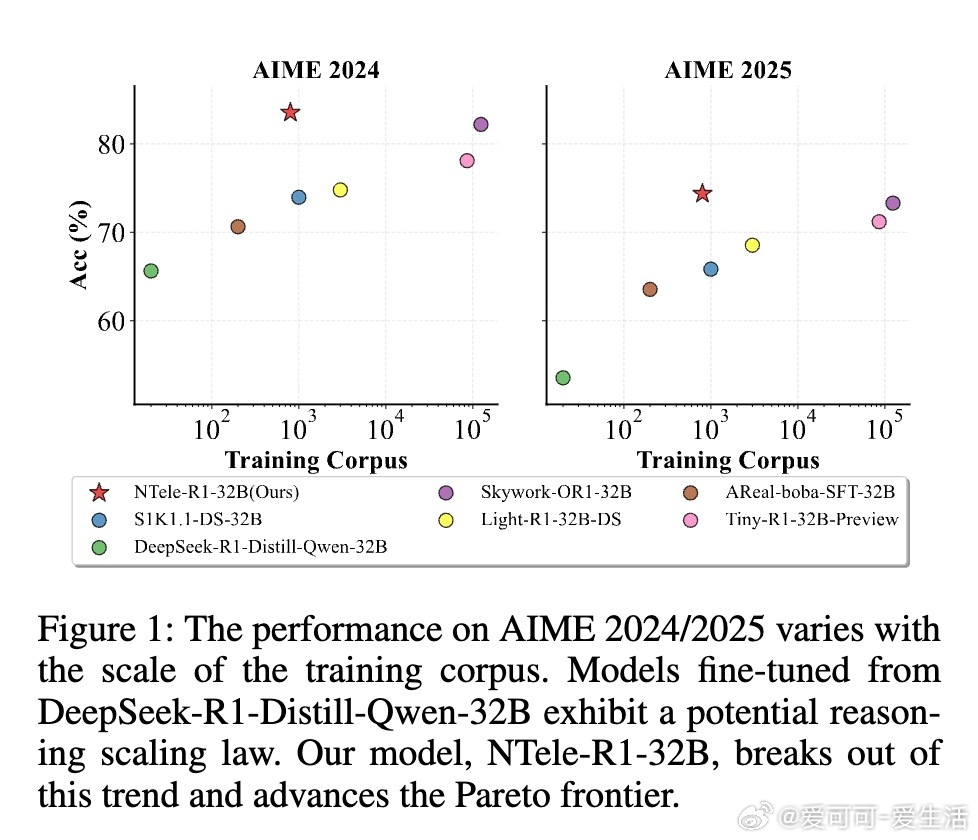

• 挑战传统规模扩展思路,提出数据高效蒸馏框架(DED),仅用约800个精心筛选的样本,在数学推理(AIME 2024/2025、MATH-500)和代码生成(LiveCodeBench)上实现SOTA表现。

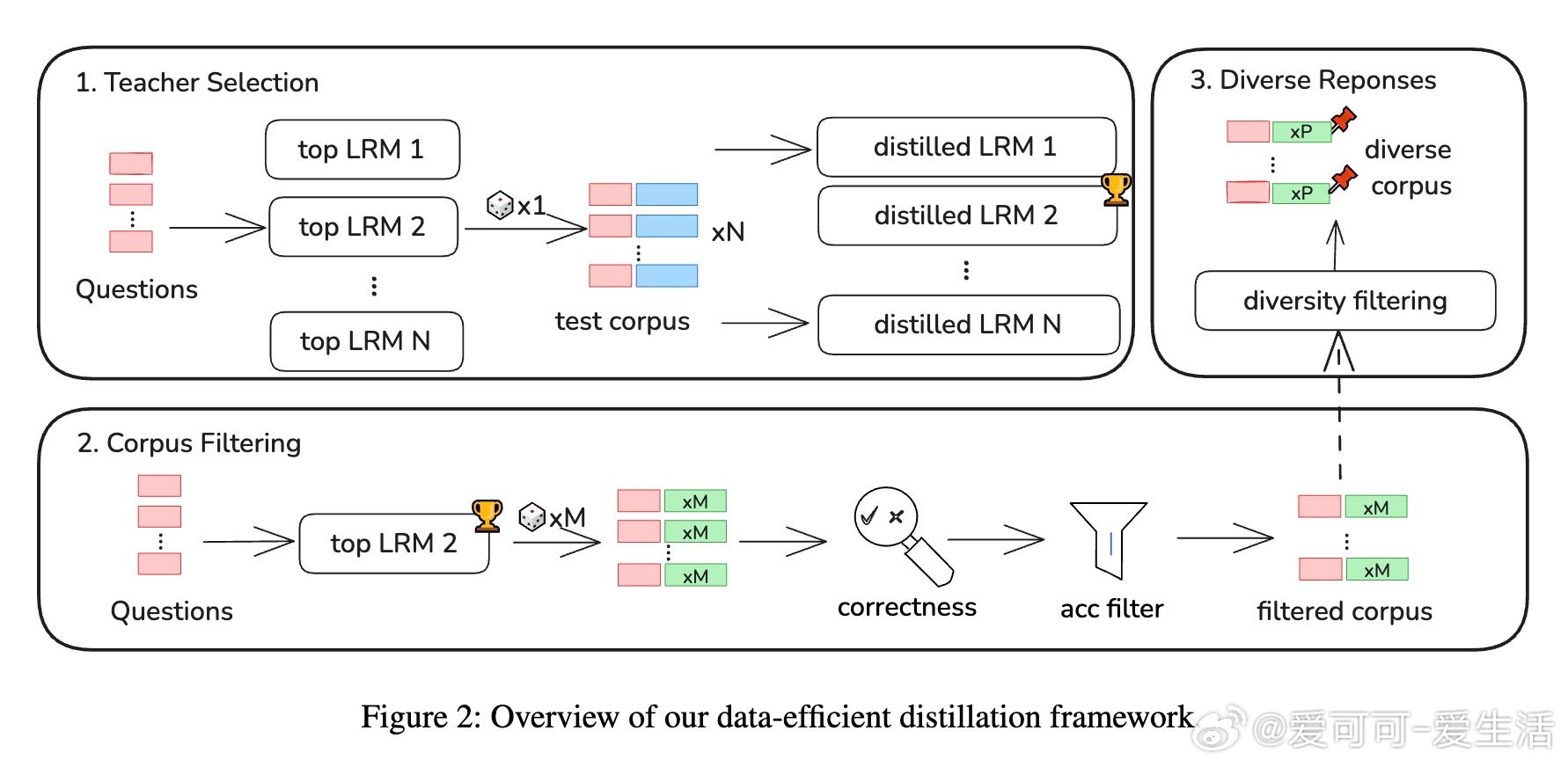

• 关键创新包括:1)基于快速蒸馏测试优选教师模型,发现最强基准表现模型未必是最佳教师;2)压缩训练语料,过滤易样本,平衡域内与域外性能,避免规模膨胀带来的泛化退化;3)引入多样化推理轨迹,提升学生模型的鲁棒性和推理深度。

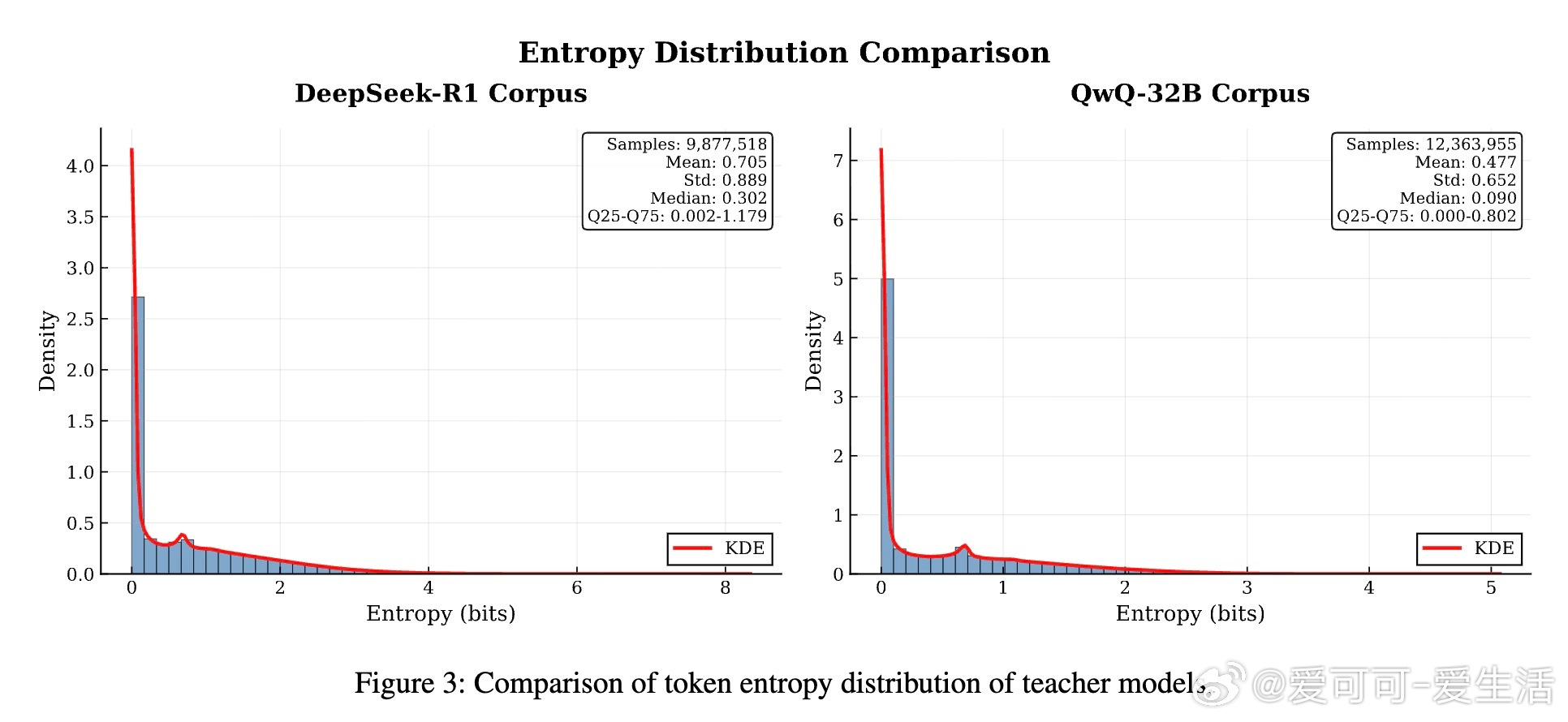

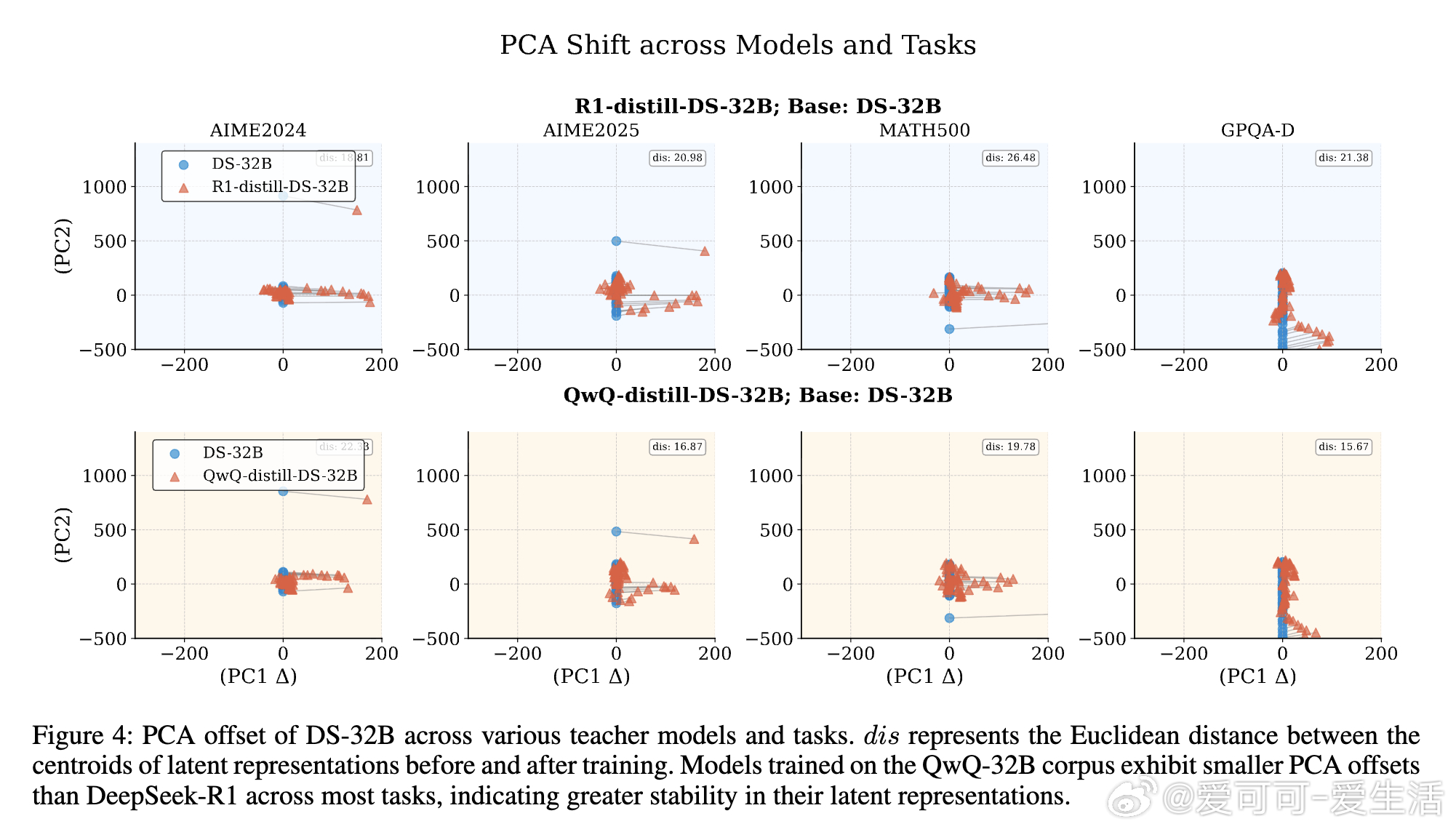

• 实验显示,传统以难度、token长度或教师模型强度衡量语料质量的做法不足以解释蒸馏效果,语料的token熵和潜在表征的PCA偏移更能反映知识迁移的有效性和模型泛化能力。

• DED框架在数学与代码双领域训练下,促进跨域能力提升,显著增强模型在多任务、多领域的推理和生成表现。

• 该方法为推理能力提升提供了一条高效、低成本且兼顾泛化的实用路径,适合资源受限环境下的模型优化。

详情请见🔗arxiv.org/abs/2508.09883

大语言模型推理能力知识蒸馏数学推理代码生成机器学习模型泛化