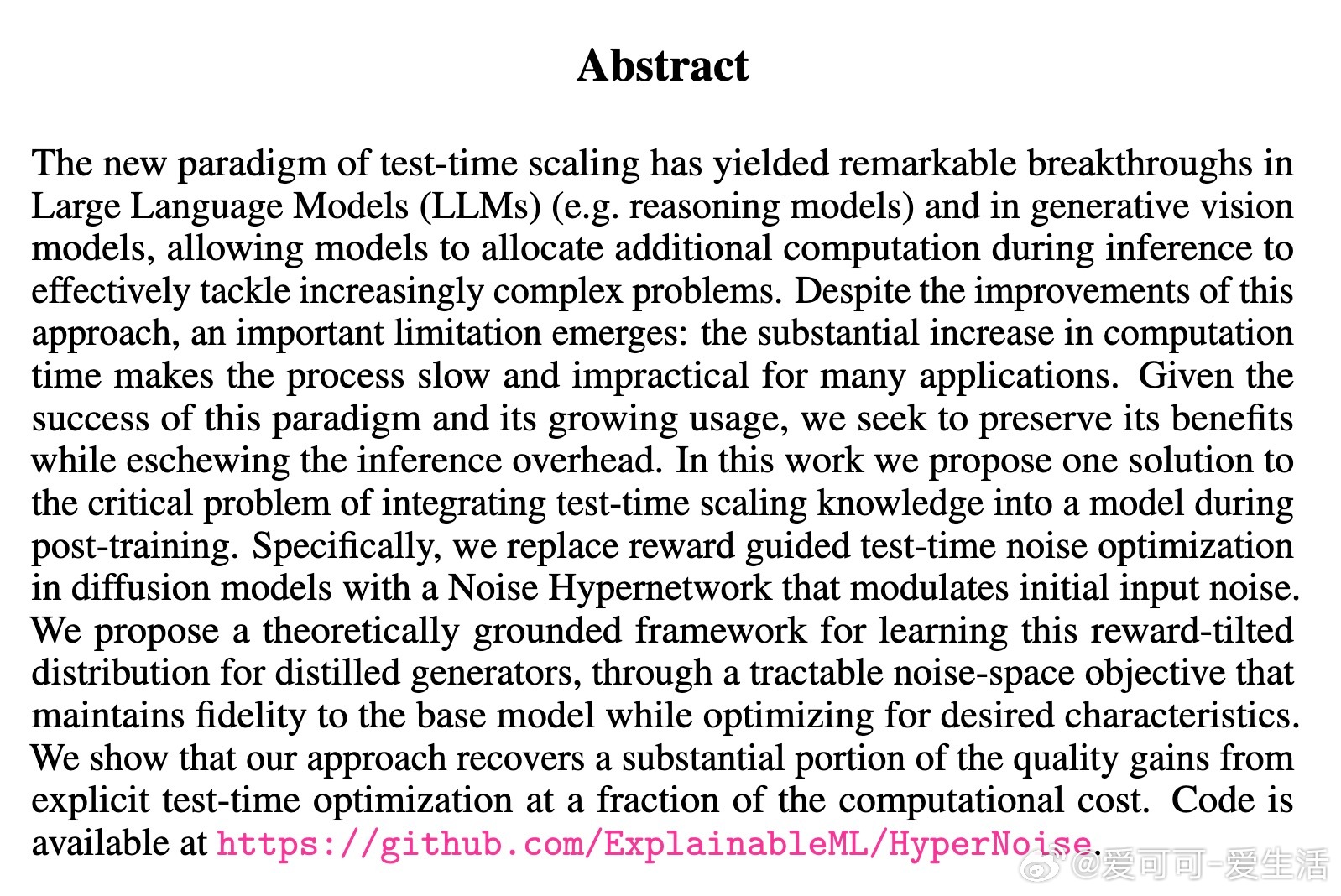

[LG]《Noise Hypernetworks: Amortizing Test-Time Compute in Diffusion Models》L Eyring, S Karthik, A Dosovitskiy, N Ruiz, Z Akata [Technical University of Munich & Inceptive] (2025)

Noise Hypernetworks:解锁扩散模型推理效率与质量的平衡新路径

• 传统测试时放大策略虽提升大语言模型和生成视觉模型表现,但推理计算成本高昂,限制实用性。

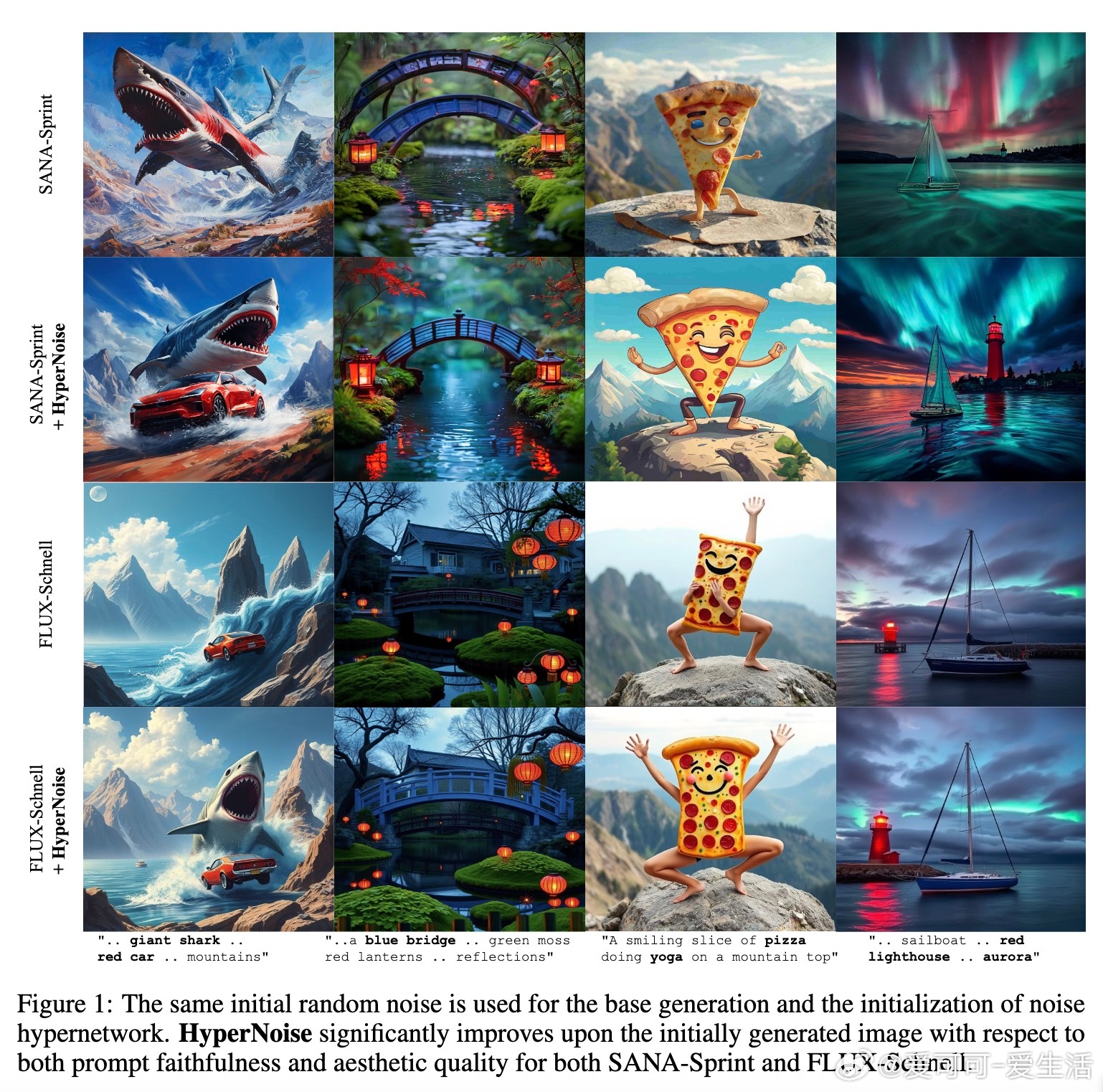

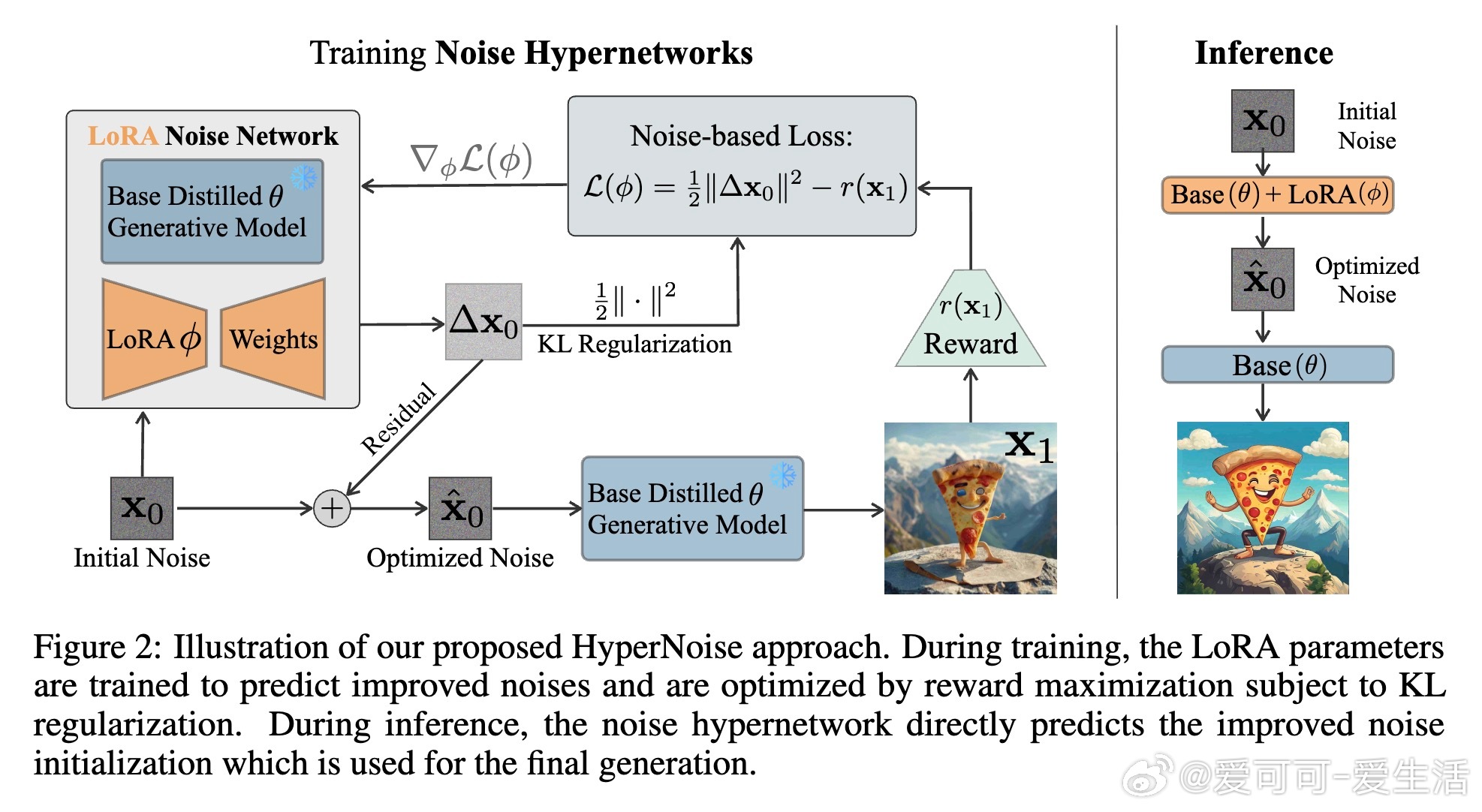

• 本文提出Noise Hypernetworks(简称HyperNoise),通过学习优化初始噪声分布,内嵌测试时优化策略,消除逐样本推理期的高昂计算负担。

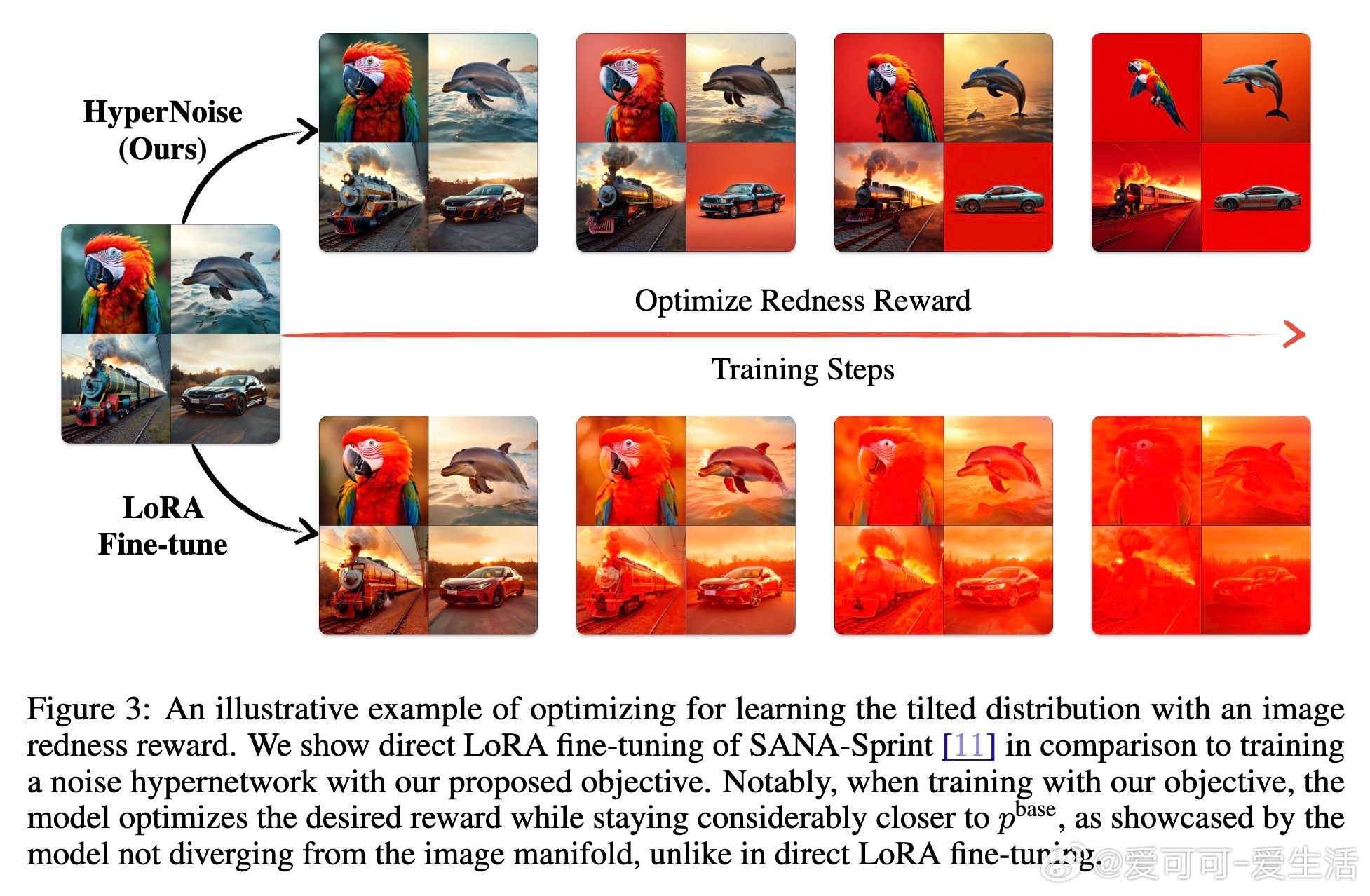

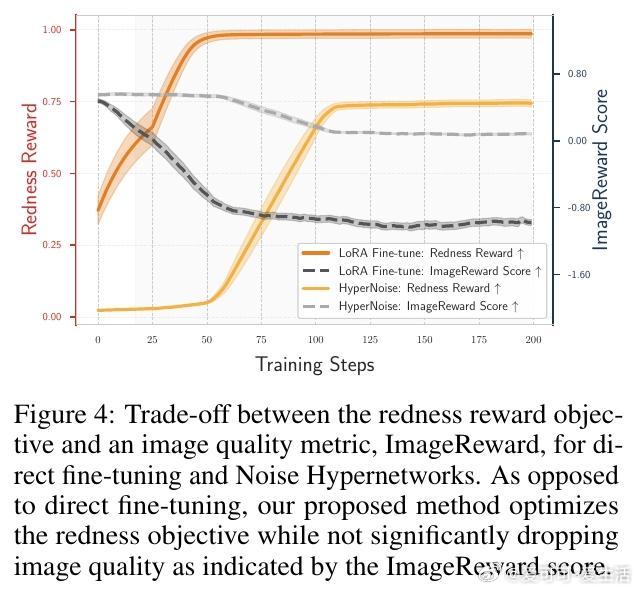

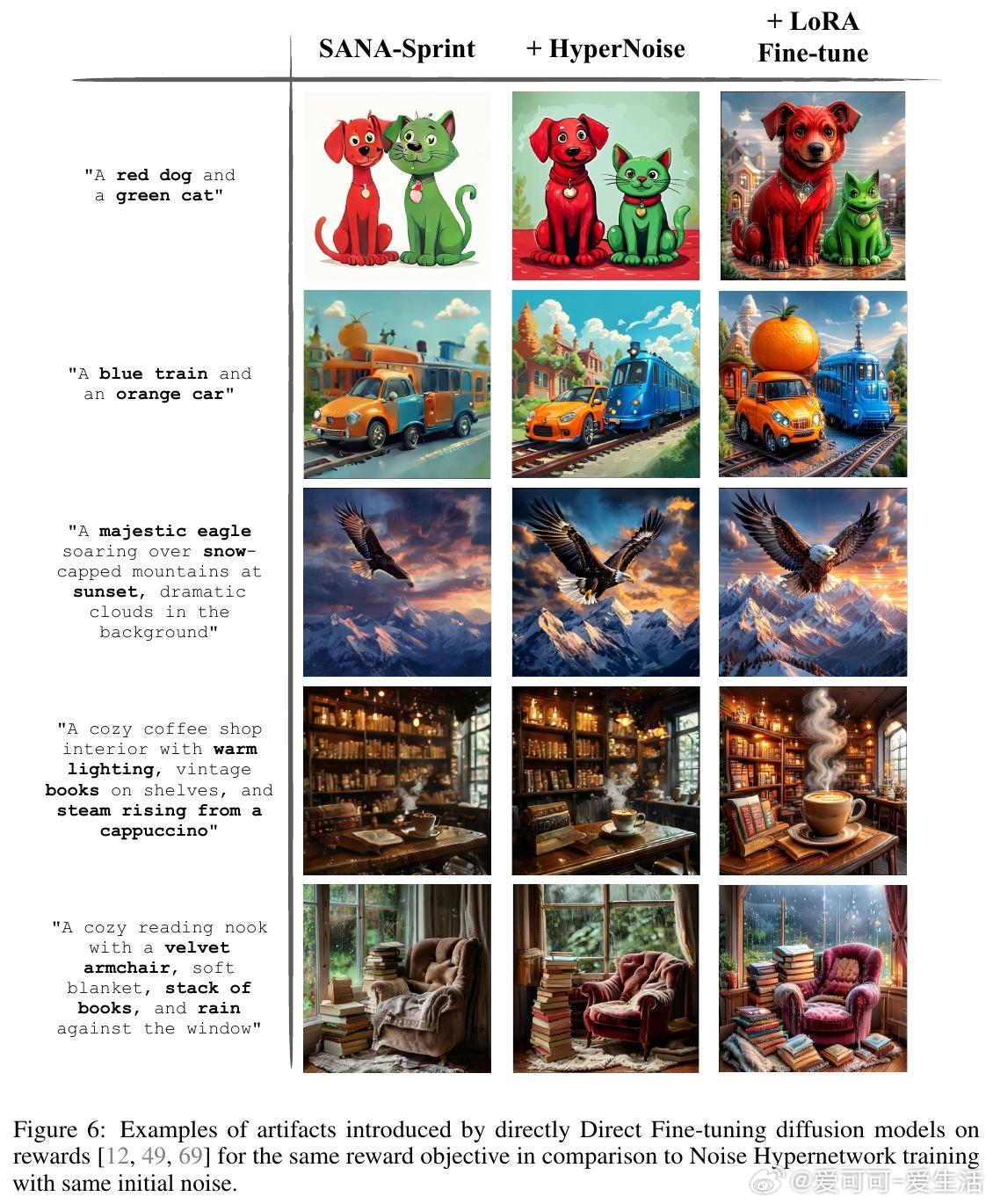

• 理论上,HyperNoise拟合奖励倾斜的噪声分布,使固定的蒸馏生成器直接输出高质量且符合目标奖励的图像,避免直接微调生成器参数的不可控偏差与“奖励劫持”。

• 采用LoRA轻量化架构实现,训练时仅微调噪声调制网络,显著减少内存与计算开销,推理阶段仅需一次噪声调制与生成器前向传播。

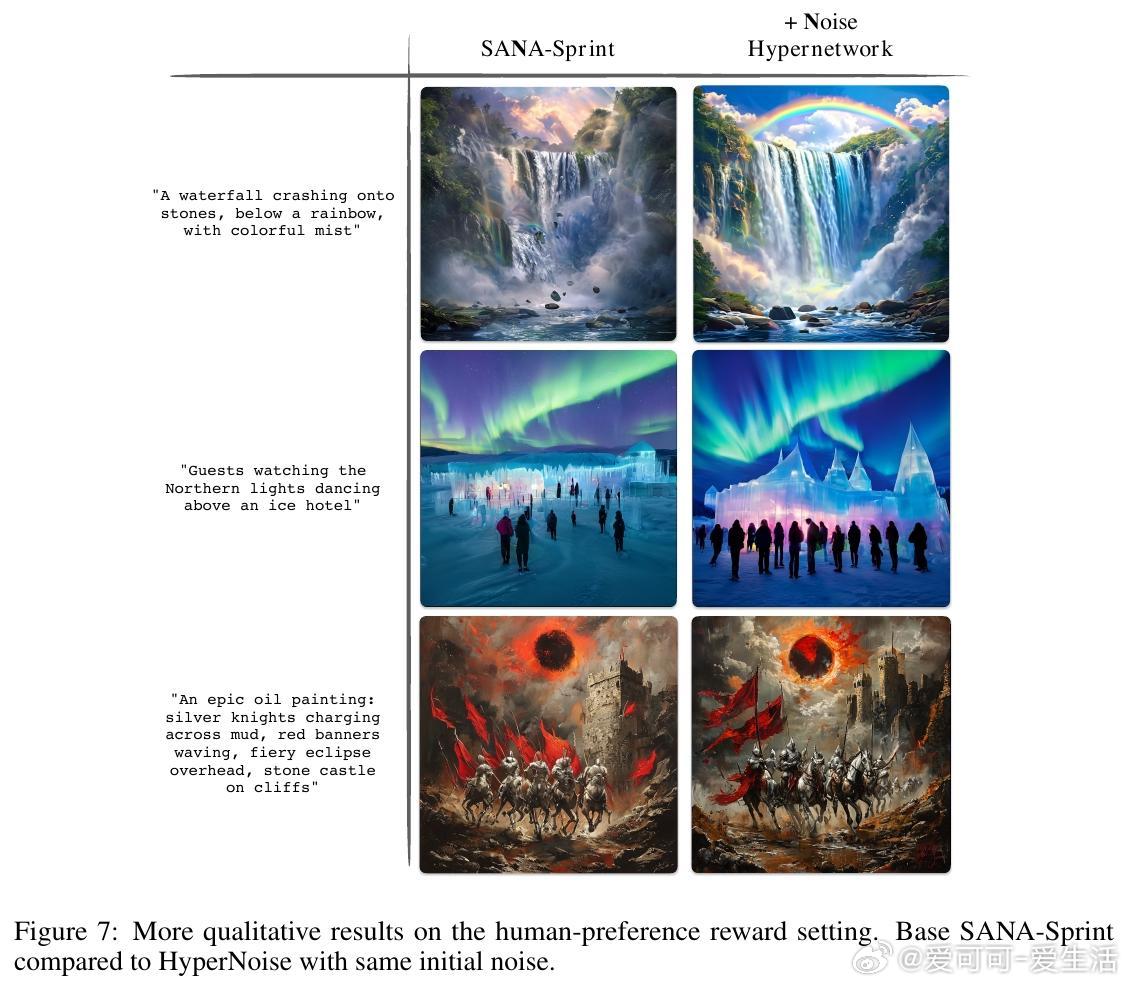

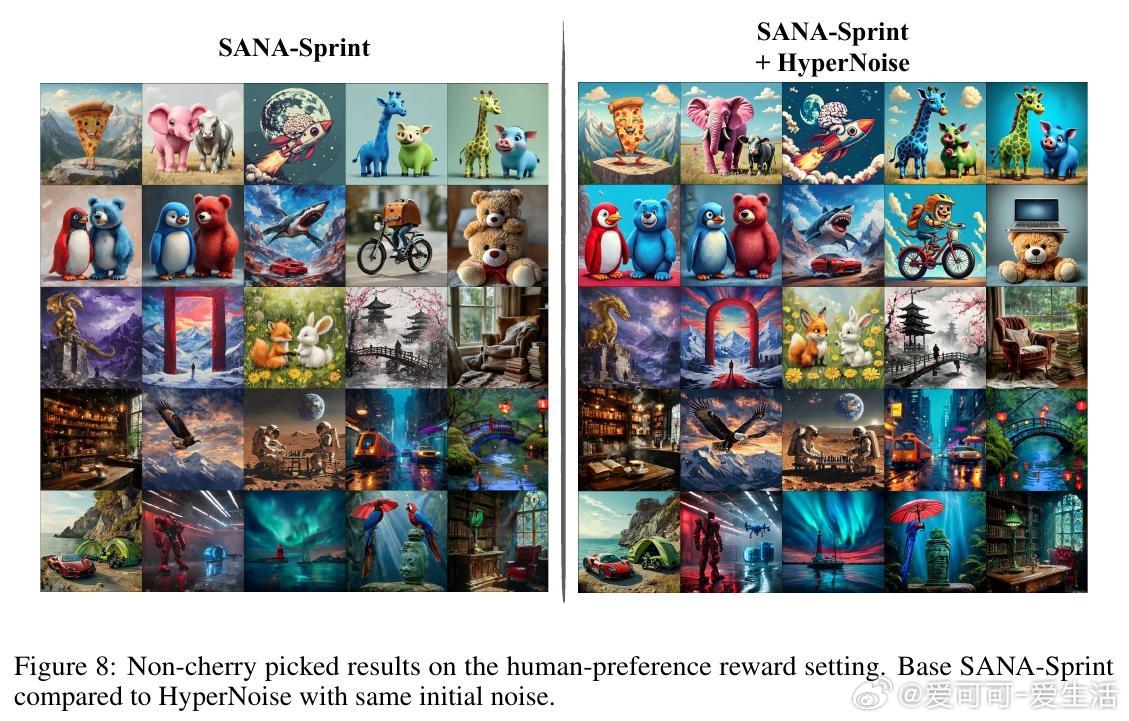

• 在文本到图像任务上,针对红度奖励和人类偏好奖励均实现显著性能提升,效果超越直接微调及多步测试时优化,且推理速度快数十倍。

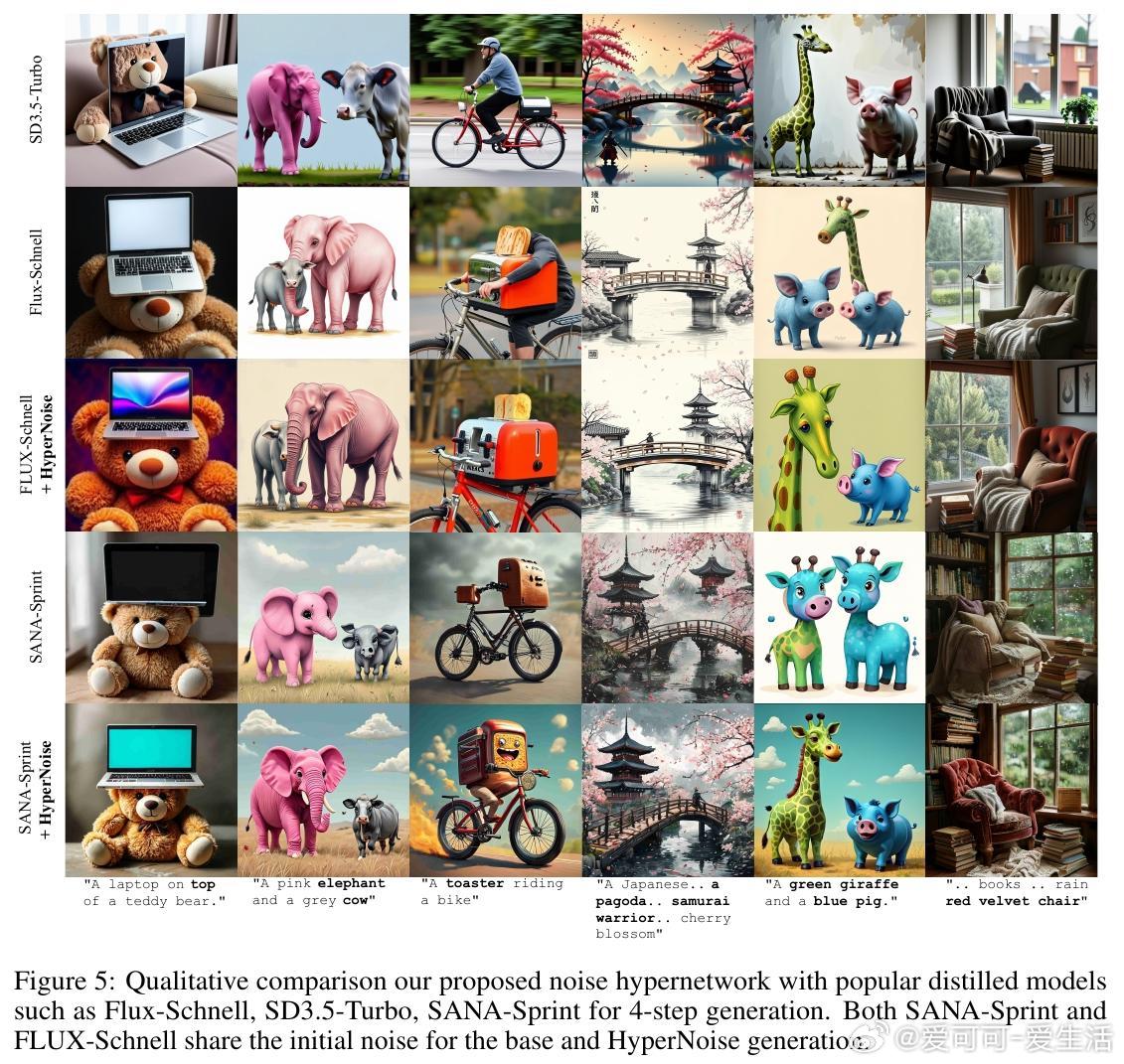

• 多模型、多步数验证显示HyperNoise训练的噪声调制网络具备良好泛化能力,提升图像质量与提示遵循性,同时保持生成多样性。

• 方法理论基础扎实,利用噪声空间KL散度近似简化目标函数,结合数据处理不等式保证输出分布与基础模型保持适度接近。

• 该技术为扩散模型后训练微调、快速高质量生成提供实用方案,适合实时及大规模应用场景,推动生成模型在效率与定制化上的平衡发展。

详细阅读👉 arxiv.org/abs/2508.09968

扩散模型生成模型机器学习图像生成模型微调人工智能