近日,Create2025百度AI开发者大会在武汉举办。百度发布了文心大模型4.5Turbo及深度思考模型X1Turbo两大模型。文心4.5Turbo源自文心4.5,具有效果更佳、成本更低的优势;基于文心4.5Turbo,文心X1升级到X1Turbo,性能提升的同时,具备更先进的思维链,问答、创作、逻辑推理、工具调用和多模态能力进一步增强。

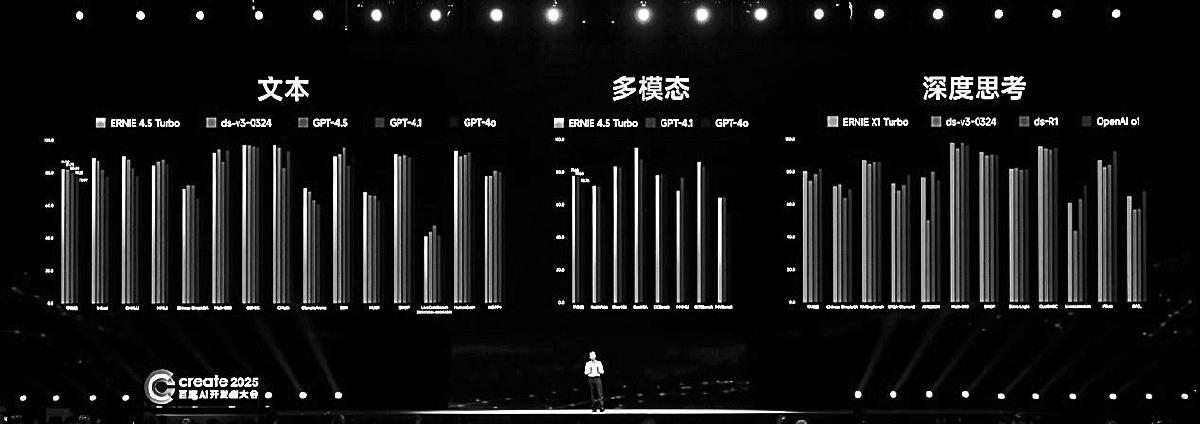

据百度首席技术官王海峰介绍,在C-Eval、CMMLU、MathVista、Math500等多个基准测试集中,文心4.5Turbo和X1Turbo与DeepSeek、GPT模型相比,效果在伯仲之间。

作为多模态大模型,文心4.5Turbo实现了文本、图像和视频的混合训练。针对不同模态数据在结构、规模、知识密度上的差异,通过多模态异构专家建模、自适应分辨率视觉编码、时空重排列的三维旋转位置编码、自适应模态感知损失计算等技术,大幅提升跨模态学习效率和多模态融合效果,学习效率提高近2倍,多模态理解效果提升超过30%。

在后训练方面,百度研制了自反馈增强的技术框架,基于大模型自身的生成和评估反馈能力,实现了“训练—生成—反馈—增强”的模型迭代闭环,不仅解决了大模型对齐过程中数据生产难度大、成本高、速度慢等问题,还显著减少了模型幻觉,模型理解和处理复杂任务的能力大幅提升。

在训练阶段,研制了融合偏好学习的强化学习技术,通过多元统一奖励机制,提升了对结果质量判别的准确率,通过离线偏好学习和在线强化学习统一优化,进一步提升了数据利用效率和训练稳定性,并增强了模型对高质量结果的感知。得益于偏好信号与奖励信号的融合运用,模型的理解、生成、逻辑和记忆等能力全面提升。

在深度思考方面,突破了仅基于思维链优化的范式,在思考路径中结合工具调用,构建了融合思考和行动的复合思维链,模型解决问题能力得到显著提升。同时,结合多元统一的奖励机制,实现了思考和行动链的端到端优化,大幅提升了跨领域的问题解决能力。

在数据方面,打造了“数据挖掘与合成—数据分析与评估—模型能力反馈”的数据建设闭环,为模型训练源源不断地生产知识密度高、类型多样、领域覆盖广的大规模数据。同时,数据建设流程具备良好的可扩展性,能够轻松迁移到全新的数据类型,实现快速、高效的数据生产。

文心大模型的能力拓展和效率提升,得益于飞桨文心的联合优化。比如,训练方面,多模态统一的掩码注意力加速,在不同模态混合计算注意力时,显著降低掩码构建和计算开销,大幅提升训练性能;推理方面,多模态流式分块预填充机制,减少首token耗时,同时减小推理计算的显存峰值,提升推理批次大小,提升吞吐性能。通过这些联合优化技术,文心4.5Turbo训练吞吐达到文心4.5的5.4倍,推理吞吐达到8倍。

记者从现场了解到,飞桨框架3.0既延续了动静统一、训推一体的技术特色,又在自动并行、神经网络编译器、高阶自动微分等方面创新突破。例如,动静统一自动并行,使得大模型分布式训练代码减少80%;大模型训推一体,帮助强化学习训练提速114%;科学计算高阶微分,微分方程求解速度比PyTorch快115%;神经网络编译器,提升框架通用性能,模型端到端训练速度提升27%;在异构多芯适配方面,飞桨已适配国内外60多个系列芯片。