Casper Hansen 根据已有的消息解释了下 DeepSeek R1 的训练过程。“我的大脑难以相信,如此强大的模型(的训练过程)竟然可以如此简洁明了。”

简单的讲就是 基础模型 → 强化学习 → 微调 → 强化学习 → 微调 → 强化学习

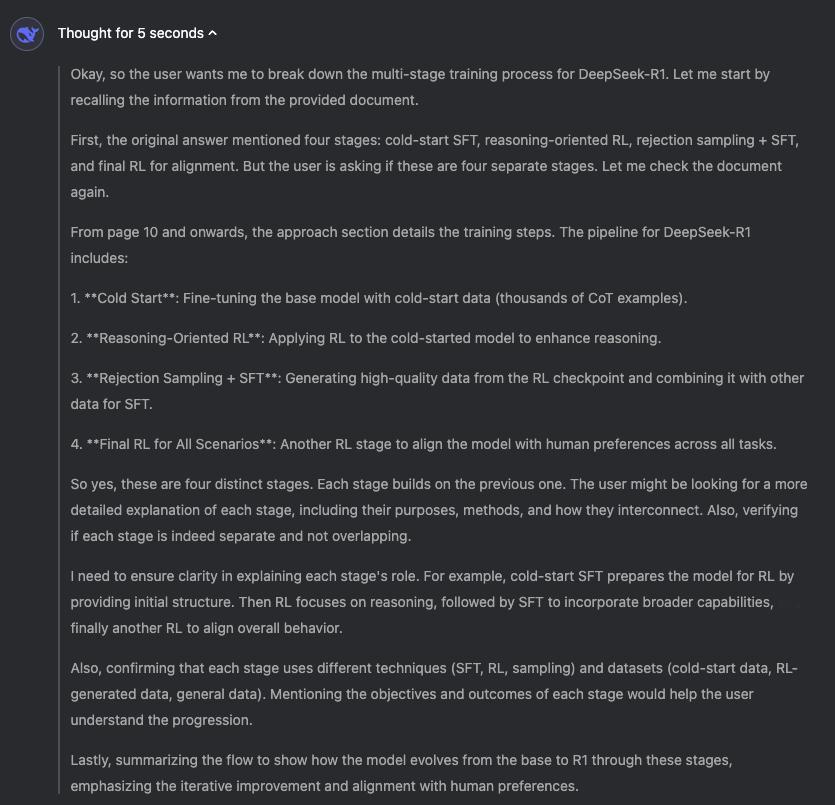

具体阶段解析:

V3 Base → R1 Zero (Stage 0/4):基础模型到初始模型

⚙️GRPO:“没有价值函数,使用蒙特卡洛估计优势的 PPO”

🔍 数据策略:通过基于规则的奖励(IFEval/Tülu 3)验证提示 + 测试用例(数学/代码)。

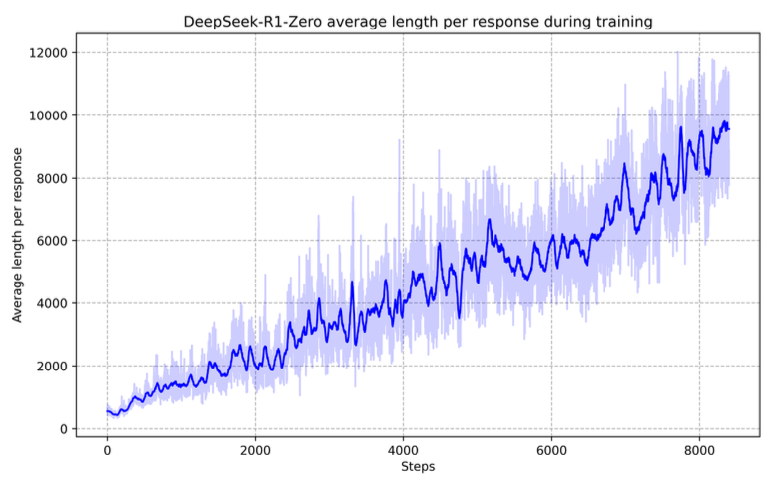

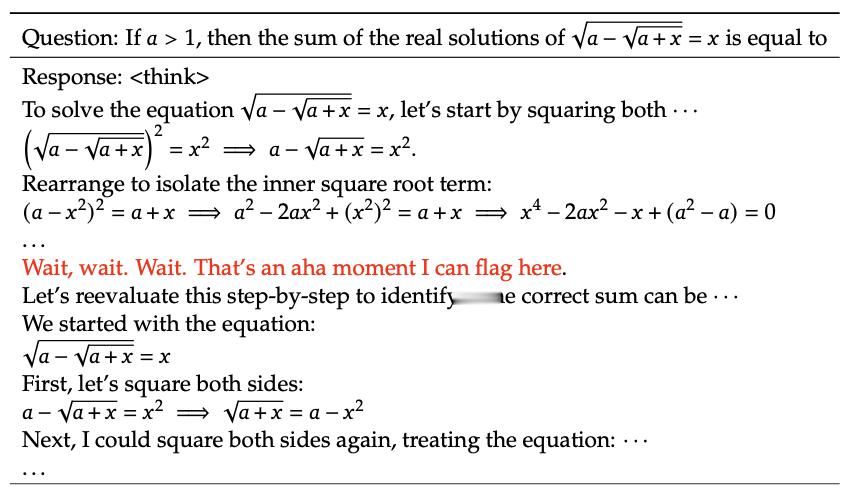

💡涌现能力:推理/反思 + 长思维链。

R1 Zero → R1 Finetuned Cold Start (Stage 1/4):初始模型到冷启动微调模型

🚀生成 1-10k 长思维链样本:使用 R1 Zero 和少样本提示

⚙️使用阶段 0 的模型进行监督微调

💡结果:可读的思考过程 + 结构化输出。

R1 Cold Start → R1 Reasoner with RL (Stage 2/4):冷启动微调模型到强化学习推理模型

🚀使用 GRPO 训练阶段 1 模型:使用阶段 0 的数据并添加语言一致性规则(思维链中目标语言的百分比)。

💡涌现能力:具有反思能力的可读推理 + 长思维链。

R1 Reasoning → R1 Finetuned-Reasoner (Stage 3/4):推理模型到微调推理模型

🚀生成 60 万个样本:多响应采样,只保留正确的样本(使用之前的规则)

⚙️V3 作为评判者:过滤掉混合语言、长段落和代码

🌐通过 V3 生成 20 万个通用样本

🔥微调模型

R1 Instruct-Reasoner → R1 Aligned (Stage 4/4):指令推理模型到对齐模型

⚖️对齐 DeepSeek-R1:使用 GRPO 平衡推理能力、有用性和无害性

🔍 数据策略:针对数学/代码的基于规则的奖励 + 针对人类偏好的奖励模型。

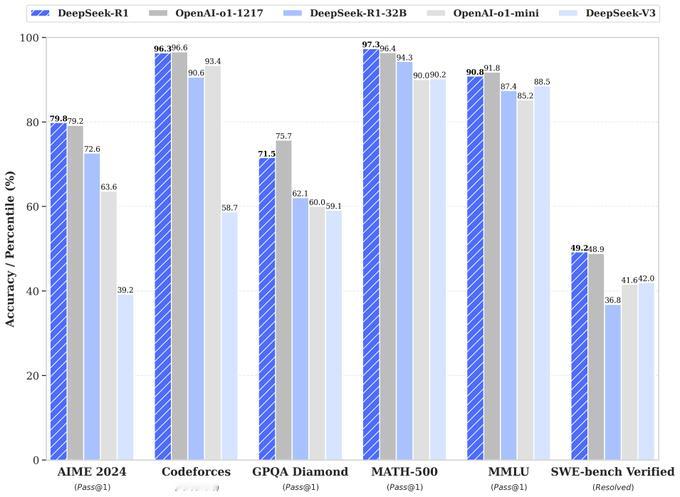

🌟结果:DeepSeek R1

🌟结果: 最终得到DeepSeek R1模型。