Sky-T1:用450美元训练出一个自己的 O1模型 [哆啦A梦吃惊]

novasky-ai.github.io/posts/sky-t1/

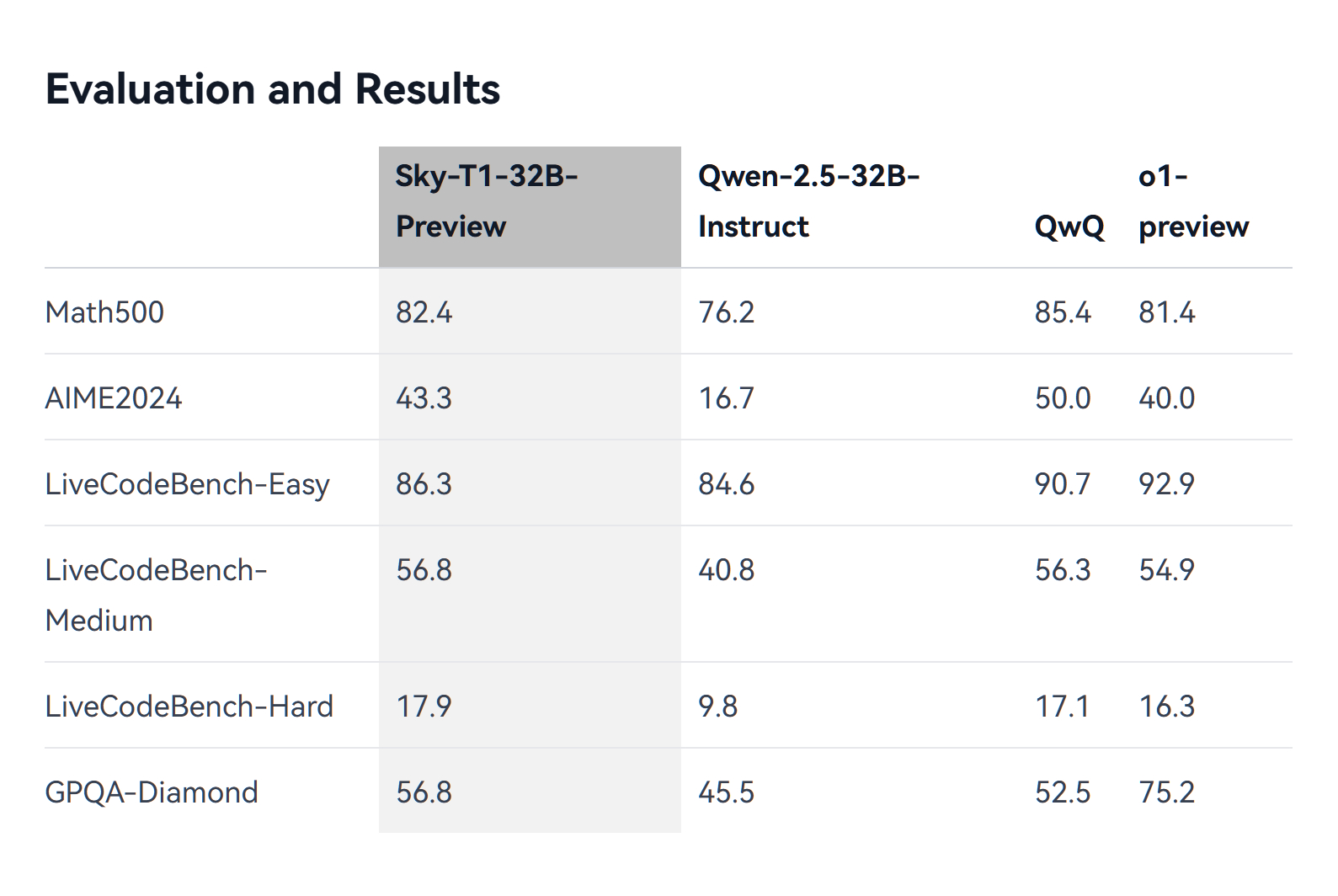

Sky-T1-32B-Preview模型,这是一个由加州大学伯克利分校的NovaSky团队在qwen模型基础上训练并开源的推理模型。能力和o1-preview模型相仿。而且团队公布了整个过程和训练数据。

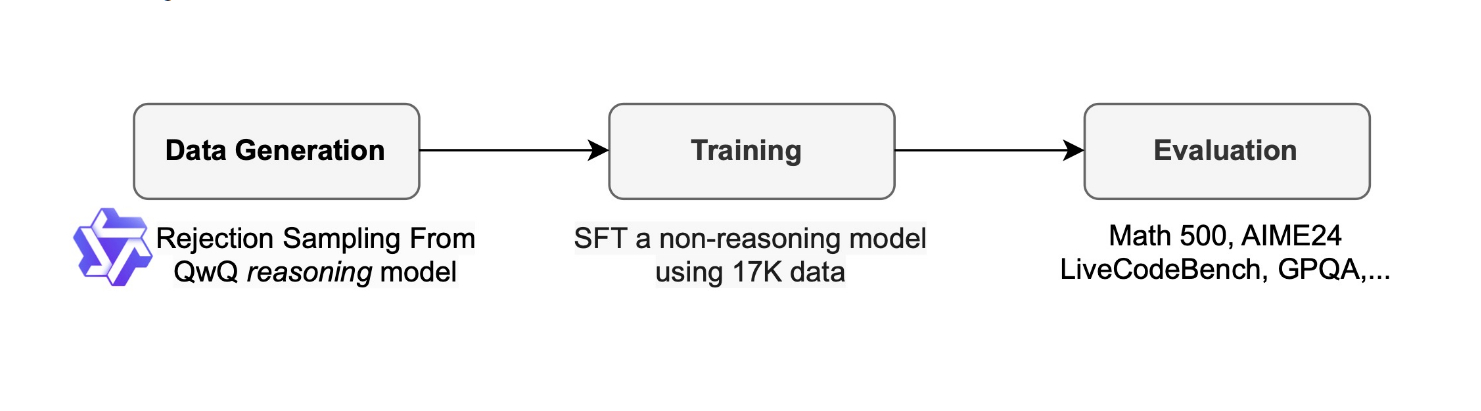

大概思路似乎是这样:首先利用 QwQ-32B 模型生成涵盖数学和编程等领域的推理数据,然后通过拒绝采样(根据正确答案过滤错误样本)和使用 GPT-4o-mini 进行格式重写来提升数据质量,最终形成一个包含约 17,000 个高质量样本的训练集。训练阶段则采用 Qwen2.5-32B-Instruct 作为初始模型,在 8 个 H100 GPU 上利用 DeepSpeed ZeRO-3 内存优化技术进行微调,仅用 3 个 epoch、1e-5 的学习率和 96 的批处理大小,在约 19 小时内以低于 450 美元的成本完成了训练,最终得到性能卓越的 Sky-T1-32B-Preview 模型。