huggingface的技术负责人介绍了下DeepSeek提出的GRPO技术。一种用于强化学习(特别是 RLHF)的优化方法,被 DeepSeek 和 Qwen 等优秀的开源模型采用。

“最优秀的开源模型背后的 RLHF 方法!

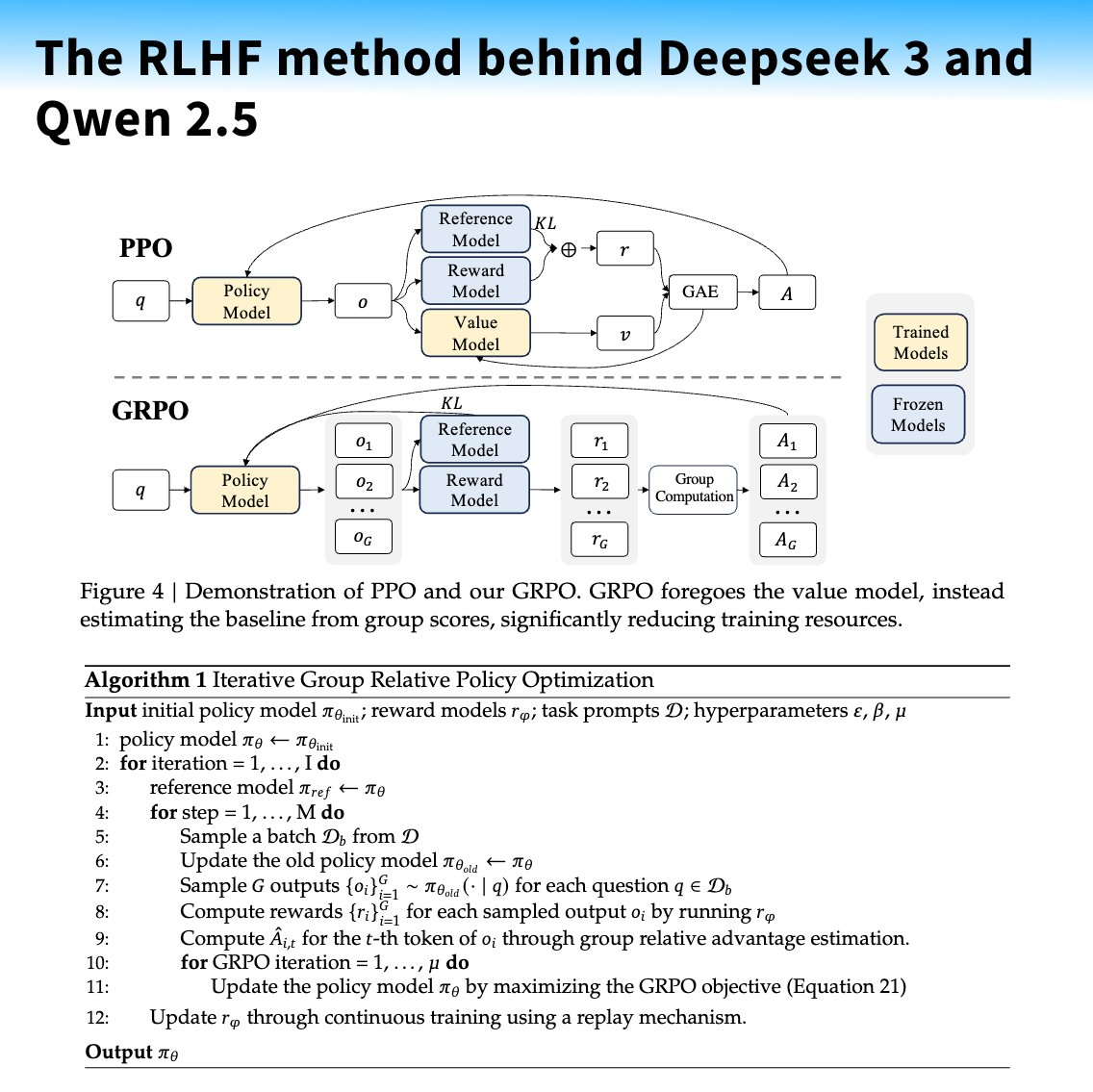

deepseek(深度求索) 和 Qwen(阿里巴巴通义千问)都在后期训练中使用了 GRPO!即组相对策略优化(Group Relative Policy Optimization)。GRPO 最初在去年的 DeepSeekMath 论文中被提出,用于在更少内存消耗的情况下提高数学推理能力,但现在也以在线方式用于提高模型的真实性、有益性和简洁性... 👀

实施步骤:

1️⃣ 使用当前策略为每个输入问题生成多个输出。

2️⃣ 使用奖励模型对这些输出进行评分。

3️⃣ 对奖励进行平均,并将其作为基准来计算优势。

4️⃣ 更新策略以最大化 GRPO 目标,该目标包括优势和一个 KL 散度项。

要点:

💡 不需要价值函数模型,从而减少了内存占用和复杂性。

🔗 直接将 KL 散度项添加到损失函数中,而不是添加到奖励中。

🧬 适用于基于规则的奖励模型和生成式/基于评分的奖励模型。

👉 看起来类似于 RLOO 方法。

👀 DS 3 改进了编码、数学、写作、角色扮演和问答能力。

🤗 即将加入 的 TRL(Pull Request 已提交)。”