针对Ilya 提出的“预训练将会终结” 观点,qwen的Binyuan Hui觉得现在还早 AI创造营

-------------------------------------------------------------

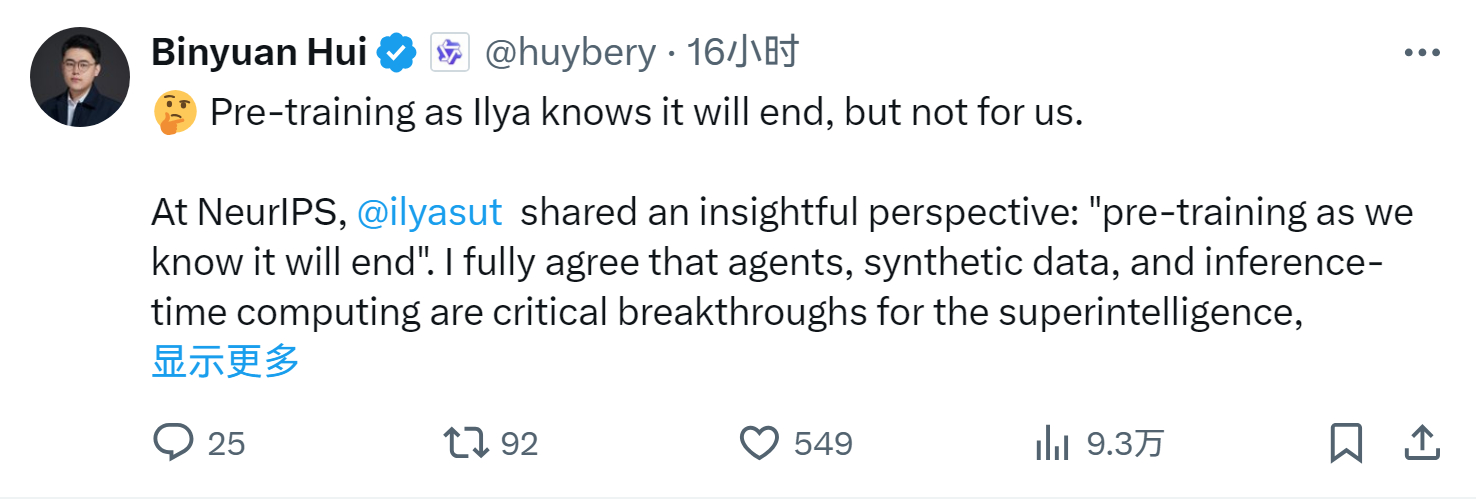

🤔 Ilya 所说的预训练终结或许即将到来,但对我们而言尚未结束。

在 NeurIPS 大会上,

Ilya Sutskever 提出了一个深刻的观点:“预训练将会终结”。

我完全认同,智能体、合成数据和推理时代的计算是实现超级智能的关键突破。但我认为,开放 LLM 社区在预训练方面仍需坚持一段时间。

⭐实现“覆盖整个互联网”仍然是一个挑战

例如,Qwen2.5 使用了 18 万亿个 token 进行预训练,但这个数据集依然难以涵盖所有知识领域,特别是小众领域和长尾内容。同时,对于不断变化的信息,这样的规模也显得不足。展望未来,Qwen3 的预训练需要显著增加 token 数量以实现实质性的提升。此外,数据清洗依然是关键瓶颈。目前,社区尚未掌握数据清洗的最佳实践,也未能以成本可控的方式获取高质量数据集。因此,开发可扩展的数据工程解决方案依然是当务之急。

⭐扩展模型规模带来了训练挑战

例如,Llama 405B 的性能低于预期,这表明只有少数组织真正掌握了超大规模模型的训练技术。此外,这些技术距离完全公开仍有很长的路要走。要让更多人能够参与这一领域,我们需要创新的训练方法和更强健的模型设计,以降低扩展模型规模带来的风险。或者,我们需要确定最优的模型规模,以实现目标性能。

⭐一个不容忽视的事实是,合成数据和后训练的效果从根本上受制于预训练(基础)模型的质量

我推测,o1 的成功正是预训练与后训练阶段共同努力的结果。在开放社区能够开发出与 OpenAI 相媲美的预训练模型之前,我们无法停止对预训练的投入。

总的来说,我们无法获取 Ilya 提到的最先进预训练模型的关键细节(如 token 数量、参数规模以及实际性能),这使得判断预训练是否真的达到了极限变得困难。开放社区依赖高质量的预训练模型推动下游研究。如果预训练停止,后训练的发展可能会面临瓶颈。