引言

在统计学与机器学习的辽阔天地中,线性回归犹如一颗璀璨的明珠,它以简洁而强大的建模力量,构筑起自变量与因变量之间的桥梁。而多元线性回归,作为线性回归的华丽变奏,它拓展了视野,允许多个自变量共同舞蹈,共同影响因变量的节奏。在Python的天地里,有了NumPy、pandas和scikit-learn这些得力助手,多元线性回归的实现变得游刃有余。本文旨在深入探讨Python中多元线性回归的艺术,结合实例编程,引领读者全方位掌握其原理与操作。

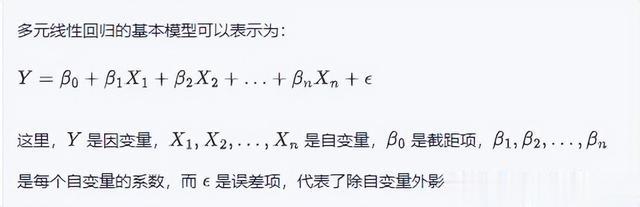

多元线性回归概述

实现多元线性回归之路

数据准备在踏上多元线性回归之旅前,数据的收集与整理是首要任务。所需数据应包含众多个自变量及一个因变量,通常以二维表格形式呈现,行代表样本,列代表特征。

数据集分割为公正评价模型的性能,需将数据集一分为二,划分为训练集与测试集。训练集用以模型的锻造,而测试集则用于检验模型的预测能力。常见做法是,训练集占据八成,余下两成留给测试集。

模型训练借助训练集的滋养,scikit-learn库中的LinearRegression类将自动拟合模型,探寻那组最优的系数。

模型评估训练完毕后,模型需在测试集上接受考验。均方误差(MSE)是衡量模型预测准确性的重要指标,误差越小,模型性能越优良。

模型应用经过严格训练与评估,模型终将展翅高飞,应用于新数据的预测。只需输入自变量,模型便能预测出因变量的值,为现实世界的问题提供解答。

实际编程演练 接下来,让我们以房屋价格预测为例,一探在Python中实现多元线性回归的奥妙。

import numpy as npimport pandas as pdfrom sklearn.model_selection import train_test_splitfrom sklearn.linear_model import LinearRegressionfrom sklearn.metrics import mean_squared_error# 数据准备data = { 'Area': [1200, 1500, 1800, 2000, 1000], 'Bedrooms': [2, 3, 3, 4, 2], 'Distance_to_center': [5, 4, 3, 2, 6], 'Price': [300000, 400000, 500000, 550000, 250000]}df = pd.DataFrame(data)# 自变量与因变量分离X = df.drop('Price', axis=1)y = df['Price']# 数据集分割X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# 模型训练model = LinearRegression()model.fit(X_train, y_train)# 模型评估y_pred = model.predict(X_test)mse = mean_squared_error(y_test, y_pred)print("均方误差:", mse)# 模型应用new_data = { 'Area': [1600], 'Bedrooms': [3], 'Distance_to_center': [4]}new_df = pd.DataFrame(new_data)predicted_price = model.predict(new_df)print("预测价格:", predicted_price)结论

多元线性回归,这一强大的统计分析工具,不仅搭建起多自变量与因变量之间的线性桥梁,更通过Python中的各类库,让我们能够轻松地进行分析与预测。在实际应用中,我们应注重数据的预处理、模型的训练与验证,确保所得模型的准确性与可靠性。愿本文能成为您在Python世界中探索多元线性回归的指南,助您理解和运用这一技术。