今年中旬各家品牌的新笔记本感觉上都是很不错,搞得小白自己心痒痒,突然间想要真的买一台Windows笔记本来耍耍了。

但今天这个文章并不是什么商品宣传啥的,而是小白稍微尝试了一下新笔记本之后的一些发现。

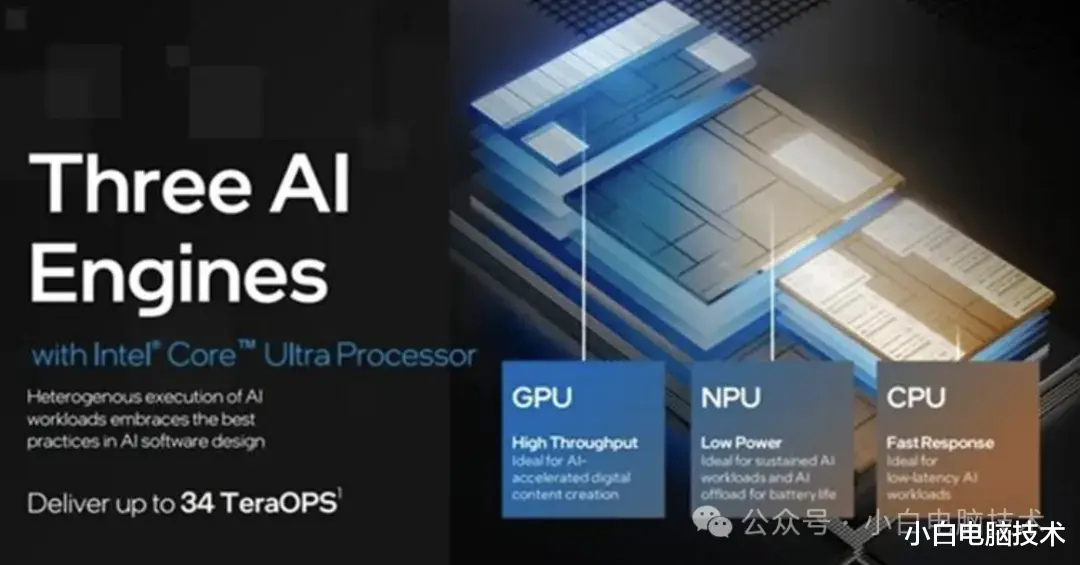

在今年的新笔记本上都多了一个硬件,那就是NPU。这个NPU是继CPU和GPU之后的第三个PU。

什么是CPU?

相比对于CPU,可以说是没有一个小伙伴不知道的。CPU(全称:Central Processing Unit,中文名:中央处理器),可以说是整台电脑的核心元件,类似于人的大脑。

什么是GPU?

这个大部分小伙伴也都知道,它其实就是咱们经常说的:显卡。GPU(全称:Graphics Processing Unit,中文名称:图形处理单元),这个元件也是必不可少的,如果没有它的存在,那么电脑将不会有任何内容和画面输出。

那什么是NPU?

NPU(神经处理单元,Neural Processing Unit)是一种专门用于加速神经网络计算的处理器。复杂的理论咱们这里不进行讲解,简单来说就是NPU是用来加速处理AI任务的。

还记得2022年到2023年的人工智能突然爆火,小伙伴们多多少少都接触过各种AI智能助手,比如:文心一言、讯飞星火、抖音豆包、ChatG**等等,当然也还有其他厂商推出的AI工具,比如微软的Copilot。

其实上面提到的AI智能助手,你在使用的过程中发出的指令并不是在你自己本地电脑上执行的,而是远在世界的某个角落的某台服务器上部署的设备执行你所发出的命令或者问题,生成结果之后再返回到你使用的设备上。

那我们自己所使用的电脑能不能运行AI智能模型呢?这个其实得看配置,如果配置足够,那完全可以把模型放到本地来运行。但如果不行,则……

哎呀,突然间觉得聊偏了偏了!

人工智能的出现,导致有些东西就会出现一些隐私问题,咱们这里不做深入讨论。

所以,如果有这么一台设备,能够在本地执行一些比较简单的AI智能任务,那隐私保护也会得到大大提升。(实际的隐私问题真的解决了吗?这谁知道呢?)

NPU在人工智能上的应用显著提升了计算效率和降低了能耗。

高效能的硬件架构:NPU采用了优化的硬件架构,如向量处理单元、矩阵乘法单元、卷积单元和激活函数单元等,能够在硬件级别上执行大规模矩阵运算和卷积运算。这种设计使得NPU在处理神经网络任务时,比传统的CPU和GPU更加高效。数据驱动的并行计算:NPU采用“数据驱动并行计算”的架构,在电路层模拟人类神经元和突触,特别擅长处理视频、图像类的海量多媒体数据。这种并行计算能力使得NPU在执行深度学习任务时,能够显著提高运行效率。存储计算一体化:NPU通过突触权重实现存储计算一体化,提高了运行效率。这种设计使得NPU在处理推理工作负载时具有显著的能耗节约优势。因为NPU的硬件架构优化和数据驱动的并行计算,所以它的能耗降低是显著的。在未来的人工智能发展上,NPU有着巨大的潜力,在90%的领域都会发挥很重要的作用。

比如未来的你可以直接在本地计算机上运行AI大模型,一个专属于你自己的AI模型,一个有着你的风格色彩的AI模型。你在使用它生产出来的内容能更加贴合你的需求。未来的你再也不用为了PPT而烦恼,未来的你再也不会因为数据分析而烦恼,未来的你再也不会因为写报告而烦恼。AI智能时代,你无论如何都要学会如何使用这项技能。

--End--