AI大模型基石:一文读懂NPU

““NPU” 代表什么?它能做什么?它是如何工作的?你需要一个吗?以下是你应该了解的有关这项技术的信息。”

AI大模型基石:一文读懂NPU

近一年来,神经处理单元(NPU)成为了热议的话题。尽管NPU已在智能手机领域存在数年,但如今,包括英特尔、AMD,以及近期加入的微软,均推出了搭载NPU以支持AI功能的消费级笔记本。

NPU与AI PC的概念紧密相连,众多主要硬件制造商如AMD、Apple、Intel及Qualcomm等,在其生产的芯片中愈发频繁地融入了NPU技术。特别是自微软于今年初推出了Copilot+ AI PC产品后,NPU在笔记本电脑领域的身影愈发显著。

1、NPU 起什么作用?NPU扮演着人工智能领域硬件加速器的关键角色。硬件加速的概念,简而言之,就是通过专门的硅芯片来高效执行特定任务,这好比是一位大厨将不同的烹饪步骤分配给助手,从而协同高效地完成一顿大餐的准备。NPU并非意在取代CPU或GPU,而是作为它们的补充,专注于处理如边缘AI等特定工作负载,让CPU和GPU得以专注于它们更为擅长的任务。

GPU作为一种硬件加速器,其设计初衷是专注于图形的渲染,但凭借其底层的灵活性,它同样在AI处理或某些科学计算领域表现出色。在过去,处理AI工作负载通常会依赖于一个或多个高性能的GPU(例如Nvidia的产品)来进行高强度的数字运算。目前,一些企业正致力于研发专为AI设计的硬件加速器,如Google的TPU,因为在专注于AI处理的硬件中,GPU所具备的图形处理功能变得多余无用。

2、工作负载决定一切硬件加速在处理那些不涉及复杂条件分支且需重复执行的任务时尤为高效,特别是在处理庞大数据集时。以3D图形渲染为例,计算机需持续管理大量的粒子与多边形数据流,这是一项对带宽要求极高且主要涉及三角函数计算的任务。计算机图形学、物理模拟、天文学计算以及大型语言模型(LLM),例如支撑现代AI聊天机器人的模型,均是硬件加速技术的理想应用场景。

AI工作负载可被划分为训练与推理两大类别。训练过程几乎完全依赖于GPU。凭借对CUDA技术的近二十年投入以及在独立显卡市场的领先地位,Nvidia在这两大领域均占据主导地位,而AMD则显著落后。大规模训练通常在数据中心级别进行,而当我们与如ChatGPT这样的云端服务交互时,运行的推理工作负载也同样在数据中心级别执行。

相比之下,NPU(及其相关的AI PC)的应用规模较小。它们能够作为CPU供应商所提供的集成GPU的补充,为未来的AI工作负载带来额外的灵活性,并相较于等待云端计算,显著提升性能。

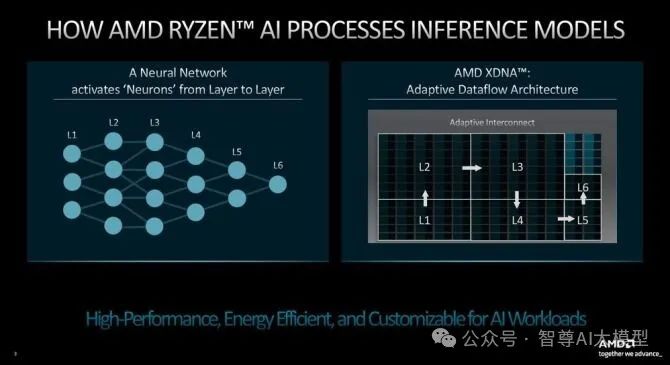

3、NPU 如何工作?通常而言,NPU凭借其高度并行的架构设计,能够迅速执行重复性任务。与此相反,CPU则被视为一个全能选手,功能多样。这种差异在NPU的逻辑设计与物理构造中均有体现。CPU配备有一或多个内核,能够访问少量的共享内存缓存;而NPU则包含多个子单元,且每个子单元均配备有独立的微型缓存。NPU在处理高吞吐量及高度并行的工作负载方面展现出显著优势,例如神经网络与机器学习任务。

NPU、神经网络以及神经形态系统(例如英特尔的Loihi平台)均共享一个核心设计理念:模拟大脑在信息处理方面的某些特定功能。

AI大模型基石:一文读懂NPU

来源:AMD

各个将NPU引入市场的设备制造商,均基于其产品的独特性设计了相应的微架构。此外,大多数制造商还推出了与各自NPU相配套的软件开发工具。举例来说,AMD推出了Ryzen AI软件套件,而英特尔则在不断优化其开源的深度学习工具包OpenVINO,以更好地支持其NPU的发展。

4、NPU 和边缘智能当前,多数NPU被部署在面向消费者的电子设备中,例如笔记本电脑和个人电脑。高通公司在其骁龙处理器中融入了Hexagon DSP,这一技术为智能手机、平板电脑、可穿戴设备、高级驾驶辅助系统以及物联网设备提供了NPU加速能力。苹果则在其iPhone、iPad和iMac的A系列与M系列芯片中内置了神经引擎NPU。

此外,部分PC和笔记本电脑被特别标记为Copilot+,这意味着它们能够在内置的NPU上运行微软的Copilot AI。然而,NPU的应用并不仅限于客户端设备,一些服务器端或基于云的系统同样采用了NPU。谷歌的Tensor Processing Units就是专为数据中心设计的高性能机器学习NPU加速器。

NPU之所以能够崛起,边缘智能的重要性日益凸显是其中一个关键因素。随着传感器网络、移动设备(如手机和笔记本电脑)以及物联网的发展,数据整理的需求不断增长。与此同时,基于云的服务受限于基础设施延迟,而本地处理则无需依赖云端,这在速度和安全性上可能更具优势。

关于是否需要NPU的问题,实际上已不再是讨论的焦点。英特尔、AMD和苹果等硅谷巨头已经在这一技术上进行了大量投资。无论你是否有特定的NPU使用场景,当你下次组装或购买PC时,你选择的芯片很可能已经内置了NPU。据分析师预测,到2026年底,100%的美国企业PC采购都将选择配备一个或多个NPU的芯片。换句话说,你无需担心找不到带有NPU的系统,因为它们将无处不在。

AI大模型基石:一文读懂NPU

AI大模型基石:一文读懂NPU

本文转载自智尊AI大模型。