原文链接:

Hello,大家好啊!今天给大家带来一篇关于在麒麟KOS上部署MaxKB,并结合Ollama本地化部署DeepSeek-R1模型的文章。通过本教程,您将学会如何在麒麟KOS上搭建MaxKB 知识库管理系统,并通过Ollama部署DeepSeek-R1大模型,最终通过MaxKB前端页面访问本地AI大模型,实现高效智能问答。欢迎大家分享点赞,点个在看和关注吧!

1.查看系统信息

pdsyw@pdsyw1024:~$ cat /etc/os-release pdsyw@pdsyw1024:~$ uname -a

2.配置临时代理

pdsyw@pdsyw1024:~$ export http_proxy="http://192.168.0.193:7890"pdsyw@pdsyw1024:~$ export https_proxy="http://192.168.0.193:7890"

3.安装ollama

pdsyw@pdsyw1024:~$ curl -fsSL https://ollama.com/install.sh | sh

4.查看ollama版本

pdsyw@pdsyw1024:~$ ollama --versionollama version is 0.5.11

5.下载deepseek-R1

pdsyw@pdsyw1024:~$ ollama pull deepseek-R1:1.5b

6.查看ollama列表

pdsyw@pdsyw1024:~$ ollama listNAME ID SIZE MODIFIED deepseek-R1:1.5b a42b25d8c10a 1.1 GB 2 minutes ago

7.运行deepseek-R1

pdsyw@pdsyw1024:~$ ollama run deepseek-R1:1.5b

8.查看ollama端口

root@pdsyw1024:~# netstat -tulnp | grep ollamatcp 0 0 127.0.0.1:11434 0.0.0.0:* LISTEN 13723/ollama

9.配置ollama远程访问

root@pdsyw1024:~# systemctl stop ollama.service root@pdsyw1024:~# mkdir -p /etc/systemd/system/ollama.service.droot@pdsyw1024:~# vim /etc/systemd/system/ollama.service.d/environment.confroot@pdsyw1024:~# cat /etc/systemd/system/ollama.service.d/environment.conf[Service]Environment="OLLAMA_HOST=0.0.0.0:11434"root@pdsyw1024:~# systemctl restart ollamaroot@pdsyw1024:~# systemctl status ollama

10.下载maxkb离线包

https://community.fit2cloud.com/#/download/maxkb/v1-10-1-lts

11.解压maxkb

pdsyw@pdsyw1024:~$ ls maxkb-v1.10.1-lts-offline.tar.gz pdsyw@pdsyw1024:~$ tar zxvf maxkb-v1.10.1-lts-offline.tar.gz

12.安装maxkb

pdsyw@pdsyw1024:~$ cd maxkb-v1.10.1-lts-offline/pdsyw@pdsyw1024:~/maxkb-v1.10.1-lts-offline$ sudo bash install.sh

13.查看ip

pdsyw@pdsyw1024:~/maxkb-v1.10.1-lts-offline$ ip a

14.访问maxkb

http://192.168.0.247:8080/ui/login用户名:admin默认密码:MaxKB@123..

15.修改密码

16.创建应用

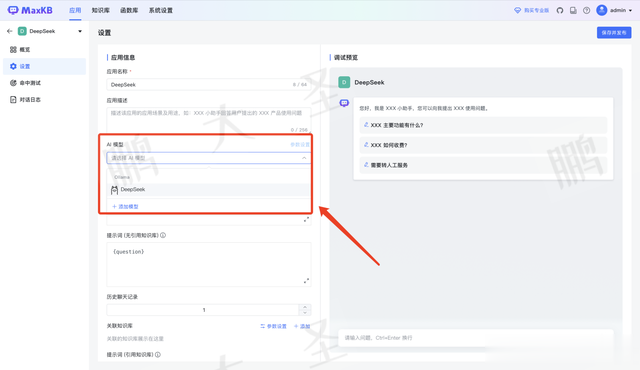

17.应用配置

18.添加模型

19.选择ollama

20.配置ollama

没有api key可任意填写即可。

21.选择模型

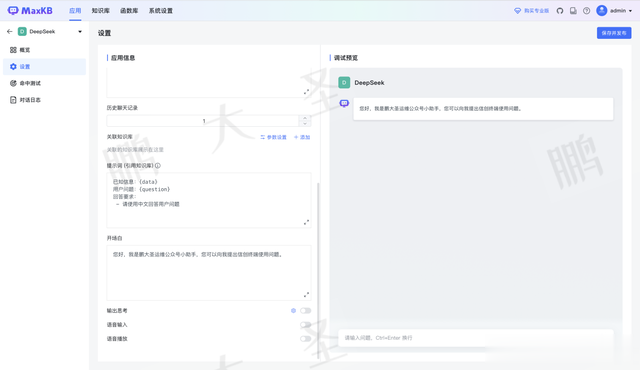

22.填写开场白

23.查看访问地址

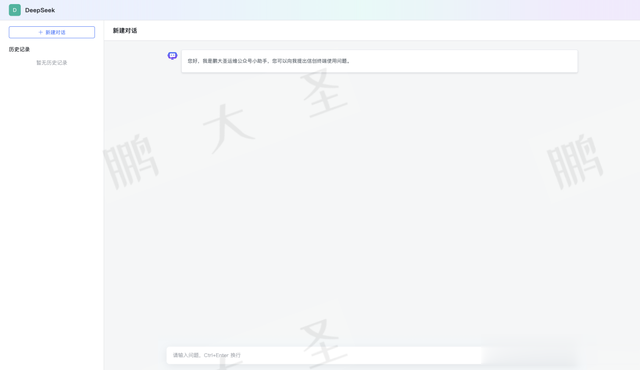

24.访问测试

http://192.168.0.247:8080/ui/chat/9d8b2fc4aa51d1d5

25.模型测试

通过本教程,我们成功在麒麟KOS上:安装Ollama并部署DeepSeek-R1模型,搭建MaxKB 作为AI知识库前端,在Web页面访问本地AI模型,实现智能问答。这种方式不仅能够离线运行AI,还可以充分利用本地硬件资源,特别适用于数据安全要求高的企业和科研用户。如果您觉得这篇文章对您有帮助,欢迎分享点赞,记得点个在看和关注哦!我们下次再见!