现在DeepSeek这个国产AI真是风头无两,出场即王炸,一开源就风靡全球。虽然官方提供了API和在线交互内容,甚至还推出了APP让大家使用。不过作为技术人,本地部署才是正确的打开方式。我们想私密使用,本地部署也是最好的选择。

虽然现在AI大模型技术和能力越来越强,不过相应的成本也在逐步降低。成本低不仅仅意味着它价格低,也意味着,本地部署的成本低,即安装使用成本。所以要安装DeepSeek这个大模型,简单地有电脑就能有手即可,就两步。

首先,下载安装Ollama,它是一个管理运行AI大模型的工具,能节省大量代码依赖库调试的时间。打开官网,找到Download,这里列举了macOS,Linux和Windows三种不同操作系统的版本。我们一般用Windows系统,所以Download for Windows。下载后双击打开,跟着步骤下一步安装就行。

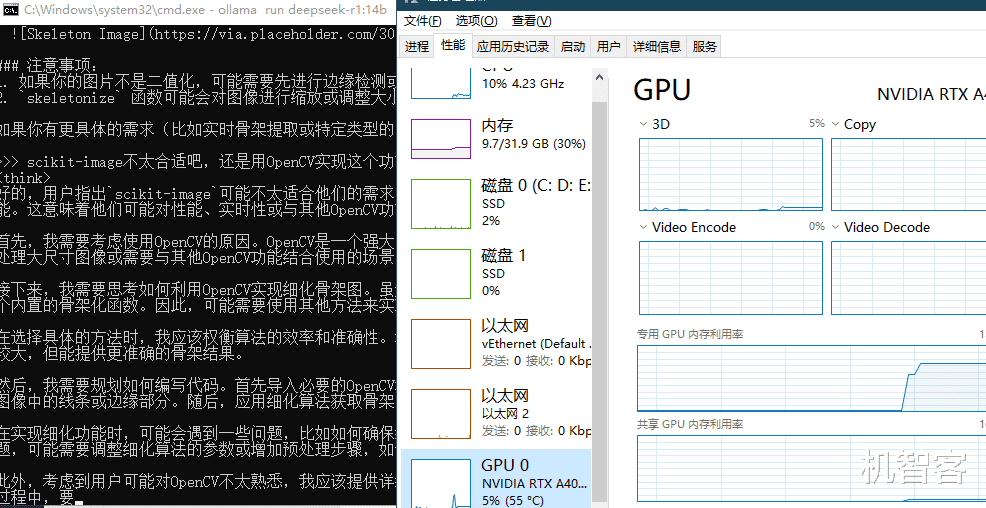

安装以后就能运行。Ollama是本地终端使用,也就是类似命令行的黑乎乎窗体。这里需要打开CMD,也就是win键,运行,输入cmd然后出现一个黑框。在cmd中输入ollama加AI大模型就能自动下载使用了,格式是:Ollama run yourModel 。Ollama支持的大模型很多,每个大模型也有不同的参数版本。比如DeepSeek的版本,适合个人或小公司用的有1.5B,7B,8B,14B,32B,70B。每个版本对应不同配置的电脑,很普通的个人电脑,显卡和硬盘都一般,甚至没啥显卡,用最低版本1.5B,消耗显存1GB。有8G的显卡那就用7B或8B,用12G或16G的显卡就用14B,显卡是24G的那就用32B。显存40G以上就用70B的。这里机智客的电脑是16G显存,那我输入:Ollama run ollama run deepseek-r1:14b确定以后就可以等待下载完成自动进入聊天界面了。

基本的本地部署就这两步。显存要你电脑配置。显存也间接决定硬盘空间的要求,现在AI大模型都很大,比如显存要求12G,也意味着大模型权重就得十来个G,加上其他文件,硬盘不得更多点才能装下整套AI。如果你需要大多数人都习惯的UI,那么就需要再增加一步,Web UI的安装和使用,这里不多说了,我们能简单就简单。