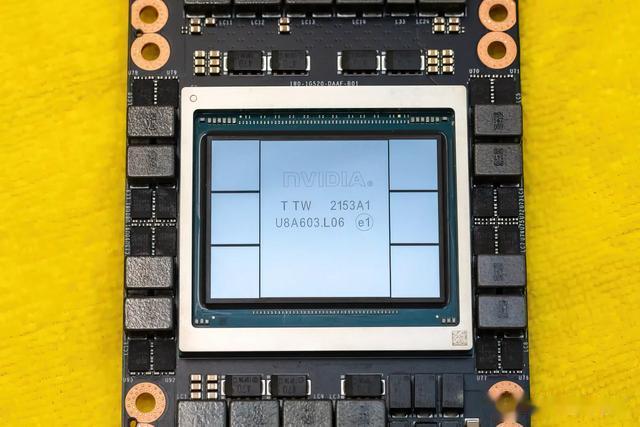

尽管B100和H100系列已推出市场,但目前在市场上,旧款的B100和H100产品仍占据较大份额。特别是在算力芯片的存量市场中占据着重要的地位,依旧被视为当前 GPU 市场的高性能代表。

首先我们来复习下,H100的基本参数。H100是基于先进的 Hopper 架构,相较于前代产品 A100,H100 在多个关键性能指标上都有显著提升。例如,H100 的 FP64 性能达到了 60 teraflops,是 A100 的三倍多,而其内存带宽也达到了 6 TB/s,远超 A100 的 2 TB/s。此外,H100 的 Tensor Core 性能是 A100 的六倍,使其在处理深度学习任务时更加高效。

H100 的优势不仅体现在性能上,还在于其对多种精度计算的支持,包括 FP8、FP16、TF32 等,这使得它能够灵活应对不同的 AI 和机器学习工作负载。其 Transformer Engine 专为加速大规模 Transformer 模型而设计,大幅提升了训练速度,特别适合处理自然语言处理和生成式 AI 任务。H100 还采用了 HBM3 高带宽内存,提供了更高的内存容量和更快的数据传输速度,进一步优化了性能。

但和最新的B系列对比,整体参数已经不那么突出!!!

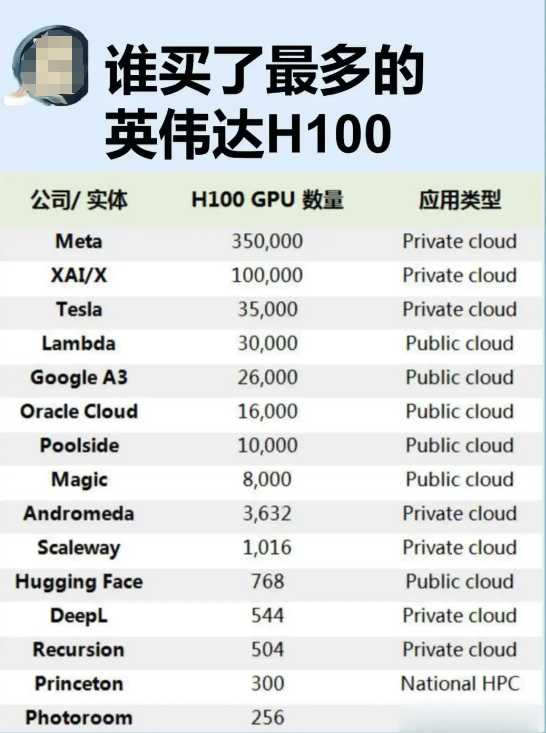

在生成式AI浪潮的推动下,英伟达H100 GPU已成为科技巨头争夺的“战略资源”。这款专为AI训练和推理设计的顶级芯片,不仅性能远超前代产品,更因供应紧张而被称为“比黄金更硬的通货”。以下是基于公开数据的全球H100采购格局统计:

一、国际巨头:Meta领跑,特斯拉紧随其后1. Meta:豪掷百亿美元的AGI野心

Meta在2024年初宣布计划采购35万颗H100,目标直指通用人工智能(AGI)。尽管部分报告显示其实际到货量为22.4万颗,但扎克伯格强调其算力集群规模“远超公开数据”。按单价3万美元估算,仅硬件成本已超百亿美元。

2. 特斯拉与xAI:马斯克的“双线作战”

特斯拉拥有3.5万颗H100,用于自动驾驶和Dojo超级计算机,而马斯克旗下xAI公司则被曝储备约3万颗H100,用于训练Grok模型。马斯克曾直言:“在AI领域竞争,每年至少需投入数十亿美元。”

4. 亚马逊、谷歌:自研与采购并行

亚马逊和谷歌分别采购19.6万颗和16.9万颗H100,但两家公司同时推进自研芯片(如亚马逊Trainium、谷歌TPU),以降低对英伟达的依赖。

二、中国厂商:绕道采购与本土替代博弈

二、中国厂商:绕道采购与本土替代博弈1. 腾讯与字节跳动:海外“囤卡”主力

受美国出口限制影响,H100无法直接在中国销售,但腾讯和字节跳动通过海外渠道分别采购约23万颗H100。字节跳动更被曝为“英伟达亚洲最大客户”,其海外数据中心布局进一步支撑算力需求。

2. 特供芯片的过渡角色

中国厂商曾大量采购英伟达特供版H20芯片(性能约为H100的20%),但2024年第三季度后该渠道也被阻断。这加速了华为昇腾等本土芯片的替代进程,但短期内难以弥补算力缺口。

三、其他玩家:云服务商与初创企业的“夹缝求生”

三、其他玩家:云服务商与初创企业的“夹缝求生”- CoreWeave:这家由矿机转型的AI云服务商,凭借与英伟达的紧密关系,获得超3.5万颗H100供货承诺,并以此抵押获得23亿美元融资。

- OpenAI、Anthropic等AI公司:OpenAI需至少5万颗H100训练GPT-5,而初创企业多依赖云服务商租赁算力。

四、英伟达的挑战:繁荣背后的隐忧

四、英伟达的挑战:繁荣背后的隐忧尽管H100在2024年出货量预计达150万-200万颗,但巨头们的自研芯片计划已构成威胁:

-Meta推出MTIA芯片:5nm工艺的推理加速器性能较初代提升3倍,计划逐步替代部分GPU。-亚马逊、谷歌强化定制芯片:亚马逊Trainium成本仅为英伟达方案的一半,谷歌TPU则优化了大模型推理效率。-中国反垄断调查:英伟达在华面临监管压力,进一步推动本土供应链崛起。 结语:算力竞赛的本质是生态之争

结语:算力竞赛的本质是生态之争H100的采购数据折射出AI产业的两极分化:头部企业通过“囤卡”构建护城河,而中小玩家则受限于资金与供应链。未来,英伟达能否维持霸主地位,不仅取决于产能,更需应对开源框架、异构计算等生态变革。这场“囤卡大战”的背后,实为AI时代基础设施主导权的争夺。