报告出品方:光大证券

以下为报告原文节选

------

1、 AI: iPhone 时刻的开启,硅基时代的行业特征

ChatGPT 引领人工智能进入以 AGI 为代表的新里程碑阶段。随着 AI 基础设施逐步完善,深度学习技术不断进步,人工智能应用场景逐渐增多,模型参数规模和数据量也实现了大幅度增长,为 NLP、CV 等领域带来更强大的表达能力和性能。人工智能发展历程中主要有两大里程碑:

里程碑一:2012 年 CNN 获得 ImageNet 第一,标志着机器视觉识别能力开始逐渐超越人眼识别准确率,开启了人工智能革命。随着深度学习技术不断突破,诞生了一批“AI+场景应用”的专属模型,但是整体研发成本比较高、研发时间比较长。

里程碑二:2022 年 ChatGPT 的出现,掀起了又一波人工智能发展热潮,以大模型+RLHF 为核心的技术落地意味着人工智能开启 AI 新范式。人工智能相关产业开始基于强大的基模型进行发展,通过人类反馈和强化学习不断解锁基模型的能力,以解决海量开放式任务,带来了新的研究范式。

AGI 技术能够精准识别人类情绪意图、理解人类语言、学习人类知识并进行类脑推理与创造,大模型是目前通往 AGI 的最佳实现方式。以 ChatGPT 为代表的人工智能技术已经具备 AGI 的核心技术和特征,能够自动化地学习任何可以符号化的知识及信息,不断自我优化,充分理解和流畅表达人类语言,同时逻辑推理能力强,实现了具备一般人类智慧的机器智能。

伴随 AI 技术升级和大模型成熟,AI 绘画与 ChatGPT 的成功破圈,生成式 AI 技术迎来发展拐点,行业关注度大幅提升。生成式 AI 是指基于大模型、生成对抗网络 GAN 等人工智能技术,通过已有数据寻找规律,并通过适当的泛化能力生成相关内容的技术,可生成如图像、文本、音频、视频等原创内容变体。例如,以 ChatGPT、Midjourney、文心一格、商汤商量、Codex 为代表的生成式 AI应用拥有文本语言理解能力、涌现能力以及思维链推理能力,能够完成文学创作、新闻写作、数理逻辑推算、代码生成、图片生成等多项任务。目前,国内电商、游戏、文娱、设计等行业正在积极使用相关的生成式 AI 应用来提高自身工作效率,尤其以文生图应用为主。

生成式 AI 不仅能够增强并加速下游多领域的设计,而且有潜力“发明”人类可能错过的新设计、新对象。生成式 AI 有生成大规模、高质量、低成本内容优势,在算力和算法支持下生成大量内容,生成的内容质量将持续超越 UGC 与 PGC。

未来有望为各行业提供内容支持并促进其内容繁荣,最大化释放内容生产力。

文字生成属于发展成熟、易于跨界转化的赛道,而跨模态生成赛道的发展潜力最大。生成式 AI 应用根据模态划分为文字生成、音频生成、图像生成、视频生成、跨模态生成。语音合成、文本生成图像属性编辑等技术应用目前较为成熟,跨模态生成、策略生成是高增长潜力的应用场景,在自动驾驶、机器人控制等领域有极高应用价值。

算力需求激增,推动算力基础设施迎增长新周期。受益于 AI 等相关新兴领域的应用以及“东数西算”政策下云计算、超算中心的蓬勃发展,数据计算、存储需求呈几何级数增长,算力需求持续释放带动算力基础设施产业迎来增长新周期。

据 IDC,AI 的应用与普及促使 2022 年我国智能算力规模近乎翻倍,达到 268EFLOPS,超过通用算力规模,2026 年我国智能算力规模将达 1271.4 EFLOPS,22-26 年复合增长率预计达 47.58%;硬件占 AI 支出比重 49.8%,其中最大投资是服务器,占 AI 硬件支出比重 84%以上,AI 将成为未来服务器市场新一轮快速增长的主要推动力。

2、 全球科技巨头大力布局 AI 产业

2.1、 微软:投资 OpenAI,Copilot 开启 AI 商业化里程碑

2023 年 1 月中旬,微软对 OpenAI 投资 100 亿美元,占股 49%。微软与 OpenAI的合作始于 2019 年 7 月,当时微软宣布向 OpenAI 提供 10 亿美元的投资,并与其建立独家云计算合作关系。此外,微软还将为 OpenAI 提供技术支持和咨询服务,帮助其实现“通用人工智能”的愿景。

微软将 GPT-4 模型装进了 Office 套件,推出了全新的 Copilot 系统,发布Dynamics 365 Copilot、Microsoft 365 Copilot、Power Platform Copilot 板块,开启 AI 商业化里程碑。

Dynamics 365 Copilot:GPT4 赋能业务全线Dynamics 365 Copilot 赋能销售人员随时快速响应。在 Dynamics 365 Sales和 Viva Sales 中,Copilot 可以编写给客户的电子邮件回复,在 Outlook 中自动生成一个 Teams 会议的总结邮件,从销售的 CRM 系统中自动提取产品、报价之类的细节,由 Teams 通话中总结出的核心要点一并汇总到邮件里。

Dynamics 365 Copilot 助力客服人员时刻对答如流。在 Dynamics 365Customer Service 中,能够针对聊天对话和电子邮件中的问题,撰写出符合上下文语境的答案。

Dynamics 365 Copilot 升级市场营销体验,轻松找到目标受众。在 Dynamics365 Customer Insights 和 Dynamics 365 Marketing 中的 Copilot 使营销人员能够简化他们在数据探索、受众细分和内容创建方面的工作流程:借助 Dynamics 365 Customer Insights 中的 Copilot,可以应对复杂的计算并且准确定位特定客户群体。

利用 Dynamics 365 Marketing 中的 Copilot,市场人员可以创建一个支持检索辅助功能的全新目标客户类别。

Microsoft 365 Copilot:开启全新工作方式

Copilot 是将大型语言模型 GPT-4 内建到 Microsoft 365。在程序里面可以用非常口语化的方式使用 AI,还可以通过各个程序的配合,达到预期效果。

Microsoft 365 Copilot 简化工作流程,释放创造力和生产力:

1. Copilot in Word 能够与用户一起撰写、编辑、总结和创作。

2. Copilot in PowerPoint 能够在创作过程中,通过自然语言命令将想法转化为设计好的演示文稿。

3. Copilot in Excel 能够帮助用户识别趋势,在短时间内创建专业型式的数据可视化。

4. Copilot in Outlook 能够帮助用户整合并管理收件箱。

5. Copilot in Teams 能够直接从对话上下文中提供实时摘要和待办事项。

6. Business Chat 汇集了来自文档、演示文稿、电子邮件、日历、笔记和联系人的数据,能够帮助用户总结聊天内容、撰写电子邮件、查找关键日期,根据其他项目文件制定计划。

Power Platform Copilot:低代码未来前景打开

Copilot 是将 AI 结合到各种软件内的功能。Copilot 是 Microsoft Power Platform 的一个新功能,可以在 Power Apps, Power Virtual Agents 和Power Automate 中基于 GPT 能力提供 AI-powered 的帮助,让制作者可以用自然语言描述他们想要的应用、流程或机器人,然后 Copilot 可以快速完成创建,并提供改进的建议。

(1)Power Apps Copilot 可以让制作者通过自然语言对话的方式来描述并且直接生成想要的应用程序,可以通过和 Copilot 的对话来对应用进行调整,Copilot 也可以为用户提供应用的改进建议来解决问题。

(2)通过 Power Automate Copilot ,可以通过自然语言来生成比以前更复杂的流程, Copilot 还可以以对话的方式不断优化和迭代更新流程,使用户无需专业知识也可以构建想要的流程。

(3)通过 Power Virtual Agents Copilot,可以直接使用自然语言来描述机器人流程,无需手动一个一个进行创建。

2.2、 英伟达:全球 GPU 龙头,产品需求量价齐升

全球 GPU 龙头开拓 AI 市场,助力服务器核心算力硬件性能提升。英伟达作为一家以 GPU 为主营业务的半导体设计公司,在 AI 行业发展初期就前瞻布局。2022年公司数据中心产品营业收入 150.05 亿美元,同比增长 41.38%,2020-2022CAGR 高达 49.70%,增势迅猛。ChatGPT 发布引爆市场、Google AI 对话模型Bard 开放公测、百度发布“文心一言”大模型等一系列互联网巨头纷纷发力 AI领域,催生 AI 服务器需求增长。据 TrendForce 预测,2023 年 AI 服务器出货量同比增速将达 37.7%,2024 年将增长 38%。公司有望受益于 AIGC 带来的核心算力硬件性能需求大幅提升,AI 服务器系统业务未来将成为公司数据中心产品营业收入的新增长点。

GPU 性能领先全球,H100 拓展市场领先地位。公司深耕 GPU 芯片多年,据英伟达在 IEEE 会议公布数据显示,从 2012 年的 K20X 到 2020 年的 A100,GPU的推理性能提高了 317 倍,远超摩尔定律的发展速度。A100 作为当前 AI 服务器 GPU 中的高端产品,性能相比上一代 Volta GPU 提升 20 倍,其 AI 推理性能是 CPU 的 249 倍,打破 16 项性能 AI 记录,在 AI、数据分析、高性能计算上应用广泛,目前仍是 AI 领域所用的主力 GPU,被 AWS、微软 Azure 和百度云等。

算力需求迅猛增长,服务器 GPU 业务有望迎来量价齐升。AIGC 产品与应用的逐步落地催生了巨大的算力需求,据 OpenAI 测算,自 2012 年以来,全球头部 AI模型训练算力需求 3-4 个月提升一倍,每年头部训练模型所需算力增长幅度高达10 倍。作为 AI 时代的算力核心,GPU 需求旺盛。同时,芯片性能的大幅提升带动 GPU 价格不断增长,英伟达 V100/A100/H100 三代 GPU 价格分别为 10000/15000/36500 美元。作为服务器 GPU 领导者,英伟达将直接受益于 AIGC 大热带来的核心算力硬件性能需求提升,服务器 GPU 业务有望迎来量价齐升。

2.3、 华为:服务器产业深耕多年,打造“鲲鹏+昇腾” 双引擎战略布局

深耕服务器产业多年,打造“鲲鹏+昇腾” 双引擎战略布局。华为从 2008 年开始对外提供服务器产品,目前形成了通用计算(鲲鹏)和 AI 计算(昇腾)两大业务布局。由于美国将华为列入实体清单,限制 x86 架构的芯片供给,华为在2021 年 12 月出售了 x86 服务器业务。原本主营 x86 服务器业务的子公司超聚变分离后仍然稳定发展,2022 年国内市占率位列第三,达到 10.1%。目前华为致力于打造以“Arm 架构的鲲鹏+达芬奇架构的昇腾”为根基的双引擎战略布局,借助自研芯片优势,持续拓展服务器业务布局。

坚持计算产业战略,积极布局 AI 服务器领域。华为创新处理器架构“达芬奇”以匹配算力的增速,推出全场景处理器族,其中面向通用计算的鲲鹏系列与面向AI 计算的昇腾系列主要应用于服务器产品,已服务政府、金融、运营商、电力、交通、医疗、教育、电力、油气、制造等领域,为全球合作伙伴开发服务器应用及解决方案。其中,采用鲲鹏 920/916 处理器的 TaiShan 服务器包括 2280E 边缘型、1280 高密型、2280 均衡型、2480 高性能型、5280 存储型和 X6000 高密型等产品,适配高性能计算、数据库、云计算等各种应用场景,现已应用于中科大千万亿次“瀚海 20 超级计算系统”。最高配置 2480 高端服务器基于鲲鹏920 处理器,最高提供 256 核、3.0GHz 主频的计算能力和最多 25 个 SSD 硬盘。

此外,昇腾系列 AI 服务器包括 Atlas 800 推理服务器与 Atlas 800 训练服务器,广泛应用于中心侧 AI 推理、深度学习模型开发和训练场景。Atlas 800 推理服务器搭载 64 核架构的鲲鹏 920 处理器,支持 8 张 Atlas 300I 推理卡,整机可提供 640 路高清视频实时分析(1080P 25FPS),Atlas 800 训练服务器达到 4U高度,最高可提供 2.24 PFLOPS FP16 的算力,为 AI 推理、深度学习模型开发和训练提供超强算力支持。

3、 AI 产业链:大模型加速落地,算力空间广阔,应用百花齐放

3.1、 大模型:国内和海外巨头加速布局

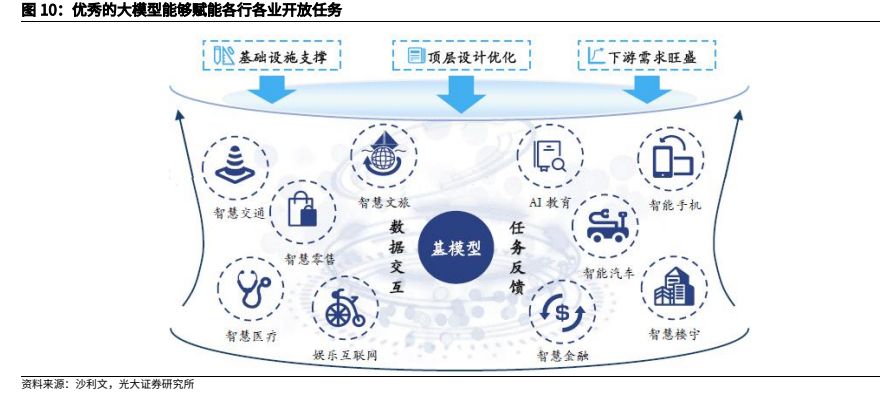

在“基础设施支撑+顶层设计优化+下游需求旺盛”三轮驱动下,AI 大模型迎来了良好的发展契机。通过数据交互和任务反馈,优秀的大模型能够赋能各行各业开放任务,满足对未来 AI 应用的期待。展望未来,大模型“训练基础设施-底层技术-基础应用-垂直应用”发展路线逐渐清晰,随着底层技术逐步革新,基模型和领域大模型持续完善,大模型应用边界不断拓宽,将加速赋能交通、医疗、金融等各个行业和领域引发一场以强人工智能和通用人工智能为代表的新一轮智能革命浪潮,大幅提高生产和生活效率,带来深刻的经济、社会和产业变革。

3.2、 服务器:AIGC 推动 GPU 服务器市场持续扩张

AI 训练服务器方面,单个大语言模型训练驱动 AI 训练服务器市场约 2 亿美元需求。据英伟达测算,要完成一次 10000 亿参数大语言模型的训练,使用 4096颗 A100 GPU 约需 4 周时间,使用 4096 颗 H100 GPU 约需 1 周时间。按每台服务器配备 8 颗 H100 GPU 计算,则完成一次万亿参数的大语言模型训练需约 500台服务器,配备 8 个 H100 GPU 的服务器价格约为 40 万美元,则单个大语言模型训练驱动 AI 训练服务器约 2 亿美元需求。

海内外服务器市场持续增长,国内市场一超多强。全球方面,根据 IDC 数据,2022 年全球服务器出货量突破 1,516 万台,同比增长 12%,产值达 1,215.8亿美元,预计未来四年内仍保持增长,2026 年全球服务器出货量达 1885.1 万台,2022-2026 年全球服务器出货量 CAGR 为 5.59%,产值有望达到 1664.95 亿美元,2022-2026 年产值 CAGR 为 8.18%。中国方面,据智研咨询数据,2022 年中国服务器出货量为 434.1 万台,同比增长 5.36%。据 IDC,2022 年中国服务器市场规模为 273.4 亿美元(1888.37 亿人民币),同比增长 9.1%。据中商情报网预测,2023 年中国服务器出货量有望达到 449 万台,同比增长 3.43%;中国服务器市场规模有望达到 308 亿美元,同比增长 12.66%。从市场份额(按营业收入统计)上看,据 IDC,浪潮、新华三、超聚变、宁畅、中兴位居 2022年中国服务器市场前五,市场份额占比分别为 28.1%/ 17.2%/ 10.1%/ 6.2%/5.3%,同比变动-2.7pct/ -0.3pct/ +6.9pct/ 0pct / +2.2pct。

AI 服务器有望迎高速增长,海内外云巨头加大 AI 服务器采购。ChatGPT、文心一言等 AIGC 大模型带来计算资源需求井喷,催生 AI 服务器需求增长,叠加配置升级带动单台 AI 服务器价值较通用型成倍增长,量价齐升。据 TrendForce 预测,2023 年全球 AI 服务器出货量同比增速可达 8%,2022~2026 年复合增长率将达 10.8%。据 IDC 数据,2021 年全球 AI 服务器市场规模 156 亿美元,预计到 2025 年全球 AI 服务器市场将达到 318 亿美元,21-25 CAGR 为 19.5%;2021年中国 AI 服务器市场规模达 350 亿元,预计 2025 年中国 AI 服务器市场规模将达到702亿元,21-25 CAGR为19.0%。从AI服务器的采购量来看,据TrendForce统计,2022 年 AI 服务器采购量中,北美四大云端供应商 Microsoft、Google、Meta、AWS 合计占比约 66%,而中国近年来 AI 建设浪潮持续升温,字节跳动2022 年采购占比达 6.2%,腾讯、阿里巴巴、百度紧接其后,分别约为 2.3%、1.5%与 1.5%。海外云巨头对 AI 服务器的需求更大,但随着国内 AI 大模型的开发及应用拉动更多 AI 服务器需求,中国 AI 服务器市场空间有望进一步提升。

IDC 认为,中期来看 X86 架构仍然会是主流的服务器,未来将会形成以 X86 为核心多种架构并存的丰富算力市场。另外,随着互联网、云服务、电信、银行等各行业超大规模客户不断扩张和升级扩容对于服务器的强劲需求,以硬件为中心的集成硬件与软件支持多样化工作负载的解决方案将成为服务器厂商制胜未来的关键。当前服务器产业正往技术多样化、服务定制化、软件定义、异构计算与边缘计算方向发展。

芯片作为服务器算力的载体,与服务器整体性能紧密相关。传统服务器芯片组仅由 2 颗 CPU 构成,价格在 800-850 美元/颗,而 AI 服务器芯片组通常需要搭载2 颗 1000-1100 美元/颗的 CPU,训练 AI 服务器与推理 AI 服务器还分别需要增加 8/4 颗 GPU 以提升服务器的综合算力。目前完整规格的英伟达 HGX H100 AI服务器搭载配备 8 个 H100 GPU,总计 8 个 GPC 图形集群,72 个 TPC 纹理集群,144 个 SM 流式多处理器,共计 18432 个 FP32 CUDA 核心,每组 SM 配备4 个专用于 AI 训练的第四代张量核心 TensorCore,共计 528 个。相较于同等GPU 数量配置的 A100,H100 在 HPC 和 AI 计算 (FP64/TF32/FP16/INT8)上由 156TF/2.5PF/5PF/10POPS 提升至 480TF/8PF/32PF/32POPS,在多专家(MoE) 模型训练速度上提升了 9 倍,大幅度提升万亿参数的 AI 大模型应用效率。

在 AIGC 快速发展背景下,服务器芯片配置或成服务器厂商制胜关键。

3.3、 光模块:800G 需求释放,中国厂商厚积薄发

AI 大模型发展加速光模块迭代节奏,800G 光模块放量或将超预期:根据Lightcounting 2021 年的预测,800G 光模块将从 2025 年底开始主导市场,主要原因是 AI 应用等带来数据流量的增长,超预期的数据中心带宽需求以及光模块厂商技术的迭代。随着以 Chat GPT4 为代表的 AI 大模型问世以及相关应用的快速发展,AI 训练和推理服务器有望进一步推升高速率光模块的需求。目前头部云厂商已开始集中测试和采购 800G 光模块,我们预计 800G 光模块出货量将在 23 年下半年快速增长,放量节奏将超出此前 Lightcounting 预期。

AI 服务器促使数据中心网络架构的演变,从而提升光模块需求:普通 GPU 服务器一般只要求单卡性能,而在 AI 训练中,GPU 卡间需要大量的参数通信,模型越复杂,通信量越大,所以 AI 服务器除了要求单卡性能外,还要求多卡间的通讯性能。这促使数据中心整体架构由传统的三层网络架构转化为脊叶式架构,数据流量从南北向到东西向转变。叶脊使用所有的互联链路,每台叶交换机都连接到了脊交换机上,脊交换机之间和叶交换机之间没有任何互连,相对于传统的三层网络架构而言,减少了设备寻找或等待连接的需求,从而减少了延迟及流量瓶颈。由于其特殊的拓扑结构,系统对于光模块的需求得到了提升。

随着数据中心对于带宽需求的提升,叶脊架构中的光模块也在持续升级之中。速率方面,亚马逊、谷歌、微软、Facebook 等北美超大型数据中心内部互连已经在 2019~2020 年开始商用部署 400Gb/s 光模块;国内数据中心正由 100Gb/s逐步向 400Gb/s 过渡。根据 IMT2020(5G)推进组预计,数据中心交换芯片吞吐量 2023 年将达到 51.2Tb/s,2025 年之后达到 102.4Tb/s,800Gb/s 和 1.6Tb/s更高速率将成为实现高带宽数据交换的重要选择。

Lightcounting 预测光模块市场 23 年将出现 10%下滑,但 800G/1.6T 光模块预计仍维持高增:根据 LightCounting 23 年 3 月发布的最新报告,其下调了 2023年以太网光模块销售的预测,从 22 年 10 月预测的 2%的增长到现在 10%的下降,24-28 年的复合增长率预期仍为 13%。下降的主要原因是云巨头 Meta 公司放缓了数据中心的建设部署,支持元宇宙业务的数据中心升级计划许多都被搁置或缩小了规模。但 Meta 公司确认了其建立人工智能基础设施,并追赶亚马逊和谷歌的承诺,目前大多数 400G 光模块使用的场景,接下来将使用 800G 光模块。

LightCounting 并未太多的削减 Meta 对 400G/800G 光模块的需求预测,LightCounting 对 1.6T 光模块的出货量预测没有改变,这些模块需要满足谷歌、亚马逊和微软运营的数据中心每年 40%带宽增长的需求。

800G LPO 方案或将成为 AI 服务器集群中最具性价比方案:LPO(Linear-drive Pluggable Optics)是线性驱动可插拨光模块,在数据链路中只使用线性模拟元件,无 CDR 或 DSP 芯片的设计方案。在 OFC 2023 上,多家厂商展示了其linear-drive 方案,包括 Macom、Broadcom 和 Cisco 等公司。相较 DSP 方案,LPO 可大幅度减少系统功耗和时延(功耗相较 DSP 可下降接近 50%,与 CPO的功耗接近),而系统误码率和传输距离有所牺牲,深度契合目前 AI 计算中心的短距离、大带宽、低功耗、低时延的数据连接需求。建议积极关注国内光模块公司在 800G LPO 方案的进展。

国内光模块厂商彰显强大竞争力,在 800G 时代有望持续扩大份额:根据Lightcounting ,2021 年全球前十大光模块厂商,中国厂商占据六席,分别为中际旭创(与 II-VI 并列第一)、华为海思(第三)、海信宽带(第五)、光迅科技(第六)、华工正源(第八)及新易盛(第九)。在 800G/1.6T 技术方面,国产厂商也都有深度布局,未来有望持续受益于 800G 光模块需求的放量。在2023 年 OFC 大会上,各大国内厂商发布并展示最新 800G/1.6T 光模块产品,例如:中际旭创发布基于 5nm DSP 和先进硅光子技术的第二代 800G OSFP DR8+和 2xFR4 光通信模块,以及 1.6T OSFP-XD DR8+可插拔光通信模块;新易盛推出多款 800G 光模块,其中基于薄膜铌酸锂(TFLN)调制器的 800G OSFP DR8 模块功耗仅为 11.2W,是目前业界最节能的光模块;光迅科技首次展出业界最新的数据中心内部高速互联 1.6T OSFP-XD DR8 和 800G QSFP-DD800 SR8光模块。

3.4、 边缘算力:AIoT 智能终端的“大脑”,端侧算法部署的核心

边缘算力应用和端侧 AI 算法部署需求巨大

智能应用处理器芯片均为系统级的超大规模数字集成电路,可以分为高性能应用处理器、通用应用处理器、人工智能视觉处理器、智能语音处理器、车载处理器、流媒体处理器等。上述处理器一般内置中央处理器(CPU),根据使用场景的需要增加图形处理器(GPU)、图像信号处理器(ISP)、神经网络处理器(NPU)及多媒体视频编解码器等处理内核。芯片内部设置高速总线负责各个处理器和外部接口的数据传输,配备闪存接口、动态存储器接口、显示接口、网络接口以及各种高速、低速外部设备接口。

SoC 的关键技术主要包括总线架构技术、IP 核可复用技术、软硬件协同设计技术、SoC 验证技术、可测性设计技术、低功耗设计技术、超深亚微米电路实现技术,以及嵌入式软件移植、开发研究,是一门跨学科的研究领域。SoC 意味着在单个芯片上实现以前需要多个芯片才能实现的系统功能,克服了多芯片板级集成出现的设计复杂、可靠性差、性能低等问题,并且在减小尺寸、降低成本、降低功耗、易于开发等方面也有突出优势。SoC 对研发设计、制造工艺以及软硬件协同开发技术的要求较高,主要体现在芯片验证和测试难度的提高,以及 IP复用、混合电路设计的困难加大。任何 SoC 的设计都是性能、功耗、稳定性、工艺难度几方面的平衡。完整的 SoC 系统解决方案,除了提供硬件参考设计外,还需要提供系统级的软件参考设计,包括驱动软件、大型 OS(Linux、Android、ChromeOS、国产 OS 等)的移植、针对性的算法、中间件和上层应用软件的适配等,并通过严格的可靠性、兼容性测试。

--- 报告摘录结束 更多内容请阅读报告原文 ---

报告合集专题一览 X 由【报告派】定期整理更新

(特别说明:本文来源于公开资料,摘录内容仅供参考,不构成任何投资建议,如需使用请参阅报告原文。)

精选报告来源:报告派科技 / 电子 / 半导体 /

人工智能 | Ai产业 | Ai芯片 | 智能家居 | 智能音箱 | 智能语音 | 智能家电 | 智能照明 | 智能马桶 | 智能终端 | 智能门锁 | 智能手机 | 可穿戴设备 |半导体 | 芯片产业 | 第三代半导体 | 蓝牙 | 晶圆 | 功率半导体 | 5G | GA射频 | IGBT | SIC GA | SIC GAN | 分立器件 | 化合物 | 晶圆 | 封装封测 | 显示器 | LED | OLED | LED封装 | LED芯片 | LED照明 | 柔性折叠屏 | 电子元器件 | 光电子 | 消费电子 | 电子FPC | 电路板 | 集成电路 | 元宇宙 | 区块链 | NFT数字藏品 | 虚拟货币 | 比特币 | 数字货币 | 资产管理 | 保险行业 | 保险科技 | 财产保险 |