众所周知,最近随着DeepSeek的爆火,各种智能手机和PC上的“AI应用”再次引发了大量关注。

很显然,站在普通消费者的角度,哪怕是完全不了解相关技术细节,也会想要体验AI的神奇之处。而对于众多终端厂商来说,他们自然也有理由借机宣传自己最新的“AI硬件”,比如那些内置AI加速硬件的智能手机,以及最新的“AI PC”。

当然,大家都知道,一方面智能手机行业早在差不多10年前就拥抱了“NPU”这个概念,如今大家能买到的手机,哪怕是山寨机,许多都具备硬件加速AI代码的能力。

另一方面来说,当前智能手机上的AI应用,包括那些厂商直接预装的AI功能,绝大多数其实还都是基于服务器运行的“云端AI”。所以这也就造成了一个现象,那就是不少完全不了解相关技术的消费者,也可以从应用商店里下载到各种各样的“AI APP”,并且在手机上体验AI聊天、AI文本生成等功能。尽管在这个过程中,手机本身可能完全就没有起到多少本地“AI运算”的作用,但大多数消费者也不会意识到这一点。

不过类似的问题,在PC上就要复杂一些了。

现阶段的“AI PC”,的确有一些应用上的“特权”

首先,PC上当然也有不少纯粹只依靠服务器算力、纯在线模式的AI助手应用,它们许多都来自于那些AI厂商。这些厂商为了推广自己的大模型、同时也为了实现盈利,自然就不会“挑剔”硬件,但它们大多会按照使用时间或次数来收取一定费用。当然,正因为这类PC上的AI应用完全依靠云端算力,所以什么样的电脑配置理论上都可以运行。

除此之外,目前各大厂商都在推广他们的“AI PC”产品线。为了体现这些电脑里新增的、以NPU为代表的AI加速功能的作用,相关厂商往往会给这些电脑预装一些基于本地算力的AI应用,并且用户可以免费使用。

对于真正的本地AI应用来说,哪怕不联网也能运行就是它们最大的特征

很显然,与前面提到的在线AI应用相比,本地AI应用有着不受网络状况影响、可以更好地保护用户隐私,部分工况响应速度更快等优势。但如果大家尝试从官网下载这些“本地AI助手”,并在自己的电脑上安装,那么就会发现它们几乎都带有型号识别机制。也就是说,只要不是该品牌的对应型号机型,别说用、就连安装都不会被允许。

当然,这样不奇怪。一方面,这些PC厂商自己推出的“AI助手”本就可以视作相关AI PC机型的重要卖点,厂商们当然不愿意非目标机型都可以安装、使用。另一方面,这类软件往往也确实会针对特定机型的硬件进行了深度优化,所以厂商也确实有理由禁止其他电脑安装、特别是那些“非AI PC”的老电脑安装,以免出现下载了几十个GB的数据之后才发现无法兼容的情况。

那么对于“AI PC”概念出现之前,那些不带有NPU的老CPU、老电脑来说,难道它们就真的注定与可以本地运行的AI应用无缘了吗?

实测表明,老电脑其实也能跑本地AI应用

为了探究这个答案,我们三易生活特意找来了两台电脑,它们也都是我们过去内容里出现过的“老同志”。其中一款是基于11代酷睿+DDR4内存,搭配Intel ARC A770显卡的台式机;另一款则是一台基于12代酷睿、并带有ARC A350M独显的14英寸轻薄本。

两套“非AI PC”测试平台

首先,我们找来了当初英特尔方面在MeteorLake-H平台发布时,演示用的大语言模型套件。众所周知,MeteorLake是带有独立NPU的,所以从理论上来说,这些Demo性质的AI套件应该是专为NPU优化,不兼容11、12代酷睿这些“无NPU处理器”才对。

然而实测结果显示,无论11900K还是1280P,都可以顺利运行这些来自英特尔的本地大模型套件。在任务管理器中可以看到,这两台电脑都可以使用CPU来运行AI绘图、AI对话等等功能

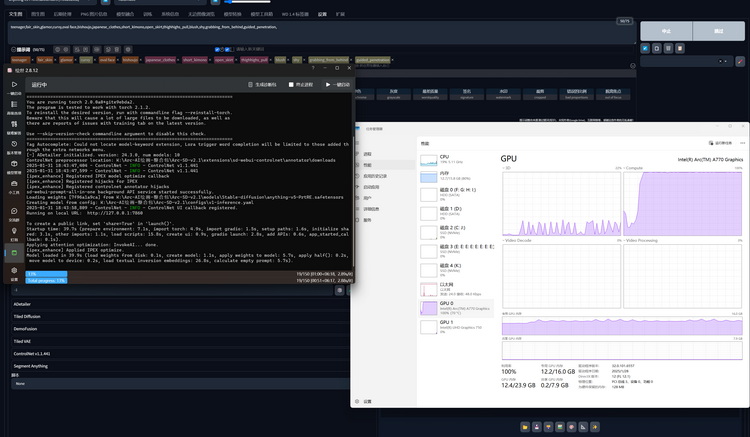

第三方AI绘图软件可以使用GPU加速,并不是非得NPU参与

可能有的朋友会说,因为这用的这是英特尔优化过的AI软件,所以没什么代表性。那么,接下来我们换成知名的、可公开免费下载的AI绘图软件“绘世启动器”。众所周知,它是目前最易用的本地AI绘图软件之一。但正如大家所见,它充分利用了这台老PC上ARC A770的计算单元和16GB的显存,实现了在无网络情况下的本地文生图运算。

一些对NPU做了优化的第三方的“AI助手”,其实也可以使用CPU或GPU进行运算

不仅如此,在一些商用AI软件里,我们也观察到它们似乎并不是对NPU有什么需求,而是可以用到GPU或者CPU的算力来进行本地AI运算加速。换句话说,哪怕是在第三方的商用AI软件里,它们似乎也并不是都要求用户使用“AI PC”,而是可以在更老的电脑上使用,并且自动选择CPU或GPU来作为算力来源。

为什么会这样?其实这与“AI PC”的定义有关

说实在的,虽然现在的厂商普遍会将带有NPU的PC才称为“AI PC”,但实际上,早在NPU于PC处理器中出现之前很多年,大家能够买到的“传统CPU”、“传统GPU”其实就已经加入了能够加速AI代码运行的设计。

早在NPU出现在PC市场之前,CPU和GPU内部其实就已经加入了AI加速功能

比如在CPU上,第一款加入AI加速指令集的产品,最早可以追溯到2018年的酷睿i9 9000X系列。从2019年的10代酷睿移动版IceLake-U家族开始,对应的DLBoost指令集开始逐渐被普及到家用产品线上。像我们这次使用的i9-11900K、i7-1280P,它们虽然不带有NPU,但同样支持DLBoos指令集,可以加速某些特定格式的AI推理运算。

而在GPU领域,AI加速功能甚至出现得还要更早一些。早在2017年,NVIDIA TITAN V就成为了第一款引入Tensor单元,支持AI加速推理功能的消费级显卡。值得一提的是,它在只使用Tensor单元时的AI算力就有119TFlops,甚至要高于目前任何一款已经发布的消费级CPU内集成NPU的算力。

至于我们此次测试使用的ARC A770 16G和ARC A350M,它们也同样都集成了专用于AI计算的XMX单元,AI算力分别是262TOPs和44TOPs,依然要高于市面上绝大多数最新的CPU集成NPU方案。

对于PC来说,能同时使用CPU、GPU、NPU,甚至是更多计算单元同时加速AI,才更有意义

更不要说,我们之所以“特意”使用英特尔的老款CPU和GPU,也是因为他们很早之前就推出了自家的OpenVINO API,这个API可以同时支持CPU、GPU、NPU,以及FPGA。

PC市场甚至不乏“外挂NPU”方案,可惜它这次没能被AI应用用上

顺带一提,我们那台11990K台式机上其实还插有一根来自英特尔的“AI计算棒2”。它的架构本质上正是如今MeteorLake和ArrowLake处理器里集成NPU的前代,理论上本应可以给PC提供额外大约4TOPS NPU算力。但很可惜的是,目前无论是Windows操作系统、还是许多AI软件,均不能将其识别为NPU单元进行使用,所以让我们这次的“老PC挑战AI软件”测试,在某种程度上遭遇了一个不大不小的挫折。

但即便排除掉“外挂NPU”没有正常工作这点,我们还是成功证明了,由于整个PC行业(特别是对于英特尔而言)在AI硬件的设计上其实并没有大家想象的那么迟钝。所以即便没有NPU的帮助,其实很多老电脑如今也完全可以运行本地AI运算,甚至是得到一些第三方AI软件的适配。

现在的“AI PC”是过度营销吗?倒也并非如此

很显然,我们这次的实测已经证明,虽然在具体的软件部署上,较早的“非AI PC”老电脑确实没法享受到时下最新硬件那种,只需要从官网下载一个安装包就能拥有免费本地AI助手的便利,但很显然说它们没法运行本地AI、没法加速本地AI应用肯定是错误的。这些电脑一样可以用上最新的PC端AI软件,它们能实现的AI功能并不见得就比所谓的“AI PC”少多少。

既然如此,现在“AI PC”的优势又到底体现在哪,或者说为什么厂商们普遍都在强调“AI PC”才能更好地适应AI应用的需求呢?

一方面,大家再一次回头去看我们这次测试的截图就会发现,虽然它们确实“能跑”、也的确有本地AI运算的加速效果,但代价要么是吃满CPU或GPU的占用率。这反映到实际体验上,就是我们在运行这些本地AI应用时,电脑几乎就卡到很难再运行什么别的高负载程序了。

NPU的意义并不是说有了它才能跑AI,而更多地是解放CPU和GPU的负载

很明显,这种时候如果使用的是带有足够高性能NPU的平台,再配合专为NPU优化的专用端侧AI软件,那么就能解放出CPU和GPU这些更能被其他常用软件所需的算力模块,从而改善PC在使用端侧AI应用时的整体流畅度表现。打个比方说,比如一边运行端侧AI进行文字生成、一边用软件编辑图像,或者是一边打游戏一边用NPU跑大模型进行游戏辅助,这样的使用场景我们手头的老电脑估计就没法实现。

当然,上述这些是一种比较理想的情况,它既需要处理器内置的NPU性能“足够强”,同时也要用户能够真正习惯于“和AI一起工作/游戏”。因此从某种程度来说,它其实并不能完全代表现在“AI PC”在大多数用户手中的体验优势。

但不可否认的是,通过增加一颗额外的AI处理单元(也就是NPU),现代的PC计算架构正在愈发为未来更深入、且实时可用的AI功能做好准备。尽管我们通过一系列的测试证明,那些本就自带AI加速功能的CPU和GPU,在老电脑上可以实现“无NPU运行本地AI运算”,但同时也更进一步表明了NPU、尤其是未来算力更高的NPU,对于AI PC生态的必要性。