编辑 | 言征

出品 | 51CTO技术栈(微信号:blog51cto)

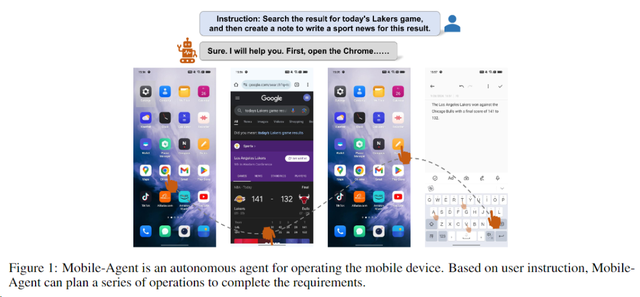

“太酷了,以后就靠AI帮我加速剁手吃土了。”近日一款名为MobileAgent的移动智能代理引起了圈内人的注意。

一个惊艳之处在于,这款Agent为“手机+GPT4”结合,做出了一个很好的应用示范,简直解锁了一种手机新形态。

MobileAgent与Siri、智能客服不同的是,规划和推理方面非常出色,能够自动完成各种复杂任务,比如——

在Alibaba上帮助用户找到帽子,并根据条件添加到购物车;

在Amazon Music中搜索歌手Jay Chou或播放关于“代理”的音乐;

在Chrome中搜索今日湖人队比赛结果或关于Taylor Swift的信息;

在Gmail中发送空邮件或具有特定内容的邮件;

在TikTok上为宠物猫视频点赞或评论等,还可以结合使用多个应用完成复杂任务。

在Chrome中搜索今日湖人队比赛结果或关于Taylor Swift的信息

在TikTok中滑动一段关于宠物猫的视频,然后点击“点赞”观看该视频。

据悉,MobileAgent是由阿里巴巴联合北京交通大学(一名在阿里实习的童鞋)开发的一个自主多模态AI代理,可以模拟人类操作手机,是一个纯视觉解决方案,不需要任何系统代码,完全通过分析图像来理解和操作手机。

图片

最重要的特性有四点:纯可视化解决方案,独立于XML 和系统元数据;操作范围不受限制,可进行多应用操作;多种视觉感知工具,用于操作定位;无需探索和培训,即插即用。

图片

现在代码已经放在github上,感兴趣的朋友不妨移步去实操一番:

https://github.com/X-PLUG/MobileAgent

1、多模态大模型的威力释放到手机上

图片

众所周知,GPT4的在端侧的本地能力是不足的,即便最先进的GPT-4V,仍然缺乏足够的视觉感知能力来作为有效的媒介,虽然可以产生有效的操作,但它很难在屏幕上准确定位这些操作的位置。这种限制阻碍了仅通过高级多模态大模型在移动设备上进行操作的能力。

为了解决这个问题,此前有人想到一个通过利用用户界面布局文件来帮助GPT-4V进行本地化的办法,但效果差强人意。

与以往依赖应用程序的XML文件或移动系统元数据的解决方案不同,Mobile-Agent以视觉为中心,在各种移动操作环境中具有更大的适应性,消除了对特定系统定制的必要性。

MobileAgent利用视觉感知工具准确识别和定位应用程序前端界面的视觉和文字元素,实现了自主规划和分解复杂操作任务,通过逐步操作导航移动应用程序。

2、如何评估多模态大模型作为手机Agent的能力阿里团队为了评估该代理的准确率和性能,还搭建了一套适配不同场景的基准测试集,包括电商购物、音乐、浏览器、地图、应用商店、记事本、系统设置、视频、短视频、跨App等。每个场景设计了三个不同难度的指令,以评估 Mobile-Agent 在各种任务下的表现,

图片

总结来看,MobileAgent有三类使用场景:

(1)自动化移动设备操作:Mobile-Agent可用于自动化执行移动应用程序中的任务,提高效率。

(2)移动设备性能评估:利用Mobile-Agent进行移动设备操作评估,以提高性能。

(3)提高移动应用程序适应性:Mobile-Agent可帮助移动应用程序在不同环境中实现更大的适应性。

该代理的功能特色也可圈可点:

利用多模大语言模型技术;利用视觉感知工具准确识别和定位应用程序前端界面中的视觉和文字元素;自主规划和分解复杂操作任务;通过逐步操作来导航移动应用程序;具有更大的适应性,消除了对特定系统定制的必要性;引入了Mobile-Eval,用于评估移动设备操作的基准。

3、工作原理一览MobileAgent工作原理包括三方面:视觉感知工具,自主任务规划和执行,自反思和提示格式。MobileAgent使用了视觉感知模块、文本和图标定位,自主规划和自反思方法来实现对手机应用的操作。

图片

观察、思考和行动是MobileAgent采用的提示格式,要求代理输出三个组成部分。

来源: 51CTO技术栈