前言 (个人测试结论)

本贴 是在本地部署Deepseek的基础上进行的,部署方法见上一篇帖子win11部署本地deepseek-r1,chatbox,deepseek联网(谷歌网页插件)。

想要获得自己的私人助手,需要喂相关的知识(RAG),这就需要建立知识库

建立知识库 需要先有一个量化工具(nomic-embed-text)。

ds的模型越大,回答的越理想。因设备条件差,只能用1.5b的进行测试。

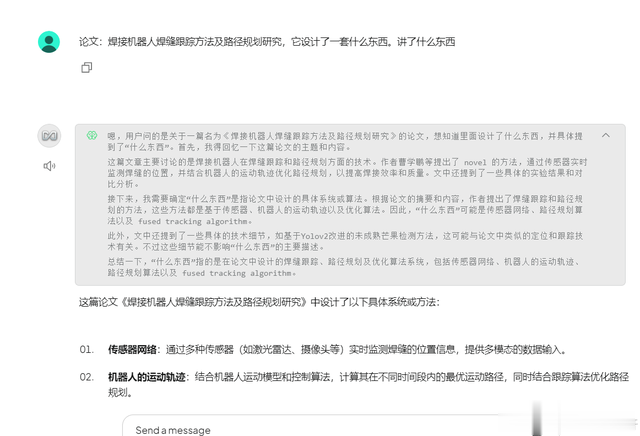

方法一、在谷歌插件Page Assist中投喂数据,较为方便。大pdf可以成功,但是回答的不理想。

方法二、AnythingLLM可以使用pdf、文本、音频、视频(音频、视频我没测试).

注意:刚测试发现pdf的质量 也影响测试结果,扫描的pdf教材之类的影印书籍,他在转化RAG的时候可能就存在问题了。所以影印书籍不适合投喂学习。

!!我发现用Cherry Studio调用api 。对添加的只是库操作,满血ds回答问题。

参考:Cherry Studio搭建本地知识库,让DeepSeek R1发挥最大实力,彻底告别硬件限制!

对于知识库不涉密,本地电脑配置跟不上的朋友,最适用!

法一、在Page Assist建立知识库

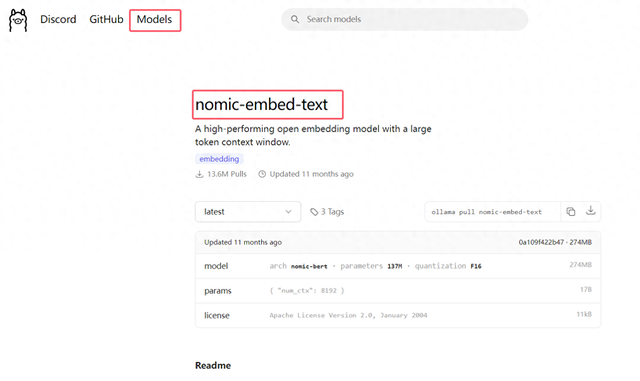

step1 下载nomic-embed-text

ollama官网->models->nomic-embed-text

cmd进终端输入(依然默认进了系统盘)

ollama pull nomic-embed-text

下载完成,进Page Assist的设置->RAG设置->文本嵌入模型:nomic-embed-text

我下了几次,前几次都下完没显示success,只有跳success后,

step2 加载进Page Assist

刷新Page Assist的设置页面,文本嵌入模型 才会有显示

step3 添加知识

管理知识->添加知识

我添加了一篇论文,进行测试,添加后,稍等一下,状态就会变成已完成。

step4 对话框添加知识库

回到首页,添加知识库,

方法二、在AnythingLLM建立知识库

在本地已经部署deepseek的基础上进行。

还需要先去下载一个下载nomic-embed-text。

参考视频:【AI】如何用RAG投喂数据给你的deepseek?

参考:Ollama结合Anything LLM搭建本地AI大模型

准备工作

1.下载nomic-embed-text

ollama官网->models->nomic-embed-text

cmd进终端输入(依然默认进了系统盘)

ollama pull nomic-embed-text

下载完成,进Page Assist的设置->RAG设置->文本嵌入模型:nomic-embed-text

我下了几次,前几次都下完没显示success,只有跳success后才是真的成功。

2.下载AnythingLLM

下载地址:AnythingLLM

安装速度 比想象中的慢 ~ 很 ~ 多 ~

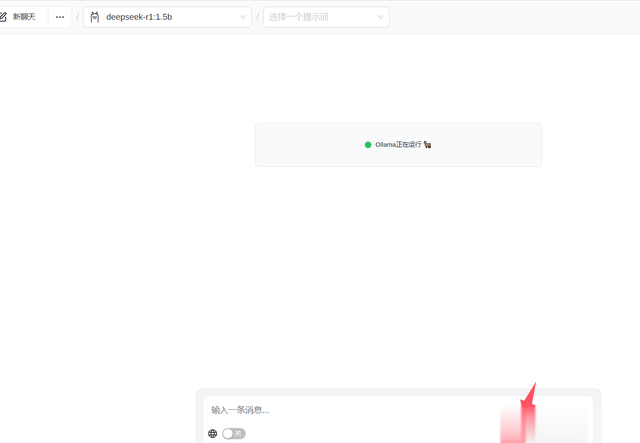

安装后,经过一大段导航(不停的点下一页),进入页面。

3.创建工作区,进行设置

3.1 聊天设置设置

聊天设置选择ollama,deepseek。

然后要拉到最下面点“Update workspace”

3.2 向量数据库

向量数据库 :喂给ds的文档,他会变成向量,向量的大小

暂时不设置

3.3 代理配置

选择ollama,自己之前部署的模型,然后点== “Update workspace”==

4.进入软件设置

设置完模型,还需要一个能够把”文本转变成ds读取的向量“的模型。所以需要回到大的设置

顺手修改下ds思考的语言。

4.1 向量数据库

用默认的LanceDB就行

4.2.嵌入首选项

选择ollama, nomic-embed-text。点击保存

上传文档

上传60多兆的pdf教材,报错了(我怀疑是 要修改下读取的参数值,我先试试)。

上传几兆的文献成功了。

点:save and embed

测试