“你能相信你的手机上现在能运行高效的目标检测模型了吗?

”张宏(化名)对他的朋友们说道。

这句话立刻引起了一片哗然。

一直以来,大家都认为,强大的目标检测模型只能运行在庞大的计算机服务器上,而张宏的话显然颠覆了他们的认知。

微小的手机芯片上如何能够运行复杂的深度学习模型呢?

这就让我们不得不提到一个叫做Micro-YOLO的新技术。

这个概念乍一听有点晦涩,但如果你了解它背后的故事,或许会对它的前景充满期待。

为什么目标检测需要更轻量级的模型?

简单来说,我们常见的目标检测模型,如Faster R-CNN和最常听说的YOLO,虽然在检测性能上表现卓越,但它们有一个致命缺陷——需要大量的计算资源。

这也是为什么这些模型通常只能部署在服务器上,而无法在手机、无人机等嵌入式设备上直接运行的原因。

过去,张宏曾在一次业余编程项目中尝试在他的老款手机上运行YOLO模型。

即便是“削足适履”之后,这个模型依然拖慢了手机的速度,几乎变成了一块发热的砖头。

于是,张宏意识到,开发更轻量的检测模型迫在眉睫。

Micro-YOLO:轻量级设计的核心思路Micro-YOLO的设计者们显然认识到了这一问题。

为了减少模型的计算量,他们想到了使用轻量级卷积层代替传统的卷积层。

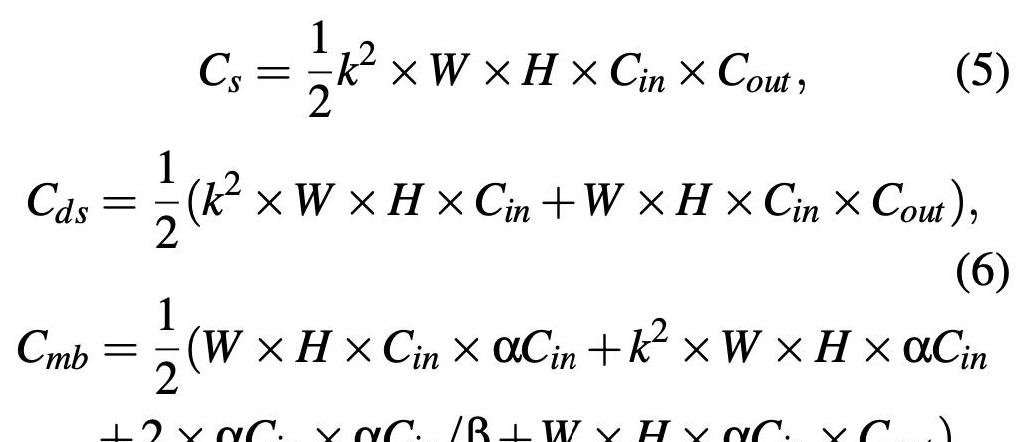

最核心的两个技术就是DSConv和MBConv。

DSConv,即深度卷积和逐点卷积的组合,能极大地减少模型大小和计算成本。

而MBConv更是锦上添花,用1×1的卷积层逐步缩减和扩展通道,实现高效计算。

想象一下你家的厨房,本来你灶台上摆满了各种锅碗瓢盆,每次做饭都要动用一堆厨具才能完成。

现在,你有了一个多功能料理机,它既能炒菜也能煮粥,你就不需要那么多复杂的炊具了。

Micro-YOLO的轻量化思路就像这个多功能料理机,让复杂任务简单化。

渐进式剪枝技术:让模型更精简

说到剪枝,可能不少人会想到剪树枝,但在深度学习领域,它可不单单是物理上的剪枝。

模型剪枝是通过去除冗余参数来精简模型,这和我们精简文件、删除无用的照片差不多。

Micro-YOLO采用了一种叫渐进式剪枝的技术。

这种方法就像裁缝一点点修改衣服的版型,直到找到最合身的样式。

在每个剪枝步骤中,研究者们都会评估模型的性能,剔除不重要的参数,保持其结构紧凑和高效。

张宏曾经试图简化一个模型的架构,但往往拆东墙补西墙,结果模型性能不升反降。

而渐进式剪枝则帮助他在不明显影响检测质量的情况下,减小了模型参数的体积,可谓事半功倍。

实验结果:压缩vs性能之间的新平衡

接下来,让我们看看实验结果吧。

Micro-YOLO的研究者在COCO数据集上进行了测试。

与原始的YOLOv3-tiny网络相比,Micro-YOLO成功减少了3.46倍的参数量和2.55倍的乘法加操作次数。

可能你会问,性能会因为压缩而降低吗?

令人惊喜的是,在模型压缩的同时,检测性能仅小幅度下降了0.7%。

这就像是一直开豪车的你忽然换成了一辆更节能但也依旧高性能的小车,油费省下了,驾驶体验却没有大的损失。

这种压缩与性能之间的新平衡,使得目标检测模型不再是高不可攀的技术,而变得触手可及了。

既能减小模型又不显著降低性能,这无疑给了广大开发者们更多的选择和机会。

结尾看完上述关于Micro-YOLO的介绍,相信你会对“压缩模型并保持高性能”这件事有了新的认识。

回到文章开头张宏与朋友们的对话,其实无论是手机上的目标检测还是其它高效的人工智能应用,背后都依赖于这样不断创新与突破的技术。

技术的发展不仅仅在于更高效地解决问题,更在于如何在人类生活中真正实现价值。

Micro-YOLO的出现告诉我们,复杂的智能模型也能被巧妙地简化,带来便利和可能性。

或许有一天,我们手中的每一部手机都能运行最先进的AI模型,不再受到硬件的制约。

这些技术的进步无疑为我们打开了更多可能性的窗户。

随着Micro-YOLO等技术的发展,我们似乎可以看到一个信息化和智能化更加亲民的未来。

你,准备好迎接这样的改变了吗?