文 |追风怪谈

编辑 |追风怪谈

前言近日,某社交网站吃瓜群的几张聊天记录在网络上疯传,引起了不少人的围观。

聊天记录内容是:

记录再往下翻,才发现不止有文字描述,还配了张图片。照片中的女孩虽然戴着眼镜和口罩,但仍能看出面容清丽,皮肤白皙,身材姣好,正在低头玩手机,但最让人震惊的是她的身上竟未着寸缕。尺度之大实在令人瞠目结舌。

聊天群里看到图片的人也纷纷被震惊,随后便对图片中的女子展开了漫无边际的遐想和调侃——

随着聊天记录被不断传播,大家对照片中女子的身份和事件的真实性也越来越好奇。

照片中的女子究竟是谁?

聊天记录中所说的“地铁上全裸露出”是真的吗?

一、“不雅照”实际为AI合成

聊天记录截图被流出后,就开始在网络上疯传,事态也不断发酵。有越来越多的人看到图片后,开始好奇照片的出处和真实性。如果这位美女是真的在地铁上搞“露出”,工作人员会眼看着而不进行劝诫或其他处理吗?旁边的乘客反应会如此平静吗?

于是,网友们便在各大社交平台上展开了“地毯式搜索”,试图找出关于照片中女孩的蛛丝马迹。

在大家的苦苦搜索下,终于找到了照片中女孩的某个社交平台账号。原来,这位女孩是小某书上的一位穿搭博主,平时会拍摄一些自己的穿搭照片分享在平台上。

而且,女孩发表的穿搭照片全都正常得体,无任何不良导向行为,那之前大家传播的“露出”照片是怎么回事呢?

正当大家疑惑之时,有人发现了不对劲——

在这位女孩去年八月份的一条社交动态中,有一张照片,与之前网上传播的“不雅照”看起来十分相似,但本质却截然不同:两张照片中的背景、动作、姿势都一模一样,但这张照片中的女孩却穿着再正常不过的服装,并没有做出聊天群中所传的不雅行为,图片配字“在地铁被夸了,感谢妈妈给的原生漫画腿”,完全就是一条正常的分享穿搭的动态。

大家往下继续翻看评论,才终于恍然大悟——

“姐姐,你这张图被P图造谣了。”

原来,之前大家在网上疯传的该名女生在地铁上的“露出不雅照”,是由AI“一键脱衣”合成的。而最初那个聊天群里的人们,也不过是“开局一张图,剩下全靠编”,仅靠着一张来路与真实性都尚且不明的照片,就肆意地给这位无辜的女孩子“造黄谣”,用完全不负责任的语言,来满足自己下流无耻的窥私欲。

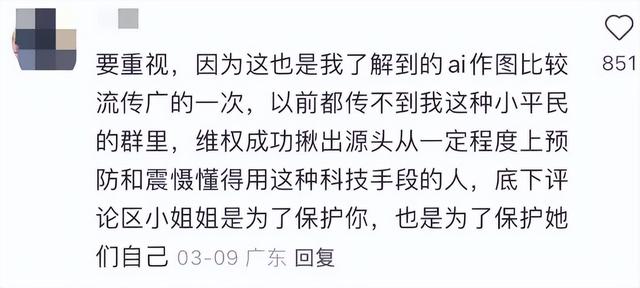

起初,当事女孩并不知道自己的照片被人拿去进行了如此恶劣的谣传,后经人在评论区提醒后,女孩表示:“大家稍安勿躁,我正在进行维权,别急。”

二、一键脱衣、一键换脸,AI究竟有多离谱?

该事件中造谣者使用的AI“脱衣”技术,是一种通过分析和替换人脸、身体的图像或视频内容,实现对原始素材的修改或伪造的人工智能技术。与之相似的还有一键换脸等。

通俗点来讲,就是使用女性裸照对人工智能应用进行训练,从而使应用可将任意图像中女性身上的衣物用裸露皮肤替换,从而合成出以假乱真的“裸照”。

早在四年前,国外就有人就开发出了这种“一键脱衣”的应用,但后来因为该应用受到了激烈争议,项目被迫停止。其中,知名度最高的工具,当属DeepFake。

DeepFake是一种利用人工智能技术,将一张人脸替换成另一张人脸的合成媒体。该软件被研发后,就一直用于制作虚假的色情视频、虚假新闻、恶搞视频等。

但由于其较高的技术门槛,DeepFake并没有得到大范围的应用。于是,它的低配版DeepNude“应运而生”。

只要用户在该软件上传一张照片,它就能利用人工智能技术,将照片中女性身上的衣物悉数“脱掉”,生成出一张虚假的裸照。

它的操作比之DeepFake要“简单”“便捷”得多,用户只需在软件内轻松点击数下,就可以在三十秒之内得到一张AI合成的“逼真”裸照。

不出意外,该软件发布后便在全球范围内都遭到了猛烈的抨击,因为它严重地侵犯了人们的肖像权、隐私权和名誉权,也会造成社会的不信任、舆论混乱和国家安全风险。因此,DeepNude上线仅一天后,就在一篇谩骂声中下架了。

但如今,国内网站上的替代品层出不穷,许多别有用心的人为了不正当的利益,仍在继续研发此类应用。只要在搜索引擎中搜索“AI一键脱衣”,相关的软件比比皆是。

此类软件通常程序简单、操作也很容易,仅需短短的几个步骤便有可能给照片中的人带来身败名裂的打击,实在令人不寒而栗。

三、合成裸照、接吻视频,“高科技性骚扰”何时是个头?

类似的AI技术原本可以用于健康的娱乐、教育、艺术创作等领域,但如今却被不法分子拿来诽谤他人,带来了无数隐私、版权以及道德方面的问题。

例如,越来越多的人利用这种技术制作不真实的色情或诽谤性的内容,严重侵犯了他人的肖像权和名誉权,甚至造成社会不安和法律纠纷。地铁女子被“一键脱衣”就是个典型的案例。

但这早已不是AI合成技术第一次引起巨大争议。

洪亮曾是一名特效合成师,因为制作各种与明星的合拍视频而在短视频平台上小有名气,积累了百万粉丝。特效合成技术给他带来了巨大的流量,而他的应用不当也让他因此“翻了车”。

有次,他在平台上发布的一段视频,评论并不似从前是一片欢声笑语,而是被谩骂声占据了大多数。视频内容是洪亮对国产某电视剧中主演迪丽热巴与男主角的吻戏片段进行了特效合成处理,把视频中杨洋的脸改成了自己的。

视频一经发布,马上引起了网友们的强烈不满,大家纷纷表示“辣眼睛”。

热巴的粉丝则更是气愤,认为洪亮的这种行为是严重侵犯了热巴的权力,要求他马上删除视频。

然而,洪亮并没有及时“听劝”。部分偏激的迪丽热巴粉丝眼看着劝删无果,直接找上了洪亮的工作室,把人给打了。

事后,洪亮在短视频平台发文向迪丽热巴“郑重道歉”,并将之前的吻戏换脸视频全部删除或隐藏,还发出了自己被打后的照片——

从图片来看,洪亮的脸上有几道明显的被抓伤的痕迹,仔细再看还有红白相间的巴掌印,看来热巴粉丝下手真的不轻。

洪亮给自己被打的照片配文“破相了,暂停更新一段时间。等我先缓一缓,一切都会好起来的”,看起来好不“可怜”。不过即使迪丽热巴的粉丝动手打人不对,但也是洪亮有损女明星的名誉权及肖像权、还不听劝告在先,热巴粉丝怒火中烧也是情有可原。

四、“造黄谣”必将付出法律代价

其实,在各种各样的“高科技性骚扰”事件中,最可恶的并不是被研发出的用来“脱衣”“换脸”的技术,而是利用这些技术损害他人名誉权的造谣者。工具本身并不会具备伤害他人的意图,只有到了别有用心的人手里,它们才成了伤人凶器。

十天前,一篇名为《那些被挂在黄色网站上的女孩们》的文章在网上引起热议,文中讲述的是一位女孩被同校的一名男同学恶意P图、造黄谣的经历。

文中讲到,苏州大学19级赵S峰对多名女同学恶意P图,并将她们的照片挂在色情网站上,大肆污蔑、造谣,声称自己与她们曾发生过关系,损害了多名女生的名誉。

此事经曝光后,校方立刻对该男生展开了调查。后经核实,文中所说的赵S峰P图、造黄谣等违法行为均为事实,并对该名学生作出了开除学籍的处分。

而赵S峰面临的不只有学校的处罚,还有法律的制裁。警方经过调查后,对赵某处以拘留十天的处罚。

经知情人透露,该名男生本已被保送名牌大学研究生,但这事一出,他的本科学校也将其开除,如今的他,只是一个有前科的高中肄业生,实在大快人心。

但此事只是众多“造黄谣”事件中的一例,当事女生还为此收集了大半年的证据,才令不法分子受到惩罚。当今互联网技术进步得飞快,造谣和犯罪的成本越来越低,还有许多的造谣者躲在屏幕后逃过了法律的制裁,还有众多无辜的被造谣女性尚未沉冤得雪。

笔者认为技术本身是中性的,关键在于使用者的目的和方式。如果是为了创造有价值的内容,或是经过被合成者的同意和授权,那么这种技术是完全可以被接受的。但如果是为了损害他人的利益,或是未经被合成者的同意或授权,那么这种技术就是不道德的,甚至是违法的。

技术的发展需要监管和引导。国家相关部门早已出台了互联网合成技术的管理规定,要求AI合成平台必须进行实名认证、标明合成标识、征得被合成者同意等措施,对不当使用AI合成技术的行为将进行严厉的整治和处罚。这是一种积极的举措,有利于保护公民的合法权益,维护网络安全和社会秩序。

技术的普及需要教育和提高。AI合成技术降低了造假和传播虚假信息的门槛,可能给公众造成误导和困扰。因为,我们需要提高自己的信息素养和辨别能力,对于疑似合成的内容, 要保持理性和警惕,不可轻信或盲目转发传播。同时,我们也应该尊重他人的知情权和选择权,不要随意使用AI合成技术来修改或曝光他人的图像或视频。

AI“一键脱衣”,本质上是一种互联网“造黄谣”,只是借用了新型的技术和手段,需要我们为网络谣言的治理作出新的努力,要不断完善和更新相关的法律法规,加强技术治理和社会监督,提高公众的识别能力和法律意识,不能让造谣者利用低犯罪成本屡次逍遥法外。