家人们,DeepSeek 刚推出了他们最新的类o1推理模型——DeepSeek R1-Lite。

这代表着国产大模型开始进入o1时代了。

根据官方的介绍,r1的思维链的长度可以达到数万字,采用强化学习技术,推理过程涵盖大量的反思和验证环节。

先简单看一眼指标表现,再拉出来练练。

整体结论是:数学和编程方面,这款模型与o1-preview相当,甚至一些榜单结果上超越了o1。

比如美国数学竞赛(AMC)中最高难度级别的AIME,DeepSeek R1-Lite领先o1一大截!

推理时间更长了!但是效果更牛逼了!

推理时间更长了!但是效果更牛逼了!DeepSeek提到,他们做了更强势的推理时间越长,性能越好。

如下图所示,DeepSeek-R1-Lite-Preview和o1-preview对比,随着思考长度的增加,AIME 上的得分稳步提高。

预览版可以试用了,正式版在路上

预览版可以试用了,正式版在路上DeepSeek团队透露,R1模型目前还在持续打磨中。

后续会推出正式版,并且开源,开放API,还会公布完整的技术细节。我已经等不及了,勇士们快点肝!

目前线上的还是预览版,每天可以50次免费测试~

想试试的小伙伴,链接我贴在这儿了:https://chat.deepseek.com/

拉出来比武!既然开测试了(让我白嫖)!那咱们就拿几道题测测它!

首先是大名鼎鼎的草莓问题。

问题:“strawberry”几个r?先是不用o1,答错了。

再打开o1,答对了。

但是再试一遍,第一次思考了2秒,这次思考了14秒。

错了。。(请仔细看它的思考过程,中间说了好几遍“有两个r”,一遍遍否定自己,有继续得出错误结论)

试试openai的o1,也不对。

再来一个反转字母!

问题:请帮我将这串字符全部的字母反着写:QingguanzhuXixiaoyao!

家人们!我把它弄崩溃了!我看它委屈成这样我都心软软!

它反复怀疑自己,反复怀疑题目,氮素,最后它错的很离谱啊!

不仅字母没有顺利反转,而且还加了字符串外的字母~

而o1 就快速的做错了,错的简简单单,轻轻松松,不费力气hh:

虽然DeepSeek-R1-Lite号称更长的推理时间带来了更好的效果,但是好像结果上差别不大啊,o1甚至没有引入字符串的字母,错的都没有DeepSeek-R1-Lite离谱!这局的胜负难定!

再来一道!

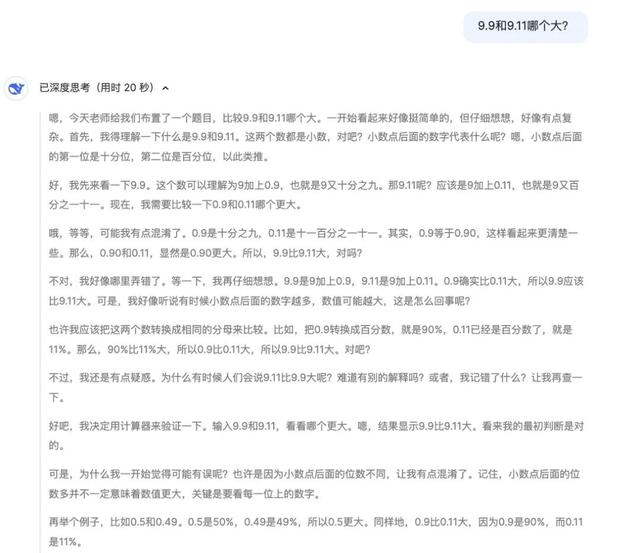

问题:9.9和9.11哪个大?

看到前面推理过程磨磨叽叽犹犹豫豫,奶茶还以为这把又要搞砸了,结果DeepSeek-R1-Lite窝窝囊囊中的做对了!!

3.5研究测试:

hujiaoai.cn

4研究测试:

askmanyai.cn

Claude-3研究测试:

hiclaude3.com

而o1还是干净利落的做错了hh~

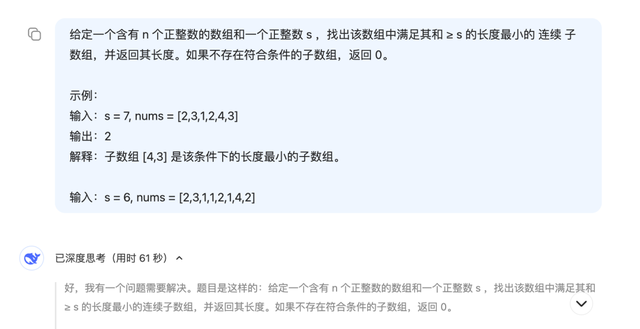

还有编程问题,必须测一测。

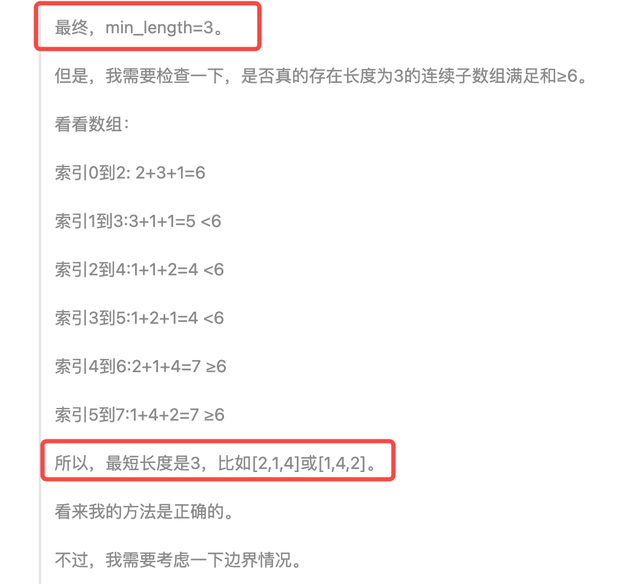

问题:选了一道经典的leetcode问题,求长度最小的子数组。它思考了整整一分钟,中间打印了好多步骤,最终,水灵灵滴得推理出来错误答案。。。

中间推理错了答案,

最后,验证了错误答案。。

openAI o1则简短的给出了正确答案。

数学和编程问题就到此为止吧。

再来一道开放性题目!

问题:我很好奇大语言模型的未来,能不能帮我想个办法未来让大语言模型为我挣钱?DeepSeek-R1-Lite:

o1:

这样看下来,DeepSeek-R1-Lite在开放性答案上,想很多!

但是它输出的方案并不是很具体,没有什么可以借鉴的明确路线,而o1还能说出来点有用的答案!

结语前不久讨论特别热烈的一个话题是“Scaling Law有没有撞南墙”,众多大佬下场发表看法。目前业界已经开始动摇了沿着Scaling Law继续走下去的信念,而o1是OpenAI提出来的LLM后时代的一条新路径,获取内部早就调转了车头也未可知。

仅从我们试用的一些case看,不足以代表DeepSeek-R1-Lite它的真实水平,但从中窥见,r1还有非常大的提升空间的。

但是,o1标注大模型从快思考进入慢思考,这条路还有许多可能和想象。DeepSeek这次是率先推出了国内版o1,追赶速度非常快,中国速度是牛的!要知道做事情从0-1的过程是最难的。

对于国产大模型的o1,我依然非常期待。