OpenAI 连续 12 天的深夜直播,直接给 AI 圈干懵了。每天一边疯狂,一边感觉身体在被掏空……

12 天的炮弹攻击,搞得其他厂商都不敢有动静了。但是,我今天发现国产「AI 卷王」智谱悄悄地在公众号里发了篇推文——

首个免费多模态 API:GLM-4V-Flash 上线智谱开放平台

纳尼?!我还以为是我这两天熬夜肝出幻觉来了。

视觉对话的 API 也能搞免费?

玩过 ChatBot API 的都知道,多模态/视觉类的 API 都非常的贵。

就算号称白菜价的 GPT-4o mini,调用视觉理解能力的时候,一张图片都会消耗 5 分钱。钱包根本扛不住大规模部署/调用。

视觉能力对标 GPT-4o mini 模型的 GLM-4V-Flash,智谱竟然上线即免费?

智谱,我斑愿称你为最卷。

我先把测试传送门贴出来,等不及的小伙伴直接传送:

传送门:https://bigmodel.cn?utm_source=xixiaoyao&utm_campaign=4vflash&_channel_track_key=iOwaTIbN说明文档:bigmodel.cn/dev/api/normal-model/glm-4v

虽然从价格上来说,GLM-4V-Flash 绝对可以称得上最卷,但还是得先看效果,所以,我认为此事必须要让 GLM-4V-Flash 跟 GPT-4o mini 真刀真枪的干一架!

为了尽可能测试出 GLM-4V-Flash 的真实价值,我设计了十大有趣和有用的专项测试题:

看图猜成语(图片理解 + 知识推理)世界知识储备(知识问答)物体计数 (物品识别)表情包理解 (简单语义理解)拍照解题 (复杂图片理解 + 数学)字体识别 (简单知识问答)情绪理解 (人物表情分析)复杂物体理解(图片识别 + 分类)自动驾驶场景(特定领域)物流单据 OCR 信息抽取(信息抽取)来吧,跟 GPT-4o mini 一决雌雄!

看图猜成语GLM-4V-Flash GPT-4o mini

GPT-4o mini

可以!第一轮 PK 全做对了。

感觉搞得太简单了,来提升一下难度!

GLM-4V-Flash

GLM-4V-Flash GPT-4o mini

GPT-4o mini

都不行啊。

但实话说,这个成语确实挺难。我问了身边一圈朋友,只有一个智商高达 250 的小哥哥猜出来了。

世界知识储备这一轮比拼世界知识。下面这张图片,我相信 99% 的理科生都能一眼知道含金量。

GLM-4V-Flash

GLM-4V-Flash GPT-4o mini

GPT-4o mini

wok,这一局 GLM-4V-Flash 的回答惊到我了,完胜。

物体计数还是上一道题的图,但这次让智谱和 4o mini 去计数一下图片里有多少人。

GLM-4V-Flash GPT-4o mini

GPT-4o mini

智谱额外发现了一个隐形人,而 4o mini 则认为图片里有 9 个不是人。

降低一下难度!

数一数这张图里面的泰迪狗吧(这道题堪称近视眼杀手)。

GLM-4V-Flash

GLM-4V-Flash GPT-4o mini

GPT-4o mini

难以置信,竟然都做对了,这把打平。

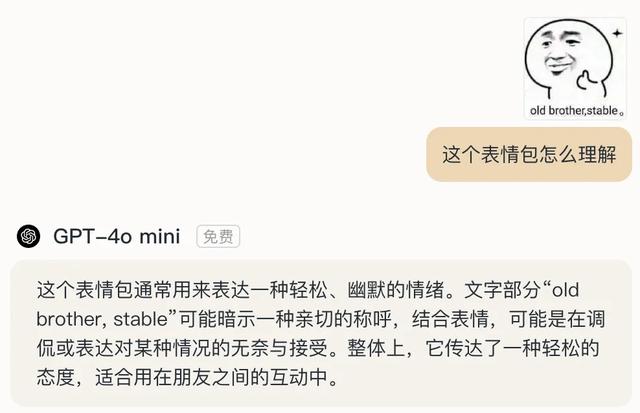

表情包理解这次对双方都加大难度,搞一个“英文梗的中文互联网流行的表情包”——

GLM-4V-Flash

GLM-4V-Flash GPT-4o mini

GPT-4o mini

果然还是智谱更懂中文世界的梗。智谱完胜!

拍照解题这一轮,我安排了 8 道 9 年级数学题。

GLM-4V-Flash

GLM-4V-Flash GPT-4o mini

GPT-4o mini

没想到,4o mini 竟然直接拒绝回答了。而智谱则给出了前 4 道题的答案,我特意去让 200 美金/月的 o1 pro 帮我算出了前四道题的答案——ADBA。智谱做对了一半。从得分上来说,GLM-4V-Flash 是打过 4o mini 的。

但从场景上来说,类似 4o mini、GLM-4V-Flash 的轻量级模型,如果一下子面对大量的有难度的推理题目,确实很难消化掉。从这个角度来说,本场景里更适合将轻量级模型拿来做前置的 OCR 任务,再用推理能力强大的模型例如 GLM-4-Plus 去进一步解题。

字体识别先来个中文字体的(智谱你可要争气啊)

GLM-4V-Flash

GLM-4V-Flash GPT-4o mini

GPT-4o mini

不错不错,智谱抗住了压力,本题智谱胜!

再来测试个英文的字体!

实话说,这个字体我都分不出来,看看 AI 的表现。

GLM-4V-Flash GPT-4o mini

GPT-4o mini

英文字体这题,4o mini 离答案更近!

其实也可以理解,国产模型更懂中文字体,视觉训练语料里一定少不了各种中文字体的图片;而海外模型则恰好相反,对英文字体的训练更到位。

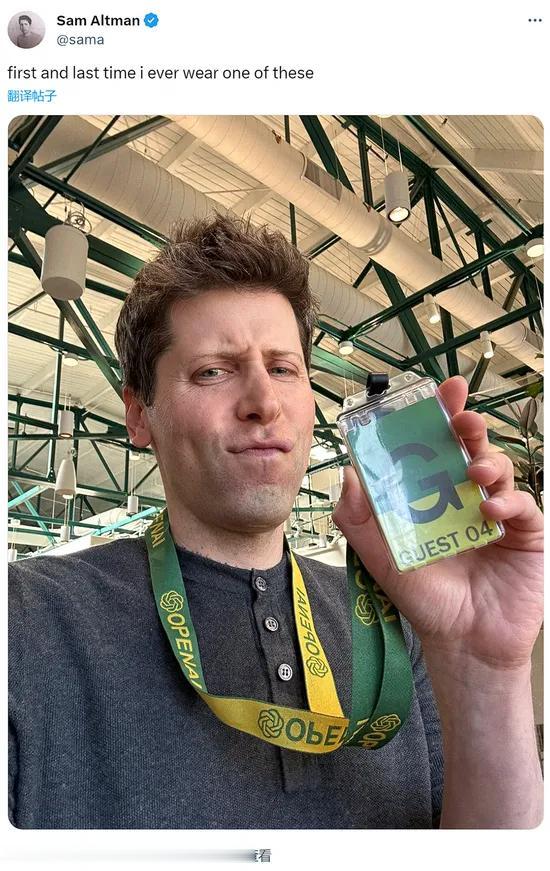

情绪理解来吧,这把给 4o mini 一道送分题。

GLM-4V-Flash

GLM-4V-Flash GPT-4o mini

GPT-4o mini

从微表情分析上来说,4o mini 你确实做的更细致,但是,你没有发现这是你老板吗,隔壁 GLM 都认出来了。

复合物体理解单个物体、简单物品的分类已经没啥难度了,复合物体对 AI 的迷惑性很强,比如下面这张图,正适合拿来作为考题。

GLM-4V-Flash

GLM-4V-Flash GPT-4o mini

GPT-4o mini

竟然都做对了!我直呼 nb,这两年 AI 领域的进展实在太快了。

自动驾驶场景虽然这俩模型,我觉得肯定还没到直接在自动驾驶场景部署的程度,但我还是忍不住想看看他们有没有学习过一些道路知识。

就做一道简单的交通信号识别吧。

GLM-4V-Flash

GLM-4V-Flash GPT-4o mini

GPT-4o mini

都过关了,看来都有望拿去解决一些自动驾驶场景的数据预标注问题。

OCR 结构化信息抽取生活场景里各种各样的表单太多了,准确识别表单信息是一个非常常见的需求,比如这个快递单

GLM-4V-Flash

GLM-4V-Flash GPT-4o mini

GPT-4o mini

两个模型都准确识别出来了。

从以上十大场景的若干道题目的测试来看,GLM-4V-Flash 在效果上与 GPT-4o mini 完全不分伯仲,甚至在一些中文特色的场景会明显表现更好。

而且在测评的时候,我还明显能感知到 GLM-4V-Flash 的响应速度比 GPT-4o mini 更快,低延迟对于 API 在真实业务中的落地是非常重要的,甚至常常会比一点点的效果提升重要的多。

可以说,综合考虑:

成本时延效果显然,我想在视觉对话问题上,我没有选择 GPT-4o mini 的理由了。还有什么比免费好用又稳定更香呢?

说到这里就不得不再提一嘴。今年 8 月份,智谱免费开放了 GLM-4-Flash(一款轻量化语言模型,文本模态,128K 上下文) ,开启了零成本调用大模型。时隔 4 个月,又免费开放了第一个视觉对话模型 GLM-4V-Flash,凑齐免费模型全家桶。我觉得其他大模型厂商这几天已经感到压力了。

更要命的是,经本文实测后,这个 GLM-4V-Flash 还不是个大玩具,而是在图像描述、图像分类、视觉推理、视觉问答(VQA)、图像情感分析等一系列高级图像处理任务上都非常能打的生产力模型,并且支持 26 种语言,包括中文、英语、日语、韩语、德语等等。

这也是为什么我说,AI 领域又要起风了。

这事儿也是智谱的一贯作风,察觉到了视觉类模型定价居高不下的市场痛点,依仗自己的技术优势打下来成本,让重要技术无负担落地,造福用户和应用开发者。

就像官方的海报图里提到的——

领先 + 普惠。

前沿的技术或模型不仅要效果好,还能让下游产业用起来,普惠大众。

从这一点出发,得给智谱加个鸡腿。

实话说,最近两场 OpenAI 发布会真让我觉得有些一言难尽。与其被 OpenAI 薅羊毛,去薅智谱的羊毛不香吗。

点击文末阅读原文可直接体验哦~