短期卷电动,长期卷智能,相信这是每个仍然“健在”的车企们都基本认同的观点。

尤其是智能驾驶,这几年技术进化的速度令人眼花缭乱。

尽管如此,我们仍然能用每一年的智驾“代名词”,大体上把智驾进化的路线分成几个阶段。

从2018年开始,“L2”这一概念逐渐进入了人们的视野。

只不过当时的智驾还属于野蛮生长阶段,功能也只是自动跟车和车道保持。因此静止的障碍物和匝道的大曲率弯道,就成了最典型的智驾拦路虎。

到了2019年,随着百度 Robotaxi 在长沙开启试运营,“自动驾驶”开始在神州大地上生根发芽,也让人看到了无人驾驶到来前的曙光。

2020年,车企们开始一窝蜂地提出“L2+”、L2.5甚至“L2.99”的概念,增加打灯变道等功能,来在宣传上贴近L3级“有条件自动驾驶”。

2021年,在此基础上“自动辅助导航驾驶”和“记忆泊车”成了关键词,智驾系统也终于趋于完善,开始解决“最后5公里”乃至“最后1公里”的问题。

2022年的关键词是“激光雷达”,随着硬件和算力的提升,有了足够的安全冗余,高速领航辅助能力得到了很好的保证。

2023年的代名词,则是“无图”。

头部车企已经悉数实现城市领航辅助了,但却发现高精地图“鲜度低”,过度依赖会限制智驾的应用范围。而抛弃高精地图或采用“轻地图”方案后,城市领航辅助可用范围大幅扩大。

而2024年最火爆的,必然是“端到端”。它的目的是为了提升智驾的执行效率,以及面对各种极端场景的能力。

最近有不少头部智驾企业,包括特斯拉、理想、华为、小鹏等等,都纷纷从传统智驾升级为了端到端智驾,而没升级端到端的也基本上都在规划和调试,这恰恰印证了现阶段的技术路线。

至于端到端智驾效果如何?恰好前段时间我去重庆参加了“问界智驾体验营”,实地体验华为基于端到端架构的ADS3.0系统,以此为例子跟大家具体聊聊。

众所周知,重庆固有“山城”之称,山与城市错综复杂,高低起伏变化大,再加上人口众多,车流量密集,电驴行人频繁横穿,交通标线奇葩等等……

这等于把行车困难的BUFF直接叠满了,连人开都很容易犯错,对智驾系统的考验可想而知。

整体体验下来,基于端到端架构的ADS 3.0给我带来最直观的感受就是俩字——果断。

比如,以前窄路碰到右侧有违停车的时,车会先自己踩脚刹车减个速,再绕过去,顿挫感比较强。

现在绕行违停车时,不到万不得已基本不会减速,有时甚至还会在出弯时加速。

在导流线遇到违停车侵占车道,车也可以毫不犹豫地压线绕过去。

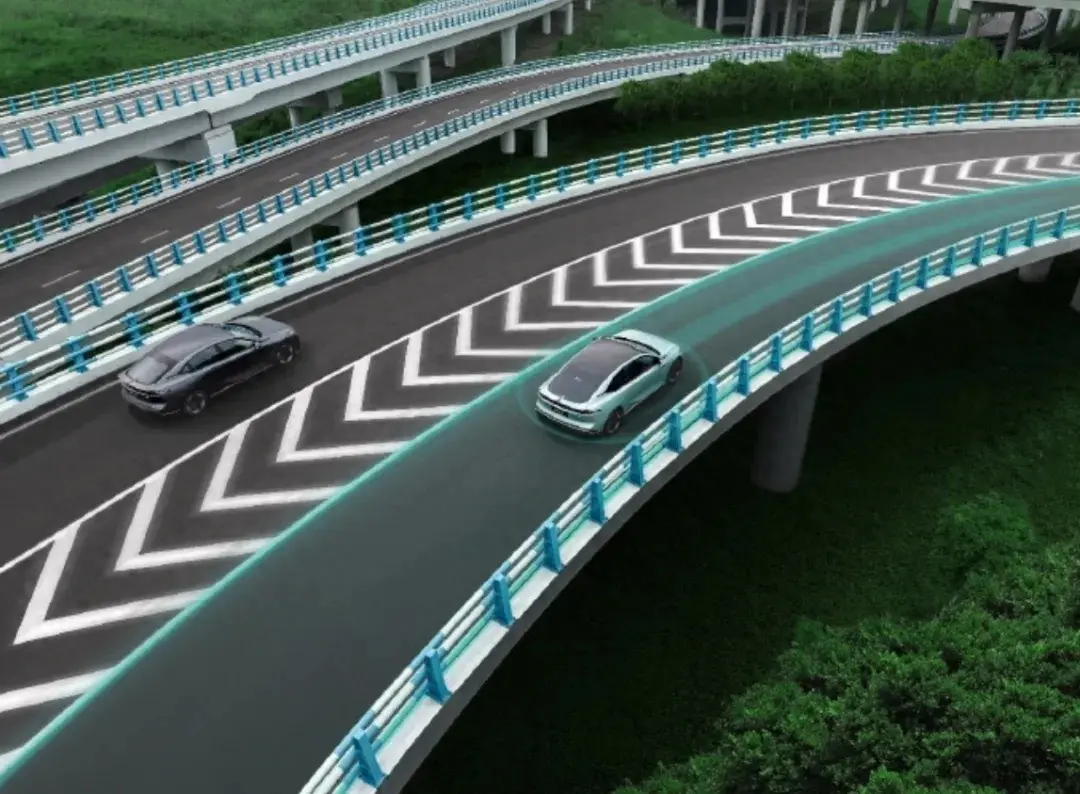

以前过大曲率弯道时,基本上都是卡40km/h限速过,现在如果前面没有车阻挡,会从40km/h开始逐渐加速过弯,速度有时甚至能到60km/h左右。

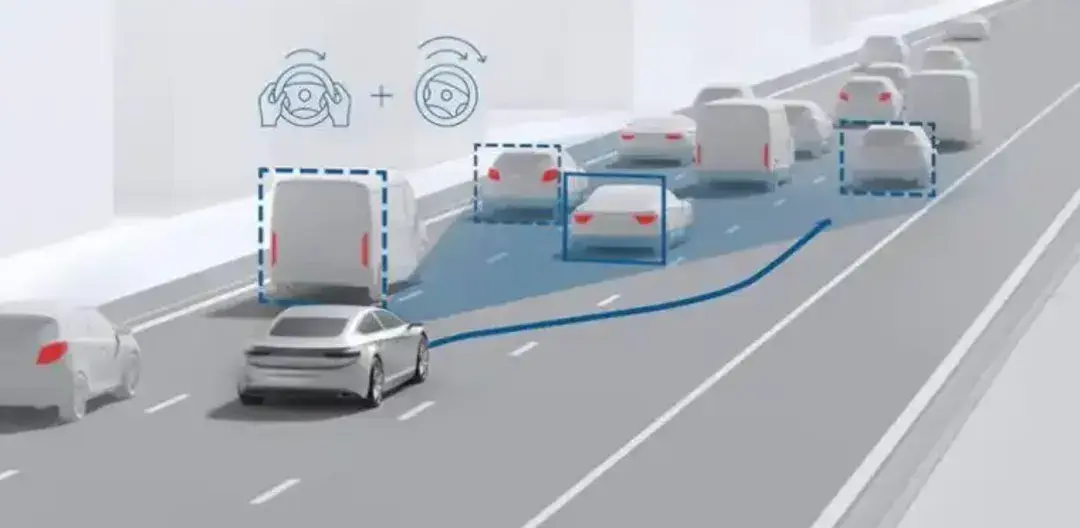

以前在执行变换车道命令时,如果检测到侧后方有来车,且对方速度高于自己车速时,99%的概率会选择先保持在原车道内,等对方超车之后再执行变道策略。

但现在执行变道命令,遇到同样的情况,则会有概率加速执行变换车道,一旦开始执行命令,整个切入和摆正车头的过程会非常迅速。

再比如,从辅路并线进入辅路后,遇到前方车道变窄,需要继续向左变道汇入时,以前会提前减速,打很多提前量并线。

现在则会在前方无车的情况下,优先开到车道汇入处尽头,再择机并入目标车道,甚至有时会压导流区。

总而言之,就是和老司机一样果断。

而另一个明显的感受,就是端到端系统对道路存在潜在危险的场景,具备了一定“防御性驾驶”的能力。

比如在重庆南山这样的曲折山路,车开得就不会像城市道路那样猛了,遇到大曲率转弯,存在视野盲区时,车辆会提前减速预防事故。

在路边违停车辆较多时,系统似乎判定场景为有行人/电动车“鬼探头”的可能性,所以开得也会比较谨慎,不会贸然提速。

在路口遇到疑似视野盲区,也会减速慢行。

还有必须要提的一点是,在升级完端到端智驾之后,车自身的“空间感”变得更好了。

具体到场景,就是以前不能掉头,现在能掉头了,而且掉头速度并不慢。

遇到人都容易开错的多出口环岛,车现在也能正确处理了。

总体上来说,从ADS 2.0到ADS 3.0,端到端架构带来的提升是显而易见的。

在场景不复杂的情况下,系统会以通行速度作为优先,执行各种动作特别干脆利落,很少会出现犹豫不决的情况,甚至能轻微“越界”。

在潜在风险场景,系统则会开得比较小心谨慎。

所以,就像一个对经验丰富的老司机一样,不再是简简单单的解决某个问题,而是从更宏观的视角出发去考量环境,从而影响决策策略的“激进”与“保守”。

可以看到,最近一年时间里,整个汽车行业大面积的开始升级端到端,意义究竟是什么呢?

答案是——上限。

这就要跟大家讲讲端到端和传统智驾有什么本质区别了。

传统智驾的底层,是依靠大量代码组成的逻辑链构成的,可以认为是复杂版的数控机床。

如果工况恰好处于代码覆盖的范围内,传统智驾的表现就会很稳定,可一旦场景复杂程度超过了范围,传统智驾就会犹豫不决无法处理,甚至直接退出。

所以严格意义上来说,传统智驾其实跟“智能”俩字不怎么搭边,以至于很多业内人都称其为“自动化驾驶”。

端到端架构与传统智驾的不同在于,它不再是从感知到决策再到执行的串行结构了,而是从感知图像直接转化为控制车辆加减速和转向的信号。

从底层架构上来看,端到端取消了海量的代码,取而代之的是神经网络构成的大模型。类似于由程序组成的神经细胞,使得端到端智驾应用的效果,更接近于生物而不是机器。

这也是为什么,各家在宣传端到端智驾时,都在强调“类人”、“仿生”的特性。

总结下来就是,传统智驾靠的是逻辑的堆叠,代码越叠越多,就会越来越慢,况且有些极端复杂的场景是怼多少代码都难以解决的。

而端到端,更多靠的是“经验”,这让机器在应对更复杂的极端场景时,可以更快速的做出与人类似的决策。

很多时候人类通过直觉做出的判断,有时很难通过逻辑来解释,但实际就是这么做了。

端到端智驾“经验”的来源,恰恰就是人类驾驶行为本身,其背后是通过投喂海量的图像与驾驶决策操作,训练出来的大模型。

虽然端到端很强,但并不能代表其不会出错。

既然本质上是人在开车,理论上来说出错就不可避免,毕竟不是神仙。

目前端到端暴露出的一些不稳定的情况,并不是因为端到端本身不够好,而是因为现阶段投喂的数据量不足导致的。实际上这类问题,在早期传统智驾身上发生的概率只多不少。

随着数据投喂量的提升,端到端智驾进化速度会比传统智驾更快,理论上其能力是能无限接近于人类的。

端到端可以做到L2级别的上限,但想做到L4级别无人驾驶,仍然需要传统智驾的底层逻辑来兜底。

问题来了,在端到端进化到理想状态之前,我们该怎样用好端到端呢?

这时,学会“人机共驾”,就是们学问了。

就像人类骑马一样,马有自己的思维,而人需要做的,是先摸清马的脾气,再去通过一定时间的配合,跟马达到知己知彼心有灵犀的状态,才能驾驭马术。

而人机共驾时,切不可将控制权全部交给机器,而是要做到“两松一不松”——

即,手和脚可以松,但眼睛不能松,要密切观察潜在危险,保持随时准备接管的状态。

每一位用户的接管和操作,对于端到端大模型本身来说都是一次数据修正。

久而久之,端到端智驾就会越来越好用。

任何新兴事物的发展,时间和经验的积累都必不可少。

写在最后

随着特斯拉引领端到端智驾时代的到来,对于车企来说可以说是又一个分水岭。

虽然各家自研端到端的底层逻辑都一样,但进化的速度却有快有慢,其中最重要的影响因素就是数据量的积累。

数据量的多与少,除了AI算力和软件仿真的解析力以外,路面上跑出的真实数据也是非常关键的。

车卖得越多,真实数据源就会越多。

也就是说,未来端到端智驾能力的强弱,跟销量是直接挂钩的。

不同品牌不同车型数据资源相互共享,恰恰是以问界为首的“华为系”的优势之一。

而月销50万辆的比亚迪,尽管目前智驾是短板,但后续也有可能凭借海量车源提供的数据,将智驾水平追上来。

新一轮的智驾竞争已然到来。

问未来谁主沉浮?让子弹再飞一会儿。