编辑:桃子 好困

【新智元导读】大模型战场上的硝烟可能先要告一段落了。OpenAI明年初将发布「Operator」智能体工具。与此同时,谷歌正准备年底推出「贾维斯」助手。AI智能体或许是2025年挽救LLM的救星。

大模型卷不动,该卷智能体了?

奥特曼刚刚发文:根本就没有墙

彭博最新爆料称,OpenAI计划在2025年1月初,重磅推出AI智能体工具「Operator」。

它可以通过计算机,代表一个人写代码、预定行程完成任务。

正如Claude 3.5所展示的,AI可以自主操控电脑一样。

之所以发布AI智能体,或许是因为OpenAI内部已经触及到大模型Scaling Law的边界了。

几天前,Information、路透接连曝出LLM进展放缓,而彭博的最新文章又为之添上一把火。

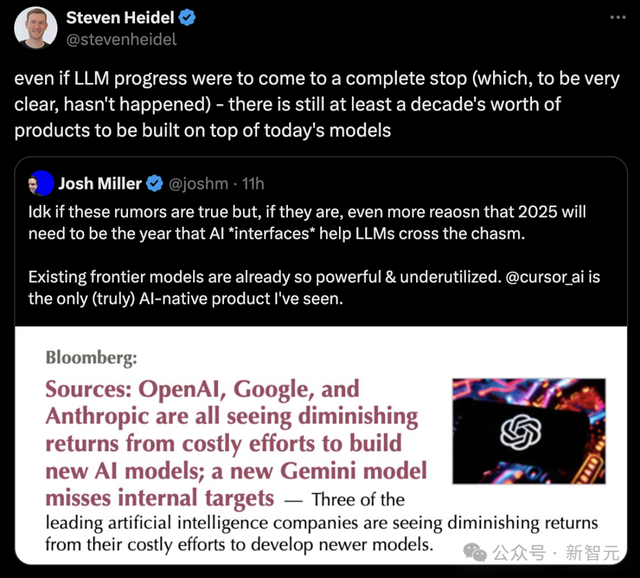

OpenAI、谷歌、Anthropic三家AI公司,在新模型上开发付出很多,但回报越来越少。

一家初创公司联创Josh Miller道出箴言:如果这些传言是真的,那么2025年将是「AI界面」帮助LLM跨越鸿沟的一年。现有的前沿模型已经如此强大,但没有得到充分利用。

对此,OpenAI微调研究员称,「即便是LLM进展完全停滞(然而现在并不是),基于当前的模型至少有十年的产品可以开发」。

这些话所暗含之意,便是OpenAI智能体发布的合理性。

AI智能体升温,OpenAI年初发布

诚然,随着LLM研发成本居高不下,各大AI实验室正面临着巨大的商业化压力。

单纯的模型性能提升,已经难以说服用户接受更高的价格。

而自主智能体,被视为下一个可能带来突破性的产品。

周三的员工会议上,OpenAI领导层宣布了计划在明年1月,发布代号为「Operator」的全新AI智能体预览版本。

并且, 将通过API向所有开发者开放。

据知情人士透露,OpenAI内部一直在进行多个与智能体相关的研究项目。最近得到的一个雏形是,在网络浏览器中执行任务的通用工具。

伦敦开发者日之后的Reddit AMA上,奥特曼在问答环节中曾暗示了向智能体转变的趋势。

他表示,「我认为下一个巨大的突破将是AI智能体」。

在OpenAI新闻发布会上,首席产品官Kevin Weil同样称,「我认为2025年将是智能体系统最终成为主流的一年」。

对此,OpenAI暂未回复彭博置评请求。但此举,也是整个行业在智能体发展布局的重要一环。

10月下旬,Anthropic首发「计算机使用」,并将其称之为全新人机交互范式的第一步。

Claude 3.5能够像人类一样操作计算机,不仅可以查看屏幕、移动光标,还可以单机按钮、键入文本。

比如,金门大桥和自己所在地的距离,Claude 3.5会自己打开地图进行查找。

微软在最近也推出了一套智能体工具,帮助企业员工发送电子邮件、管理记录等等。

谷歌也在准备年底发布代号为「Project Jarvis」的智能体,将由Genimi 2.0驱动。

它专门针对谷歌浏览器Chrome做了优化,帮助人们收集信息、购买商品、订机票等等。几天前,Jarvis被意外泄露,原型被设定为「一个与你一起上网的有用伴侣」。

还有Meta、苹果、亚马逊等科技大厂,都将在这一领域掀起一番风浪。

业界希望的是,智能体能够希望像ChatGPT一样掀起新一轮革命,从而证明当前他们在AI领域的巨额投资是值得的。

OpenAI、谷歌和Anthropic全部遭遇瓶颈

毕竟,如今寻找新的、未开发的高质量人工训练集,来构建更先进的AI系统变得越来越困难。

这些问题挑战了近年来硅谷的主流观点,特别是自从OpenAI两年前发布ChatGPT以来。

科技巨头们都在押注于所谓的Scaling Law,纷纷认为只要有足够的算力、数据、更大的模型。必然会为AI能力的巨大飞跃铺平道路。

然而,在这三个方向上的暴力美学,并没有预想的那么有效。

在OpenAI内部,研究人员对Orion已经开展了为期数月的后训练过程(post-training),包括整合人类反馈改进响应、完善模型与用户互动的语气等等。

但Orion的最终输出效果,仍未及OpenAI的预期,即可以向用户发布的水平。

一位知情人士透露,明年年初之前,OpenAI不太可能发布旗舰Orion。

最近的挫折也引发了人们的质疑,不仅对AI的大规模投资,还包括这些公司正在积极追求的一个终极目标的可行性:通用人工智能(AGI)。

奥特曼称,「AGI将在2025年到来」。Anthropic首席执行官Dario Amodei预测,「若没有其他外部阻力因素,AGI可能在2026/2027年到来」。

对此,Hugging Face的首席伦理科学家Margaret Mitchell表示,「AGI泡沫正在逐渐破裂」。

她指出,「我们现在清楚地认识到,可能需要采用不同的训练策略,才能使AI模型在各种任务上都表现出色」。而这一观点得到了许多AI专家的认同。

众所周知,OpenAI并非唯一一个最近遭遇瓶颈的公司。

短短几年以惊人速度推出越来越强大AI之后,谷歌、Anthropic都在新模型的开发上遇到了边际效益递减。

据称,谷歌即将推出的Gemini新版本未能达到内部预期。同时,备受期待的Claude 3.5「超大杯」Opus的时间表再次延迟。

紧随OpenAI脚步,谷歌改变策略,成立新小组今天,The Inforamtion深挖了谷歌内部模型的一些进展。

知情人士透露,谷歌最近在Gemini对话式AI方面的进展速度,不及去年。

尽管投入了更多的算力、训练数据(如互联网文本和图像),新版Gemini仍未能达到期望的性能提升。

(而过去版本的Gemini,在研究人员使用更多数据和计算能力进行训练时,改进速度超快。)

这个问题对谷歌来说尤其令人担忧,因为在使用的开发者和客户数量方面,Gemini远远落后于OpenAI的模型。

一直以来,谷歌希望利用其在计算资源方面的相对优势,让模型质量迅速赶超OpenAI。

与此同时,他们都在开发基于现有模型的新产品,有望自动化软件程序员和打工人复杂繁琐的工作。

这迫使研究人员不得不采取新的策略,来勉强获得性能提升。

谷歌发言人称,公司正在重新思考如何处理训练数据,并「大量投资」数据。此外,谷歌还成功地加快了Gemini生成回答的速度,发言人强调这「对于以谷歌的规模提供AI服务至关重要」。

与此同时,谷歌正借鉴OpenAI推理模型的做法,弥补在模型训练阶段使用传统Scaling Law所带来的进展放缓。

最近几周,DeepMind在其Gemini团队中组建了一个新的小组,由首席研究科学家Jack Rae和前Character.AI联合创始人Noam Shazeer领导,旨在开发类似的能力。

另外,据透露,开发Gemini的DeepMind研究人员,也一直专注于对模型进行「手动改进」。

其中便包括调整模型的「超参数」,即决定模型如何处理信息的变量,比如它如何快速地在训练数据中的不同概念或模式之间建立联系。

研究人员在为模型调优的过程中,测试不同的超参数,以确定哪些变量能带来最佳结果。

不过,谷歌并非完全从0开始。

谷歌研究人员此前就发明了OpenAI推理模型背后的一项关键技术——CoT,只是论文一作Jason Wei后来加入了OpenAI,在那里继续深化这项技术的研究。

论文地址:https://arxiv.org/pdf/2201.11903

不仅如此,谷歌在其传统方法中还遇到了一个问题:在用于开发Gemini的训练数据中发现了「大量重复信息」。

他们表示,这种数据重复可能降低了Gemini的性能表现。对此,谷歌发言人表示,这类问题对研发团队来说并不陌生。

谷歌此前寄希望于通过合成数据,以及音频和视频作为Gemini训练数据的一部分,能够带来显著性能提升,但这些尝试似乎并未产生预期的重大突破。

对此,谷歌发言人表示,Gemini模型「在处理音频和视觉信息方面已经展现出强劲的性能,我们将继续探索和推进多模态功能。

谷歌之外,Anthropic也被曝出暂缓Opus 3.5的发布。

Anthropic超大杯不及预期今年3月,Anthropic发布了三个新模型,并表示其中最强大的选项Claude Opus在关键基准测试上(如研究生水平的推理能力和编程)的表现超过了OpenAI的GPT-4和谷歌的Gemini。

在接下来的几个月里,Anthropic推出了其他两个Claude模型的更新——但没有更新Opus。

就在10月份,官网上与3.5 Opus有关的措辞,包括表明它将「在今年晚些时候」到来和「即将推出」等,都被删除了。这引发了业内对Opus开发进展的猜测。

知情人士表示,Caldue 3.5 Opus在评估中的表现确实比旧版本好,但考虑到模型的规模以及构建和运行它的成本,性能提升并不如预期那么多。

Anthropic的发言人表示,关于Opus的语言从网站上移除是出于营销决策,只展示可用和已进行基准测试的模型。

当被问及Opus 3.5是否仍会在今年推出时,该发言人指向了Amodei在播客中的言论。在采访中,这位CEO表示Anthropic仍计划发布该模型,但多次拒绝承诺具体时间表。

数据瓶颈,千亿美元训一个模型当前,AI巨头们正面临着一个关键转折点——仅仅依靠互联网「野生数据」,已经无法支撑AI向更高智能迈进。

虽然从大量社交媒体帖子、在线评论、书籍和其他从网络上自由爬取数据,催生了能说会道的ChatGPT,但要构建超越诺奖得主AI系统,可能还需要维基百科条目和YouTube字幕以外的数据源。

Scaling Law撞墙闹得沸沸扬扬,图灵奖得主LeCun下场表示,「虽然但是,我早就说过了...」。

他引述了Ilya接受路透采访的话,通过扩大预训练规模——即使用海量未标记数据来理解语言模式和结构的AI模型训练阶段——所获得的成果已经遇到瓶颈。

「2010年代是scaling的时代,现在,我们再次回到了奇迹和发现的时代。每个人都在寻找下一个奇迹」。

「现在比以往任何时候都更重要的是,Scaling真正有价值的方向」。

为了突破这一瓶颈,各大公司开始改变策略。

特别是OpenAI,已经与出版商签订了协议,以满足部分高质量数据的需求,同时也适应出版商和艺术家对用于构建GenAI产品的数据日益增长的法律压力。

一些科技公司还在招聘研究生学位的人员,以便对自身专业领域(如数学和编程)的数据进行标注。目标是提升这些系统在回应特定主题查询时的表现。

毋庸置疑,这些人工操作比单纯地爬取网页内容更耗时、成本更高。

一些公司也在转向合成数据,但在这方面,也存在着局限性。

正如New Enterprise Associates的AI战略主管、前微软副首席技术官Lila Tretikov所言:

「AI训练过程中,数据质量和多样性远比数量重要。没有人类知道,即便可以通过合成方法生成大量数据,也难以获得独特的、高质量的数据集,尤其是语言方面。」

尽管如此,AI公司仍在继续追求「more is better」的策略。

在追求构建接近人类智能水平的产品的过程中,科技公司正在增加用于训练新模型的计算能力、数据量和时间——同时也推高了成本。

Anthropic CEO Amodei表示,今年公司将花费1亿美元来训练一个最先进的模型,而这个金额在未来几年将达到1000亿美元。

但随着成本的上升,每个正在开发的新模型的风险和期望也随之增加。