PCIe 5.0服务器平台在2023年进入市场,到目前已经演进了两代,正逐步成为主流。Solidigm在推出PCIe 5.0 SSD的进度上相对竞品有所落后,但也把握住了后发优势,其首款PCIe 5.0 SSD——D7-PS1010/1030的标称性能一步到位跑满了x4接口的带宽。

在AI大热的当下,高性能的SSD最受AI数据管道的青睐,譬如作为GPU服务器的数据缓存盘,尤其是检查点创建需要高读写性能以减少训练时间的损失。大数据、商业分析等场景也奉行时间就是金钱。

高性能SSD还常在存储阵列中作为高性能层,为对象层加速。一个非常值得注意的例子是Solidigm的CSAL(Cloud Storage Acceleration Layer)中的写缓冲。CSAL以前是建议使用傲腾或SLC SSD作为持久化写缓冲,在D7-PS1010/1030发布之后,也将其作为缓冲盘的选择之一。

新一代的TLC SSD到底有没有能力接棒傲腾老大哥,在这次测试当中可以让大家有一些参考。

EDSFF:更适合的外形

从外观看,E3.S比U.2明显更薄。E3.S规划了两种厚度,1T和2T,分别对应厚度7.5mm和16.8mm。而U.2接口的NVMe SSD通常厚度为15mm,托架也以此规格设计,即使使用7mm厚度的SATA盘也大多只能安装在这样的托架之内。

E3.S的宽度(高度)为76mm,而U.2为69.9mm。前者在竖插时更接近2U服务器的高度(88.9mm),空间利用率更高。另外,许多传统服务器前窗为了兼顾3.5盘的长度(深度),背板位置比较深,这也导致2.5英寸托架通常还要做的比盘体更长一些,譬如下图左侧的U.2盘与托架组合的样子。

EDSFF设计的初衷就是尽量消除硬盘历史包袱的影响,更贴近现代服务器的规格。由于不需要弥合高度、深度差异,E3.S的托架结构可以明显简化,减少了材料的消耗,也更符合环保减排的大势。E3.S托架与盘体结合也更为简单,配合托架前部预制的定位销,只需要安装两颗螺丝即可固定。

信号方面的包袱也可以甩掉,E3.S的接口不需要如U.2那样兼容SATA、SAS等传统协议,不需要那么多金手指,外观尺寸由此明显缩小。另外,由于EDSFF接口直接与PCB一体,不需单独安装、焊接接插件,还有利于消除焊点处的信号反射和干扰,提高信号质量。

相应的,服务器高速背板的接插件体积也可以缩小,带来更好的通风效果。以此次的测试平台H3C UniServer R4900 G6 Ultra为例,可以同时配置U.2和E3.S的硬盘笼。每组硬盘笼占前窗三分之一的宽度,其中U.2硬盘笼可以安装8块SSD;E3.S 1T则是12块,而且硬盘的两侧还可以留下额外的进风口。H3C还规划了罕见的E3.S 2T笼选件,支持8个设备,可谓新锐又百变了。

从背板角度看,E3.S热插拔背板面积明显小于U.2背板。后者只在接口附近有少量镂空,而前者上下的豁口面积大得多,带来更大的通风量,对SSD和服务器内部散热都更为有利。姑且不论EDSFF接插件在信号质量上的优势和发展潜力,单是看安装密度和散热条件,这种为SSD量身定做的新外形规格优势确实非常明显。

从内部拆解看,U.2的D7-PS1010有充裕的厚度,可以使用传统的圆柱形的电解电容。而E3.S薄盘有厚度限制,需要使用贴片式的电解电容,成本会略高一些。原则上,E3.S的SSD可以布置更大的PCB面积以容纳更多的元件,但在D7-PS1010身上还没有体现这一点。毕竟它的最大容量点只规划到15.36TB,并不需要使用太多颗粒。

目前的D7-PS1010的PCB是每面8个NAND颗粒的设计,最高容量点会用满两面共16颗NAND颗粒。3.84和7.68TB都只用了单面8个焊盘位置,只是每片颗粒封装的die数量有别。D7-PS1010/1030使用的是SK海力士的176层TLC NAND,主控和DRAM也来自SK海力士。

四角性能:翻倍有余

我们以H3C UniServer R4900 G6 Ultra服务器为基础构建了Solidigm D7-PS1010的测试平台。该服务器可广泛应用于通用计算场景,同时对高性能计算、人工智能、云桌面等场景重点优化,适用于互联网、运营商、企业,政府等各行业典型应用,具有计算性能高、存储容量大、功耗低、扩展性强和可靠性高等特点,易于管理和部署。

具体配置为:

处理器:双路英特尔至强白金8562Y处理器(2.80GHz/60MB L3/32C/64T/250W)

内 存:16×32GB 1R×4 DDR5 5600

系 统:CentOS Stream release 9(内核6.11.3-1.el9.elrepo.x86_64)

在FIO v3.35测试当中,Solidigm D7-PS1010 7.68TB的顺序读可以达到14.8GB/s,顺序写10.7GB/s,比官方的标称值还要高一些。4KB随机读达到325万IOPS,随机写39.7万IOPS。3.84TB的读性能相仿,写性能略低,顺序写为8.6GB/s,随机写为32.4万IOPS。

从四角性能初步看,D7-PS1010相对上一代产品(PCIe 4.0)确实提升巨大,基准项目大致实现了倍增,随机读IOPS甚至接近3倍。如果要实现同样的目标性能,新一代的SSD完全可以“一个顶俩”。后面我们会利用更接近真实应用的测试做进一步的验证。

混合读写:上限猛增

在我们非常重视的混合随机读写方面,D7-PS1010 7.68TB在7读3写的设置下,读IOPS超过65万,写也超过28万。

在这里我们可以与PCIe 4.0时代的经典——Solidigm D7-P5520做一下对比。P5520不但是业内部署量和兼容性拔尖的SSD,还树立了混合读写QoS的标杆。

得益于基础性能的大幅度提升,相应的,D7-PS1010的混合读写IOPS是P5520的两倍以上。

PS1010的平均时延也明显改进:在队列深度达到32时只有100微秒;队列128时,不超过200微秒;即使队列达到512,也才600微秒。

不论是P99,还是P99.95,PS1010的平均读时延相对P5520全面领先。

P5520的P99.99读时延是上一个时代的神话,中等队列可以控制在1毫秒之内。PS1010在中等队列没有简单地重演神话,它在中小队列时的P99.99时延与P5520接近,但在中等队列的时延差距加大,但在大队列(64以上)的读时延增长相对平缓,即使在512队列深度之下,P99.99读时延也只有2.25毫秒而已。

数据库:超高负荷

Aerospike是一个典型的分布式数据库应用,可满足TB级数据量、万级以上高并发请求,可以对SSD构成很重的混合读写压力。其ACT(Aerospike Certification Tool:Aerospike认证工具 )测试中是采用2:1的混合读写配置,负荷采用倍数形式体现。其中1x代表2000个读事务请求和1000个写入。每个操作以1.5KB对象为单位,对于没有整形/压缩的SSD而言,相当于一次默认页面大小的随机访问。

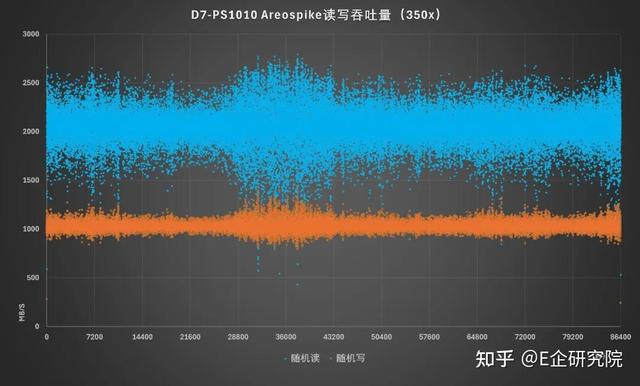

我们使用ACT v6.5进行测试,D7-PS1010 7.68TB可以完成持续24小时350x压力的验证。这意味着以每秒对数据库发出70万条读请求和35万条写请求,也就是每秒百万级以上的2:1混合随机读写。

从8万多秒(24小时)的log看,D7-PS1010在跑350x压力时的波动还是挺剧烈的,有点儿极限操作的味道了。但即使在这样高的压力下,PS1010的平均响应时间大于1毫秒但小于2毫秒的请求占比仅为3.13%,时延超过8毫秒的请求仅为万分之七,没有大于16毫秒的请求。说明可以保证良好的响应能力,以提供稳定的业务支持。

如果觉得350x太狠了,实际应用当中也可以控制一下负载。譬如将ACT压力换为300x,D7-PS1010的表现会立刻平稳得如同一条直线,大于1毫秒的请求只有千分之五,大于2毫秒的只有万分之五,大于4毫秒的只有万分之一。

350x的设置让我们让2:1混合读写突破百万级。这是什么概念?PCIe 4.0时代主流SSD在发展到中后期,随机读性能才逐步达到了百万级,遑论混合读写了。以D7-P5520 7.68TB为例,它发布之初验证的是150x的ACT测试。这意味着到了D7-PS1010这一代,已经可以处理两倍以上的数据库负载,前面说的“一个顶俩”确实真的可行。

除了纵比,我们也可以横比:目前Areospike官网已经测试过的“PCIe/NVMe-Based Flash”中,还没有出现常规的标准耐用度(1DWPD)的SSD能达到这个负荷。TPS能够超过D7-PS1010的两款SSD,要么是大容量、中等耐用度(3DWPD)的,要么就是计算型存储可以压缩数据。

说到这里,那要让D7-PS1010的战斗力再上一个台阶,那就不妨打打容量或者DWPD的主意。

彩蛋时间:用20%容量换200%性能

Solidigm D7-PS1010是标准耐用度,即1DWPD的SSD。如果我们想要冲击更高的负荷,换PS1030上场就是了,它是中等耐用度,3DWPD的SSD。

熟悉Solidigm产品线,或者看过我们以往测试的读者,应该知道Solidigm提供了一个强大的管理工具:Solidigm Storage Tool(SST)。使用SST的命令行界面,我们可以调整Solidigm SSD的保留空间。

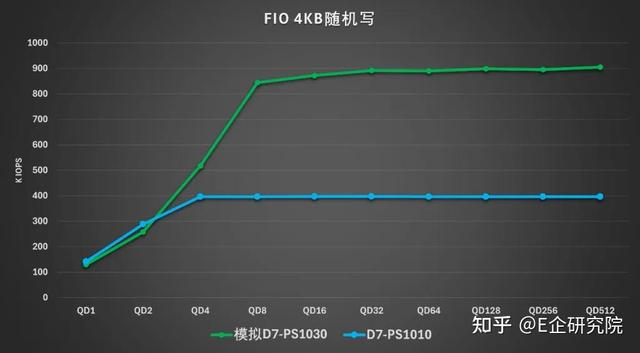

譬如我们用SST 2.0对Solidigm D7-PS1010 7.68TB进行调整,设置MaximumLBA=80%,额外增加20%的保留空间,可用容量降到6.14TB,近似于D7-PS1030的规格。

模拟的“D7-PS1030”的顺序读写和随机读性能与PS1010基本一致,随机写性能大幅度提升,从后者的约40万IOPS猛增至90万IOPS。这种变化符合我们的经验,更多的保留空间可以提升SSD的随机写性能和耐用度。由于保留的空间更多,这个模拟的“D7-PS1030”的实测性能还略高于D7-PS1030的官方标称值。

增有余的随机写性能对混合读写测试也带来了显著的影响。在FIO的7:3混合读写测试中,“D7-PS1030”的表现明显改善,譬如随机读从PS1010的65万IOPS提升至超过120万,近乎翻倍。

“D7-PS1030”在7:3混合读写当中的总IOPS已经超过了170万。这是一个里程碑式的成绩。单看数字,可能大家对我们测得的这个混合读写性能没啥直观的概念。但如果我告诉你:末代的傲腾的7:3混合读写是180万IOPS——是不是很容易理解了?随着NAND介质、控制器的发展,优秀的数据中心/企业级TLC SSD已经可以告慰先烈了。

读时延也明显改善,在512队列深度时,“D7-PS1030”的平均时延大概是PS1010的三分之一,P99和P99.99也始终保持优势。

在Areospike中,“D7-PS1030”可以很轻松的完成24小时500x的测试,延迟表现极其稳定,大于1毫秒的事务仅有0.26%,远远低于5%的要求;大于2毫秒的仅有0.02%;没有延迟大于4毫秒的访问。从ACT 500x的log可见,这24小时的表现波动幅度确实轻微,只有零星的离散点。

500x已经在常规SSD中一骑绝尘,我们还进一步尝试了更高的负荷:1小时的550x压力下,大于1毫秒的仅为0.60%;560x下,大于1毫秒的也仅为0.76%,大于2毫秒的仅为0.03%。不过在我们没能完成持续24小时560x负荷的测试,在第六小时中断了。前五小时中每小时的平均时延均在0.75%到0.76%之间。如此微小的波动却不一定能够确保完成24小时ACT测试,也从侧面说明Areospike的压力确实够分量。

值得一提的是,500x的负荷也是可以和傲腾扳手腕的,这个水平已经超过了PCIe 3.0时代的3D Xpoint技术SSD,并接近PCIe 4.0时代的产品。回想文章开头我们提到的CSAL,再结合目前模拟D7-PS1030的测试数据,我们确实可以相信新一代高性能TLC SSD的随机写性能已经不再是写缓冲的瓶颈,而且,TLC SSD的大容量和读性能的优势还有机会拉高整体表现。

结语:好马急需好鞍

服务器处理器正在进入百核时代。算力密度的激增之下,存储性能也应该有相应的增长。Solidigm D7-PS1010的性能相对上一代产品翻倍,完全跟上了“核”战的节奏。

对于大企业、云服务商等,新一代SSD可以在更小的空间内,提供双倍以上的性能,仅付出不到30%的功耗增长,很有利于提高部署密度、降低TCO。

至于目前大火的人工智能等应用,PS1010的领先性能尤其受到重视,毕竟GPU时间成本昂贵,不论数据投喂还是Checkpoint存储,千金难买寸光阴。这也是这两年人工智能成为存储市场最重要业务增长点的根本原因。

模拟PS1030的性能让我们对TLC SSD的发展颇感振奋。傲腾和SLC这些技术为代表的SCM产品不但成本高,还面临市场规模小、迭代缓慢的问题,其性能优势正在被逐步赶上。TLC SSD已经坐稳存储阵列的性能层,随着CXL技术的加持,TLC NAND还有能力出现在内存语义SSD当中,成为内存池的一部分。