最近DeepSeek太火爆了,很多小伙伴们无论是网页版或者APP都体验了一把,在惊艳其功能强大的同时,相信很多小伙伴也被「服务器繁忙,请稍后再试。」弄的举足无措吧。

我不知道别人经历了什么,我是一遍又一遍的试,结果还是这样。

开始是晚上不能用,早晨还可以,后来就是偶尔能成功一次。

好烦人啊

于是我查找原因,据说是一方面是国外黑客太猖狂了,令一方面是用户暴增引起的。

于是我在我的MAC上对DeepSeek-R1做了本地部署,还好基本上可以使用,不过电脑的版本有点低只部署了8b的版本,听说官网是671B的版本。

也许是好奇心使然吧,于是我找到了个平替的方案,就是通过ChatBox接入DeepSeekAPI的方式,接入API是有费用的,不过这平替的方案里基本上可以免费用好长时间,其中一个是送1200W token,一个送50W token,相信这轮羊毛用完,官网能恢复到正常使用状态了吧。

下面解释具体的操作步骤:

前提硬件环境: Mac M1 内存 16G

我的电脑是Mac M1,以下的说明都是基于Mac M1进行的,不过这些软件都是支持多平台安装的。

下载 ChatBox

打开ChatBox 中文官网

注意:Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。

选择 相应版本

然后进入下载提示页面,不过这个提示有很假,下载完后还是这样,如果你登录很长时间,不妨去下载目录看看是不是已经下载完成。

下载完后,安装提示安装即可,很快就安装完了。

安装完后,打开页面。可以选择一种打开方式

我选择的是「使用自己的 API Key或本地模型」

通过ollama 配置本地DeepSeek模型

点击左侧「设置」进行配置

在模型tab页面,模型提供方选择「OLLAMA API」,API域名默认为本地,因为我在电脑上已经安装了OllaMa,这个也可以选择其他互联网上的域名。

模型选择「deepseek-r1:8b」。

关于本地部署 DeepSeek和Ollama的操作,可以参考我的另一篇文章「基于 DeepSeeK R1 + Ollama + AnythingLLM 在MAC M1 构建本地知识库问答」

配置完后点保存就可以对话了。不过要注意对话提供的一些功能,这些功能可以辅助你得到更有价值的答案。

硅基流动API接入ChatBox

1)注册登录账户和模型选择

打开硅基流动的官网,点右上角登陆(login)

在模型广场这里找到这个deepseek的r1,注意,一定选择下面标记【671B】的,这个是和DeepSeek官网一样的模型

收费标准是

4块钱/百万token输入,16块钱/百万token输出

不过新用户注册时候就送 2000万 token,能用好久。

注册的时候要填写邀请码,可以填 KQhzlKxX ,这样你我各获得2000万token

2)生成密钥,点击左侧的「API 密钥」

创建 API 密钥

点击复制密钥

打开ChatBox 进行设置

点击左侧「设置」

按照下图设置即可

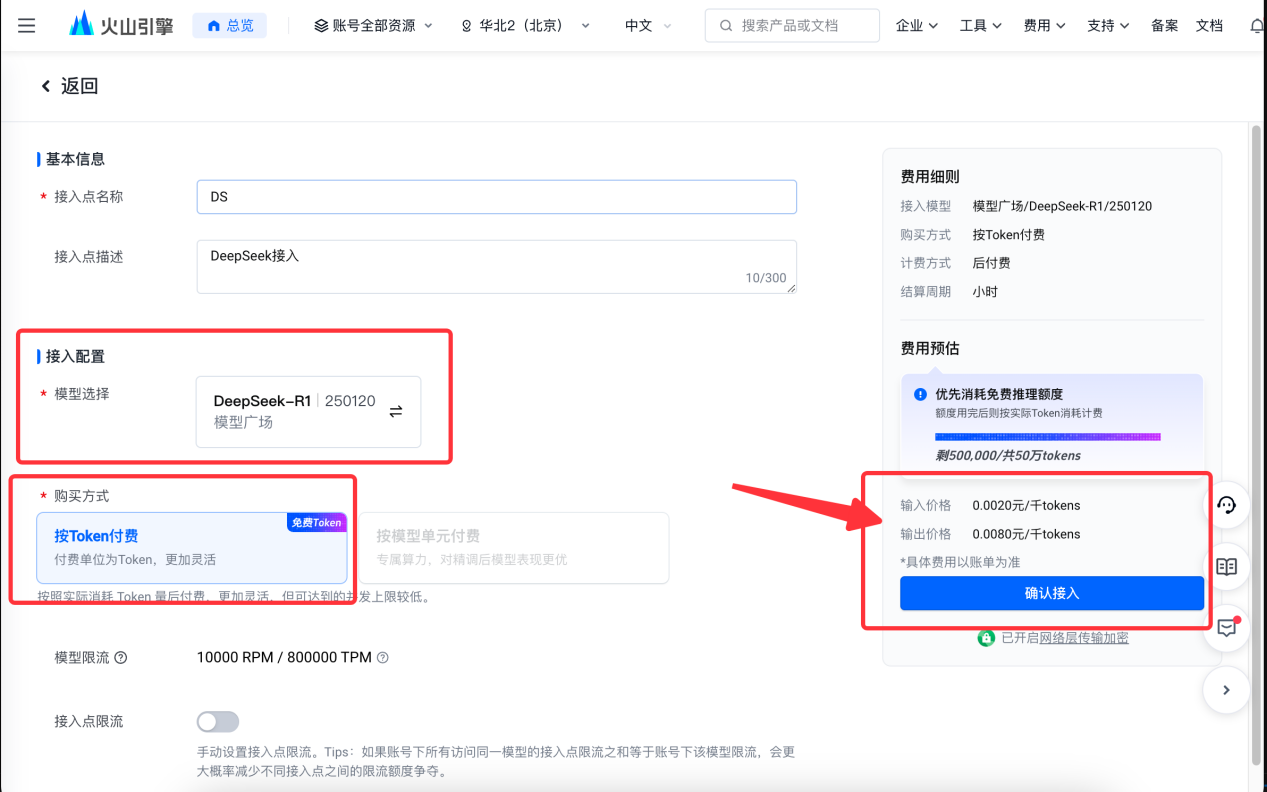

火山方舟api接入ChatBox

火山方舟是字节提供的,不过接入是相对比较繁琐了,不过这也是一个门槛,在其他家都不能用的时候,这个也是一个不错的选择。

1)生成api密钥

打开模型广场

https://console.volcengine.com/ark/region:ark+cn-beijing/model?vendor=Bytedance&view=LIST_VIEW ,需要注册账户

这里有个好消息就是,每个新注册的用户都送50万个tokens,不是1个模型,而是所有模型。

打开左侧的「在线推理」

点击「创建推理接入点」,按照下图进行选择,然后点「确定」

点击「立即开通」

这里需要实名认证,可以通过企业或个人认证,这里选择「个人认证」即可

选择第一个微信人脸识别认证即可,认证完后,继续配置

然后点「确认接入」,创建完后点「API调用」

点「选择API Key 并复制」

创建完后,点击复制

打开ChatBox 设置

模型,复制下图ID填入

最后点保存,即可使用。

其实百度也提供相应的方法,但是它封了我的百家号,大家如果有兴趣也可以去了解一下。

直接用kimi

这时得提醒用户防止电诈了