最近DeepSeek 比较火爆,这两天查阅资料,动手在自己的 MAC M1 上部署了一个本地知识库系统。

硬件环境: Mac M1 内存 16G

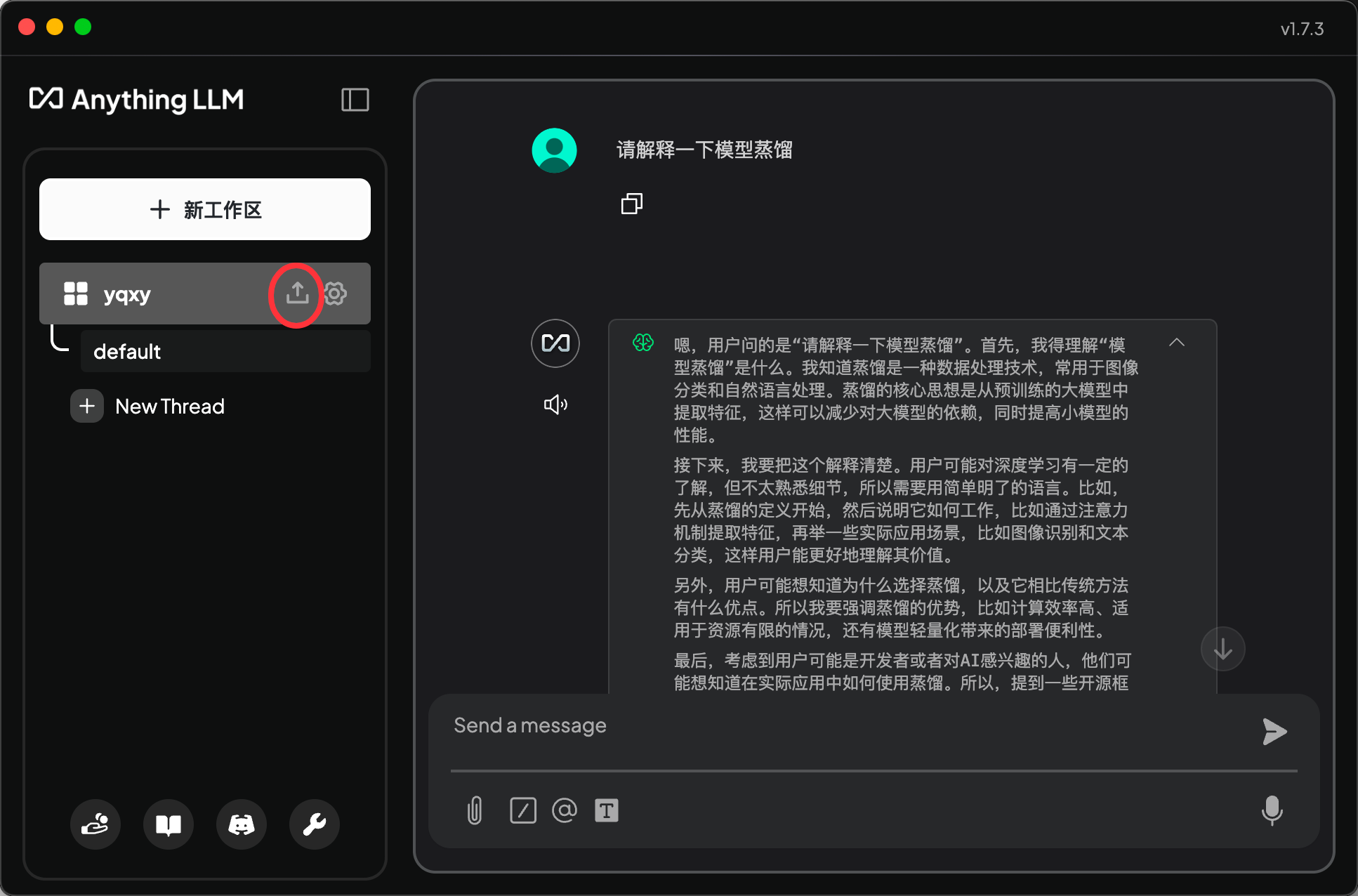

使用软件环境:ollama + DeepSeek R1-8b + AnythingLLM

下载 ollama 地址 https://ollama.com/

下载完后是一个zip文件,双击解压(如果没有解压软件,需要先安装解压软件),解压完后,如下,双击Ollama

以下就是按照提示操作即可

安装完后

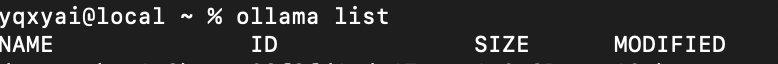

命令行输入ollama list,出现 NAME ID 下面什么也没有就可以了,表示已经安装成功,因为没有模型,所以下面什么也没有

2、本地化部署 deepseek-r1

命令行

ollama run deepseek-r1:8b

【deepseek-r1:8b 是我电脑部署的版本,也可以根据电脑的配置选择其他的版本】

运行完后,看到【success】字样。

你可以和它交流一下,比如我,输入了【hello】,得到了一个回复

安装完 DeepSeek 模型后,再从命令行输入 ollama list 就可以看到刚才的模型了

3、安装 Anything LLM

Anything LLM 是一款集成度非常高、且功能非常稳定的大模型前端产品,虽无法进行二次开发,但是功能实现便捷,适合小白使用。

下载地址

https://anythingllm.com

下载完后,按照提示安装即可

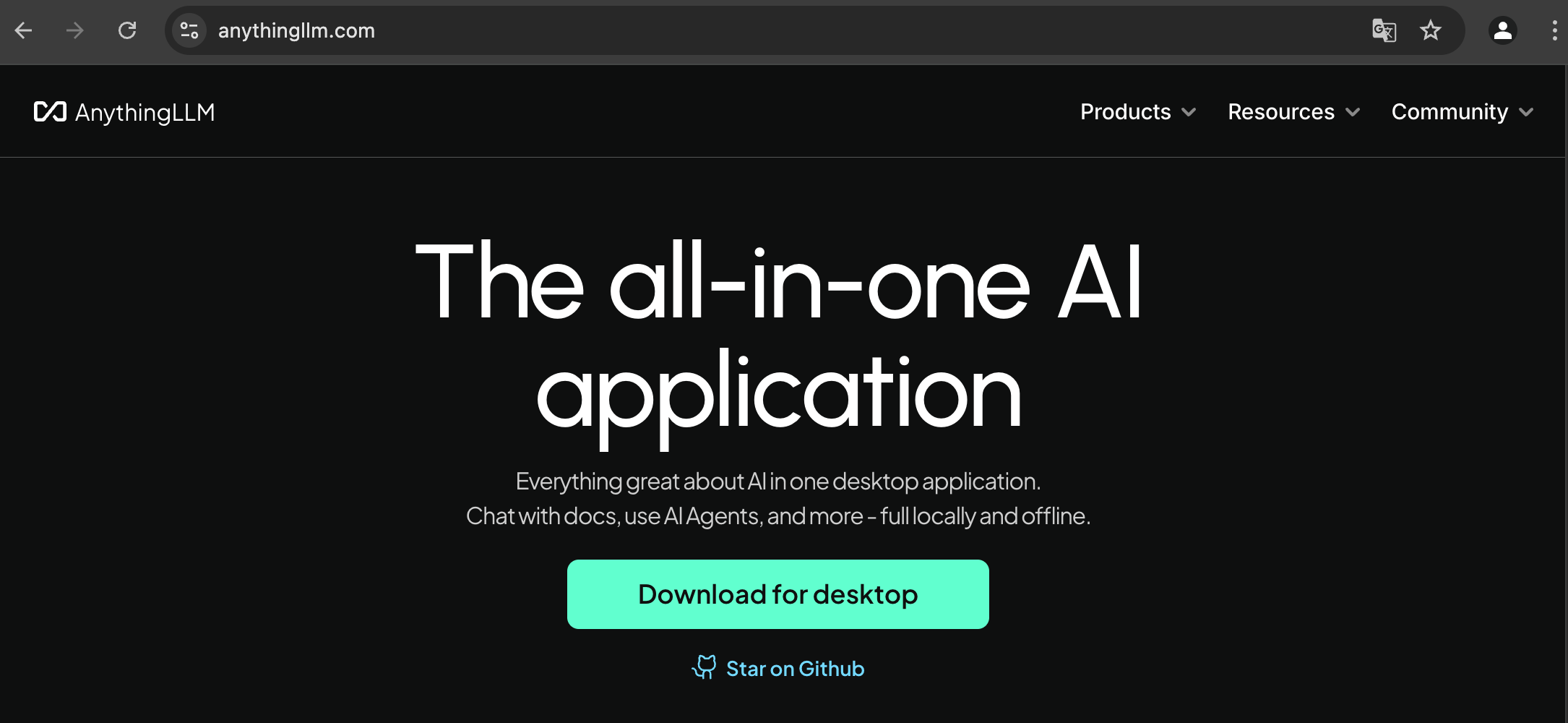

安装完后后进入设置页面,具体操作可以参考下图

点击右侧箭头

对话模型:负责完成对话任务,由ollama调度 DeepSeek 完成对话

Embedding 模型:负责进行词向量化的模型

词向量数据库:用于存储词向量化后的对象,默认为LancelotDB

对于任何本地知识库问答的过程,都需要经历文本切割、词向量化、词向量存储、词向量检索与问答几个基本环节。

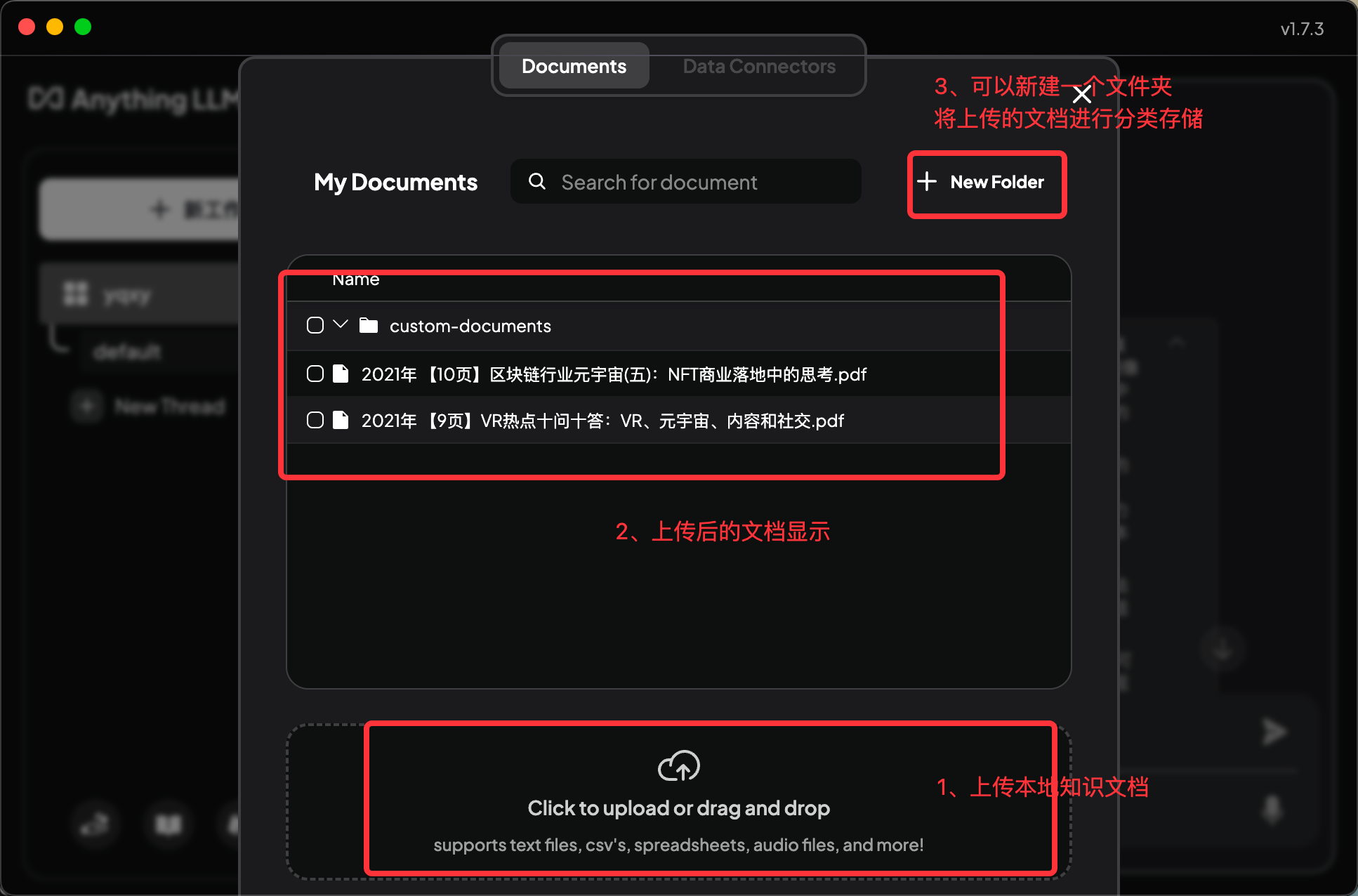

关于基于私有知识库的问答,可以上传文档后进行提问,传入的是本次对话当中。

如果想,将本地文档持久化到问答中,可以从工作区进行上传,以后每次提问都会优先根据本地上传的文档进行回答

选择选择文档,【Move to Workspace】按钮就会出现,然后点击【Move to Workspace】按钮,文档就会出现在右边的工作区中,然后【Save and Embed】完成关联,你可以传很多个文档进来。这就完成了长文档的切分,知识库持久化的存储。

会有一个等待时间

之后出现,点击文档右边的图钉按钮,将这个文档关联到当前会话中,这个是有选择的。

然后就可以返回对话页面进行聊天了。

至此,简单的在Mac M1 上部署本地知识库系统完毕