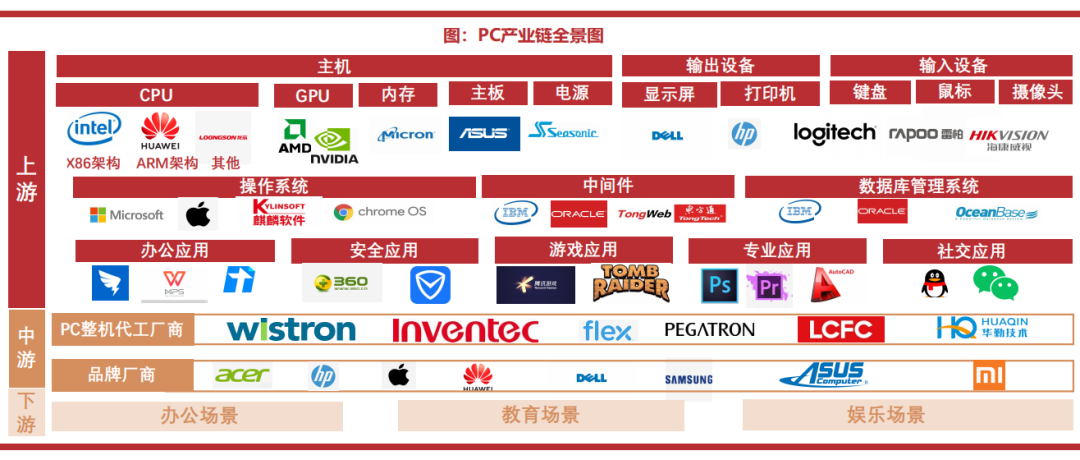

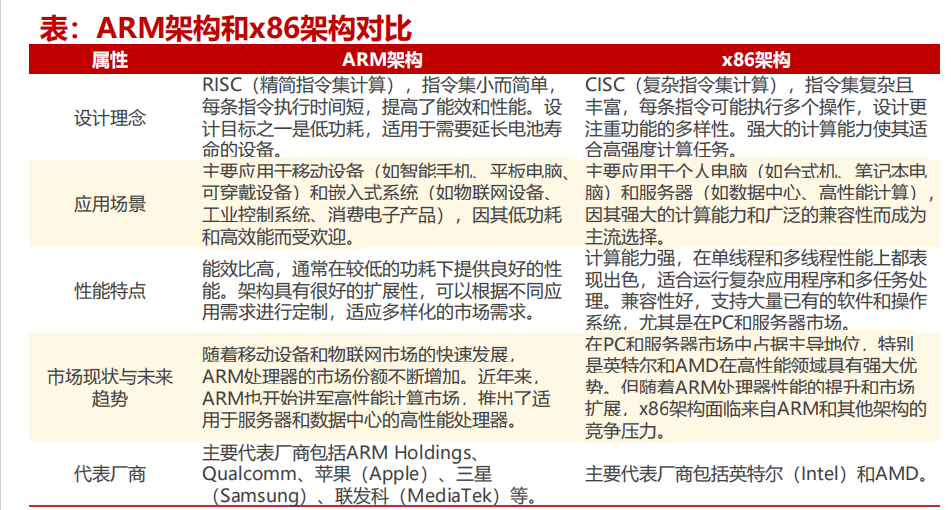

AI进化加速端侧落地,新一轮浪潮蓄势待发(2024)”。ARM(Advanced RISC Machine)架构和x86架构是两种主要的处理器架构,它们在设计理念、应用场景和性能特点等方面有显著的差异。

ARM架构是一种精简指令集计算机(RISC)架构,它具有低功耗、小尺寸、高性能、高集成度等特点,适用于移动设备、物联网等场景。而x86架构则是一种复杂指令集计算机(CISC)架构,它具有高性能、大缓存、多核心等特点,适用于PC服务器等场景。

ARM架构和x86架构都是计算机领域中常用的指令集架构。ARM架构追求指令集的简化,每条指令执行速度快,能够在较低功耗下高效工作。这种设计理念使得ARM架构适用于电池供电设备,强调节能和高效。而x86架构则包含复杂的指令集,能够在一条指令中执行更多的操作。这种设计理念使得x86架构适用于需要高计算能力的设备,强调性能和灵活性。

ARM架构在移动和嵌入式领域凭借高能效与低功耗优势独领风骚,而x86架构则在桌面和服务器市场凭借卓越性能及丰富的软件生态系称霸一方。

1、ARM架构因其低功耗的特点份额有望逐步提升

ARM架构的卓越低功耗特性源于多种设计要素的协同作用,如简洁的指令集、精简的硬件实现、高效的流水线布局、低功耗模式、较少的晶体管数量、专用处理单元的应用以及专为嵌入式系统和移动设备优化的技术。这些独特设计特点赋予ARM处理器在追求低功耗的各类应用场景中脱颖而出的能力。

在AIPC领域,ARM架构以卓越的能效比脱颖而出,为AI计算提供高效且低能耗的解决方案。其高度定制化特性使芯片设计者能够根据特定需求优化硬件架构,确保在各种AI应用场景中实现最优性能。

苹果由x86架构转向ARM架构收获成功,是其市场份额上升的关键因素之一

2020年,苹果在技术领域的一次重大转变引发了业界的广泛关注。这一年,苹果从长期使用的x86架构CPU转向了ARM架构CPU,推出了M系列芯片。11月10日,苹果正式发布了首款自研芯片M1,并将其应用在了MacBook Air、Mac Mini、MacBook Pro(13英寸,2020年款)、iMac、iPad Pro以及iPad Air(第五代)等产品上。这一举措标志着苹果正式告别英特尔处理器,踏上了自主研发芯片的道路,无疑为公司的未来发展开启了新的篇章,也成为了重要的技术里程碑。

苹果宣称该芯片在所有低功耗中央处理器产品中性能最佳,同时具有最佳的性能功耗比。

苹果MacOS市场份额提升,有部分原因可能是M系列芯片高能低耗对于其mac产品销量的拉动。根据statcounter数据,2018年MacOS在PC操作系统的占比仅为12.84%,2023年提升至18.71%,而windows操作系统市场份额则从2018年的80.36%下降至2023年的68.28%,根据苹果公司公告数据,2020年四季度推出ARM架构的M芯片后,其mac产品线销售收入在1Q21环比上涨5%,同比上涨70%,增速显著高于全球PC销量的增速。

Rosetta 2确保苹果从x86架构转向ARM架构的过渡期平稳度过

苹果在转向ARM架构时,面临确保应用兼容性和性能的挑战。需兼顾硬件设计、操作系统优化、用户体验、生态系统整合和市场竞争等多方面因素。

Rosetta 2使得macx86架构转向ARM架构平稳过渡。由于当时大量现有的Mac应用程序是为x86架构编写的,为了确保现有的x86应用能够在ARM架构的Mac上运行,苹果推出了Rosetta 2翻译层。Rosetta 2在运行时将x86指令翻译为ARM指令。这种翻译是动态进行的,意味着应用程序在启动和运行时,Rosetta 2会实时进行指令翻译,从而确保兼容性,对于用户而言,Rosetta 2的运行是透明的。

用户不需要进行任何额外的操作即可运行他们现有的x86应用程序,只需像往常一样打开应用程序即可。使用Rosetta 2翻译的应用程序与原生运行在x86设备上的体验几乎没有区别。这种无缝体验是苹果致力于确保过渡期间用户不会感受到明显差异的重要组成部分。

ARM架构助力苹果生态的一致性和无缝协同。为确保苹果产品生态系统的一致性和连贯性,新加入的ARM架构设备能与现有iPhone、iPad及Mac设备顺畅协作。开发者亦能轻松地在iOS与macOS平台间移植应用,进一步强化苹果生态系统的集成与协同。

微软逐步完善ARM架构的生态系统

2021年微软推出了ARM64EC,可以将基于X86的应用程序代码转移到基于ARM的代码上,ARM64EC可以看作是连接 x86 和 ARM架构的重要桥梁,它通过提供兼容性和优化性能,促进了两种架构之间的互操作性和协同发展。

ARM64EC是一种应用二进制接口(ABI),旨在促进在ARM系统上运行x64应用程序的兼容性。这使得x64应用程序在WOA(Windows on ARM)设备上能够更高效地运行,实现原生执行ARM代码。为了使 ARM 设备能够运行 x86 应用程序,微软引入了 ARM64EC。ARM64EC 允许开发者将现有的x64(即 x86-64)应用程序部分或全部移植到 ARM 平台上,而无需完全重写代码。通过支持 x86 应用程序,ARM64EC 使得 ARM 设备(如基于 ARM 的 Windows 笔记本电脑和平板电脑)能够运行更多的现有软件,从而扩大了这些设备的应用范围和吸引力。

"基于ARM架构的软件逐步推向市场,其中Windows on ARM已拥有87%的原生应用份额,仅剩13%需兼容层转译。"

在2023年,高通骁龙X系列问世之际,它与众多应用开发商展开了紧密合作。到了2024年3月,谷歌也推出了原生版的完整Chrome浏览器,支持在搭载高通骁龙技术的Windows PC上下载和使用。

ARM架构市场份额有望逐年上涨,高通+微软联手发力WOA

据Counterpoint Research预测,到2027年,ARM架构笔记本市场份额将攀升至25%。

根据前瞻分析,当前ARM笔记本电脑主要由苹果提供,搭载MacOS操作系统,而微软的Windows操作系统依然是最受欢迎的选择。然而,过去ARM市场份额未能显著提高的主要障碍是Windows操作系统应用程序与ARM架构的兼容性问题。值得注意的是,这一问题正逐步得到解决。

高通+微软联手发力推动WOA,Copilot+PC的推出可能是WOA的重要转折点。在Build 2024开发者大会前夕,5月20日微软发布了自家最新的“Copilot+PC”, 是专为 AI 设计的新型 Windows PC,有望开启Windows on ARM新时代。其他各大品牌同步推出Copilot+PC。微软不仅自己推出全新的Copilot+ PC,同时与各大 OEM 厂商(宏碁、华硕、戴尔、惠普、联想、三星)合作全新 Copilot+PC,于 6 月 18 日开始上市。

2、异构计算成为AIPC新品主流,引入NPU成为关键

引入NPU对于提升计算效率、降低能耗与成本具有重要意义。

NPU是专门为神经网络计算设计的,能够高效处理大量并行计算任务,显著提高AI应用的性能。例如,在图像识别、自然语言处理和自动驾驶等领域,NPU可以加速训练和推理过程 。

NPU(神经网络处理器)与通用处理器(如CPU、GPU)相比,具有更高的能效比,这对于移动设备和嵌入式系统尤为重要,因为这些设备对功耗和电池寿命有严格的要求。相较于中央处理单元(CPU)和图形处理单元(GPU),NPU从硬件层面对AI计算进行了专门优化,旨在提高处理性能和能效。NPU的设计目标是高效、低功耗地执行机器学习,特别是深度学习任务。

现代NPU通常采用可重构设计,能够适应不同的AI模型和算法。这种灵活性使得NPU可以在不同应用场景中高效运行,满足多样化的计算需求。

AIPC处理器异构计算成为共性,增加NPU本质是为了进行低功耗计算

在硬件领域,英特尔、高通和AMD新一代AI加速处理器均采用“CPU+GPU+NPU”的异构架构。这种创新设计相较于传统CPU+GPU架构,增加了专门用于处理人工神经网络计算的NPU,从而实现了更快速、高效且强大的边缘AI模型推理。

2023年12月英特尔推出首款面向AI PC的Meteor Lake酷睿Ultra处理器。

酷睿Ultra处理器采用分离式模块架构,由四个独立的模块组成,并通过Foveros 3D封装技术连接。其计算模块首次采用Intel 4制程工艺打造,带有基于Redwood Cove架构的P-Core和基于Crestmont架构的E-Core;核显采用了全新的Alchemist Xe-LPG设计;SOC模块里面包含了2个全新的LP E-Core,用于新型低功耗负载,进一步优化节能与性能间的平衡。同时酷睿Ultra处理器还采用了英特尔首个用于客户端的片上AI加速器“神经网络处理单元(NPU)”,将高能效AI加速提升到了新的高度,带来2.5倍于上一代产品的能效表现。

根据公司官网信息,intel计划将在 2025 年之前在超过 1 亿台 PC 上实现人工智能 。

2024年6月,Intel正式发布下一代面向AIPC的移动处理器Lunar Lake,综合算力达到120TOPS,NPU算力达到48TOPS,同时能耗大幅降低。

Lunar Lake处理器AI总算力达到120TOPS,其中CPU可提供5 TOPS的算力,驱动轻度AI工作;GPU提供67 TOPS算力提供游戏与创作所需的AI性能;NPU提供48 TOPS算力能够提供AI辅助与创作等功能。经过重新设计,为 x86 的能效设定了新的标准,lunar lake再供电和电源管理方面大幅改进,采用更先进的工艺节点,相较上一代meteor lake能耗降低40%。目前Lunar Lake已有来自20家OEM厂商,超过80款设计,预计第三季度开始出货。

在AI应用方面,英特尔ultra处理器性能显著提升,较上一代性能提升70%,同时也领先AMD上一代产品。

根据英特尔公布的对比数据显示,与英特尔Core i7-1370P相比,Core Ultra 7 165H的Generative AI(生成式AI)性能提高了70%;与AMD Ryzen 7 7840U相比,英特尔Core Ultra 7 165H在GIMP Stable Diffusion性能方面提高了5.4倍,在Stable Difference A1111性能方面提高了3.2倍,在Adobe Premier Pro(ColorGrade+场景编辑+导出)方面提高了1.7倍,在Adobe Lightroom Classic(AI照片编辑)方面提高了1.5倍,DaVinci Resolve(渲染+AI遮罩+导出)的性能提高了1.2倍,Wondershare Filmora(A1FX+预览+导出)性能提高了1.1倍。

Ultra系列产品在性能大幅提升的同时,功耗也得到了显著降低。与英特尔Core i7-1370P相比,Core Ultra 7 165H在Zoom视频会议中可降低38%的功耗;在空闲模式下,相较于AMD Ryzen 7 7840U,英特尔Core Ultra 7165H的功耗低了79%。当功率突破20W后,其运行速度比苹果M3更快。

Ultra系列功耗的下降核心在于其采用Tile分离模块设计,将中高功耗、低功耗、超低功耗、GPU等负载场景和运算模块分成了不同的Tile。在低功耗场景可以让NPU或者LPE单独承载,CPU和GPU降频或者基本静置,大幅降低功耗。英特尔酷睿Ultra采用全新的3D高性能混合架构,由性能核(P-Core)、能效核(E-Core)和低功耗能效核(LP E-Core)组成。这种设计允许处理器根据不同的应用场景智能地调节核心的活动状态。

Ultra系列功耗的下降核心在于其采用Tile分离模块设计,将中高功耗、低功耗、超低功耗、GPU等负载场景和运算模块分成了不同的Tile。在低功耗场景可以让NPU或者LPE单独承载,CPU和GPU降频或者基本静置,大幅降低功耗。英特尔酷睿Ultra采用全新的3D高性能混合架构,由性能核(P-Core)、能效核(E-Core)和低功耗能效核(LP E-Core)组成。这种设计允许处理器根据不同的应用场景智能地调节核心的活动状态 。

AIPC处理器异构计算成为共性,增加NPU本质是为了进行低功耗计算

生成式AI用例需求不断增加,促使专业定制的全新计算架构诞生。这款架构首先采用面向生成式AI设计的神经网络处理器(NPU),并通过搭配中央处理器(CPU)和图形处理器(GPU)等异构处理器,实现最佳性能、能效和电池续航。

NPU专为实现以低功耗加速AI推理而全新打造,并随着新AI用例、模型和需求的发展不断演进。根据高通《通过NPU和异构计算开启终端侧生成式AI》,在2015年,早期NPU面向音频和语音AI用例而设计,这些用例基于简单卷积神经网络并且主要需要标量和向量数学运算;2016年开始,拍照和视频AI用例大受欢迎,出现了基于transformer、循环神经网络、长短期记忆网络和更高维度的卷积神经网络等更复杂的全新模型,这些工作需要大量张量数学运算,因此NPU增加了张量加速器和卷积加速,大幅提升处理效率;2023年,LLM、LVM赋能的生成式AI使得典型模型的大小超过了一个数量级,因此还需要重点考虑内存和系统设计,通过减少内存数据传输以提高性能和能效。

3、大模型落地端侧提升设备对于内存的需求

内存对AI PC至关重要,影响整体性能及AI任务实现。随着模型增大且复杂度提高,AI PC需更高内存容量。

在PC市场,微软推出的Copilot+PC硬件要求最低16GB DDR5/LPDDR5内存和256GB SSD/UFS存储设备。预计AI PC将推动PC平均搭载容量的提升。根据集邦咨询预测,DRAM笔记本单机平均搭载容量年增长率约为12.4%,随着AI PC的量产,2025年的增幅将更为显著。

随着手机代际AI升级,DRAM需求有望迎来爆发式增长。尽管人工智能(AI)已融入智能手机功能多年,但在高端设备中实施改良的大型语言模型(LLM)可能会导致对DRAM需求的上升,并加速最小NAND存储容量的淘汰。据YOLE预测,到2023年,高端智能手机的平均DRAM容量将达到9GB,而随着制造商开始整合基于生成式AI的功能,到2024年,内容将接近10GB。

- 模型即服务(MaaS)是一种新型服务模式,通过将AI模型及其相关能力封装成服务,旨在降低技术使用门槛、控制成本并简化系统运维管理,从而推动“人工智能+”进程。

-对此,您有什么看法见解?-

-欢迎在评论区留言探讨和分享。-