2025年伊始,中国AI界传来捷报,DeepSeek应用强势登顶美国手机应用商店,下载量力压ChatGPT,

其创始人梁文锋一时风头无两,被海外誉为“来自东方的神秘力量”。

这款来自广东湛江的AI应用,在短短两年内便搅动了全球市场,成为业界瞩目的焦点。

甚至连Meta这样的巨头也开始对其进行研究,试图从中汲取经验。

DeepSeek-V3版本的问世更是锦上添花,其通过巧妙的优化策略,例如选择性激活模型部分、降低计算精度但不影响结果等,大幅降低了训练成本,并凭借其优秀的性能,例如能根据用户祖母的原型创作故事并给予温暖安慰,赢得了用户的广泛赞誉。

然而,就在DeepSeek享受成功的喜悦之时,一个新的挑战者悄然出现,它以低廉的成本和不俗的性能,给DeepSeek的光环蒙上了一层阴影。

这场风暴的中心,是一位华裔女院士——斯坦福大学计算机科学系的李飞飞教授。

她带领的团队以令人难以置信的低成本——不到50美元,成功复刻了一款AI推理模型,名为s1。

消息一出,便在AI领域引发了巨大的震动。

50美元,或许只够一顿普通的晚餐,却足以打造一个性能堪比业界顶尖水平的AI模型,这在以往是难以想象的。

那么这到底是一种颠覆性的创新,还是昙花一现的巧合呢?

要解答这些疑问,我们首先需要了解s1模型背后的技术细节。

与传统的“砸钱”式AI模型开发不同,s1模型的成功并非依赖于庞大的算力和海量的数据,而是依靠巧妙的算法设计和策略优化。

具体来说,s1模型基于开源的Qwen2.5-32B-Instruct模型,并利用一种被称为“蒸馏”的技术进行训练。

这项技术就好比是从一坛陈年佳酿中提取精华,将其浓缩成一小瓶精粹。

s1团队首先构建了一个名为s1K的小型数据集,其中仅包含1000个精心挑选的问题和答案,并附带了模型的推理过程,类似于解题步骤。

这些问题涵盖了数学竞赛、博士级别科学问题、奥林匹克竞赛问题等高难度领域,保证了数据集的质量和多样性。

然后,团队利用谷歌的Gemini Flash Thinking模型为这些问题生成推理轨迹和答案,以此来训练s1模型。

整个训练过程仅使用了16台英伟达H100GPU,耗时26分钟,成本低廉得令人咋舌。

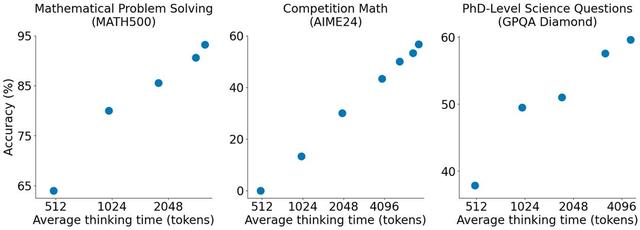

除了“蒸馏”技术和s1K数据集外,s1团队还采用了一种名为“预算强制”的策略来进一步优化模型性能。

这项策略就好比是给模型设定了一个“思考时间限制”,如果模型在规定的时间内没有完成推理,则强制终止并给出答案;

如果模型需要更长的思考时间,则通过添加“等待”指令来延长推理过程。

这种策略可以有效控制模型的计算量,并在保证性能的前提下降低成本。

于是乎,s1模型以其低成本和高性能迅速吸引了业界的关注,不少人将其视为Open AI o1和DeepSeek R1等顶级模型的强劲竞争对手。

然而,事实真相真是如此吗?

要评估s1模型的性能,我们需要将其与其他顶尖模型进行比较。

s1团队在AIME 24和MATH 500等数学竞赛数据集上对s1模型进行了测试,并将结果与Open AI o1、Open AI o1-preview和Deep Seek R1等模型进行了对比。

结果显示,s1模型在特定数据集上的表现可以媲美甚至超越o1-preview,尤其是在团队精心挑选的数据集上,s1展现出了强大的竞争力。

然而,s1模型与o1正式版和Deep SeekR1的差距仍然较为明显,特别是在更广泛的测试集上。

这种结果引发了一些争议。

一部分人认为,s1模型的成功并非完全依赖于其自身的技术创新,而是受益于对测试数据的精心挑选和对测试时间的巧妙控制。

例如,s1团队采用的“预算强制”策略,通过强制延长模型的思考时间,使其有机会进行更深入的推理,从而提高了在特定任务上的表现。

这就好比在考试中,给一些学生额外的时间来思考和检查,他们的成绩自然会更好。

因此,s1模型的优异表现并不能完全代表其在实际应用中的真实能力。

此外,s1模型的“蒸馏”方法也受到了质疑。

一部分人认为,这种方法本质上是利用Gemini模型生成数据,然后用这些数据对Qwen模型进行微调,并不能称之为真正的“蒸馏”。

真正的“蒸馏”应该是将大模型的知识迁移到小模型,而不是简单地使用大模型生成的数据进行训练。

因此,s1模型的成功在一定程度上依赖于Gemini模型,而并非完全依靠自身的创新。

另一个值得关注的模型是LIMO。

LIMO同样基于Qwen2.5-32B模型,并通过极少数数据示例来激发模型的数学推理能力。

在AIME和MATH基准测试中,LIMO仅使用了817个训练样本,就取得了令人瞩目的成绩,准确率分别达到了57.1%和94.8%。

LIMO的成功表明,通过精心设计的数据集和训练策略,即使是小规模的数据也能取得显著的成果。

尽管s1模型的性能与顶级模型仍有差距,但其低成本的特性和在特定任务上的出色表现仍然具有重要的意义。

s1模型的出现挑战了传统的AI模型开发范式,即依靠堆叠算力和数据来提升性能。

它证明了,通过巧妙的算法设计和策略优化,即使是小规模的算力和数据也能取得令人瞩目的成果。

这就好比在武术中,以“巧劲”胜过“蛮力”。

s1模型的出现引发了媒体的广泛关注,但一些报道也存在夸大和误读的现象。

例如,一些媒体将s1模型描述为“OpenAIo1和DeepSeekR1的竞争对手”,甚至将其称为“颠覆者”。

然而,s1模型的实际性能与这些顶级模型仍有差距,称其为“竞争对手”或许略显夸张,“颠覆者”更是言过其实。

另一个被媒体放大的点是“50美元”的成本。

一些媒体将“50美元”解读为训练s1模型的总成本,这实际上是一种误读。

50美元仅仅是指最终微调s1模型所需的GPU算力成本,并不包括前期数据收集、模型选择、算法设计等环节的成本。

此外,s1模型是基于开源的Qwen2.5-32B-Instruct模型进行微调的,Qwen模型本身的训练成本远高于50美元。

因此,将“50美元”等同于s1模型的总成本,显然是不准确的。

不过事到如今,咱们也别着急下定论,从长远来看,这个s1模型充其量只能说是“还在路上”。

就像我们常说的,别人老是跟着学,但就是赶不上。

中华儿女的智慧从来就不是那些外国人能望其项背的。

接下来就是让时间来见证,谁才是真正的王者!

大家觉得呢?

信息来源:

DeepSeek登顶中美苹果应用商店免费应用排行榜

澎湃新闻2025-01-27

DeepSeek:很多惊叹,更多惊喜(望海楼)

海外网2025-02-06 06:39

全球最新排名:DeepSeek-V3夺开源模型第一!是“新瓶装旧酒”还是实质性突破?业内人士详解

每日经济新闻2025-01-06

真的假的?