这篇论文的标题是《Movie Gen: A Cast of Media Foundation Models》,由 Meta AI 团队在 2024 年 10 月 17 日发表。以下是对论文的各个部分的介绍:

摘要:本文推出了Movie Gen,这是一个基础模型阵容,可以生成高质量的1080p高清晰度视频,具有不同的纵横比和同步音频。作者还展示了其他功能,比如基于精确指令的视频编辑和根据用户图像生成个性化视频。本文的模型在多个任务上设定了新的技术标杆:文本到视频合成、视频个性化、视频编辑、视频到音频生成和文本到音频生成。本文最大的生成视频模型是一个有300亿参数的Transformer,训练时最大上下文长度为73K视频标记,这对应于生成16秒、每秒16帧的视频。本文在架构、潜在空间、训练目标和配方、数据整理、评估协议、并行化技术及推理优化方面展示了多项技术创新和简化,利用这些优势,本文能够通过扩大预训练数据、模型大小和训练计算,来训练大规模的媒体生成模型。作者希望这篇论文能帮助研究社区加速媒体生成模型的进展和创新。

研究背景: 人类有能力在脑海中想象出虚构场景的细节,这种想象力需要组合和预测世界的不同方面,如运动、场景、物理、几何和音频等。将这种生成性、组合性和预测能力赋予 AI 系统是一个核心科学挑战,具有广泛的应用前景。尽管大型语言模型(LLMs)旨在通过文本输出空间学习这些能力,但本论文专注于媒体——图像、视频、音频——作为输出空间。

主要贡献:

提出了 Movie Gen,一个能够原生生成高保真图像、视频和音频的基础模型系列。展示了额外的能力,如基于精确指令的视频编辑和基于用户提供的图像生成个性化视频。在多个媒体生成任务上设立了新的最先进水平,包括文本到视频生成、视频个性化和精确视频编辑。提出了多个技术创新和简化,包括架构、潜在空间、训练目标和配方、数据策展、评估协议、并行化技术和推理优化。

研究方法:

使用一个 30B 参数的变换器(Transformer)模型,通过最大上下文长度 73K 视频令牌进行训练,对应于以每秒 16 帧的速度生成 16 秒的视频。通过互联网规模的图像、视频和音频数据进行预训练。通过后训练过程,获得了能够基于人脸生成个性化视频的 Personalized Movie Gen Video 模型,以及能够精确编辑视频的 Movie Gen Edit 模型。实验结果:

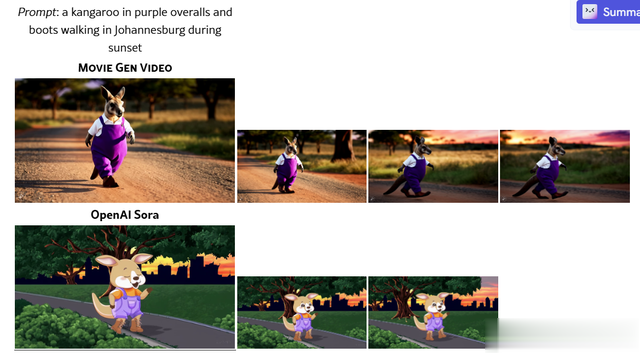

在文本到视频生成任务上,Movie Gen Video 在整体视频质量上超越了包括商业系统在内的先前最先进水平。Personalized Movie Gen Video 和 Movie Gen Edit 分别在视频个性化和精确视频编辑任务上设立了新的最先进水平。Movie Gen Audio 在声音效果生成、音乐生成和音频扩展方面超越了先前的最先进水平,包括商业系统。

结论: Movie Gen 系列模型在视频和音频的多个媒体生成任务上设立了新的最先进水平。通过公开基准测试和提供详细的模型架构、训练、推理和实验设置,作者希望本论文能加速媒体生成模型的研究进展。

全文总结: Movie Gen 是一套能够生成高质量视频和音频的基础模型,通过技术创新和大规模数据预训练,在多个媒体生成任务上设立了新的最先进水平,推动了该领域的研究进展。

论文链接https://arxiv.org/abs/2410.13720