最近看到抖音热搜的DeepSeek AI只能很火,很多小伙伴都想部署,但感觉上条件不是很满足,不知道怎样才能搞定它。

这不,即使是正月初一,小白也是会正常更新的。

今天就来告诉大家怎么在自己的飞牛NAS上部署DeepSeek AI人工智能教程!(本教程同样也适合群晖NAS等其他X86的Linux系统,Ubuntu或CentOS也是可以的,但是OneCloud就不确定了)

小白使用的是测试机i5-3470T RAM12GB+ROM120GB的配置,直接是物理机安装的飞牛NAS。

以这个配置作为参考,其实很多电脑配置都可以运行这个AI人工智能。

好啦,话不多说,马上进入到咱们的教程!

正文开始首先你需要安装一个Ollama,这个软件相当于运行DeepSeek模型的底层,没有这个底层就没办法跑DeepSeek AI模型。

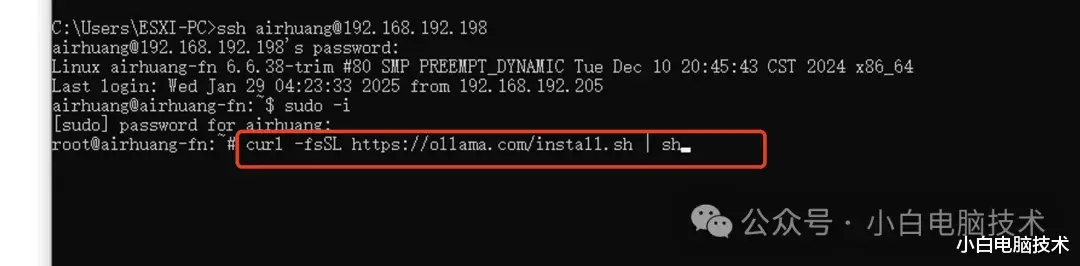

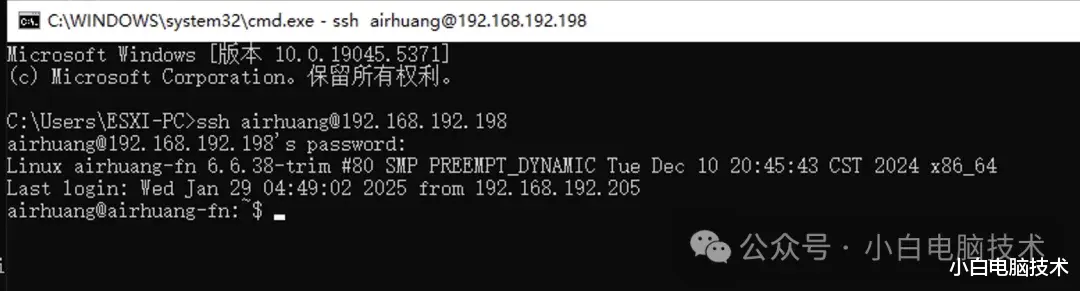

安装Ollama首先你需要SSH连接到飞牛NAS,如果不知道怎么SSH连接飞牛NAS的小伙伴可以参考下面的蓝色教程:

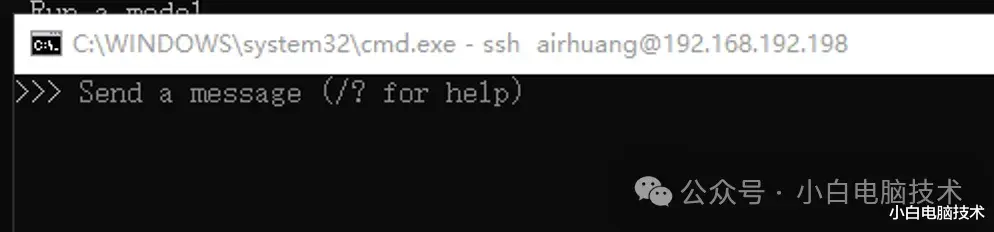

如何使用SSH连接设备?很简单!成功连接之后是这个界面:

连接上去之后就可以直接开搞!复制下面的命令行,粘贴到命令提示符框里,再回车:

curl -fsSL https://ollama.com/install.sh | sh

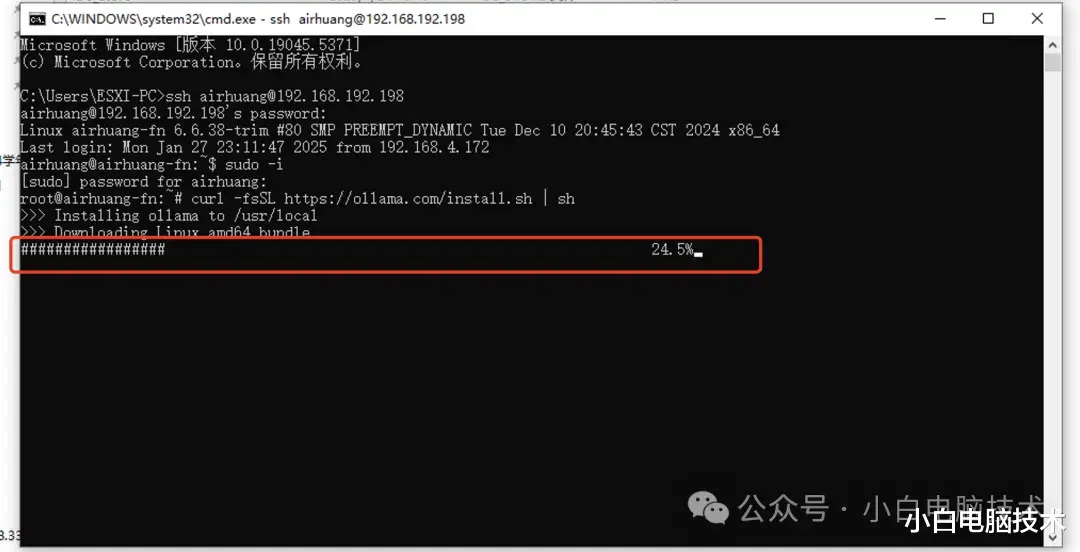

这里需要稍微等待一会儿(主要是看当前的网络情况,还有下载人数的情况,服务器比较拥堵会下载很慢)

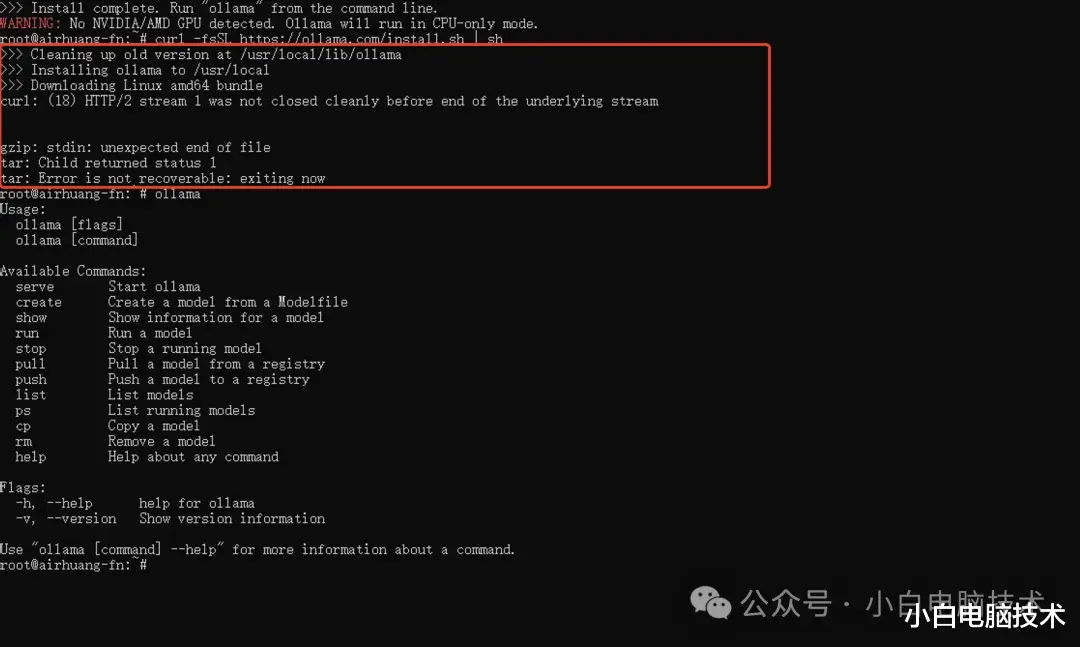

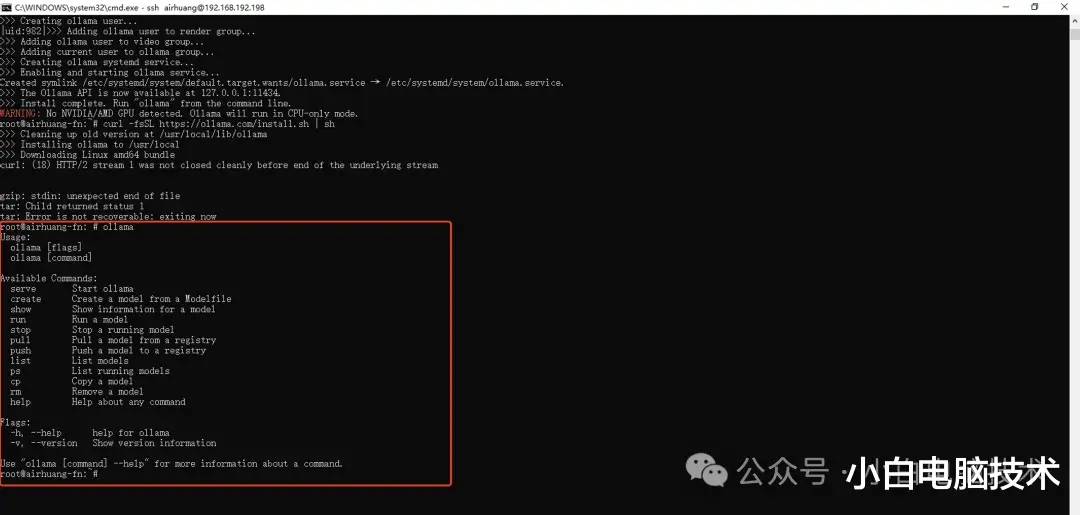

过程中可能会提示by peer,然后进程就中断了,这时候按一下【⬆️】,回车,重新下载安装。如果安装出错,需要重启一下飞牛NAS

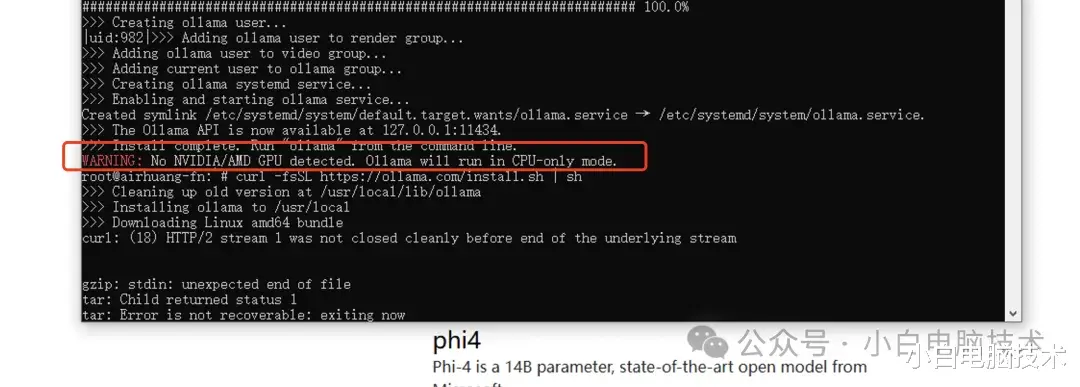

接着再重新粘贴命令行,回车。如果提示这一行:提示No Nvidia or AMDxxx的是因为飞牛上没有显卡导致的,没关系

它可能会自动执行一次同样的命令行,下载出错也没关系,只要有一次大道100%就行

这时候输入【ollama】,回车,如果出现这个框里的这种一样的提示就行了。

复制一下下面的命令行,建议使用1.1GB的模型(你要使用别的模型也可以,主要看空间足不足

------

版本:1.5b,适用于一般文字编辑使用(需要1.1GB空余空间)

ollama run deepseek-r1:1.5b

------版本:7b,DeepSeek的第一代推理模型,性能与OpenAl-01相当,包括从基于Llama和Qwen的DeepSeek-R1中提取的六个密集模型(需要4.7GB空余空间)

ollama run deepseek-r1:7b

------

版本:8b,(需要4.9GB空余空间)

ollama run deepseek-r1:8b

------

版本:14b,(需要9GB空余空间)

ollama run deepseek-r1:14b

------

版本:32b,(需要20GB空余空间)

ollama run deepseek-r1:32b

------

v版本:70b,(需要43GB空余空间)

ollama run deepseek-r1:70b

------

版本:671b,(需要404GB空余空间)

ollama run deepseek-r1:671b

------

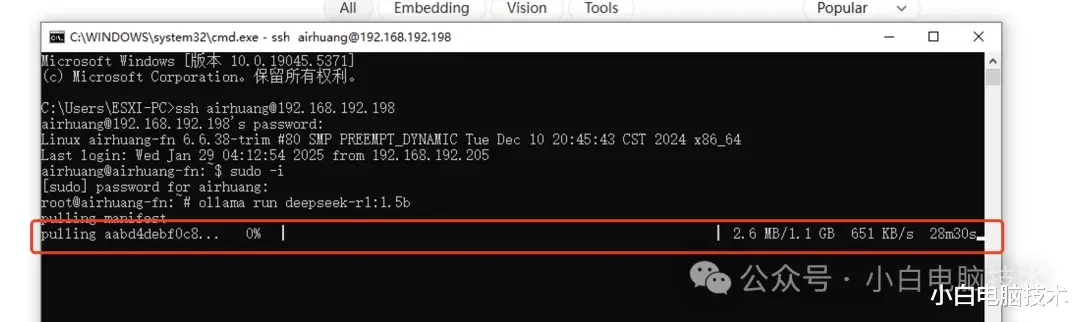

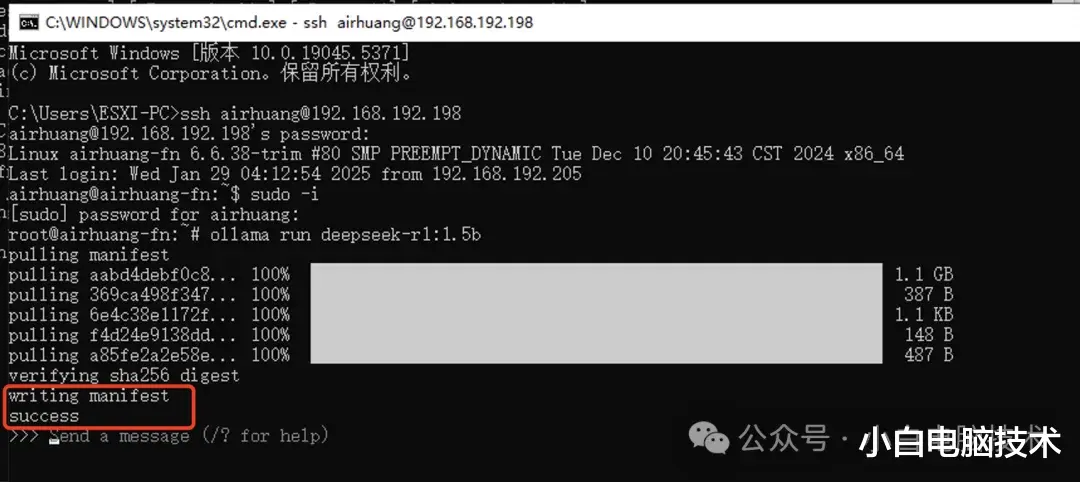

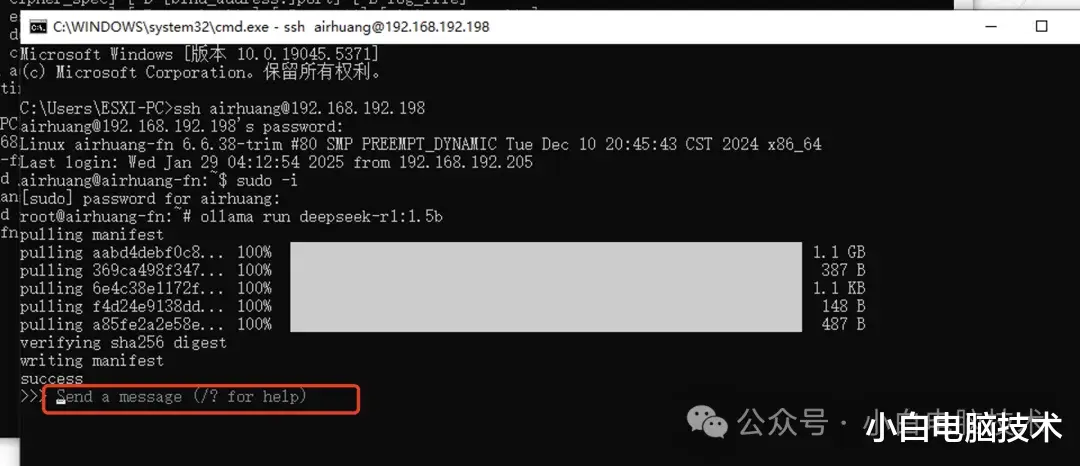

粘贴上去之后,回车,就会有一个下载进度,等待一会儿

下载完成之后就会提示【Success】,证明模型已经部署成功了。

这时候,下面会有提示【 >>> Send a message (/? for help)】

这时候你就可以在这里跟AI人工智能聊天,或者让它创作点东西了

输入完成之后要回车,它会就回复。

这是不是很nice?!

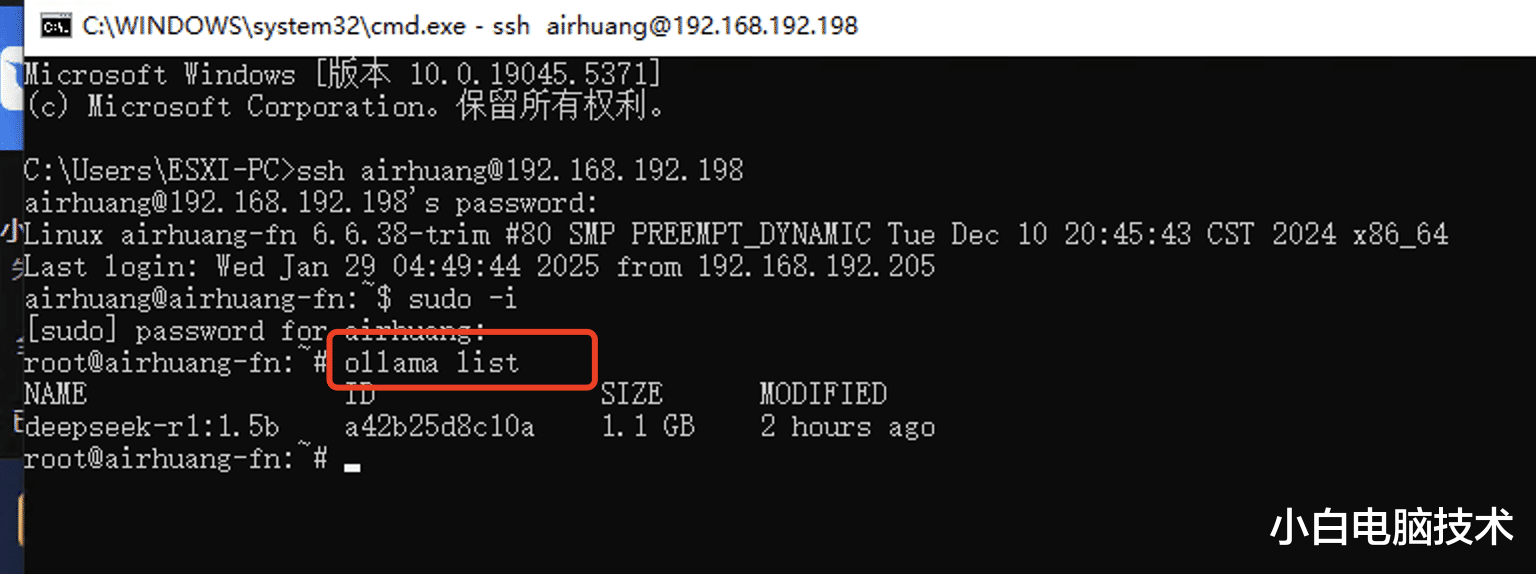

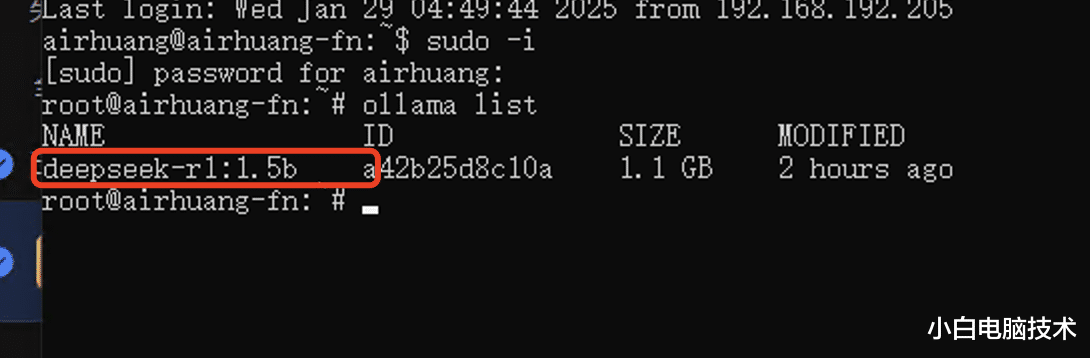

离线之后如何使用呢?关闭这个运行框之后,如果想要使用它,直接SSH连接到飞牛NAS(不需要sudo -i进入到root模式也可以的)

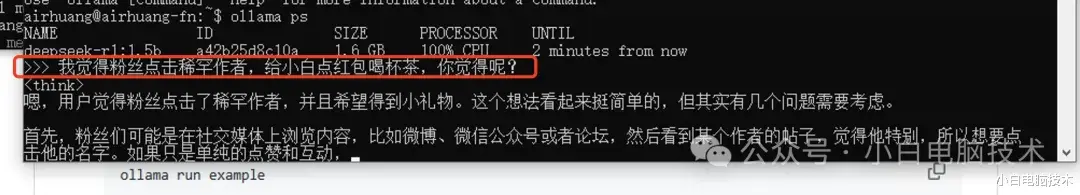

接着输入【ollama ps】查看你安装的模型

ollama list

接着输入【ollama run deepseek-r1:1.5b】,回车

ollama run deepseek-r1:1.5b(后面这个需要按照你自己安装的模型来)

就能进入到deepseek的人工智能对话

这时候就能输入你想要获得的内容了。

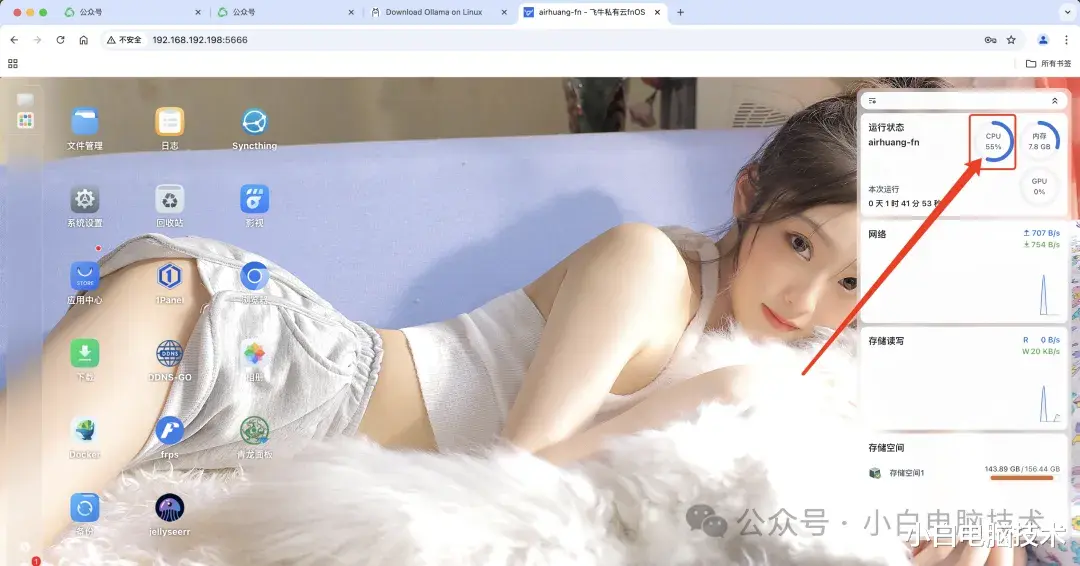

内容输出的快慢取决于你的飞牛NAS配置(主要还是CPU),小白的飞牛NAS跑起来感觉还可以(想要壁纸的小伙伴在公众号后台回复【壁纸】获取。)

另外还会讲解如何在浏览器直接打开与DeepSeek的对话(这个需要部署Open WebUI,请耐心等待教程,预计这两天就会发布了!)

今天是正月初一,㊗️各位小伙伴新年快乐、事事顺心、万事如意、恭喜发财!

(可以点击【稀罕作者】给小白打赏点茶水喝喝!爱你们哦!)