随着GPT-4、o1等大模型的出现,生成式AI产品迎来了井喷式增长,但数据污染问题却给模型的准确性和可靠性带来了严重挑战。

简单来说,数据污染是指在自然语言处理中,评估数据被无意中包含在预训练数据集中,从而影响模型评估结果的情况。

为了深入研究数据污染问题,麻省理工、上海交通、哈佛大学、微软研究院、IBM、剑桥大学等20多家机构联合召开了首届数据污染(2024CONDA)研讨会,旨在收集当前可用数据集和模型中数据污染的证据并公布了实际情况。

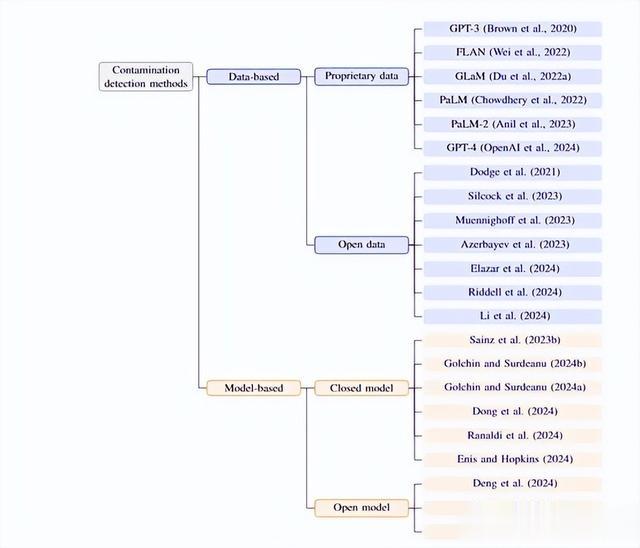

研究人员主要通过公开的拉取请求收集所有污染证据,并在接收前进行讨论。贡献者需要填写几个关键信息,例如,受污染的资源、在受污染源中发现的评估数据集、数据集中每个分割的污染百分比细分、描述提交背后方法的论文的可选参考,以及污染检测方法是基于数据还是基于模型。同时贡献者必须提供证据或指向最初报告证据的科学论文的参考。

该报告共包含42个受污染的源、91个数据集和566个污染条目,432个污染事件包括20个训练集、95个开发集、317个测试集和144个非污染事件。对于每个评估数据集的每个分割,数据库都包含了被一部分污染源污染的百分比。

在受污染的数据方面,报告主要基于CommonCrawl快照、GitHub或多种来源的组合。例如,对于基于CommonCrawl的语料库,C4有35个事件被报告,RedPajamav2有32个,OSCAR有29个,CommonCrawl本身有6个。

在GitHub数据方面,TheStack项目有2个事件被报告。此外,Pile和ProofPile等语料库也有相应的污染事件报告。

在受污染的模型方面,大多数报告的证据是针对闭源模型的。例如,GPT-3有24个污染事件报告,GLaM有17个,GPT4有16个,GPT-3.5有13个,PaLM有8个,PaLM-2有3个,GPT-3.5Turbo有2个,Calude3Opus有1个。

对于开源模型,有14个事件报告涉及使用FLAN数据微调的模型,5个涉及Mistral,3个涉及Llama2,2个涉及Qwen、Llema和Aquila2,mT0和Bloom-Z各有1个。

这说明,尽管闭源源码模型由于其内部运作机制不透明而更难以验证,但在报告中它们仍然是受到数据污染影响的主要对象。开源模型虽然提供了更多的透明度,但仍然存在不同程度的数据污染现象。所以,无论是闭源还是开源的模型,都需要更加谨慎地处理和监控数据来源,以减少污染的可能性。

通过对报告数据的分析,研究人员还发现文本评分、问答和多项选择问答等任务类型是污染最严重的。一些非常受欢迎的数据集,例如,MMLU、GLUE和 ai2_arc,是评估大模型性能的知名基准,这些数据集也存在数据污染问题。

在数据污染与数据集发布年份的关系方面,大多数报告的数据集对应于 2018 年至 2021 年期间。通过进一步分析发现,最近发布的模型更容易受到最近发布的数据集的污染。

例如,2020 年推出的 GPT - 3 主要受到 2016 年数据集的污染,而 2023 年发布的 GPT - 4 主要受到 2018 年至 2022 年数据集的污染。