美国斯坦福大学“以人为本人工智能研究院”(HAI,Stanford Institute for Human-Centered AI)于近日发布了其备受全球瞩目的第八版《人工智能指数报告》(AI Index Report 2025)。

自 2017 年首次发布以来,该报告一直致力于为政策制定者、研究人员、企业高管和公众提供准确、严谨、全球化的 AI 数据和洞察。正如报告联合主席 Yolanda Gil 和 Raymond Perrault 在序言中所言,2024 年是人工智能发展史上具有里程碑意义的一年。AI 已经以前所未有的速度融入社会、经济和全球治理的方方面面。从先进模型的性能飞跃到日常生活的深度嵌入,从创纪录的产业投资到日益收紧的政府监管,AI 正从边缘走向中心,成为驱动商业价值、重塑科研范式乃至影响人类未来的核心力量。

图丨相关报告(来源:HAI)

今年的这份报告长达四百多页,是迄今为止最为全面的一版,新增了对 AI 硬件演进、推理成本估算、AI 出版和专利趋势的深入分析,并扩大了关于企业采用负责任 AI 实践以及 AI 在科学和医学领域角色的新鲜数据。报告强调,在一个 AI 无处不在、从顶尖实验室到普通家庭的餐桌都在讨论的时代,以数据驱动、独立客观的视角来理解 AI 的现状、演变路径和未来趋势,其重要性从未如此凸显。

报告共八个章节,其核心内容可以总结为以下五点:

技术前沿:性能狂飙突进,中国紧随其后,竞争格局日趋拥挤

报告的核心发现之一是 AI 在严苛基准测试上的持续突破,其速度甚至超出了许多人的预期。

· 基准性能持续提升: 2023 年研究人员引入了 MMMU、GPQA、SWE-bench 等一系列旨在难倒顶尖 AI 的新基准。然而仅一年后,AI 模型在这些基准上的表现就出现了惊人的飞跃,得分分别提升了 18.8、48.9 和 67.3 个百分点。尤其在 SWE-bench(软件工程基准)上,AI 解决编码问题的能力从 2023 年的仅 4.4% 飙升至 2024 年的 71.7%。同时,高质量视频生成等领域也取得了重大进展。

图丨选定的 AI 指数技术性能基准与人类性能对比(来源:HAI)

· 中美差距显著缩小: 报告指出,美国仍然是顶尖 AI 模型的“生产大户”,2024 年发布了 40 个值得关注的模型,远超中国的 15 个和欧洲的 3 个。然而,数量上的领先并不意味着性能上的绝对优势。在 MMLU、HumanEval 等关键基准上,中美顶尖模型之间的性能差距已从 2023 年的两位数迅速缩小至 2024 年的近乎持平,部分基准差距仅为个位数甚至零点几。这表明中国 AI 模型的“质量”正在快速追赶。

图丨美国与中国模型在特定基准上的表现(来源:HAI)

· 技术前沿趋于收敛: 竞争的加剧也体现在技术前沿的“拥挤度”上。报告引用了 LMSYS Chatbot Arena(一个广泛使用的大模型竞技场)的数据,显示排名第一和第十的模型之间的 Elo 分数差距从一年前的 11.9% 缩小到了 5.4%。更值得注意的是,排名前两位的模型差距从 4.9% 骤降至仅 0.7%。这意味着顶尖模型的性能水平日益接近,高质量模型不再是少数巨头的专利,开发者生态系统正变得越来越有竞争力。正如 HAI 研究主管 Vanessa Parli 在接受媒体采访时所说:“这创造了一个激动人心的局面。好的地方在于,这些模型不再仅仅是由硅谷的五个人开发的。”

图丨在 LMSYS ChatBot 竞技场的不同顶级模型表现(来源:HAI)

· 小型模型异军突起,开源模型奋起直追: 另一个显著趋势是“小模型”展现出的强大能力。2022 年,在 MMLU 上得分超过 60% 的最小模型是拥有 5400 亿参数的 PaLM。而到 2024 年,微软仅有 38 亿参数的 Phi-3-mini 就达到了同样门槛,参数量缩减了 142 倍。这得益于算法效率的提升。同时,开源/开放权重模型与闭源模型之间的性能差距也几乎消失。在 Chatbot Arena 上,2024 年初领先的闭源模型比顶尖开放权重模型高出 8.04%,到 2025 年初,这一差距已缩小至 1.70%。这标志着先进 AI 技术的获取门槛正在快速降低。

图丨顶级闭源模型与开放模型在 LMSYS Chatbot Arena 的表现(来源:HAI)

· 成本效益显著提升: 报告首次对推理成本进行了追踪。结果显示,达到 GPT-3.5(在 MMLU 上约 64.8% 准确率)性能水平的 AI 模型,其推理成本从 2022 年 11 月的每百万 token 20 美元,骤降至 2024 年 10 月的仅 0.07 美元(以 Gemini-1.5-Flash-8B 为例),降幅超过 280 倍。硬件层面,成本每年下降约 30%,而能效每年提升约 40%。这使得 AI 的应用更加经济可行。

图丨 2022–24 年间在选定基准上的推理成本(来源:HAI)

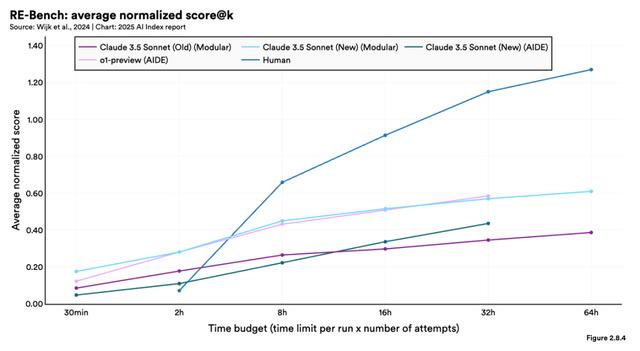

· AI Agent(智能体)崭露头角:2024 年推出的 RE-Bench 为评估 AI 智能体的复杂任务提供了严格的基准测试。在短时间范围内(两小时),顶级 AI 系统的得分是人类专家的四倍,但当给予更多时间完成任务时,人类表现优于 AI,在 32 小时时间框架内领先 AI 两倍。尽管如此,AI 智能体在特定任务上已经能与人类专业知识相匹配,例如编写特定类型的代码,同时提供更快的结果。

图丨 RE-Bench 平均标准化得分(来源:HAI)

产业与经济:投资热情高涨,企业全面拥抱,AI 驱动生产力提升

AI 的商业化进程在 2024 年显著加速,投资和应用均创下新高。

· 投资再创新高,美国优势扩大: 全球私有 AI 投资在经历短暂回调后,于 2024 年强劲反弹至创纪录的 2523 亿美元(企业总投资,包括并购等)。其中,私有投资额达到 1,508 亿美元,同比增长 44.5%。美国依然是全球 AI 投资的绝对中心,2024 年吸引了 1,091 亿美元的私有投资,是中国的 93 亿美元的近 12 倍,是英国的 45 亿美元的 24 倍。尤其在生成式 AI 领域,美国投资额(2024 年为 290.4 亿美元)比中国和欧盟+英国的总和还要多出 254 亿美元,差距进一步拉大。生成式 AI 本身也成为吸金热点,全球共获得 339 亿美元投资,同比增长 18.7%。

图丨 2013-2024 年全球企业在人工智能领域的投资活动情况(来源:HAI)

· 企业应用空前普及: 企业对 AI 的应用不再停留在实验阶段。麦肯锡的调查显示,2024 年报告在其组织中至少一个业务功能中使用 AI 的受访者比例从 2023 年的 55% 跃升至 78%。同样,报告使用生成式 AI 的比例也从 33% 翻倍增长至 71%。AI 正从企业的边缘工具转变为核心驱动力。

图丨 2023 年与 2024 年全球组织的人工智能使用情况(来源:HAI)

· 生产力效应显现,但价值兑现尚需时日: 越来越多的研究证实了 AI 对生产力的积极影响,尤其是在缩小低技能和高技能工人之间的差距方面。然而,报告也指出,尽管企业广泛采用 AI,但多数公司仍处于价值实现的早期阶段。在报告 AI 带来财务影响的企业中,大部分表示效益仍处于较低水平。例如,49% 在服务运营中使用 AI 的企业报告了成本节约,但多数节约幅度低于 10%。同样,71% 在市场营销中使用 AI 的企业报告了收入增长,但最常见的增长幅度也低于 5%。

图丨 2024 年各职能使用生成性人工智能带来的成本减少和收入增加(来源:HAI)

· 机器人领域中国持续领先: 在工业机器人领域,中国继续保持主导地位,2023 年安装量达 27.63 万台,是日本的 6 倍,美国的 7.3 倍,占全球份额的 51.1%。尽管相比 2022 年增速略有放缓,但其领先优势依然巨大。同时,协作机器人和面向人类的服务机器人安装量持续增长,显示出机器人应用场景的扩展。

图丨 2023 年各地区安装的工业机器人数量(来源:HAI)

· 能源格局的新变化: AI 庞大的算力需求正在推动能源来源的重大变化,吸引了对核能的关注。报告特别提到了微软投资 16 亿美元重启三里岛核反应堆为 AI 数据中心供电,以及谷歌、亚马逊等巨头纷纷签署核能协议,这预示着 AI 发展可能对未来能源结构产生深远影响。

AI 伦理与治理:风险与规范并进,挑战与机遇共存

随着 AI 能力的增强和应用的普及,负责任 AI(RAI,Responsible AI)的议题变得空前重要。

· AI 相关事件急剧增加: 根据 AI 事件数据库的记录,2024 年报告的 AI 相关负面事件达到 233 起,创下历史新高,比 2023 年增长了 56.4%。这既反映了 AI 应用的扩大,也凸显了潜在风险的增加,例如深度伪造、偏见歧视、隐私泄露等。

图丨 2012 年至 2024 年报告的人工智能事件数量(来源:HAI)

· RAI 评估标准仍待统一: 报告指出,尽管 RAI 的重要性日益凸显,但行业内仍然缺乏针对大型语言模型的标准化 RAI 基准。这使得跨模型的安全性和责任评估变得困难。不过,HELM Safety、AIR-Bench、FACTS 等新兴基准的出现,为评估模型的真实性、安全性和偏见提供了有希望的工具。

图丨主要的模型所采用的安全与负责任 AI 基准(来源:HAI)

· 企业认知与行动存在差距: 调查显示,虽然许多企业认识到 RAI 的关键风险(如不准确性、合规性、网络安全),但在采取具体缓解措施方面仍然滞后。例如,仅有 64% 关注不准确性风险的领导者采取了相应行动。

图丨组织认为相关并积极努力减轻的与人工智能相关的 RAI 风险(来源:HAI)

· 全球政策制定者紧迫感加大: 与企业界的谨慎不同,全球政策制定者在 2024 年明显加大了对 AI 治理的关注和合作力度。OECD、欧盟(通过《AI 法案》)、联合国、非盟等主要国际组织纷纷发布框架和原则,聚焦透明度、可信赖性、公平性等核心 RAI 议题。各国政府也加大了监管力度,例如美国联邦机构在 2024 年出台了 59 项 AI 相关法规,是 2023 年的两倍多。美国各州在规范深度伪造(尤其是在选举场景应用)方面也取得了显著进展。

· 数据公共池(Data Commons)正在萎缩: AI 模型的训练依赖于海量的公开网络数据。然而,研究发现,由于网站所有者对数据抓取(scraping)的限制日益增多(例如通过 robots.txt 或服务条款),公开可用的训练数据正在迅速减少。在 C4 Common Crawl 数据集中,受限制的 token 比例从 2023 年的 5-7% 跃升至 2024 年的 20-33%。这可能对未来模型的训练数据多样性、模型对齐和可扩展性带来挑战,但也可能催生新的数据获取和学习方法(如合成数据)。

· 模型透明度有所改善,但仍需努力: 基础模型透明度指数显示,主流模型开发者的平均透明度得分从 2023 年 10 月的 37% 提高到 2024 年 5 月的 58%。这表明行业在披露模型信息方面有所进步,但距离完全透明仍有很长的路要走。

图丨基础模型透明度指数(来源:HAI)

· 隐性偏见依然存在: 报告强调,即使是那些明确设计了反偏见措施的先进大模型(如 GPT-4、Claude 3.5),仍然表现出隐性偏见。例如,模型可能更容易将负面词汇与特定种族联系起来,或在职业联想上表现出性别刻板印象。消除 AI 偏见仍然是一项艰巨而持续的任务。

AI 与科学、医学:加速发现,改变范式

AI 正在成为推动科学发现和变革医疗实践的关键力量。

· 科学奖项的认可: 2024 年,AI 在科学领域的贡献获得了最高荣誉。两项诺贝尔奖分别表彰了深度学习的基础工作(物理学奖,John Hopfield 和 Geoffrey Hinton)及其在蛋白质折叠预测中的应用(化学奖,AlphaFold 团队的 Demis Hassabis 和 John Jumper)。图灵奖则授予了强化学习领域的奠基人。这标志着 AI 已成为科学研究不可或缺的一部分。

· 蛋白质研究的飞跃: AlphaFold 3 和 ESM3 等新一代蛋白质序列模型在 2024 年发布,它们规模更大、性能更强,极大地提高了蛋白质结构和功能预测的准确性。这些模型不仅推动了基础生物学研究,也为药物设计和合成生物学开辟了新途径。公开蛋白质数据库(如 UniProt、PDB、AlphaFold DB)的规模也在持续快速增长。

图丨 2019–2025 年公共蛋白科学数据库的增长(来源:HAI)

· 临床知识与应用:大模型在医学知识问答基准(如 MedQA)上的表现持续提升,OpenAI 的 o1 模型取得了 96.0% 的新 SOTA 分数。研究表明,在某些复杂的临床诊断任务中,GPT-4 的表现甚至优于医生(无论医生是否使用 AI 辅助)。AI 在癌症检测、高风险患者识别等方面也显示出超越人类专家的潜力。FDA 批准的 AI 赋能医疗器械数量呈爆炸式增长,从 2015 年的仅 6 个激增至 2023 年的 223 个。

图丨大模型在临床诊断中的表现(来源:HAI)

· 合成数据的潜力: 研究显示,AI 生成的合成数据在医学领域展现出巨大潜力,可用于识别健康的社会决定因素、增强隐私保护下的临床风险预测,以及加速新药化合物的发现。

· 医学伦理关注度提升: 随着 AI 在医疗领域的广泛应用,相关的伦理讨论也日益增多。医学 AI 伦理相关的出版物数量自 2020 年以来翻了两番,显示出学术界对这一领域的高度关注。

教育与公众认知:机遇与挑战并存,认知差异显著

AI 的发展对教育体系和公众认知提出了新的要求和挑战。

· CS 与 AI 教育普及,但鸿沟犹存: 全球范围内,提供或计划提供 K-12 计算机科学(CS,Computer Science)教育的国家比例已从 2019 年的约三分之一翻倍至三分之二,非洲和拉丁美洲进步最为显著。然而,基础设施(如电力缺乏)限制了非洲学生的实际学习机会。在美国,尽管高中 CS 课程的覆盖率和入学率有所提高,但不同州、族裔、收入水平和性别的学生之间仍然存在显著差距。虽然 81% 的美国 CS 教师认为应将 AI 纳入基础 CS 教育,但只有不到一半的人感觉自己有能力教授 AI。

图丨 2024 年按种族/民族划分的基础计算机科学课程的获取情况(来源:HAI)

· 人才培养出现新动向: 美国 AI 相关硕士毕业生的数量在 2022 年至 2023 年间几乎翻了一番,这可能预示着未来几年学士和博士层面也将出现类似的增长。美国在信息、通信和技术领域的毕业生培养方面继续保持全球领先地位。

图丨 2013–23 年美国新计算机科学高等教育毕业生(来源:HAI)

· 全球公众情绪:谨慎乐观与深刻分歧: Ipsos 的全球调查显示,公众对 AI 产品和服务的态度趋于“谨慎乐观”。认为 AI 利大于弊的全球受访者比例从 2022 年的 52% 上升到 2024 年的 55%。尤其是在此前较为悲观的国家(如德国、法国、加拿大、英国、美国),乐观情绪有了显著增长(+4% 到+10% 不等)。然而,地区差异依然巨大。中国(83%)、印尼(80%)、泰国(77%)等亚洲国家民众普遍更为乐观,而加拿大(40%)、美国(39%)、荷兰(36%)等国民众则相对更为审慎。

图丨不同国家民众对于 AI 的态度(来源:HAI)

· 信任度下降,伦理担忧加剧: 尽管总体乐观情绪有所上升,但公众对 AI 公司伦理行为的信任度正在下降。全球范围内,相信 AI 公司会保护个人数据的受访者比例从 2023 年的 50% 下降到 47%。认为 AI 系统公正无偏见的比例也在降低。对自动驾驶汽车的不信任感依然很高(美国 61% 的人表示害怕)。

· 对 AI 影响的认知: 全球 60% 的受访者认为 AI 将在未来五年改变他们的工作方式,但只有 36% 的人认为 AI 会取代他们的工作。人们普遍认为 AI 能节省时间(55%)、提供更好的娱乐(51%),但在经济影响(36% 认为能改善国家经济)和健康改善(38%)方面则信心不足。

图丨全球对人工智能对当前工作的影响的看法(来源:HAI)

完整报告参见:https://hai.stanford.edu/ai-index/2025-ai-index-report

参考资料:

1.https://hai.stanford.edu/ai-index/2025-ai-index-report

2.https://www.wired.com/story/stanford-study-global-artificial-intelligence-index

运营/排版:何晨龙