一、 快速入门

Ollama 是一个在可以在本地对AI大语言模型(LLM)进行运行、调试、扩展的开源工具平台。他的基本操作都是基于命令行的,但是也支持与其他的聊天界面工具结合一起使用。

1.1 安装

1.1.1 windows 与 macOS 系统安装1)通过 下载安装包

备注:如果直接从官网下载比较慢,网上有解决的方案,可以试一下。

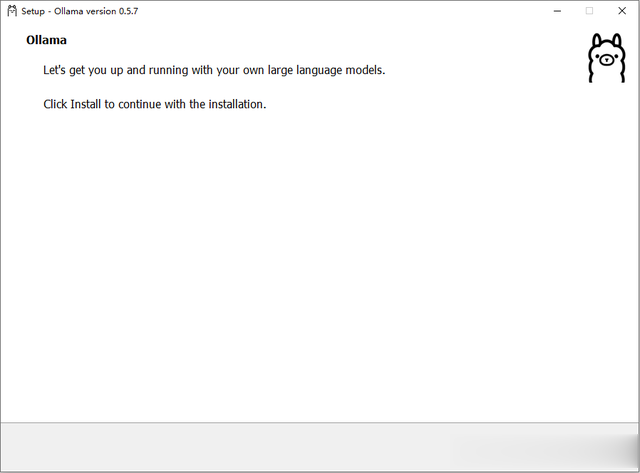

2)双击安装包启动安装。

3)单击 Install 进行安装。

4) 启动服务

Ollama 安装后,默认会启动服务,也可以设置为Windows开机启动

5)命令行查看 Ollama 的版本号

1.1.2 LInux 系统安装

1.1.2 LInux 系统安装在 Linux 系统上,还可以通过 install.sh 脚本进行安装

curl -fsSL ollama.com/install.sh | sh1.1.3 DockerOllama 官方也提供了 Docker 镜像,可以在 Docker Hub 上获取:

Ollama Docker 镜像是 ollama/ollama

二、使用 Ollama 本地部署AI大模型(LLM)

通过 Ollama 工具,可以很方便的部署AI大模型到本地,而且操作简单,支持同时部署运行多个大模型,本文就以部署 qwq 32b 为例进行简单演示,其他大模型的部署方式类似。

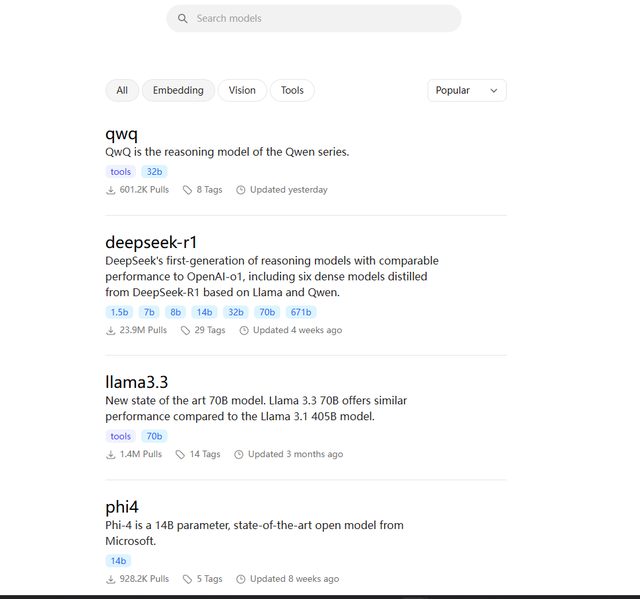

2.1 Ollama 支持的模型库

可以访问 Ollama 模型库,查询当前支持的模型有哪些,模型库的访问链接是:https://ollama.com/search

2.2 本地部署 qwq 大模型

1)单击 qwq 进行 qwq 大模型详情页面

2)查询 qwq 大模型详情

qwq 大模型的简单介绍

qwq 大模型性能对比说明

qwq 未来发展规划

3)复制 qwq 部署命令 ollama run qwq

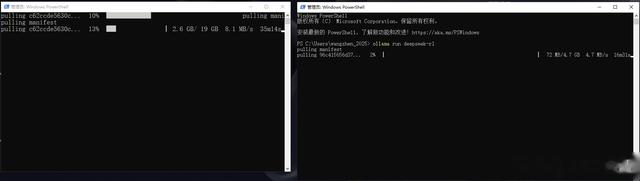

4)powershell 命令行执行命令,开始部署,等待部署完成即可开始使用。

5)也可以同时另打开一个 powershell 窗口部署其他大模型。

三、ollama 常用的一些命令

基于 Modelfile 创建一个大模型(下个文章会专门讲解)ollama create cusmodel -f ./Modelfile更新一个大模型ollama pull qwq从本地移除一个大模型ollama rm qwq从一个大模型复制一个大模型ollama cp qwq qwq-32b查看一个大模型的基本信息ollama show qwq列出本地所有大模型列表ollama list显示当前正在运行的大模型ollama ps停止一个正在运行的大模型ollama stop qwq五、说明:

ollama 特别适合学习AI大模型运行、调试和扩展等;本文只介绍了 ollama 基本的使用,只是作为学习通过 ollama 如何对AI大模型进行调试和扩展的基础部分;熟悉了对大模型的调试和扩展之后有助于我们打造一个自己专属的AI大模型,而不只是简单停留在本地部署上。