就在本周,NVIDIA英伟达刚刚发布了最新的AI芯片H200 GPU,引发了业界广泛关注。

不过AI圈苦算力久矣,看看二手平台30万一张的H100,相信规格又有提升的H200价格也不会便宜到哪去。

处在行业前列的科技大厂们同样要考虑“降本增效”的事儿,“自研芯片”就是其中一条出路。

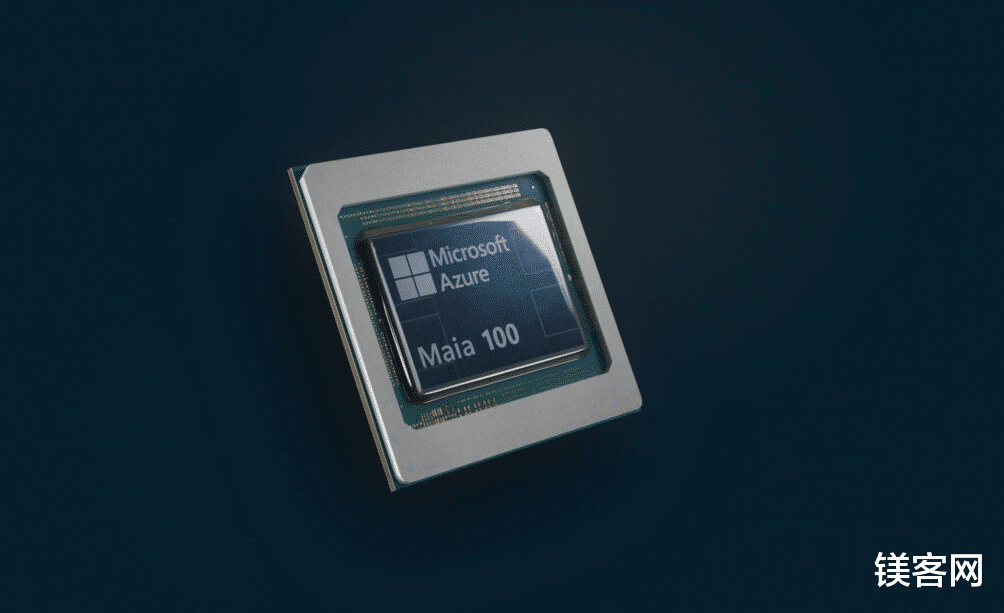

而在今天稍早的Ignite 2023大会上,微软终于公布了那个“传说中”代号“Athena雅典娜”的芯片——Azure Maia 100,同时还有Cobalt 100,两者将用于强化Azure AI和Microsoft Copilot服务。

算力还行,显存不够首先是Maia 100,这是一款专为Azure云服务和AI工作负载设计的ASIC芯片,适用于x86系统,可用于OpenAI模型、Bing、GitHub Copilot和ChatGPT等AI工作负载运行云端训练和推理。

基于台积电5nm工艺,单芯片拥有1050亿个晶体管。在算力方面,MXInt8格式下,算力可以达到1600 TFLOPS,在MXFP4格式下则为3200 TFLOPS。这个水平和英伟达的H100相比也差距不远了。

不过由于Maia 100的立项设计是早于大语言模型热潮之前的,因此在显存上的规划要相对保守,只给了4层堆栈64GB HBM3显存,带宽也只有1.6TB/s,无论速度、堆栈层数还是容量,都远不及H100。有关显存对于AI计算,尤其是推理效率的意义,大家可以参考《英伟达H200发布,性能很强,奈何买不到》,这里就不再赘述。

不过微软有一个独特的领先之处,每块Maia 100的芯片内都直接集成了RDMA以太网IO,可以很方便的进行多芯片互联,相当于英伟达的NVLink。这使得Maia 100能够很轻松地实现数量庞大的芯片互联,而不需要外置网卡协助。

OpenAI首席执行官Sam Altman表示:“Azure Maia 是专门为 AI 设计的,旨在实现硬件的绝对最大利用率”,OpenAI也已经用自己的模型(GPT-3.5 Turbo)对Maia进行了测试与改进。

另一款Cobalt 100 CPU则是一款高能效设计的Arm架构芯片,专门用于在微软Cloud上运行通用计算工作负载。这款芯片可以提供高密度、高可靠性和高安全性的计算服务,适用于 Web 应用、数据库、容器和微服务等。

硬件规格上,Cobalt 100拥有128个Neoverse N2内核,支持12通道DDR5内存。

根据微软硬件产品开发副总裁所说,Cobalt 100的主要目标是优化整个数据中心的“每瓦性能”以实现可持续发展。

取代英伟达?不,扩大合作!前面也提到了,长期以来,英伟达的AI芯片上几乎具有统治级的地位,旗舰芯片不仅一卡难求,更是价格高昂,有分析计算,AI服务比传统互联网服务如搜索引擎的成本高10倍。

实际上,微软已经是Meta、谷歌等巨头中较晚发布自研芯片的公司了,目的基本都是降低成本。

本以为,这次的微软芯片应该也会剑指英伟达,形成竞争关系,但事实好像并非如此。

一方面,微软表示,他们并不打算出售这些芯片,而是将它们用于为其自己的订阅软件产品赋能,并作为其Azure云计算服务的一部分。

另一方面,微软还宣布将会扩大行业合作伙伴关系,推出了基于英伟达H100构建的NC H100 v5 VM系列的预览版,明年还会添加英伟达的H200 GPU,以实现更大的模型推理能力,现场更请来了英伟达CEO黄仁勋站台。同时,AMD的MI300X芯片似乎也找到了新客户。

很明显“这并不是取代NVIDIA的东西”。

软件才是王炸Azure硬件系统和基础设施(AHSI)公司副总裁Rani Borkar表示,微软是一家软件公司,现在共同设计软件和硬件是为了实现1+1>2的效果,硬件只是其中一部分。

首先,Bing Chat和Bing Chat for Enterprise,正式更名为Copilot。后续不仅可以通过浏览器网页进行访问,还会上线移动设备。

同时,微软还带来了低代码工具“Copilot Studio”,可以在同一网页中构建、部署、分析和管理内容,通过拖放这种简单易懂的方式,就能直接构建和发布插件到适用于Microsoft 365的Copilot。

它甚至还集成了OpenAI前段时间刚公布的GPTs,可定制Copilot,或构建独立的协同助手,包括自定义的 GPT、生成式AI插件等,可以自定义主题。

写在最后整场Ignite 2023大会可以说是干货满满,笔者总结的并不全面。

不过有趣的是,似乎没人带着英特尔玩了?

本文作者:Visssom,观点仅代表个人,文中图片均来自微软