我记得有一次在朋友聚会上,大家聊到一个很有意思的话题:如果AI真的这么聪明,为什么我们还会看到那么多奇怪的回答?

这时,一个技术迷朋友不假思索地说:“有时候,思考过程比答案更重要。

”他提到的DeepSeek R1 671B,一款令人惊叹的AI模型,就是这么一回事。

大家的兴趣一下子被激发了,纷纷想知道这款模型到底有什么独特之处。

DeepSeek的深度思考功能让人惊叹DeepSeek R1 671B不只是个简单的问答系统。

与之前的AI不同,它可以进行深度的思维链模式思考。

什么意思呢?

假如你问它一个复杂的问题,比如“如何在城市规划中提高公共交通效率”,DeepSeek不仅能给出答案,还会展示它的思考过程——从分析现有交通模式,到提出改进方案,再到预估实施效果。

这种深度思考反而比得出答案更有学习价值。

很多时候,我们关心的已经不仅仅是答案本身,而是思考的过程。

通过观察DeepSeek的思维链条,我们可以反思自己的思考方式,看到自己平时没有注意到的细节和逻辑。

这种能力,不仅帮助我们解决问题,还能提升我们的思维水平和表达能力。

解决官网繁忙问题:本地部署是好选择这么强大的工具在使用时也并非一帆风顺。

由于DeepSeek太火了,官网经常因为访问量太大而导致服务器繁忙,让人很难畅快使用。

那怎么办呢?

爱折腾的技术人一定不会坐以待毙,可以选择本地部署!

本地部署也不是一件轻松的事,尤其要考虑各种硬件配置。

DeepSeek的原生态模型非常大:有720GB。

这意味着,即便是高端配置的GPU服务器,运行起来也有些吃力。

所以,选择一个量化版本会是一个更实际的方案。

如何选择适合的DeepSeek模型版本说到量化版本,这里就有必要提一下。

所谓量化,是对模型进行数据压缩,在保持主要功能的同时,显著减少模型占用的资源。

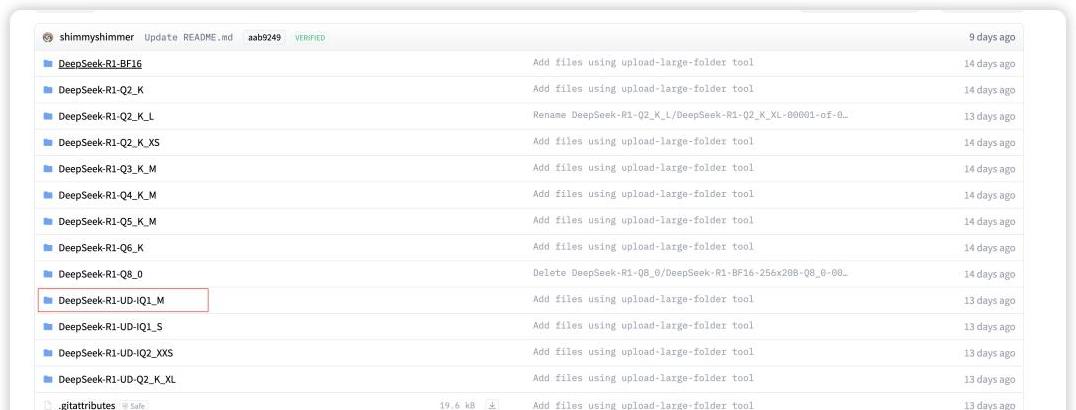

DeepSeek R1 671B有好几种量化版本可以选择,比如Unsloth AI提供的动态量化版本,就是一个非常不错的选择。

我选择的是DeepSeek-R1-UD-IQ1_M,这是一个1.73-bit的动态量化版本,占用了158 GB的空间。

虽然比原版的720GB小了不少,但实际上使用效果基本没差别,尤其是处理一般的问答、程序、数学类问题时,几乎和官方问答一致。

唯一的缺陷是,处理超复杂的问题时会稍微慢一些。

要成功运行这个模型,需要有相当的硬件支持。

比如,我的服务器配置是V100 * 8,单卡32G内存。

而且,除了模型权重,还需要为上下文缓存留出一些内存空间。

具体的安装步骤,我建议参阅一些详细的教程,但基本步骤就是下载模型、安装ollama、配置Modelfile文件,最后启动模型运行。

详细教程:从下载到运行DeepSeek R1 671B模型具体步骤其实不复杂,简单复述一下:

1. **下载模型文件**:从HuggingFace或七牛云下载模型文件(.gguf)。

2. **安装ollama**:可以选择在线或离线安装ollama,确保环境里安装了必要的CUDA驱动。

3. **配置Modelfile**:创建一个描述文件,设置模型路径,然后重启ollama。

4. **运行模型**:通过ollama的命令运行模型,或者通过API访问。

一步步完成这些操作后,DeepSeek R1 671B的模型已经在本地跑起来了。

你可以直接在命令行中和它交互,也可以通过API或者安装一个web界面来访问,非常方便。

试想一下,如果你能在自己的电脑上运行这么一个强大的思考助手,不再受限于服务器繁忙的困扰,是不是可以更自由地 explore 一些深度思考的问题呢?

这大概也是很多技术人喜欢折腾本地部署的原因之一吧。

总结一下,DeepSeek R1 671B不仅是一个强大的工具,更是一个提高我们思维能力的好帮手。

通过本地部署的方式,我们可以更自由、稳定地使用这个模型,享受深度思维带来的乐趣和启发。

通过本地部署享受深度思维最后值得一提的是,虽然本地部署看起来有些复杂,但对技术人来说,这其实是一种挑战和乐趣。

亲自动手解决问题,看到模型成功运行的那一刻,成就感满满。

同时,这也让我们重新思考了一个问题:在科技如此发达的今天,为什么我们还需要自己动手?

也许,动手的过程本身比结果更重要。

通过深度使用DeepSeek,我们不仅能得到问题的答案,更能学会如何提出更好的问题,如何从更多的角度看待问题。

在这个信息爆炸的时代,拥有深度思考的能力,也许正是我们能在纷杂的信息中保持清醒和独立思考的关键。

希望这篇文章能帮助你更好地理解和使用DeepSeek R1 671B模型,同时也激发你对深度思考的兴趣。

在未来的日子里,让我们一起享受科技带来的无限可能吧。