我是使用Ollama+Cherry-studio组合工具,在本地电脑部署了DeepSeek R1 7B,支持图形界面操作,靠CPU撑着运行,如果你硬件好建议部署更高参数的,比如14B。

整个部署流程下来大概1个小时,主要是下载速度慢,其他还好。

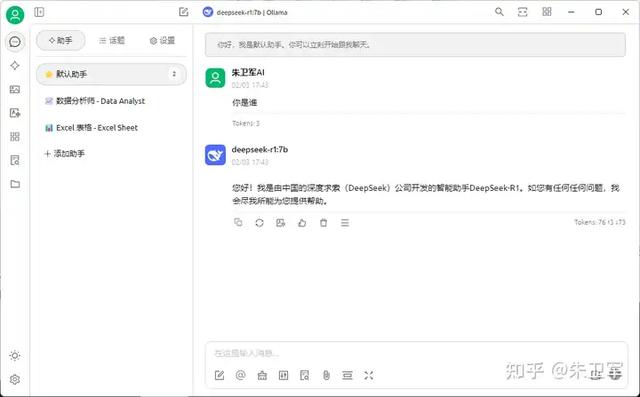

最近DeepSeek由于受到大量DDOS攻击,加上访问过热,总是会出现服务器繁忙、无法加载的情况,在本地电脑部署DeepSeek R1模型成了大家的plan b,我测试的效果图如下。

下面会讲到部署本地LLM(大模型)需要的软件,以及相应的电脑配置,这里以DeepSeeK R1各种版本为例。

软件配置我选择了Ollama作为本地运行LLM的工具,这是一个非常出名的开源软件,Github上有12万Star,主要用来在本地电脑设备下载、部署和使用LLM。

Ollama提供了丰富的LLM库用于下载,比如llama、qwen、mistral以及这次要使用的deepseek r1,而且有不同的参数规模用于选择,适配不同性能的电脑设备。

Ollama虽然支持直接使用LLM,但是仅能在命令行来对话,交互功能不尽人意,所以我会使用Cherry-studio来作为前端交互,以Ollama作为后台,来和LLM对话,这就和日常使用的DeepSeek APP类似了。

Ollama交互界面:

Cherry-studio交互界面:

电脑配置要求

电脑配置要求很多人担心在本地部署DeepSeek R1,是不是对电脑性能有很高要求,比如CPU、GPU、内存等。

其实不用担心,不同参数规模的模型对电脑性能要求不一样,部署DeepSeek R1 8B规模以下的模型不需要独显也可以运行。

我部署的是7B模型,电脑系统windows 11,配置CPU Intel(R) Core(TM) i7-12650H 2.30 GHz,内存16GB,没有独显。

这里科普下,LLM参数规模是指什么,所谓7B是指该模型大约有 70 亿(7 Billion)个参数,参数代表里模型训练过程中需要学习的数值,参数越多,模型能够理解更复杂的信息,给出的回答也越准确和全面。

以下是基本的要求,可以对号入座。

R1模型版本

CPU

GPU

内存

存储

1.5B

Intel Core i5/AMD Ryzen 5 及以上

无强制要求,有 1GB 及以上显存可提升性能

最低 8GB,推荐 16GB+

至少 10GB,建议留更多缓存空间

7B

Intel Core i7/AMD Ryzen 7 及以上

无强制要求,有 4GB 以上显存更好,推荐 8 - 12GB

最低 16GB,推荐 32GB+

至少 12GB,建议 30GB+

8B

Intel Core i7/AMD Ryzen 7 及以上

无强制要求,有 4.5GB 以上显存更好,推荐 8GB+

最低 16GB,推荐 32GB+

至少 12GB,建议 30GB+

14B

Intel Core i9/AMD Ryzen 9 及以上

8GB 以上,推荐 12GB+,如 RTX 3080 及以上

最低 32GB,推荐 64GB

至少 15GB,建议 50GB+

32B

高端多核,强多线程处理能力

18GB 左右,建议 24GB+,如 NVIDIA A100

32GB+,推荐 64GB+

至少 20GB,建议 80GB+

70B

服务器级 CPU,如 Intel Xeon 系列

40GB 以上,如 NVIDIA H100

64GB+,推荐 128GB+

至少 30GB,建议 200GB+

具体部署流程见我写的专栏文章,手把手教学,非常详细: