文生图大模型,其开源领域便是大名鼎鼎的 stable diffusion,其stable diffusion的安装,使用以及如何在官方网站使用,调用 API 等,我们都在本账户重点介绍过,其相关文章,可以到小编主页进行查看。

其stable diffusion团队也是经历了很多变更,其团队也是离职了不少专业人才,这不,今天介绍的黑森林实验室便是stable diffusion前团队重点打造的一个文生图,未来也有文生视频模型。

Black Forest Labs

黑色森林实验室是一支由杰出的 AI 研究人员和工程师组成的团队(很多核心团队成员来源于 stable diffusion),其团队成员在学术、工业和开源模型中开发基础生成式 AI 模型方面都拥有出色的业绩。黑色森林实验室创新包括创建VQGAN和潜在扩散、用于图像和视频生成的稳定扩散模型(Stable Diffusion XL, Stable Video Diffusion, Rectified Flow Transformers)以及用于超快速实时图像合成的对抗扩散蒸馏。

一直被人诟病的,文生图大模型无法生成人手,而黑森林实验室在发布模型时,特意展示了一张人手的图片,且直接把人手作为重点展示,直接打脸了很多无法生成人手的文生图大模型。

黑森林实验室发布了 FLUX.1 文本到图像模型套件,在文本到图像合成上,包含图像细节、风格多样性和场景复杂性都达到了最先进水平。为了在可访问性和模型功能之间取得平衡,FLUX.1 有三种版本:FLUX.1 [pro]、FLUX.1 [dev] 和 FLUX.1 [schnell]:

FLUX.1 [pro]:

FLUX.1 的精华,提供最先进的性能图像生成,具有一流的提示跟踪、视觉质量、图像细节和输出多样性。其团队也正在慢慢提高 API 中 FLUX.1 [pro] 的推理计算能力。API注册以访问 FLUX.1 [pro] 。FLUX.1 [pro] 也可通过Replicate和fal.ai获得。此外还提供专用和定制的企业解决方案

FLUX.1 [dev]:

FLUX.1 [dev] 是一种开放权重的模型,适用于非商业应用。FLUX.1 [dev] 直接从 FLUX.1 [pro] 提炼而来,具有相似的质量和及时处理能力,同时比同等大小的标准模型更高效。FLUX.1 [dev] 权重可在HuggingFace上使用,并可直接在Replicate或Fal.ai上使用。

FLUX.1 [schnell]:

最快的模型是为本地开发和个人使用量身定制的。FLUX.1 [schnell] 在 Apache2.0 许可下公开可用。类似地,FLUX.1 [dev],权重可在 Hugging Face 上使用,推理代码可在GitHub和HuggingFace 的 Diffusers中找到。此外,也可以在ComfyUI上来使用。

所有公开的 FLUX.1 模型均基于多模态和并行扩散transformer混合架构,并缩放至 12B 个参数。通过基于流匹配(一种通用且概念简单的生成模型训练方法,其中包括扩散作为特例)改进了以前最先进的扩散模型。此外,通过结合旋转位置编码和并行注意层来提高模型性能,并提高硬件效率。

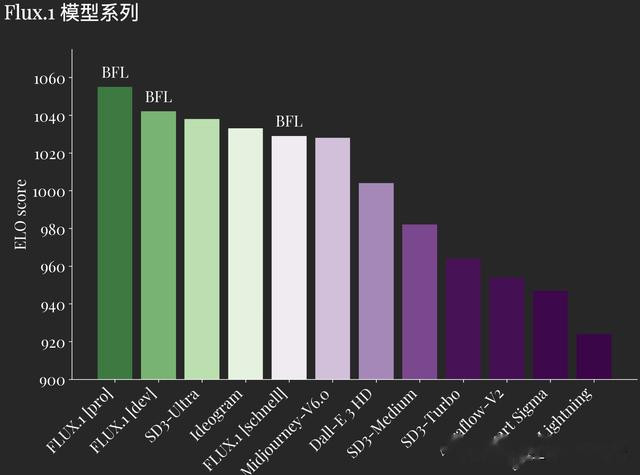

FLUX.1 定义了图像合成领域的最新技术。FLUX.1 [pro] 和 [dev] 在视觉质量、快速跟进、尺寸/长宽变化、排版和输出多样性,每个方面都超越了 Midjourney v6.0、DALL·E 3 (HD) 和 SD3-Ultra 等热门模型。FLUX.1 [schnell] 是迄今为止最先进的模型,其表现不仅优于同类竞争对手,还优于 Midjourney v6.0 和 DALL·E 3 (HD) 等强大的非蒸馏模型。此模型经过专门微调,以保留预训练的整个输出多样性。

所有 FLUX.1 型号变体均支持 0.1 和 2.0 百万像素的多种宽高比和分辨率

当然作为一个开源模型,你可以直接在 GitHub 上面找到开源代码与模型,其官方提供了 2 种使用方法,一种是使用 hugging face 的 transformers库,一种是使用官方的 API 来使用。

pip install git+https://github.com/huggingface/diffusers.gitimport torchfrom diffusers import FluxPipelinemodel_id = "black-forest-labs/FLUX.1-schnell" #you can also use `black-forest-labs/FLUX.1-dev`pipe = FluxPipeline.from_pretrained("black-forest-labs/FLUX.1-schnell", torch_dtype=torch.bfloat16)pipe.enable_model_cpu_offload() #save some VRAM by offloading the model to CPU. Remove this if you have enough GPU powerprompt = "A cat holding a sign that says hello world"seed = 42image = pipe( prompt, output_type="pil", num_inference_steps=4, #use a larger number if you are using [dev] generator=torch.Generator("cpu").manual_seed(seed)).images[0]image.save("flux-schnell.png")

使用 API,需要到官方网站注册并获取 API 接口权限

from flux.api import ImageRequest# this will create an api request directly but not block until the generation is finishedrequest = ImageRequest("A beautiful beach")# or: request = ImageRequest("A beautiful beach", api_key="your_key_here")# any of the following will block until the generation is finishedrequest.url# -> https:<...>/sample.jpgrequest.bytes# -> b"..." bytes for the generated imagerequest.save("outputs/api.jpg")# saves the sample to local storagerequest.image# -> a PIL image https://github.com/black-forest-labs/fluxhttps://huggingface.co/black-forest-labs/FLUX.1-devhttps://blackforestlabs.ai

https://github.com/black-forest-labs/fluxhttps://huggingface.co/black-forest-labs/FLUX.1-devhttps://blackforestlabs.ai

当然,黑森林实验室也会打造文生视频模型,我们一起期待。