2025年3月5日,ACM计算机协会颁出2024年度图灵奖,安德鲁·巴托(Andrew Barto)和理查德·萨顿(Richard Sutton)共享此殊荣。他们是强化学习领域的奠基人,理查德·萨顿更是被公认为“强化学习之父”。

强化学习是当今ChatGPT、DeepSeek的技术核心,这一理论早在上世纪八十年代就由安德鲁·巴托与理查德·萨顿构建出数学框架,并阐明了核心思想。所以二人获得有计机界的诺贝尔奖之称的图灵奖,可谓实至名归。

在DeepSeek中强化学习发挥了至关重要的作用,DeepSeek-R1系列模型借助强化学习显著提升了推理能力,尤其是在数学、代码和自然语言推理等复杂任务方面表现出色。

DeepSeek-R1-Zero完全依靠强化学习,在训练过程中展现出自我验证、反思以及生成长链推理过程(Chain-of-Thought, CoT)等能力,这标志着AI在推理任务上的重大进步。

强化学习(Reinforcement Learning, RL)的本质是如何让智能体(agent)在环境中采取一系列行动,以最大化累积奖励。它模拟生物在环境中的学习过程,通过与环境交互,从环境反馈中学习最优行为策略,也就是让机器通过“奖赏驱动”来获得智能。

强化学习是如此重要,但有的同学可能会担心,纯理论学起来会不会太难懂了?

其实so easy的,《Easy RL 强化学习教程》这本书就为入门者准备,以理论结合实践的方式系统化讲解,读者可一次性掌握强化学习。我们开启这趟学习之旅吧。

强化学习,So Easy《Easy RL 强化学习教程》也被读者们称为“蘑菇书”,是由Datawhale团队所出,以理论结合实践,系统全面地讲解强化学习知识,特别适合读者零起点进入强化学习的世界。

本书萃取了李宏毅老师的 “深度强化学习”、周博磊老师的 “强化学习纲要”、李科浇老师的 “世界冠军带你从零实践强化学习” 这三门经典公开课的精华内容,并融入了作者团队的理解与优化。

本书在豆瓣上获得读者8.3分好评。

本书从内容上可以分为两大部分,我们来深入学习。

第一部分:强化学习的基础知识和传统强化学习算法

首先介绍强化学习的基本概念,包括智能体与环境的交互过程,智能体在环境中获取状态、输出动作,环境根据动作反馈下一个状态和奖励。讲解了部分可观测马尔可夫决策过程等相关概念,以及动作空间、策略、价值函数、模型等智能体的组成成分。

然后从简单的马尔可夫过程讲起,介绍马尔可夫性质、马尔可夫链,接着讲解马尔可夫奖励过程,包括范围、回报、状态价值函数的定义,以及贝尔曼方程及其作用,最后介绍马尔可夫决策过程相对于马尔可夫奖励过程增加了决策(动作)因素,以及状态转移和奖励函数的变化。

讲解了蒙特卡洛方法、时序差分方法、Sarsa、Q学习等传统强化学习算法。

蒙特卡洛方法通过让智能体随机产生轨迹来计算状态价值;时序差分方法结合了动态规划和蒙特卡洛方法的优点,可更高效地学习;Sarsa算法是一种基于时序差分的在线学习算法,用于学习最优策略;Q学习也是基于时序差分的算法,通过不断更新动作值函数 Q (s, a) 来学习最优策略,不依赖环境模型。第二部分:深度强化学习算法及其常见问题的解决方法

首先讲解策略梯度的基本原理和算法,然后介绍近端策略优化算法,它是对策略梯度算法的改进,通过限制策略更新的幅度,使得策略的更新更加稳定和有效,能够在更少的训练步数内取得更好的效果。

介绍深度Q网络(DQN)及其相关扩展算法,它利用深度神经网络来逼近动作值函数Q (s, a),解决了传统Q学习在处理高维状态空间和动作空间时的局限性,使强化学习能够应用于更复杂的任务。

讲解深度确定性策略梯度算法(DDPG),它结合了深度神经网络和确定性策略梯度方法,用于解决连续动作空间的强化学习问题,在机器人控制、自动驾驶等领域有广泛应用。

最后介绍了其他深度强化学习算法及其常见问题的解决方法:

演员 - 评论员算法:结合了策略梯度和价值函数估计的优点,提高了学习效率;稀疏奖励问题:探讨了如何设计合适的奖励函数或采用其他技术来帮助智能体更好地学习;模仿学习:如何让智能体通过模仿人类或其他优秀智能体的行为来进行学习。作者团队

Datawhale团队是国内头部的AI开源学习组织,目前组织有 200 多个团队成员,包括高校教授、学生,以及领域从业者、创业者等,成员来源广泛,具有多元化的知识背景和专业技能。

本书作者团队是来自Datawhale的三名成员:

王琦,中国科学院大学硕士,主要研究方向为深度学习、数据挖掘。曾获中国大学生计算机设计大赛二等奖、亚太地区大学生数学建模竞赛 (APMCM)二等奖和“挑战杯”全国竞赛江苏省选拔赛二等奖,发表 SCI/EI 论文3篇。杨毅远,清华大学硕士,主要研究方向为时空数据挖掘、智能传感系统、深度学习。曾获全国大学生智能汽车竞赛总冠军、中国国家奖学金,发表SCI/EI论文7篇,其中以第一作者身份在SCI的Q1区、Q2区及中国计算机学会(CCF)A、B类会议中发表论文4篇。江季,北京大学硕士,主要研究方向为强化学习、机器人。曾获大学生电子设计竞赛——2018年嵌入式系统专题邀请赛(英特尔杯)一等奖,发表顶会论文1篇、专利2项。他们先是将自己学习强化学习的过程整理成笔记,随后在GitHub上发布开源线上教程“Easy-RL”,吸引了众多技术人与专业学生学习,目前已获得10.5k的星标数。

在成书的过程中,作者们又根据在线课程的反馈,对所涉及的公式都给出详细的推导过程,对较难理解的知识点进行进行重点讲解和强化。

所以,拿到这本书开始学习的读者们,会发现学习强化学习,真的是so easy。

结语自大模型技术兴起,强化学习就是重要的理论基础,《Easy RL 强化学习教程》这本书就可以帮助初学者顺利入门。

本书内容系统全面,涵盖传统强化学习算法和深度强化学习算法及其常见问题的解决方法,从最基本的马尔可夫决策过程开始,由浅入深地介绍强化学习的知识体系,各章节逻辑连贯,知识体系完整。

精彩书摘

作者们认为学习算法更要结合实践,因此为本书编写了完整的Python代码实现,可让读者进行端到端、从理论到实践的全生态学习,充分掌握强化学习算法的原理并具备实战能力。

代码示例

本书还为读者提供了优异的学习体验,在大部分章节的最后设置了原创的关键词、习题和面试题。关键词部分总结了对应章节的重点概念,习题部分以问答的形式阐述了本章节中出现的知识点,面试题部分来源于大厂的算法岗面试真题,帮助读者开阔思路,面试直接就能用上。

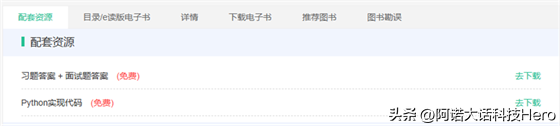

以上的Python代码、习题答案、面试题答案等配套资源,读者均可在异步社区本书页面的“配套资源”处下载。

对于AI领域的算法工程师、应用开发工程师来说,可以将书中的知识与案例与工作相结合,创新运用解决问题。对于高校专业学生,可以系统学习强化学习知识,理解课程中的理论概念,通过实践代码加深对知识的掌握,为将来从事科研或者工程应用打下坚实基础。

从理论到代码,一站式吃透强化学习,《Easy RL 强化学习教程》助你化身AI实战高手!