文|迭里迷史

编辑|迭里迷史

如今的AI技术越来越发达,在飞速发展的今天,对于那些来自AI公司的恶搞,自由开发软件所面临的一系列问题越来越严苛。

各种各样的网站都被AI爬虫给狠狠折腾了一番,一会又是卡了,一会又是让崩了,导致最后网络变得十分不稳定,运行的状况也越来越糟。

即使将那些用于抓取工具可以访问网站上的那些文件给更更改掉,屏蔽掉被揭露的部分爬虫,甚至把相关的可疑流量给过滤出去,这些AI爬虫还是能够用各种不同的办法折腾网站,怎么拦都拦不住。

许多开发者和开源开发者都没有任何解决办法。

而这AI爬虫究竟是什么,其中发生什么事情?

许多开发者表示,如果没有一个彻底解决AI爬虫的办法,他们只好暂停服务的运行。

软件开发者Xe laso就面临这这样一个问题。

在今年的一月份,Xe laso在社交平台十分生气的训斥亚马逊的AI爬虫,它使Git储存库服务疲惫不堪,筋疲力尽,导致整个服务一直处于不稳定的阶段,还时常出现了停机的问题。

尽管设置了种种的防御措施,laso发现,这些AI爬虫不仅没有“掉入陷阱”,反而完美的避开了这些防御系统。

无论她怎么做,这些AI爬虫还是会在网站里面“捣乱”,她称自己发文并非是为了给大家分享这件信息,而是求助大家,需要大家的帮忙,因为她现在已经要被这Ai爬虫逼的崩溃。

laso直接向机器人的运营者表明,希望对方能够放过自己的网站,将自己的服务器屏蔽。

但是问题并没有这么简单,laso的服务器已经明确的禁止所有爬虫的进入,但是这并没有任何的效果。

这些AI爬虫越来越放肆,利用他人的地址和身份直接绕过了系统的防御。

laso几乎要崩溃,她表示自己并不想暂停对公众访问的服务,但现在她没有很好的解决方式,迫不得已只能关闭。

后来,为了组织爬虫,她在配置中加入了阻挡爬虫的代码。

但没过多久,这些AI爬虫仍不罢休,继续不断的更换住宅IP轰炸她的网站,根本没有办法用常规的手段组织这些AI爬虫。

然而并不是只有laso出现被轰炸的问题。

今年一月份,一家专注于人体模型的网站也突然遭到攻击。

刚开始,这家公司CEO Oleksandr Tomchuk只是收到了一条警报,后来才发现,公司的商务网站已经完全崩塌了。

经过调查发现,是AI此前研发的一款机器人在作妖捣乱。

Tomchuk非常无奈也十分崩溃,他到现在也仍然没有办法制裁AI爬虫对网站的侵略。

此时有网友发起质疑,认为Trilegangers 这个网站没有什么防御系统,反爬机制并不强。

但现实残酷,这就与laso所说的一模一样,根本阻拦不住Ai爬虫的轰炸。

然而,这只是一两个开发者的遭遇。

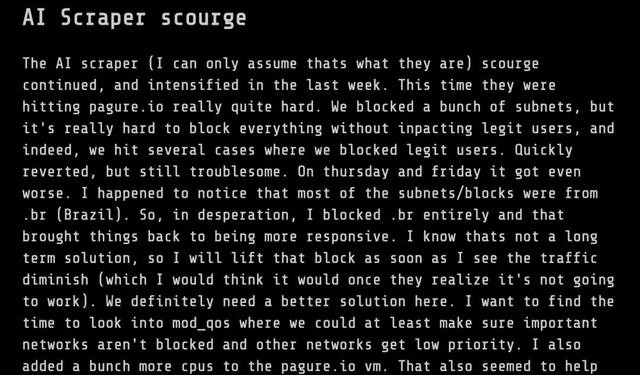

最近,系统管理员 Kevin Fenzi 在社交平台透露,AI爬虫破坏了大量的网站。

即使多次的尝试屏蔽AI爬虫,但都没有任何好转,于是他不得不屏蔽所有来自巴西的流量,这才勉强让网站正常运行。

但是这个方法,也只是临时抢救,想要真正的将AI爬虫打败,还需要更好的解决方案。

AI爬虫的肆意妄为,给许多开发者带来了沉重的负担,也让许多技术团队面临着高昂的运营成本。

对此, SourceHut 创始人兼 CEO Drew DeVault 在社交平台发布了一篇《请不要当着我的面把你们的成本转嫁给我了》,但是遭到了AI公司的无视,甚至大规模的抓取数据将SourceHut的服务器中断。

DeVault称,本该专注于工作的他,现如今不得不花费20%的时间来研究对付爬虫的方式。

DeVault表示,这些爬虫很是聪明,会伪装成用户的流量,无视robots.txt.的存在,去利用许多IP住宅地址专门的战队高消耗的API。

DeVault还说,现在他们每周都会遭到多次的轰炸停机,即使正在处理手头上的工作,也不得不停下来研究对付AI爬虫的办法。

每当DeVault与同行进行交流,当话题转到如何对付爬虫时,最终的结果都会是,没有彻底解决的办法。

面对Ai公司的嚣张,DeVault恼羞成怒但也十分无奈。

由此可见,AI爬虫不断的抓取数据,让开发者陷入沼泽当中。

为了对付这些AI爬虫,开发者也绞尽脑汁的想办法。

laso曾在社交平台上表明,自己曾发开过一个证明工作量的系统。

它的工作原理是,当你进入这个网站时,必须完成一个SHA-256的挑战。

想要挑战成功,需要一定的资源,如果是普通用户,并不会发现有什么异常。

但对于这种大量的AI爬虫来说,可以有效的起到抑制作用。

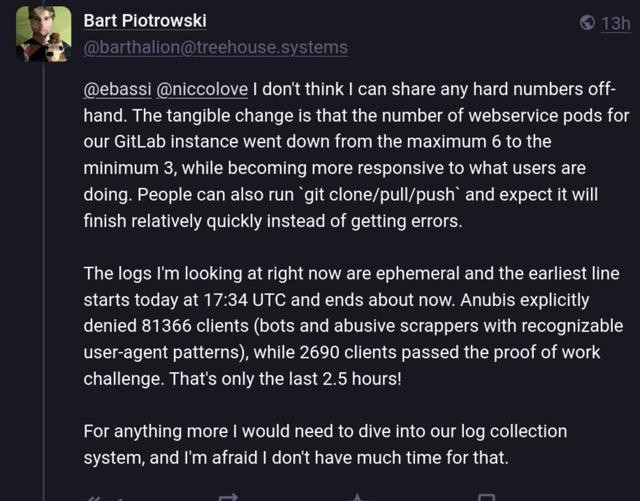

后来,GNOME的GitLab开始试验。

系统管理员 Bart Piotrowski在社交平台上发布了一系列的问题,需要他们通过阐述这些问题来判断是否是AI。

在短时间内,他收到了许多的回复。

但只有3%的人通过了系统的挑战,也就是说,余下的97%都是爬虫。

虽然这个系统确实阻拦了爬虫,但是给很多普通人带来不少麻烦。

除去这个方法外,全球最大的网络基础设施公司之一Cloudflare发布了一个专门对付爬虫的【迷宫】系统。

根据他的介绍,就是当发现有爬虫进入时,AI迷宫就是一个免费的工具,让这些机器人停留在虚假的页面上,而且页面的内容会让机器人变得更加迷茫,最后耗尽了自己的资源。

另外还发现,一位开发者根据【迷宫】系统新研制出了另外一个迷宫系统。

这个迷宫系统的工作原理是让这些爬虫停留在虚假页面的迷宫里,不断的消耗它们,直到被消耗尽。

对于目前的状况看,随着AI技术的飞速发展,AI生成的内容使网络空间筋疲力尽,让很多重要的网络资源都遭受着威胁。

如果AI公司依然嚣张跋扈,给网站带来重大的影响,且没有任何的补偿,那么严重可能威胁到现代的互联网。

在这一场技术的博弈中,虽然开源项目勇敢反击回去,但对于数据隐私等许多问题仍然存在。