撰稿丨云昭

出品 | 51CTO技术栈(微信号:blog51cto)

英伟达飘了,野心膨胀到让业界羡慕嫉妒恨。

就在今天深夜,GTC全场高潮迭起,黄仁勋“轻咬着舌头、左手一个H100,右手一个B200”的照片,纷纷成为了业界媒体新闻的封面热图。

无须多问,黄教主手里拿的是什么,什么就是全场最靓的核弹!

一、没人抄得了B2001.大模型突破摩尔定律,万亿大模型少用6000块H100“随着Transformer模型被发明,我们能以惊人的速度扩展大型语言模型,实际上每六个月就能翻一番。而为了训练这些越来越大的模型,我们也需要更强的算力。"

B200 GPU ,采用了Blackwell架构,与Hopper架构相比,不管是支持的模型参数、还是训练功耗方面,都有着惊人的性能提升。

如黄教主展示的:

之前,如果要在90天内训练一个1.8万亿参数的MoE架构GPT模型,需要8000个Hopper架构GPU,15兆瓦功率。

而现在,同样给90天时间,在Blackwell架构下只需要2000个GPU,同时,能源消耗大大缩减为1/4。

图片

自然,推理生成的token成本也会随之降低。(如此一来,用硬件的方法降低了大模型的训练推理成本,大模型市场落地的价格也会继续降低,或许SOTA模型免费Open给大众,指日可待。)

2.让友商完全抄得跟不上英伟达显卡的强大之处,就在于让友商抄无可抄。黄教主现场展示Grace-Blackwell系统(两个Blackwell GPU、四个die与一个Grace Cpu连接在一起)。

在黄教主现场演示中,GB200将两个B200 Blackwell GPU与一个基于Arm的Grace CPU进行配对。新芯片拥有2080亿个晶体管,所有这些晶体管几乎同时访问与芯片连接的内存。

图片

不得不说,NVIDIA Blackwell B200 GPU 将是一款怪物芯片。它总共包含 160 个 SM,20,480 个核心。GPU将采用最新的NVLINK互连技术,支持相同的8 GPU架构和400 GbE网络交换机。它也将非常耗电,峰值 TDP 为 700W,尽管这也与 H100 和 H200 芯片相同。总结一下这个芯片:

图片

1、20 PFLOPS FP8, 是Hopper的2.5倍

2、20 PFLOPS FP6,Hopper的2.5倍

3、40 PFLOPS FP4, 是Hopper的5倍

4、740B Parameters ,是Hopper的6倍

5、34T Parameters/s,是Hopper的5倍

6、7.2 TB/s NVLINK,是Hopper的4倍

值得注意的是,第五代NVLINK高速互联:为每个GPU 提供了1.8TB/s双向吞吐量,确保多达576个GPU之间的无缝高速通信。这样一下子解决了大规模数据中心的GPU交互问题。

图片

此外,Blackwell 不止步于芯片性能参数的提升,更在AI能力和安全方面下了一番“硬功夫”:

比如Ras Engine(可靠性、可用性和可维护性引擎),可以基于AI的预防性维护来运行诊断和预测可靠性问题;再比如:Secure AI,这是一项先进的加密计算功能,在不影响性能的情况下保护AI模型和客户数据,对于医疗保健和金融服务等隐私敏感行业至关重要。

不得不说,在GPU领域,英伟达绝对是业界的天花板,压力不止给到了AMD和英特尔,更给到了OpenAI,因为英伟达推出的一个GB200 NVL72就最高支持27万亿参数的模型,这瞬间就能装下15个GPT-4模型(据透露,GPT-4模型参数高达1.75万亿参数)。

二、B200价格预测,3W美元一块让人好奇的是,英伟达尚未公布 B200 整套方案的成本和售价。

作为参考,Blackwell的前身 Hopper ,其旗舰款 H100 作为科技界最珍贵的商品之一,每颗芯片售价一度飙至4万美金。而 B200 只会更加昂贵,这个价格恐怕只有科技巨头们才能考虑入手。

根据分析师预测, B200 GPU 售价为 30,000 美元至 35,000 美元,而GB200 芯片的平均售价将达到惊人的 60,000 美元至 70,000 美元。

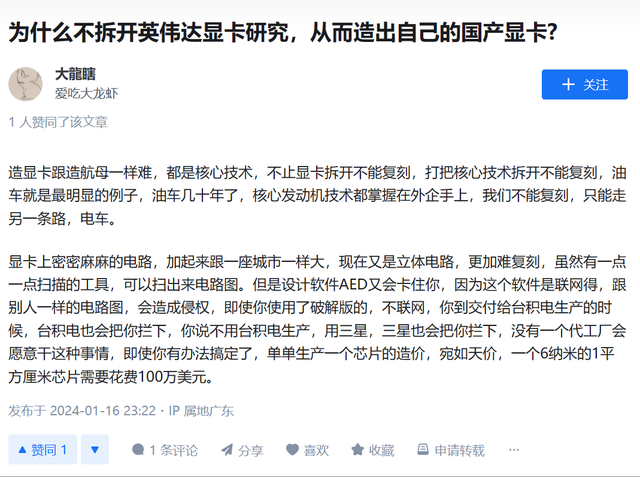

三、复刻很难国内GPU要跟上,希望在哪?简单分析一下跟不上的原因:

一、要承认复刻的确很难,短期基本不可能。这方面技术受地缘限制,从光刻机、到设计软件、再到供应链的突围,层层关卡,想要实现性能上的突破,先进的设备和技术都有待攻克。

图片

二、缺乏生成式AI相应的软件配套服务。事实上,单一层面讲国产算力匮乏并不客观,中科曙光、紫光、浪潮等一直在显卡方面取得了相当显著的效果。然而,即便有了硬件算力,与之相匹配的软件配套能力与英伟达比起来,似乎就相形见绌了。

三、即便有了,面对强大的竞争环境,自身盈利的要求也是非常大的挑战。英伟达等生态布局很早,气候已经大成,虹吸效应。

图片

从头搭建一套的成本花费巨大,即便“造出火箭”来,也没有好的买家买单,这也是为什么国内厂商难以跟进的客观原因。

攻坚克难,需要持之以恒的投入和决心。国内的GPU市场规模很大,也不是英伟达一家能通吃的天下。根据Verified Market Research的预测,到2027年,中国大陆的GPU市场规模预计将增长至345.57亿美元。

那英伟达的对手在哪里?没错,华为。

被英伟达列为最大竞争对手之一的华为,也走上了自研国产GPU的道路。华为推出的最强芯片「昇腾 910」,主要面向 AI 数据科学家和工程师,算力可达256TFOPS,超过了谷歌的 TPU v3 及英伟达的 GPU Tesla V100芯片。

不过值得注意的是,国内看,即便硬件性能追上英伟达,在软件框架层、模型层、生态层也亟需追赶。

四、通用计算过时了面向GPU编程已来英伟达成立于1993年,马上即将迎来31周年,黄仁勋带领下的“GPU”如今早已不止是“游戏”发烧友的硬件配置,而是正在成为新一轮技术变革的“超级充电厂”。

关注本次GTC的朋友,不难注意到英伟达重磅推出的AI微服务网站NIM,AI生产力的编程时代已经到来。

图片

之前,整个PC互联网都在面向CPU编程,而如今,黄教主认为AI时代下,面向GPU的开发技术栈更为被业界迫切需要。

面向外界,黄仁勋给出了一个坚定的信号:“加速计算到达了临界点,通用计算已经过时了。”

参考:https://techovedas.com/5-major-highlights-from-nvidia-gtc-2024/

来源: 51CTO技术栈