当前,AI显然已经成为了微软的主要议程,在与OpenAI合作开发出业界顶级大模型后,微软似乎并未满足于此。

微软研究院先后不断发布多个小模型(如Phi-3等),以摆脱对GPT-3.5、GPT-4.0等先进模型的依赖,并保持与AI初创公司和开源项目上的竞争力。与此同时,微软成立了Microsoft AI部门,负责整合微软的消费者AI工作以及Copilot、Bing、Edge等产品,并加强自身的AI研究和开发能力。

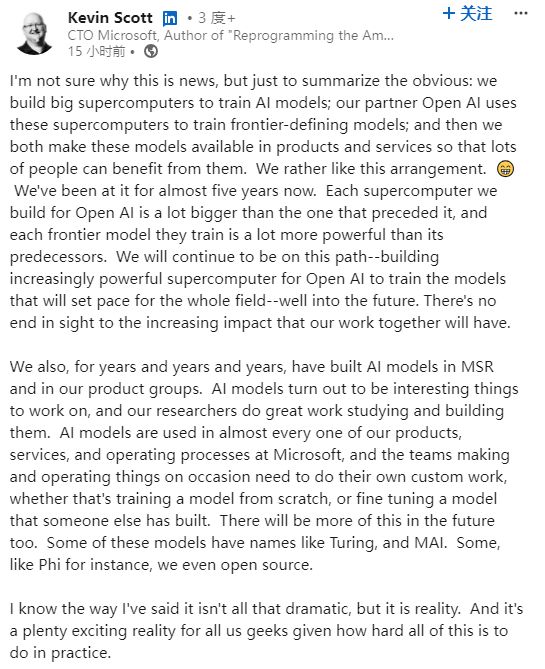

消息称,微软正在开发一款全新大模型,与Alphabet、谷歌和OpenAI等科技巨头展开新一轮竞争。该AI模型代号为MAI-1,拥有约5,000亿个参数,预计最早将于本月的Build开发者大会上首次亮相。随后,微软首席技术官Kevin Scott也在领英个人账号证实了此消息。

对于微软来说,AI领域的开发采用了“双管齐下”的策略:在为移动设备开发小型本地模型的同时,并不放松对由云端支持的大体量模型的开发。

上月底,微软刚刚推出了一款轻量级AI模型Phi-3-mini,拥有38亿参数,经过3.3万亿token的训练,号称其性能与GPT-3.5等模型势均力敌,并兼容手机设备。重要的是,除了高响应精度外,该模型低廉的成本使其在对客户群的吸引力上优势十足。

不过,Phi系列模型最多使用140亿个参数进行训练,相比之下,MAI-1的规模比微软此前训练过的较小的开源模型大得多,将使用约5,000亿个参数,可以直接与谷歌Gemini和亚马逊Titan、OpenAI的ChatGPT等先进模型相抗衡。也正因如此,它将需要更高的计算能力以及更多的训练数据,价格也将更贵。

该模型的开发将由谷歌DeepMind前联合创始人Mustafa Suleyman负责监督。2010年,Suleyman与其他合伙人创办了AI实验室DeepMind,随后被谷歌收购为旗下AI研究部门。2022年,Suleyman从谷歌离职,创建了AGI公司Inflection AI。

除聘请Suleyman和Inflection AI的主要成员外,微软还以6.5亿美元获得了Inflection技术的知识产权。据两位微软员工称:“MAI-1与Inflection之前发布的模型不同,不过,训练过程可能会用到其训练数据和技术。”

为了训练该款模型,微软正在大力囤积算力资源,已经预留了一大批配备英伟达GPU的服务器,计划到今年年底囤积180万块AI芯片,到2027财年末,预计将在GPU和数据中心上花费约1,000亿美元。

此外,该公司还一直在编制训练数据以优化模型,其中包括来自GPT-4生成的文本,以及外部来源(互联网公共数据)的各种数据集。