引言:bolt.new的革新与bolt.diy的开源力量

在现代科技的快速发展中,AI驱动的全栈开发平台已经成为开发者们的新宠。bolt.new作为一款革新性的AI驱动的全栈开发平台,允许用户通过自然语言描述,直接生成和部署完整的Web应用,无需编写代码,大大简化了开发流程。bolt.new的主要特点是其易用性和免费性,但它也存在一定的额度限制。特别是在西方节假日期间,bolt.new的每日免费额度可以达到20万tokens,每月可达200万tokens。这使得开发者们能够充分利用其提供的claude家族的大语言模型,并整合supabase,实现真正的全栈开发。

然而,bolt.new的开源版本bolt.diy则提供了更多的灵活性和自由度。与商业版本不同,bolt.diy支持各种AI的线上和线下API,并且功能强大,众多功能整合在一个开源版本中。其部署过程也非常简单,无论是线上还是本地部署,都能轻松完成。本文将详细介绍bolt.diy的部署过程,并推荐最契合的模型,同时介绍如何使用Cloudflare Pages进行线上部署,以及如何结合ollama等本地AI模型进行无token限制的开发。

1. bolt.diy的开源魅力与功能介绍

bolt.diy作为bolt.new的开源版本,吸引了大量开发者的关注。其开源特性使得开发者能够根据自己的需求进行修改和扩展,进一步提升开发效率。bolt.diy支持多种AI模型的API,包括在线和线下的模型,这使得开发者能够灵活选择适合自己的AI工具。

bolt.diy的功能非常强大,它整合了众多功能,包括但不限于自然语言处理、代码生成、数据库管理等。这些功能的整合使得bolt.diy成为一个全能的开发平台,能够满足各种开发需求。接下来,我们将详细介绍如何部署bolt.diy,并推荐一些最契合的模型。

2. bolt.diy的线上部署:使用Cloudflare Pages

bolt.diy的线上部署非常简单,我们可以通过Cloudflare Pages进行部署。以下是详细的部署步骤:

2.1 第一步:Fork项目

首先,我们需要在GitHub上Fork bolt.diy的官方开源项目。访问GitHub项目页面(@aigem/bolt.diy),点击Star并Fork项目。Fork完成后,复制仓库并删除不需要的文件。为了方便,可以直接点击Fork按钮,并为新仓库命名。稍等片刻,Fork操作就会完成。

2.2 第二步:登录Cloudflare

接下来,我们需要登录Cloudflare。如果没有账号,可以注册一个新账号。登录后,进入Workers and Pages页面,点击创建一个新的Pages项目。

2.3 第三步:连接GitHub

在创建Pages项目时,选择连接到Git。如果之前已经连接过GitHub账号,账号会自动显示在页面上。如果没有,则需要添加并绑定GitHub账号。输入密码后,绑定完成。

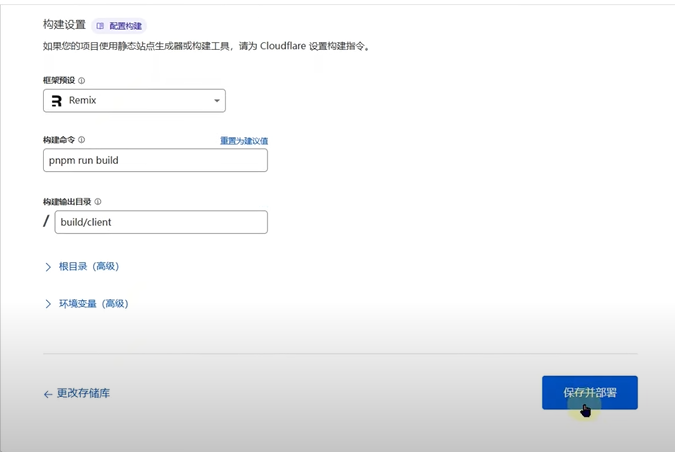

2.4 第四步:选择仓库并部署

回到创建Pages的页面,选择刚才Fork的仓库。点击仓库后,选择默认设置,并使用PMPN(npm -> pnpm)。保存并设置后,Cloudflare Pages会开始构建和部署项目。稍等片刻,部署完成后,我们可以打开页面查看效果。

2.5 第五步:测试部署效果

首次部署后,可能需要等待一两分钟,因为Cloudflare需要将内容分发到全球网络。等待后,我们可以看到页面已经成功部署。bolt.diy支持多种在线模型的API,包括Google的、Grok的、Hugging Face的、Mistral的、Open AI的等。这些模型的API可以通过Openrouter进行访问。我们可以选择一个免费的模型API进行测试,例如llama3.1 405B。

2.6 第六步:自定义域名

由于Cloudflare Pages默认的域名在国内无法访问,我们可以在自定义域名中绑定一个自己的域名。

3. bolt.diy的本地部署

除了线上部署,bolt.diy还支持本地部署。以下是详细的本地部署步骤:

3.1 第一步:安装必要工具

首先,我们需要安装git、Node.js和pnpm,并将pnpm设置为腾讯的源。这些工具是本地部署bolt.diy所必需的。

3.2 第二步:克隆仓库

克隆bolt.diy的仓库后,进入仓库并进行依赖安装。安装完成后,启动程序即可。

3.3 第三步:结合ollama使用本地模型

在下一期,我将在免费的T4显卡主机上部署ollama,并结合bolt.diy使用本地模型。这将进一步提升开发效率,实现无token限制的开发。

4. 推荐模型与使用建议

bolt.diy支持多种AI模型,以下是一些推荐的模型及其使用建议:

4.1 在线模型

- **Google的模型**:Google的模型在自然语言处理方面表现出色,适合用于生成高质量的文本内容。

- **Grok的模型**:Grok的模型在代码生成方面表现优异,适合用于开发各种应用程序。

- **Hugging Face的模型**:Hugging Face的模型种类繁多,适合各种不同的开发需求。

- **Mistral的模型**:Mistral的模型在性能和效率方面表现突出,适合用于大规模的开发项目。

- **Open AI的模型**:Open AI的模型在多种任务中表现优秀,适合用于各种开发场景。

4.2 本地模型

- **ollama**:ollama是一个本地部署的AI模型,适合用于无token限制的开发。结合bolt.diy,可以实现高效的本地开发。

- **LMStudio**:LMStudio也是一个本地部署的AI模型,适合用于各种本地开发需求。

总结:bolt.diy的无限可能

bolt.diy作为bolt.new的开源版本,提供了强大的功能和灵活的部署选项。无论是线上部署还是本地部署,bolt.diy都能满足开发者的各种需求。通过Cloudflare Pages进行线上部署,可以快速生成和部署Web应用。结合ollama等本地AI模型,可以实现无token限制的开发,进一步提升开发效率。

bolt.diy的开源特性使得开发者能够根据自己的需求进行修改和扩展,真正实现了全栈开发的无限可能。希望本文的详细介绍和推荐模型能够帮助大家更好地使用bolt.diy,提升开发效率,实现更多的创新。