之前给大家介绍过一款叫做SadTalker的AI项目,可以将一张图片制作成数字人视频。但使用SadTalker制作的数字人视频,往往比较生硬,只能动嘴,头部、身体等其他肢体基本没有任何移动,因此很容易被看出是AI生成的数字人。

今天介绍一款全新的数字人AI项目,叫做SadTalker-Video-Lip-Sync。该项目基于SadTalker进行了升级,通过以视频文件方式进行语音驱动生成唇形,并且对面部进行了画面增强,使合成的数字人更为流畅、真实以及自然。

以下是SadTalker生成的视频,可以看到基本只有嘴在动,很呆:

以下是SadTalker-Video-Lip-Sync生成的视频,可以看到整个数字人说话的动作就自然流畅多了,用该工具生成的数字人视频效果也会大幅提升:

项目准备工作:

①目前仅支持N卡,且需要至少6G以上显存才可使用;

②使用期间建议使用魔法,可能需要下载部分模型到本地。

手把手教你本地部署部署SadTalker-Video-Lip-Sync比较复杂,没关系,我来手把手教你本地部署。

①将项目克隆到本地:下载git并安装,在你想要部署SadTalker-Video-Lip-Sync的位置,右键点击,选择“Git Bash Here”。

然后输入以下指令,下载项目:

git clone https://github.com/Zz-ww/SadTalker-Video-Lip-Sync#sadtalker-video-lip-sync.git等待几分钟即可下载成功。

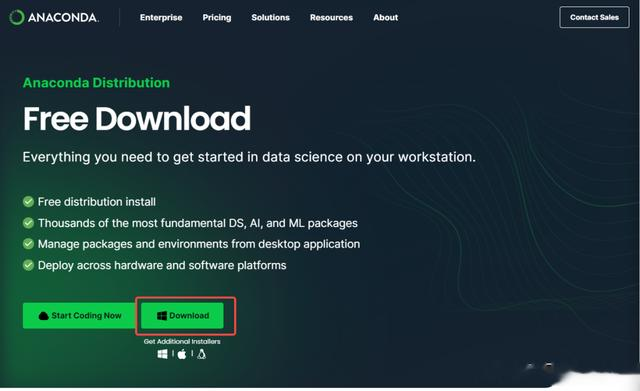

②安装Python:推荐下载Anaconda(一个傻瓜式整合Python的软件)

安装过程推荐查看往期内容:青春就是用来失败的 | 训练灌篮高手专属AI绘画模型

③创建虚拟环境:

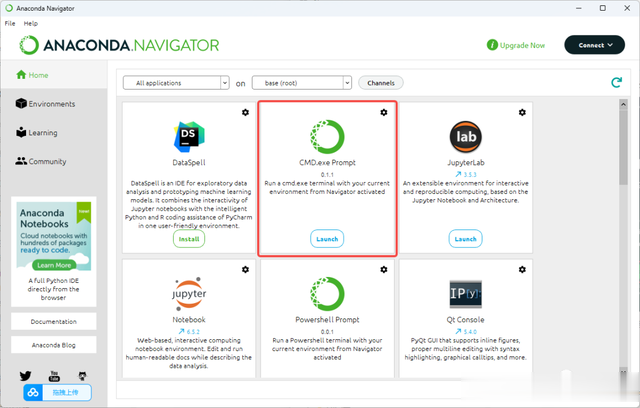

打开Anaconda,选择“CMD.exe”。

在打开的命令提示窗口,输入以下代码,以新建一个Python环境:

conda create -n SVLS python==3.8新建完成后,继续输入以下代码,来激活刚才生成的SVLS环境:

conda activate SVLS④第三方依赖库安装:在刚才的窗口输入以下代码,进入之前下载SadTalker-Video-Lip-Sync根目录:

cd 部署的SadTalker-Video-Lip-Sync本地路径然后输入以下代码,安装作者注明的第三方依赖库:

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 torchaudio==0.12.1 --extra-index-url <https://download.pytorch.org/whl/cu113>conda install ffmpegpip install -r requirements.txt#如需使用DAIN模型进行补帧需安装paddle# CUDA 11.2python -m pip install paddlepaddle-gpu==2.3.2.post112 \\-f <https://www.paddlepaddle.org.cn/whl/linux/mkl/avx/stable.html>⑤安装FFmpeg:FFmpeg是一套可以用来记录、转换数字音频、视频,并能将其转化为流的开源计算机程序,是SadTalker-Video-Lip-Sync运行的必要支持程序。安装和设置可查看往期内容:AI一键让照片说话,无限且免费!

⑥运行SadTalker-Video-Lip-Sync:输入以下代码,就可以运行了。

conda activate SVLScd 部署的SadTalker-Video-Lip-Sync本地路径python inference.py上手试试部署完成后,将需要处理的文件,放置在以下文件目录中:

音频文件:

examples/driven_audio/bus_chinese.wav

视频文件:

examples/source_image/input.mp4

需要注意以下几点:

①音频文件名称必须是“bus_chinese.wav”,视频文件名称必须是“input.mp4”;

②原视频素材中的人脸区域尽量保持固定,不要运动区域过大;

③原视频素材最好是保持闭着嘴的状态;

④音频时长和视频时长尽量一致。

运行结束后,结果在“results”文件夹内,打开最近时间的这个文件夹,后缀是“_full.mp4”的文件就是最终结果视频。

自行部署还是比较麻烦的,我也制作了离线整合包,关注并私信回复【小助手】,免费获得资源~